randomforest专题

Matlab中RandomForest分类器的使用

随机森林算法的相关资料,参考:https://www.cnblogs.com/maybe2030/p/4585705.html (1)首先制作训练样本,并对样本打分类标签; (2)训练样本,并在训练集上的利用“包外错误率oob”评估模型效果;(注意:训练模型有很多关键参数,可以参考相关手册对照使用。) load train_sample % 训练样本 load train_l

集成学习 (投票分类器 bagging/pasting RandomForest Boosting)

集成学习 本文主要介绍 voting (投票学习器)bagging / pasting 3.随机森林boosting 1.集成学习概述 1.1 概述 集成学习通过结合多个单一学习器,并聚合其预测结果的学习任务,也可以称作多分类系统等,下面是集成学习的概要图: 单一的学习器可以被称为个体学习器,聚合的过程对应结合模块根据学习器是否一致可以分为 同质 和 异质同质集成中的个体学

RandomForest随机森林感想

摘要:随机森林和决策树相比,能更好的防止过拟合。虽然每个基分类器很弱,但最后组合的结果通常很强。 在机器学习算法中,有一类算法比较特别,叫组合算法(Ensemble),即将多个基算法(Base)组合起来使用。每个基算法单独预测,最后的结论由全部基算法进行投票(用于分类问题)或者求平均(包括加权平均,用于回归问题)。 组合算法中,一类是Bagging(装袋),另一类是Boosti

有监督分类:集成分类(Bagging Boosting RandomForest)

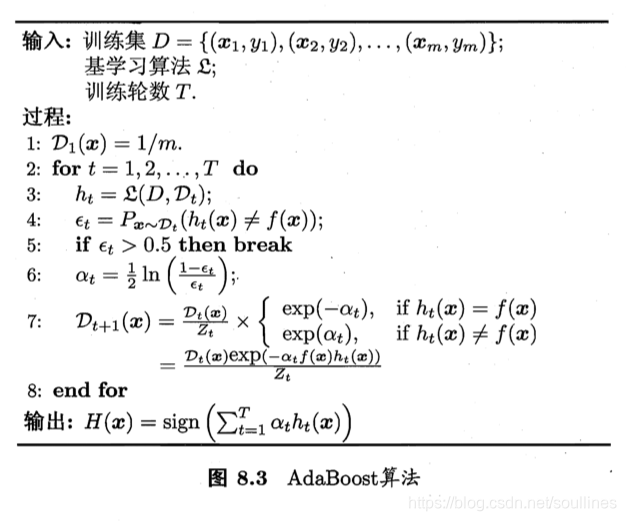

1.前言 集成学习(Ensemble),是指把性能较低的多种弱学习器,通过适当组合形成高性能的强学习器的方法。“三个臭皮匠顶个诸葛亮”这句谚语用来形容集成分类器最合适不过了。这几年,关于集成分类的研究一直是机器学习领域的一个热点问题。在这里,只分析了两个我比较熟悉的集成分类方法。 对多个弱学习器独立进行学习的Bagging学习法对多个弱学习器依次进行学习的Boosting学习法

Jackknife,Bootstrap, Bagging, Boosting, AdaBoost, RandomForest 和 Gradient Boosting的区别

Bootstraping: 名字来自成语“pull up by your own bootstraps”,意思是依靠你自己的资源,称为自助法,它是一种有放回的抽样方法,它是非参数统计中一种重要的估计统计量方差进而进行区间估计的统计方法。其核心思想和基本步骤如下: (1) 采用重抽样技术从原始样本中抽取一定数量(自己给定)的样本,此过程允许重复抽样。 (2) 根据抽出的样本计算给定的统计量T。 (

二、集成学习:Bagging之随机森林算法(RandomForest Algorithm)

随机森林(RandomForest) 一、随机森林(RandomForest)基本原理二、Out-Of-Bag Estimate 袋外数据估计泛化误差三、随机森林如何评估特征重要性。四、随机森林如何处理缺失值五、其它常见问题5.1、为什么Bagging算法的效果比单个评估器更好?5.2、为什么Bagging可以降低方差?<br>5.3、Bagging有效的基本条件有哪些?Bagging的效果