qkv专题

将Transformer应用于图像时,如何理解其中的QKV(形象化说明)+自注意力机制的理解

在Transformer中,Q(Query)、K(Key)、V(Value)可以用以下方式形象化理解: 一、概念解释 1. Query(查询):可以想象成一个“问题”或者“搜索请求”。它代表着当前要关注的信息点,比如在处理图像时,某个图像块想要了解自己与其他图像块的关系,这个图像块对应的向量就充当了Query的角色。 2. Key(键):类似于一个“标签”或者“索引”。它为其他部分提供一种标

transformer中对于QKV的个人理解

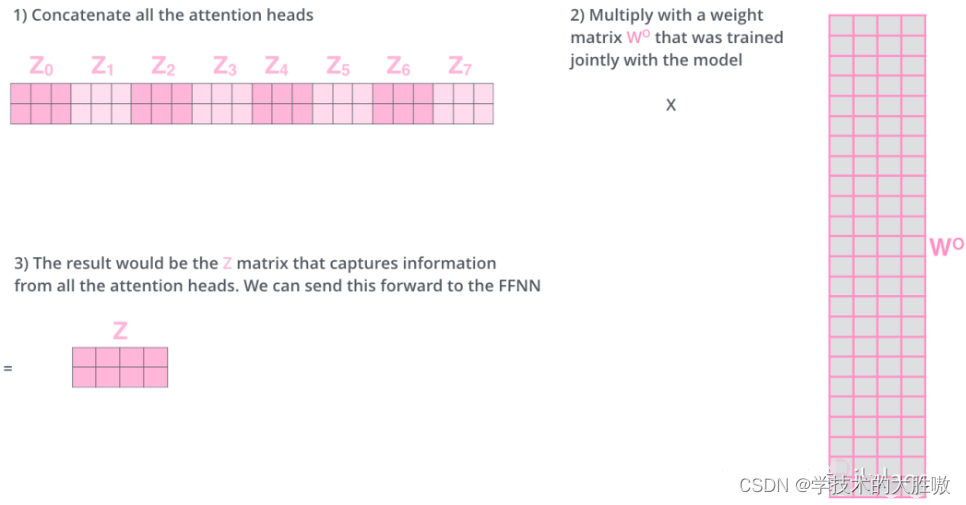

目录 1、向量点乘 2、相似度计算举例 3、QKV分析 4、整体流程 (1) 首先从词向量到Q、K、V (2) 计算Q*(K的转置),并归一化之后进行softmax (3) 使用刚得到的权重矩阵,与V相乘,计算加权求和。 5、多头注意力 上面这个transformer中的注意力公式,相信大家不会陌生。公式并不复杂,但是why? 为什么是这个公式,为什么大家都说

图像中的attention及QKV机制解释

简单记录/推荐两篇博客,后续细化写一下: 图像中的各类 attention https://blog.csdn.net/weixin_44505185/article/details/127013204 Cross-attention的直观理解 首先理解,cross-attention 是两个不同向量间的相关计算,一般Q叫做查询向量,K=V,V是被查询向量; 简单来讲,对图像而言,cro

ATTENTION QKV理解

https://blog.csdn.net/u013887652/article/details/101062567?depth_1-utm_source=distribute.pc_relevant.none-task-blog-BlogCommendFromBaidu-1&utm_source=distribute.pc_relevant.none-task-blog-BlogCommendF

LangChain+LLM实战---BERT主要的创新之处和注意力机制中的QKV

BERT主要的创新之处 BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer架构的预训练语言模型,由Google在2018年提出。它的创新之处主要包括以下几个方面: 双向性(Bidirectional):BERT是第一个采用双向Transformer架构进行预训练的模型。传统的语言模型如GPT