pkd专题

12层的bert参数量_EMNLP 2019 | BERTPKD:一种基于PKD方法的BERT模型压缩

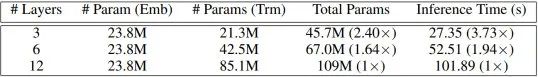

过去一年里,语言模型的研究有了许多突破性的进展,BERT、XLNet、RoBERTa等预训练语言模型作为特征提取器横扫各大NLP榜单。但这些模型的参数量也相当惊人,比如BERT-base有一亿零九百万参数,BERT-large的参数量则高达三亿三千万,从而导致模型的训练及推理速度过慢。本文提出了一种“耐心的知识蒸馏” (Patient Knowledge Distillation) 方法对模型

PKD: General Distillation Framework for Object Detectors via Pearson Correlation Coefficient阅读笔记

(一) Title 论文地址:https://arxiv.org/abs/2207.02039 (二) Summary 研究背景: 在目标检测任务中KD发挥着压缩模型的作用,但是对于heterogeneous detectors(异构)之间的蒸馏仍然lack of study。 本文的主要工作 来自异构教师的FPN feature能够帮助具有不同detect head和label ass

[论文阅读]PKD——基于Pearson相关系数的目标检测器通用蒸馏框架

PKD General Distillation Framework for Object Detectors via Pearson Correlation Coefficient 基于Pearson相关系数的目标检测器通用蒸馏框架 论文网址:PKD 创新点 1.提出FPN特征模仿适用于异构检测器对。之前的工作大多只考虑同质检测器对,很少研究异构情况。 2.指出直接最小化特征图之间的均方误

![[论文阅读]PKD——基于Pearson相关系数的目标检测器通用蒸馏框架](https://img-blog.csdnimg.cn/48538e4180f945b389fc36253647b27d.png)