olmo专题

大语言模型(一)OLMo

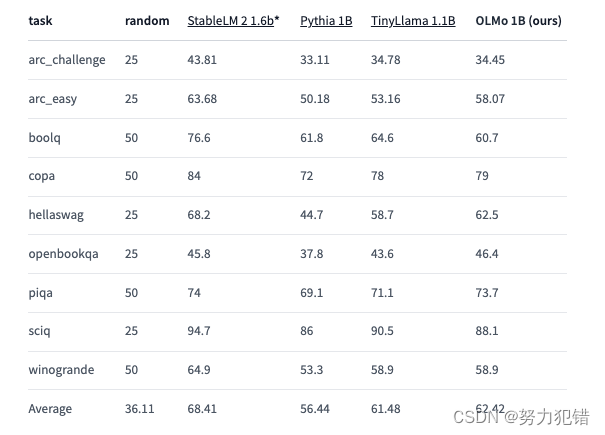

一、简介 OLMo 是由AI2 发布的大语言模型以及构建框架,与大多数之前的尝试只发布模型权重和推理代码不同,OLMo 开源了整个框架,包括训练数据、训练代码以及模型评估代码。 OLMo框架包括构建和研究语言模型所需的工具和资源。对于训练和建模,它包括完整的模型权重、训练代码、训练日志、消融实验、以Weights & Biases日志形式的训练指标,以及推理代码。这次发布包括我们的语言模型在7

100%开源大模型OLMo:代码/权重/数据集/训练全过程公开,重定义AI共享

前言 近日,艾伦人工智能研究所联合多个顶尖学术机构发布了史上首个100%开源的大模型“OLMo”,这一举措被认为是AI开源社区的一大里程碑。OLMo不仅公开了模型权重,还包括了完整的训练代码、数据集和训练过程,为后续的开源工作设立了新的标准。这一开源模型的推出,无疑将极大促进自然语言处理(NLP)技术的发展和研究。 Huggingface模型下载:https://huggingface.co

AI加速引擎PAI-TorchAcc:OLMo训练加速最佳实践

作者:黄奕桐、沈雯婷、艾宝乐、王昂、李永 摘要 阿里云机器学习平台PAI开发的Pytorch训练加速框架PAI-TorchAcc已接入最新开源的大语言模型 OLMo。在保证模型效果和易用性的前提下,PAI-TorchAcc相对 PyTorch 性能在 OLMo 1B 上加速比达到 1.64X,在 OLMo 7B 上加速比达到 1.52X。本文分析了 PAI-TorchAcc 的性能收益来源。