ofa专题

OFA one-for-all 通用多模态预训练模型

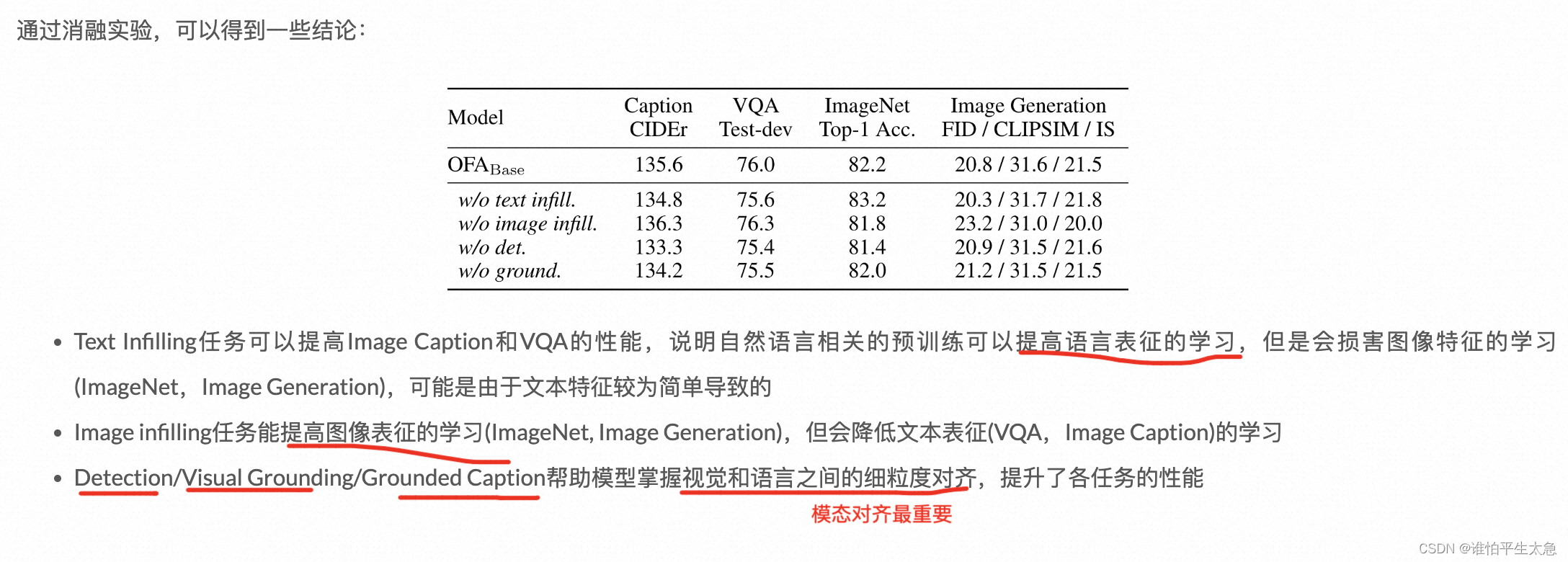

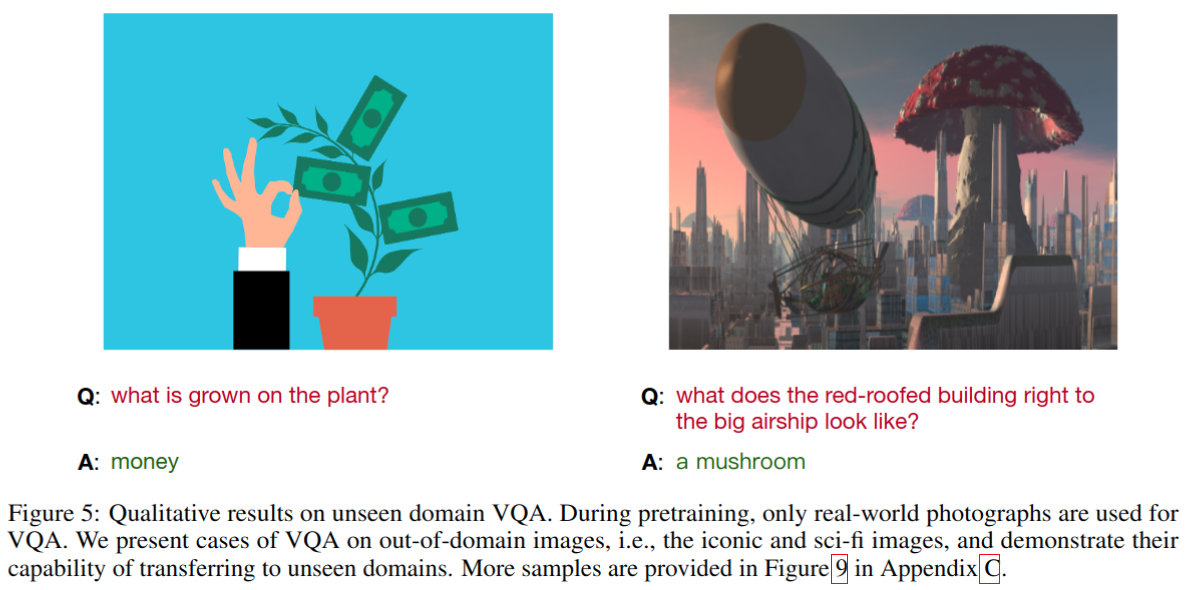

使用简单的序列到序列的学习框架 统一模态 (跨模态、视觉、语言等模态)和任务(如图片生成、视觉定位、图片描述、图片分类、文本生成等) ICML 2022: 《OFA: Unifying Architectures, Tasks, and Modalities Through a Simple Sequence-to-Sequence Learning Framework》 预训练当中的表征学习

OFA: Unifying Architectures, Tasks, and Modalities Through a Simple Sequence-to-Sequence Learning Fr

Paper name OFA: Unifying Architectures, Tasks, and Modalities Through a Simple Sequence-to-Sequence Learning Framework Paper Reading Note URL: https://proceedings.mlr.press/v162/wang22al/wang22al.p

什么?前端又出新轮子了?ofa.js

不需要打包的 MVVM JavaScript 框架 无需繁琐学习,无需 npm、nodejs、webpack,即刻上手 <script src="https://cdn.jsdelivr.net/gh/kirakiray/ofa.js/dist/ofa.min.js"></script> 官方文档 取代 jQuery 在许多小型项目中,我们可能并不需要引入像React和Vue这样

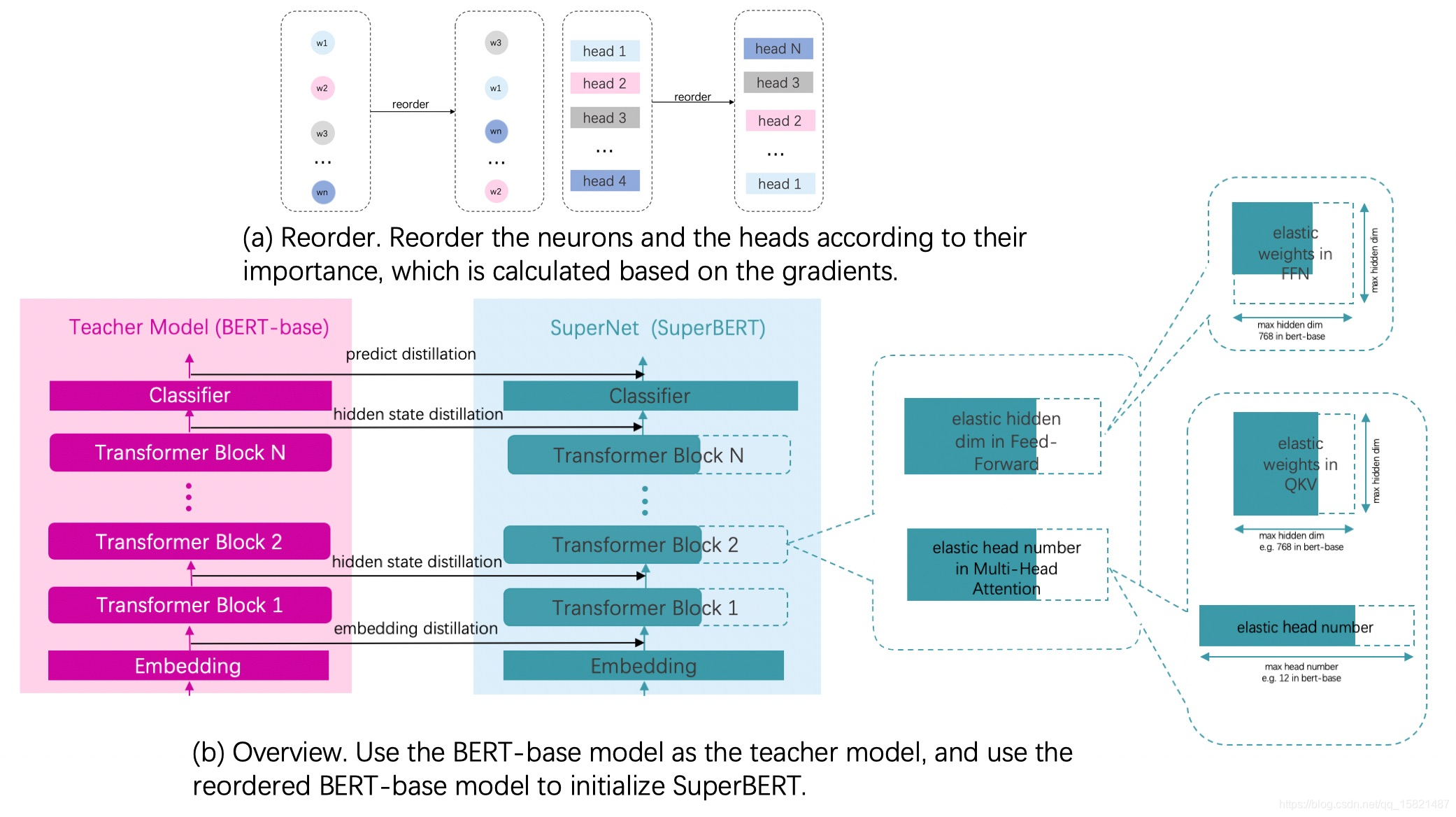

PaddleSlim对BERT-base模型进行压缩/OFA

针对不同的应用,能快速训练选择出来 BERT-base模型是一个迁移能力很强的通用语义表示模型,但是模型中也有一些参数冗余。本教程将介绍如何使用PaddleSlim对BERT-base模型进行压缩。 压缩原理 对Fine-tuning得到模型通过计算参数及其梯度的乘积得到参数的重要性,把模型参数根据重要性进行重排序。 超网络中最大的子网络选择和Bert-base模型网络结构一致的网络结构,其