nndl专题

NNDL 实验五 前馈神经网络—鸾尾花分类

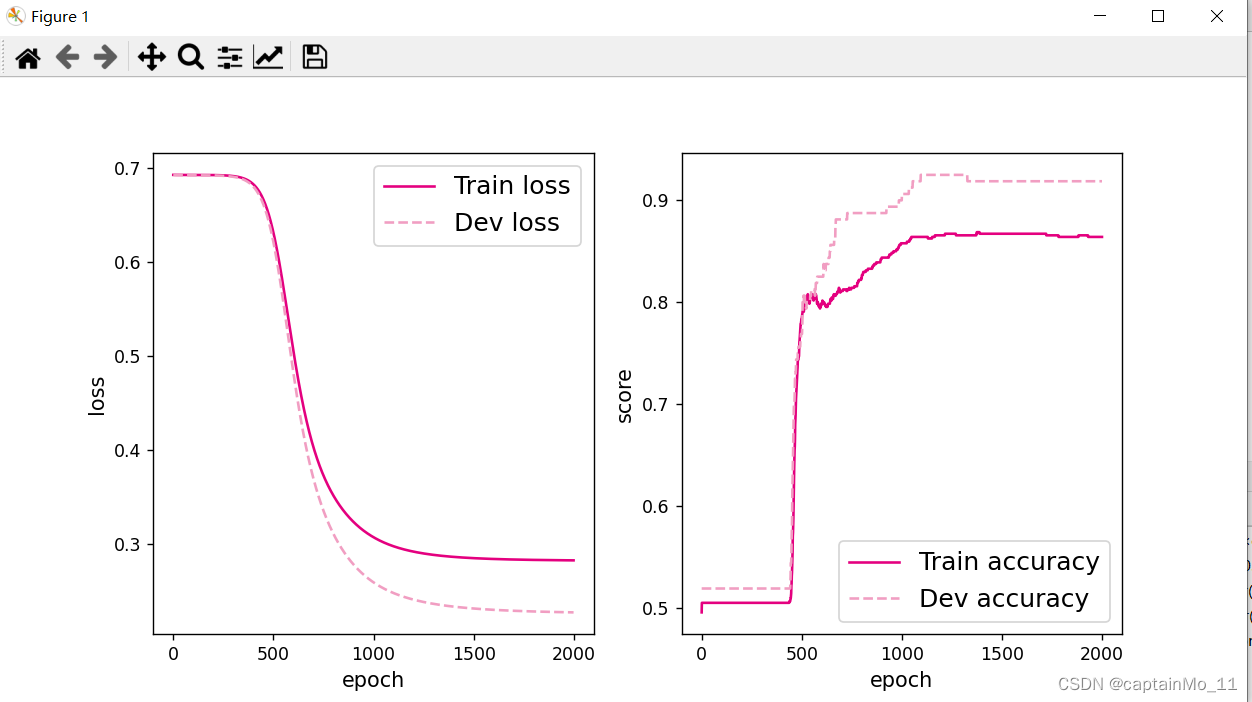

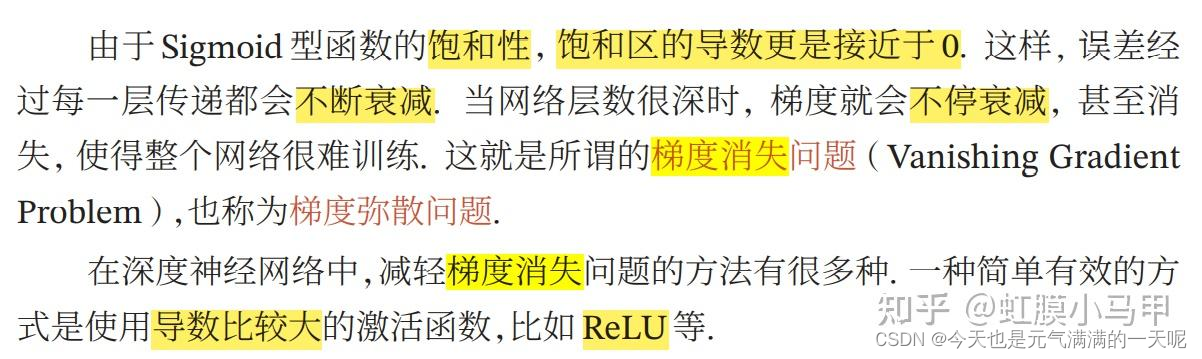

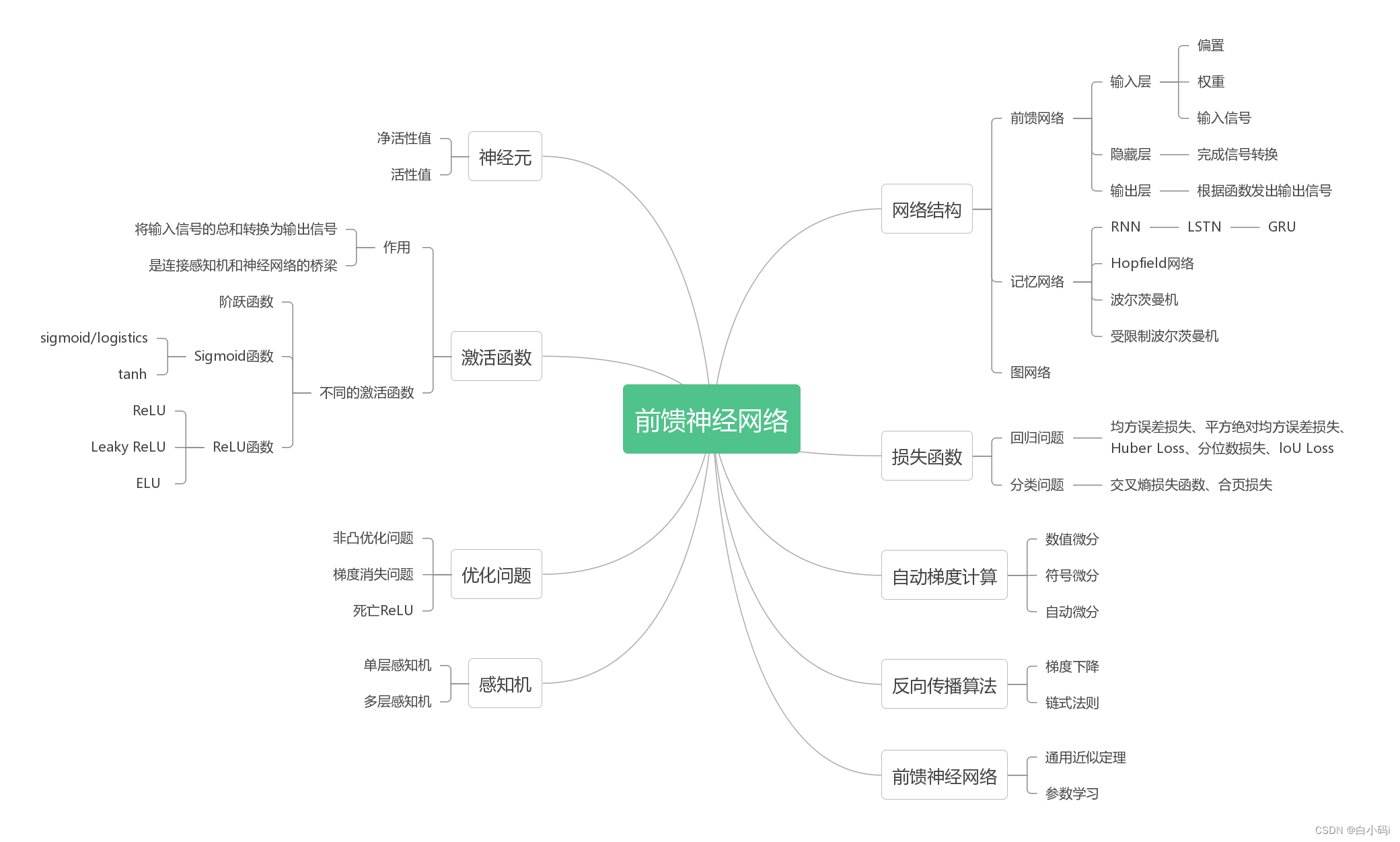

通过前两次对前馈神经网络的探究实验,基础掌握了前馈神经网络的基本概念、网络结构及代码实现,利用前馈神经网络完成一个分类任务,并通过两个简单的实验,观察前馈神经网络的梯度消失问题和死亡ReLU问题,以及对应的优化策略。接下来便落实实例,完成基于前馈神经网络完成鸾尾花分类。 目录 深入研究鸾尾花数据集 小批量梯度下降法 数据分组 数据处理 用DataLoader进行封装 模型构建

NNDL 作业13 优化算法3D可视化 [HBU]

老师作业原博客:【23-24 秋学期】NNDL 作业13 优化算法3D可视化-CSDN博客 NNDL 作业13 优化算法3D可视化-CSDN博客 编程实现优化算法,并3D可视化 1. 函数3D可视化 分别画出 和 的3D图 NNDL实验 优化算法3D轨迹 鱼书例题3D版_优化算法3d展示-CSDN博客 代码: from mpl_toolkits.mplot3d import

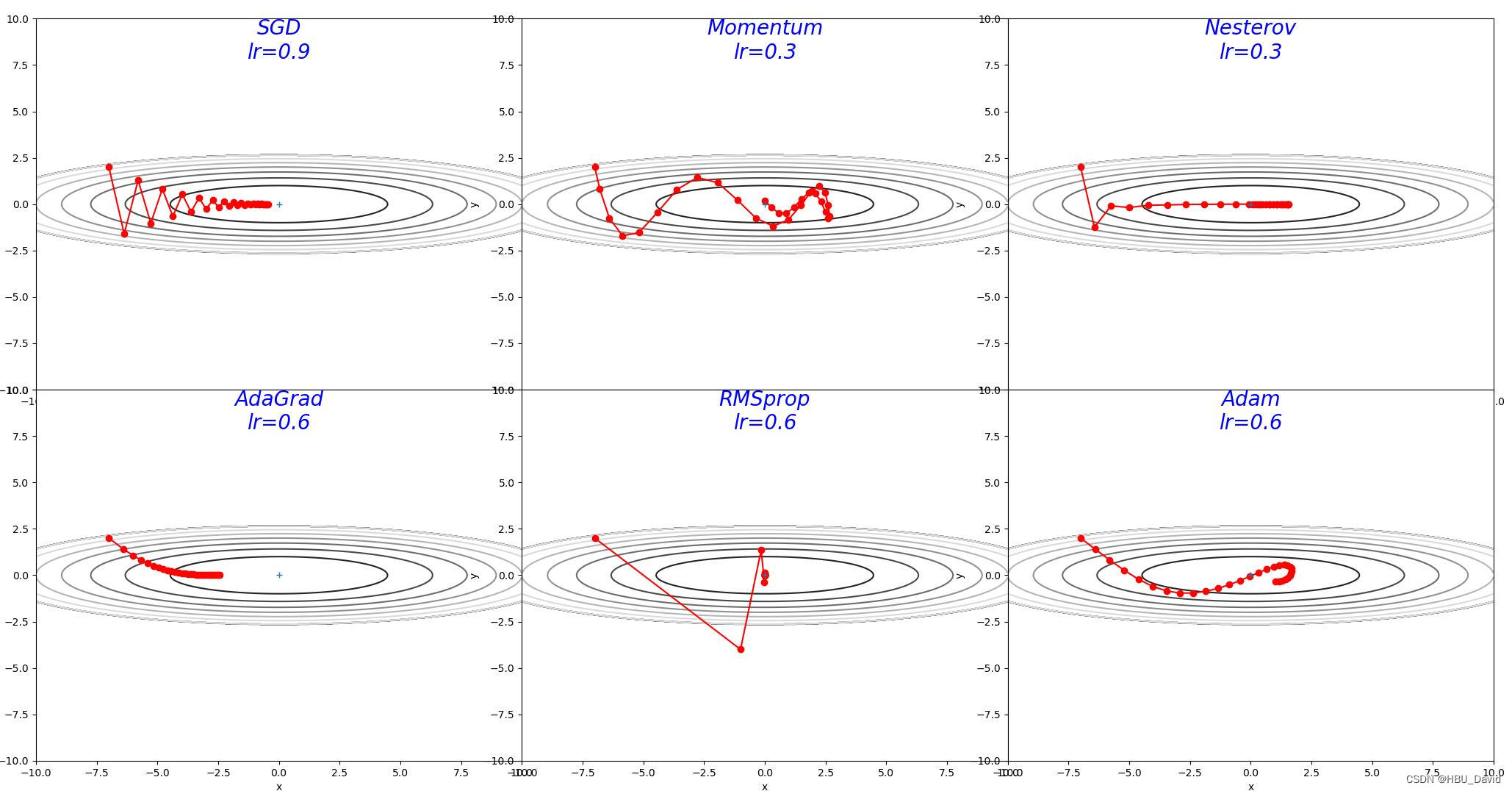

NNDL 作业12-优化算法2D可视化 [HBU]

老师作业原博客地址:【23-24 秋学期】NNDL 作业12 优化算法2D可视化-CSDN博客 目录 简要介绍图中的优化算法,编程实现并2D可视化 1. 被优化函数 编辑 深度学习中的优化算法总结 - ZingpLiu - 博客园 (cnblogs.com) SGD: Adagrad: RMSprop: Momentum: Adam: 2. 被优化函数 编辑 3D效果

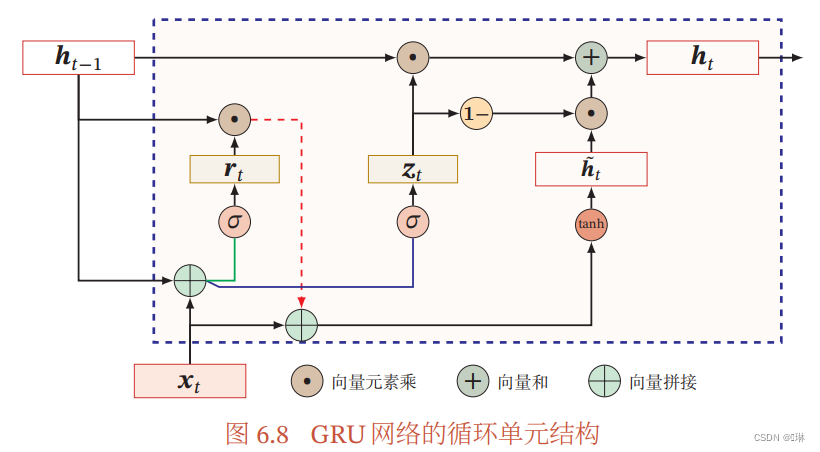

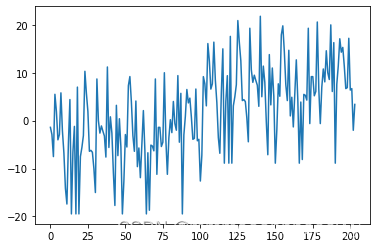

NNDL 循环神经网络-梯度爆炸实验 [HBU]

目录 6.2.1 梯度打印函数 6.2.2 复现梯度爆炸现象 6.2.3 使用梯度截断解决梯度爆炸问题 【思考题】梯度截断解决梯度爆炸问题的原理是什么? 总结 前言: 造成简单循环网络较难建模长程依赖问题的原因有两个:梯度爆炸和梯度消失。 循环网络的梯度爆炸问题比较容易解决,一般通过权重衰减或梯度截断可以较好地来避免; 梯度消失问题,更加有效的方式是改变模型,比如通过长短期

NNDL 实验四 线性分类 基于Logistic回归的二分类任务、基于Softmax回归的多分类任务和基于Softmax回归完成鸢尾花分类任务

pytorch实现 第3章 线性分类 3.1 基于Logistic回归的二分类任务 使用到的第三方库 import matplotlib.pyplot as pltfrom sklearn.datasets import make_moonsimport torch.nn as nnimport torch.optim as optimimport torchimport

【23-24 秋学期】NNDL 作业12 优化算法2D可视化

简要介绍图中的优化算法,编程实现并2D可视化 1. 被优化函数 2. 被优化函数 3. 解释不同轨迹的形成原因 分析各个算法的优缺点 REF:图灵社区-图书 (ituring.com.cn) 深度学习入门:基于Python的理论与实现 NNDL 作业11:优化算法比较_"ptimizers[\"sgd\"] = sgd(lr=0.95) optimiz

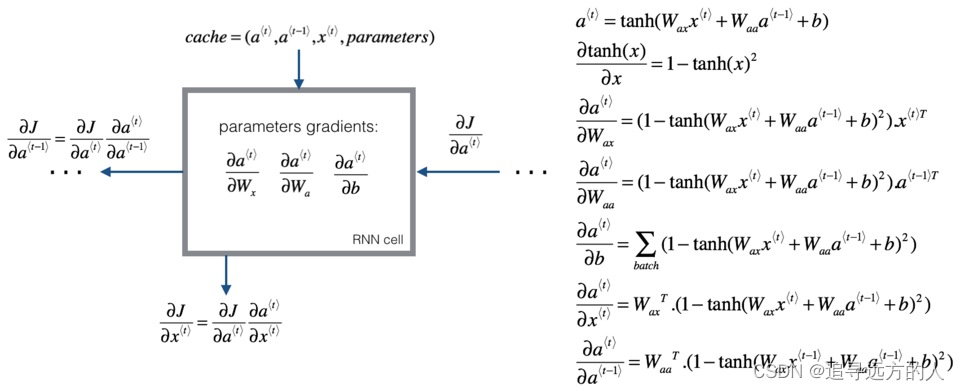

【23-24 秋学期】NNDL 作业10 BPTT

习题6-1P 推导RNN反向传播算法BPTT. 习题6-2 推导公式(6.40)和公式(6.41)中的梯度. 习题6-3 当使用公式(6.50)作为循环神经网络的状态更新公式时, 分析其可能存在梯度爆炸的原因并给出解决方法. 习题6-2P 设计简单RNN模型,分别用Numpy、Pytorch实现反向传播算子,并代入数值测试. 代码实现 REF:L5W1作业1 手把手实现

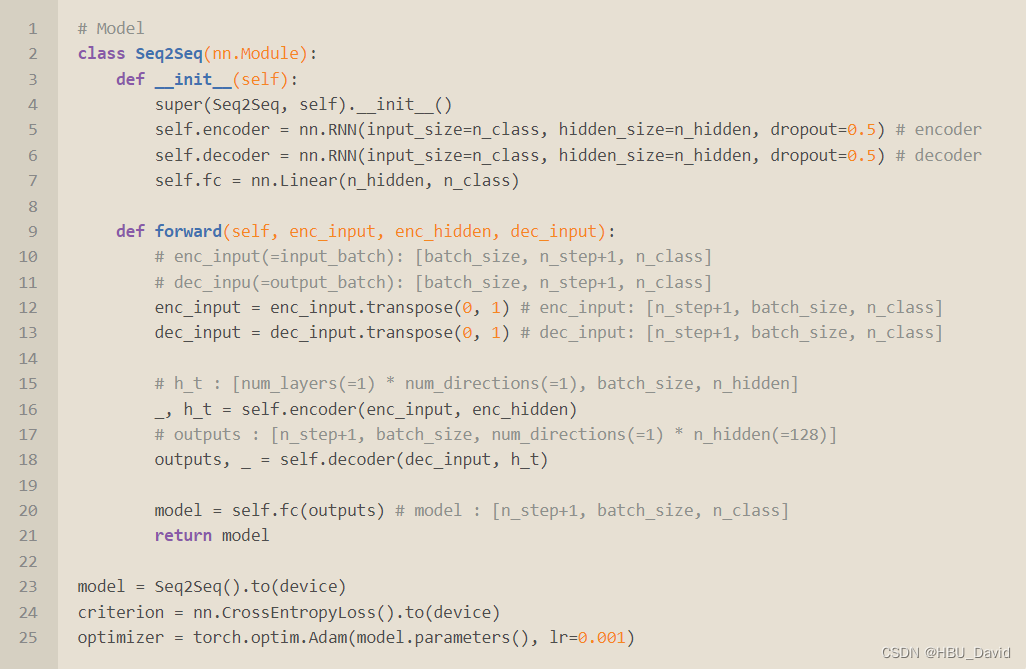

【23-24 秋学期】NNDL 作业9 RNN - SRN

简单循环网络(Simple Recurrent Network,SRN)只有一个隐藏层的神经网络. 目录 1. 实现SRN (1)使用Numpy (2)在1的基础上,增加激活函数tanh (3)使用nn.RNNCell实现 (4)使用nn.RNN实现 2. 实现“序列到序列” 3. “编码器-解码器”的简单实现 4.简单总结nn.RNNCell、nn.RNN 5.谈一谈对“序

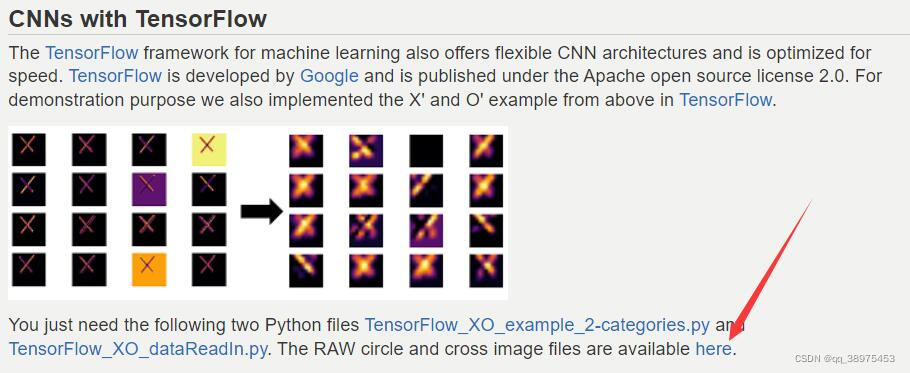

【23-24 秋学期】NNDL 作业7 基于CNN的XO识别

一、用自己的语言解释以下概念 局部感知、权值共享池化(子采样、降采样、汇聚)。会带来那些好处和坏处?全卷积网络(课上讲的这个概念不准确,同学们查资料纠正一下)低级特征、中级特征、高级特征多通道。N输入,M输出是如何实现的?1×1的卷积核有什么作用 二、使用CNN进行XO识别 1.复现参考资料中的代码 2.重新设计网络结构 至少增加一个卷积层,卷积层达到三层以上去掉池化层,对比“有无池

【23-24 秋学期】NNDL 作业7 基于CNN的XO识别

一、用自己的语言解释以下概念 局部感知、权值共享池化(子采样、降采样、汇聚)。会带来那些好处和坏处?全卷积网络(课上讲的这个概念不准确,同学们查资料纠正一下)低级特征、中级特征、高级特征多通道。N输入,M输出是如何实现的?1×1的卷积核有什么作用 二、使用CNN进行XO识别 1.复现参考资料中的代码 2.重新设计网络结构 至少增加一个卷积层,卷积层达到三层以上去掉池化层,对比“有无池

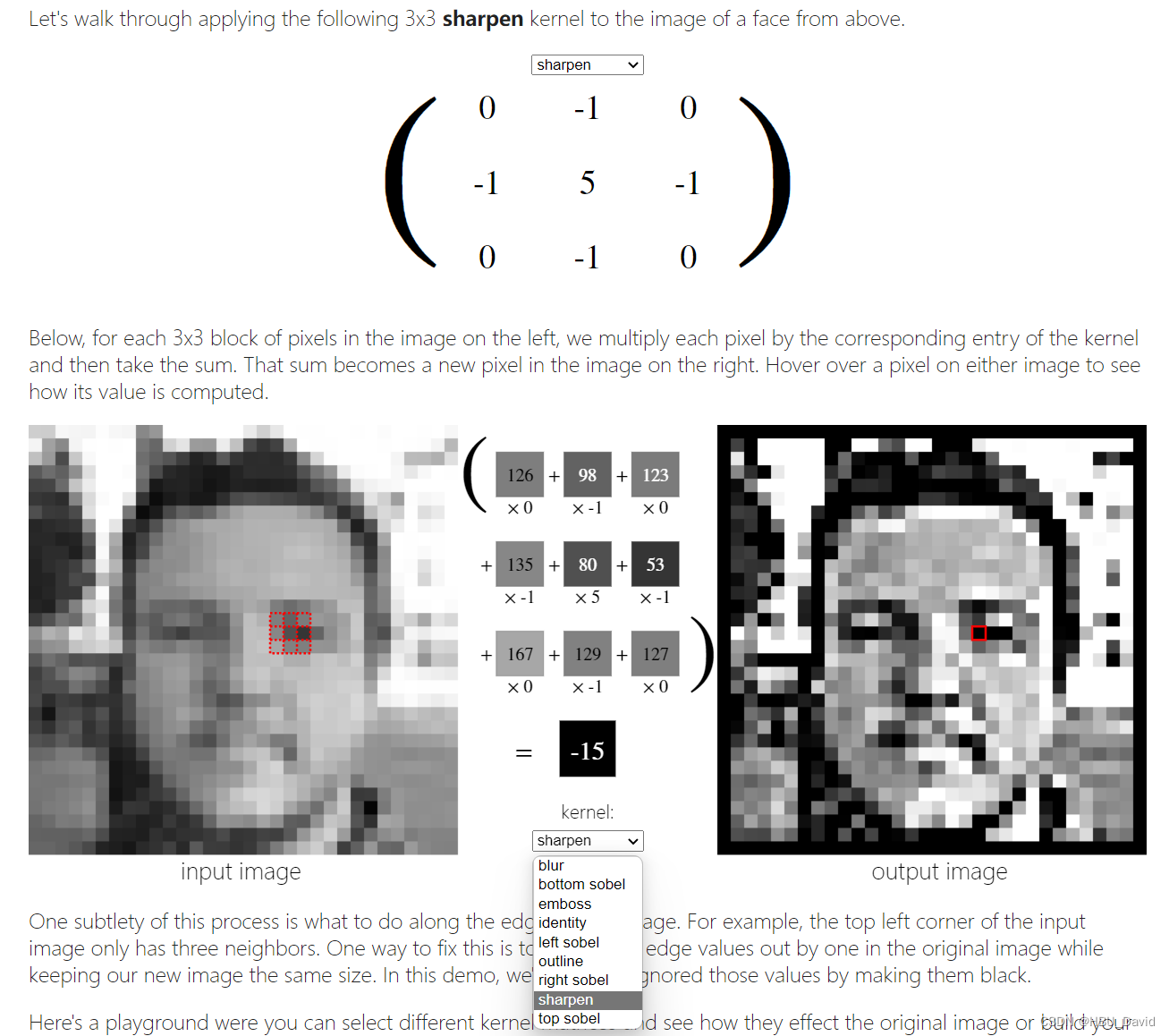

[23-24 秋学期]NNDL 作业6 卷积 [HBU]

目录 一、概念 二、探究不同卷积核的作用 后接:关于使用pycharm输出卷积图像后图片仍然不清晰的可能原因以及解决方法👆 总结: 前言:卷积常用于特征提取 实验过程中注意认真体会“特征提取”,弄清楚为什么卷积能够提取特征。 一、概念 用自己的语言描述“卷积、卷积核、特征图、特征选择、步长、填充、感受野”。 大致看了一遍邱锡鹏《神经网络与深度学习》

【23-24 秋学期】NNDL 作业6 卷积

卷积常用于特征提取 实验过程中注意认真体会“特征提取”,弄清楚为什么卷积能够提取特征。 一、概念 用自己的语言描述“卷积、卷积核、特征图、特征选择、步长、填充、感受野”。 二、探究不同卷积核的作用 卷积神经网络工作原理的直观理解_superdont的博客-CSDN博客 1. 图1分别使用卷积核,输出特征图 2. 图2分别使用卷积核,输出特征图 3. 图3分

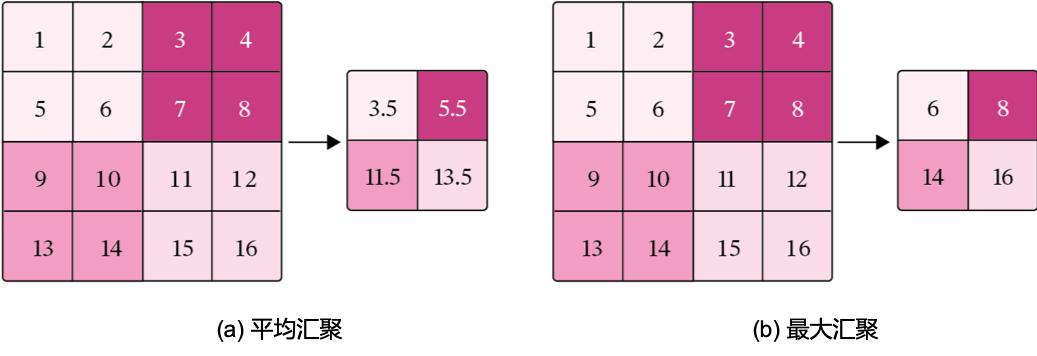

NNDL 实验六 卷积神经网络(2)基础算子

5.2 卷积神经网络的基础算子 我们先实现卷积网络的两个基础算子:卷积层算子和汇聚层算子。 5.2.1 卷积算子 卷积层是指用卷积操作来实现神经网络中一层。 为了提取不同种类的特征,通常会使用多个卷积核一起进行特征提取。 5.2.1.1 多通道卷积 5.2.1.2 多通道卷积层算子 1. 多通道卷积卷积层的代码实现 2. Pytorch:torch.nn.Conv2d()

NNDL 实验五 前馈神经网络(2)自动梯度计算优化问题

目录 4.3.1 利用预定义算子重新实现前馈神经网络 1,使用pytorch的预定义算子来重新实现二分类任务。 2. 增加一个3个神经元的隐藏层,再次实现二分类,并与1做对比。(必做) 3. 自定义隐藏层层数和每个隐藏层中的神经元个数,尝试找到最优超参数完成二分类。可以适当修改数据集,便于探索超参数。(选做) 4.4.2 梯度消失问题 4.4.3 死亡ReLU问题

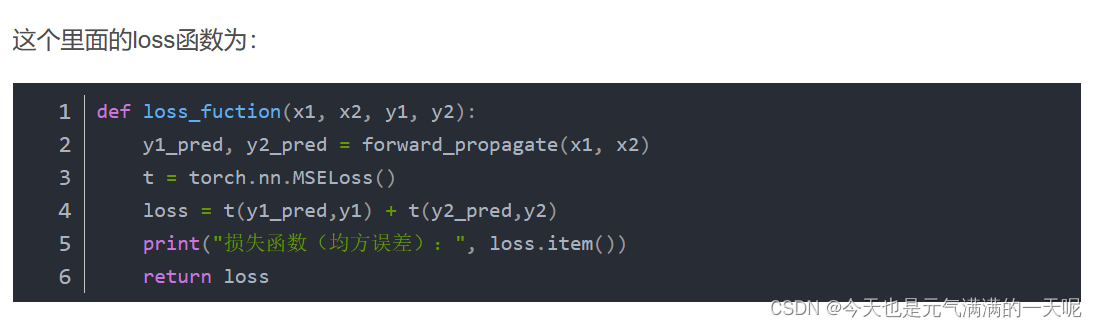

NNDL:作业3:分别使用numpy和pytorch实现FNN例题

对比【numpy】和【pytorch】程序,总结并陈述。 激活函数Sigmoid用PyTorch自带函数torch.sigmoid(),观察、总结并陈述。 激活函数Sigmoid改变为Relu,观察、总结并陈述。 损失函数MSE用PyTorch自带函数 t.nn.MSELoss()替代,观察、总结并陈述。 损失函数MSE改变为交叉熵,观察、总结并陈述。 改变步长,训练次数,观察、总结并陈述。

![NNDL 作业13 优化算法3D可视化 [HBU]](https://img-blog.csdnimg.cn/direct/4aa6b1a28e3741a191c8e0abe15d2a88.png)

![NNDL 作业12-优化算法2D可视化 [HBU]](https://img-blog.csdnimg.cn/direct/f48af9e9ec4848a68cc30e2e114fb0c9.png)

![NNDL 循环神经网络-梯度爆炸实验 [HBU]](https://img-blog.csdnimg.cn/direct/1f93e164a3e74760931a8c96bfa1ce1d.png)

![[23-24 秋学期]NNDL 作业6 卷积 [HBU]](https://img-blog.csdnimg.cn/91ffc202de5148428fb01d2220338102.png)