multitask专题

Language Models are Unsupervised Multitask Learners

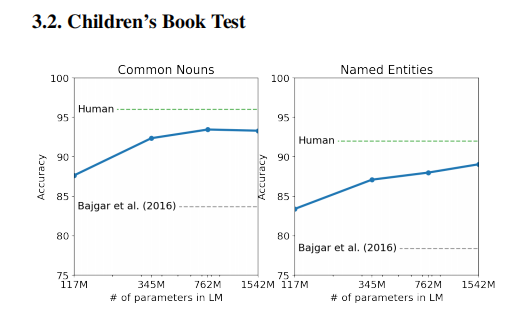

摘要 自然语言处理任务,如问答、机器翻译、阅读理解和摘要,通常在任务特定的数据集上使用监督学习来处理。当在一个名为WebText的数百万网页的新数据集上训练时,我们证明了语言模型在没有任何明确监督的情况下开始学习这些任务。在不使用127,000多个训练示例的情况下,当以文档和问题为条件时,语言模型生成的答案在CoQA数据集上达到55的F1值 -匹配或超过4个基线系统中的3个的性能。语言模型的能力

Flow Prediction in Spatio-Temporal Networks Based on Multitask Deep Learning

这是一篇郑宇团队2019年发表在 **IEEE Transactions on Knowledge and Data Engineering** 杂志上的一篇论文。 从题目来看文章提出的模型是一个多任务模型,在阅读文论之后发现是为了解决两个问题: ①流量预测;(同论文 [上一篇博文介绍的论文一样](https://blog.csdn.net/The_lastest/article/detai

Re62:读论文 GPT-2 Language Models are Unsupervised Multitask Learners

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类 论文全名:Language Models are Unsupervised Multitask Learners 论文下载地址:https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pd

Multitask Classification of Breast Cancer Pathological Images Using SE-DenseNet

摘要: 本文采用密集连接的卷积网络(DenseNet)结构,吸收SeNet,对一组苏木精和伊红(H&E)染色乳腺组织学显微镜 Camelyon16 进行多任务分类。全幻灯片图像(WSI)通常存储在多分辨率金字塔中,我们的数据集包含Camelyon16 在*5、*20、*40,三倍放大率下的patches。 我们的多任务是通过连接同一网络末端的两个分类器来识别patches的放大率并区分提取的pa

【GPT-2】论文解读:Language Models are Unsupervised Multitask Learners

文章目录 介绍zero-shot learning 零样本学习 方法数据Input Representation 结果 论文:Language Models are Unsupervised Multitask Learners 作者:Alec Radford, Jeff Wu, Rewon Child, D. Luan, Dario Amodei, I. Sutskever

CS224N学习笔记(十七)Multitask learning

Multitask指多任务学习,大致意思是一个NLP的模型可以完成多种任务。 一、单任务学习的局限和特点 由于{dataset,task,model,metric}等的发展,近年来single-task取得了很好的效果当训练集足够大,能够很容易局部最优对于通常更常用的AI,需要针对single-model的持续的学习(continus-learning),即很多时候不需要从头开始,顺着上次的结