logits专题

如何理解分类任务中的logits?

在分类任务中,logits 是模型输出的原始分数,通常是在通过模型的最后一个全连接层之后但在激活函数(如 softmax)之前获得的。它们代表每个类别的未归一化得分或信心度。理解 logits 的过程可以分为以下几个步骤: 模型的最后一层输出:在神经网络模型的最后一层(通常是全连接层),每个类别都会有一个对应的输出值。这些输出值就是 logits。 未归一化的分数:logits 并不是概率,

关于tensorflow中的softmax_cross_entropy_with_logits_v2函数的区别

tf.nn.softmax_cross_entropy_with_logits(记为f1) 和 tf.nn.sparse_softmax_cross_entropy_with_logits(记为f3),以及 tf.nn.softmax_cross_entropy_with_logits_v2(记为f2) 之间的区别。 f1和f3对于参数logits的要求都是一样的,即未经处理的,直接由神经

【PyTorch】进阶学习:探索BCEWithLogitsLoss的正确使用---二元分类问题中的logits与标签形状问题

【PyTorch】进阶学习:探索BCEWithLogitsLoss的正确使用—二元分类问题中的logits与标签形状问题 🌈 个人主页:高斯小哥 🔥 高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程👈 希望得到您的订阅和支持~ 💡 创作高质量博文(平均质量分92+),分享更多关于深度学习、PyTorch、Pyt

tf.nn.softman_cross_entropy_with_logits及几种交叉熵计算

https://www.jianshu.com/p/95d0dd92a88a 就看例子就完事了 tf.nn.softmax import tensorflow as tfimport numpy as npsess=tf.Session()#logits代表wx+b的输出,并没有进行softmax(因为softmax后是一个和为1的概率)logits = np.array(

TensorFlow ValueError Only call softmax_cross_entropy_with_logits with named arguments labels logits

TensorFlow报错: ValueError: Only call softmax_cross_entropy_with_logits with named arguments (labels=…, logits=…, …) 定位到出错点: self.loss = tf.nn.softmax_cross_entropy_with_logits(z, self.target) 原来

知识蒸馏的蒸馏损失方法代码总结(包括:基于logits的方法:KLDiv,dist,dkd等,基于中间层提示的方法:)

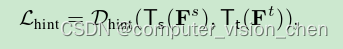

有两种知识蒸馏方法:一种利用教师模型的输出概率(基于logits的方法)[15,14,11],另一种利用教师模型的中间表示(基于提示的方法)[12,13,18,17]。基于logits的方法利用教师的输出作为辅助信号来训练一个较小的模型,即学生模型: 利用教师模型的输出概率(基于logits的方法) 该类方法损失函数为: DIST Tao Huang,Shan You,Fei Wang,

tf.nn.sparse_softmax_cross_entropy_with_logits()函数

感觉就是softmax+tf.nn.softmax_cross_entropy_with_logits 原文链接:https://blog.csdn.net/ZJRN1027/article/details/80199248 tf.nn.sparse_softmax_cross_entropy_with_logits() 这是一个TensorFlow中经常需要用到的函数。官方文档里面有对

binary_cross_entropy和binary_cross_entropy_with_logits的区别

binary_cross_entropy和binary_cross_entropy_with_logits的区别 引言 二分类问题是常见的机器学习任务之一,其目标是将样本分为两个类别。为了训练一个二分类模型,通常使用交叉熵作为损失函数。 二分类交叉熵损失函数有两种不同的形式,分别是 binary_cross_entropy_with_logits 和 binary_cross_entropy