kaiming专题

pytorch-13_3 模型参数初始化方法:Xavier和Kaiming(HE)

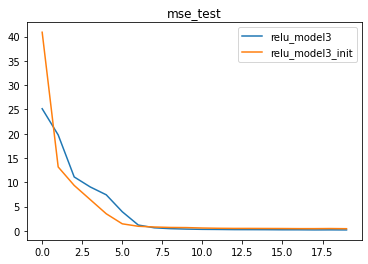

一、激活函数使用过程中的优化 不同激活函数在深层次神经网络运行时存在的不同问题 ReLU激活函数叠加后出现的模型失效问题,也就是Dead ReLU Problem(神经元活性失效问题)。Sigmoid激活函数堆叠后出现的问题,本质上就是梯度消失所导致的问题。tanh激活函数堆叠所导致的迭代过程剧烈波动的问题,也被称为迭代不平稳,需要优化迭代过程来解决。 从本节开始,将正式进入到优化方

基于暗通道的图像去雾算法_CVPR09 BestPaper_KaiMing He

前一阶段做项目用到了 何凯明的这篇文章中的算法,闲来无事,总结一下。 其实,对于图像去雾,去模糊,去噪声问题,数学模型都非常接近,而且非常简单,由于数学模型非常简单,如何有效的估计其中的参数就是重点了。以前有大量的文章是基于先验假设的,这类方法有很大的局限性,而何凯明的这篇文章的确是给出了一个去雾问题的比较好的模型。 ------------------------------- 先介绍一下

Kaiming_normal 正态分布

torch.nn.init.kaiming_normal_(tensor, a=0, mode= 'fan_in', nonlinearity='leaky_relu') 此为0均值的正态分布,N~ (0,std) std = sqrt(2/(1+a^2)*fan_in) a为激活函数的负半轴的斜率,relu是0 mode: 选择“fan_in”保留了forward传递中权重的方差大

【torch杂记】torch.nn.init.kaiming_normal_

torch.nn.init.kaiming_normal_ 文章目录 torch.nn.init.kaiming_normal_参考源码 参考 torch.nn.init.kaiming_normal_python中的numel()函数 源码 这个函数就是实现这个公式 std = gain fan_mode \text{std} = \frac{\text{ga

Facebook,Kaiming He的PointRend我的阅读笔记

Point Rend笔记 PointRend模块的提出是为了解决Mask预测时候对于原图或feature map上的像素的过采样和欠采样问题。这个问题的核心在于,由于2d图像本身是以栅格化的形式保存图像,那么网络在预测Mask的时候,不可避免地会将所有像素都有同等地位地进行预测,而实际上我们更希望的是网络集中预测在物体边缘部分的地方,而物体内部则不需要过多地预测,那么前者就是欠采样,后者则是过

Kaiming weight initialization中 fan_in / fan_out的理解

从内置函数 _calculate_fan_in_and_fan_out来看fan_in 和 fan_out 的定义 如果输入数据 tensor 的维度等于2, 如果输入数据 tensor 的维度 大于2 recpetive_field_size 就是第三维度 * 第四维度... 例如, conv1=nn.Conv2d(16, 64, 3, 3, stride=1) t