interpretable专题

Reasoning on Graphs: Faithful and Interpretable Large Language Model Reasonin

摘要 大型语言模型(llm)在复杂任务中表现出令人印象深刻的推理能力。然而,他们在推理过程中缺乏最新的知识和经验幻觉,这可能导致不正确的推理过程,降低他们的表现和可信度。知识图谱(Knowledge graphs, KGs)以结构化的形式捕获了大量的事实,为推理提供了可靠的知识来源。然而,现有的基于kg的LLM推理方法只将kg作为事实知识库,忽略了其结构信息对推理的重要性。在本文中,我们提出了一

论文笔记:Interpretable Deep Models for ICU Outcome Prediction

使用mimic learning用来更精确分分类。 核心:retrain

Multi-Objective Molecule Generation using Interpretable Substructures

2021/7/22 摘要:药物设计问题旨在发现满足目标化学性质要求的新分子结构,当面对多性质优化问题时这项工作便变得极其困难。本文提出了一种解决这种复杂性的方法,通过一个子结构语料库来组成分子,称之为分子基本准则,这些子结构是从分子中确定的可能对某个属性有贡献的子结构,这样的方法属于“基于分子碎片”的设计方法。 实现自动生成分子的模型包括两个步骤: 在性质预测模型的帮助下提取出用于构建分子的分

[论文精读]BrainGNN: Interpretable Brain Graph Neural Network for fMRI Analysis

论文原文:BrainGNN: Interpretable Brain Graph Neural Network for fMRI Analysis - ScienceDirect 英文是纯手打的!论文原文的summarizing and paraphrasing。可能会出现难以避免的拼写错误和语法错误,若有发现欢迎评论指正!文章偏向于笔记,谨慎食用! 目录 1. 一些概念 1.

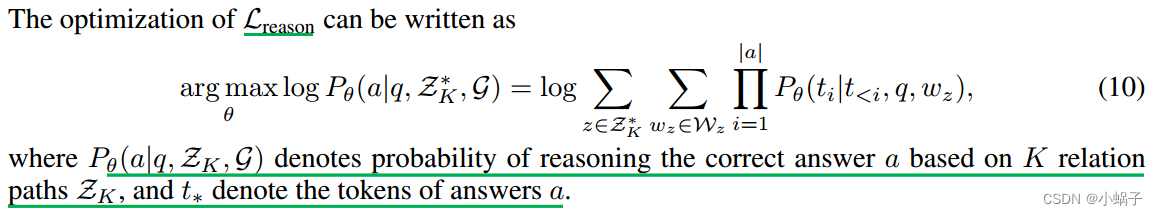

REASONING ON GRAPHS: FAITHFUL AND INTERPRETABLE LARGE LANGUAGE MODEL REASONING

本文是LLM系列文章,针对《REASONING ON GRAPHS: FAITHFUL AND INTERPRETABLE LARGE LANGUAGE MODEL REASONING》的翻译。 图上推理:忠实的和可解释的大语言模型推理 摘要1 引言2 相关工作3 前言4 方法5 实验6 结论 摘要 大型语言模型(llm)在复杂任务中表现出令人印象深刻的推理能力。然而,他们在推理