groq专题

Llama 3 + Groq 是 AI 天堂

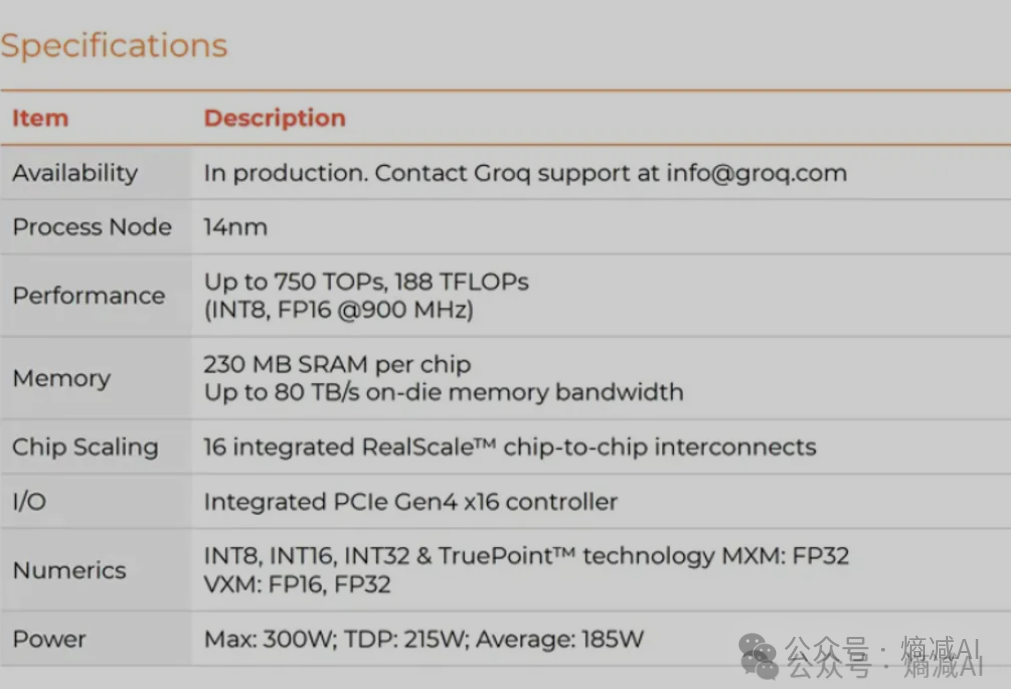

我们将为生成式人工智能新闻搜索创建一个后端。我们将使用通过 Groq 的 LPU 提供服务的 Meta 的 Llama-3 8B 模型。 关于Groq 如果您还没有听说过 Groq,那么让我为您介绍一下。 Groq 正在为大型语言模型 (LLM) 中文本生成的推理速度设定新标准。 Groq 提供 LPU(语言处理单元)接口引擎,这是一种新型的端到端处理单元系统,可为计算密集型应用程序提供最快的

科技云报道:黑马Groq单挑英伟达,AI芯片要变天?

科技云报道原创。 近一周来,大模型领域重磅产品接连推出:OpenAI发布“文字生视频”大模型Sora;Meta发布视频预测大模型 V-JEPA;谷歌发布大模型 Gemini 1.5 Pro,更毫无预兆地发布了开源模型Gemma… 难怪网友们感叹:“一开年AI发展的节奏已经如此炸裂了么!” 但更令人意想不到的是,AI芯片领域处于绝对霸主地位的英伟达,竟然也遇到了挑战,而且挑战者还是一家初创公司

谷歌连发 Gemini1.5、Gemma两种大模型,Groq让模型输出速度快18倍

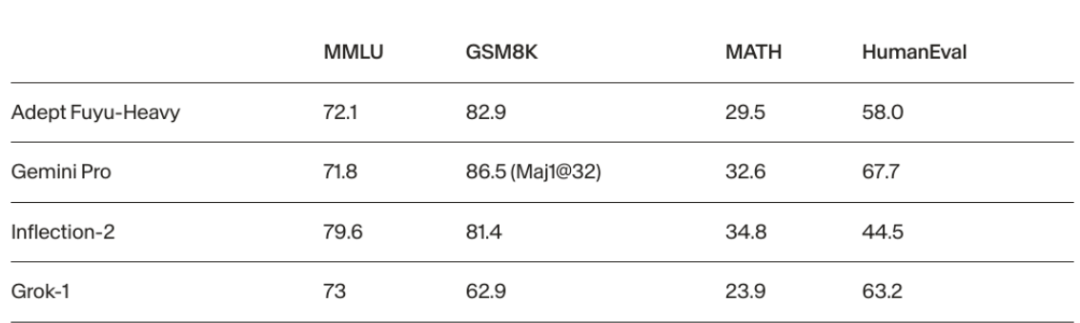

本周,我们观察到以下AI领域的新动向和新趋势: 1.谷歌连发Gemini1.5和Gemma两种大模型, 其中Gemini1.5采用MoE架构,并拥有100万token上下文长度,相比Gemini 1.0性能大幅提升。Gemma是谷歌新推出的开源模型,采用Gemini同源技术,性能比同参数尺寸的Llama 2更强。 2.Groq的LPU让其模型输出速度比GPT-4快18倍, 用LPU集群推理的速

每周AI新闻(2024年第8周)谷歌推出开源大模型Gemma | Groq自研AI芯片 | 英伟达成立GEAR研究具身智能体

这里是陌小北,一个正在研究硅基生命的碳基生命。正在努力成为写代码的里面背诗最多的,背诗的里面最会写段子的,写段子的里面代码写得最好的…厨子。 每周日解读每周AI大事件。 大厂动向 【1】谷歌推出最强开源大模型Gemma 谷歌发布开源模型Gemma,Gemma主打轻量级、高性能,有20亿、70亿两种参数规模,能在笔记本电脑、台式机、物联网设备、移动设备和云端等不同平台运行。性能方面,Gemm