glm2专题

glm2大语言模型服务环境搭建

一、模型介绍 ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 引入了如下新特性: 更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识

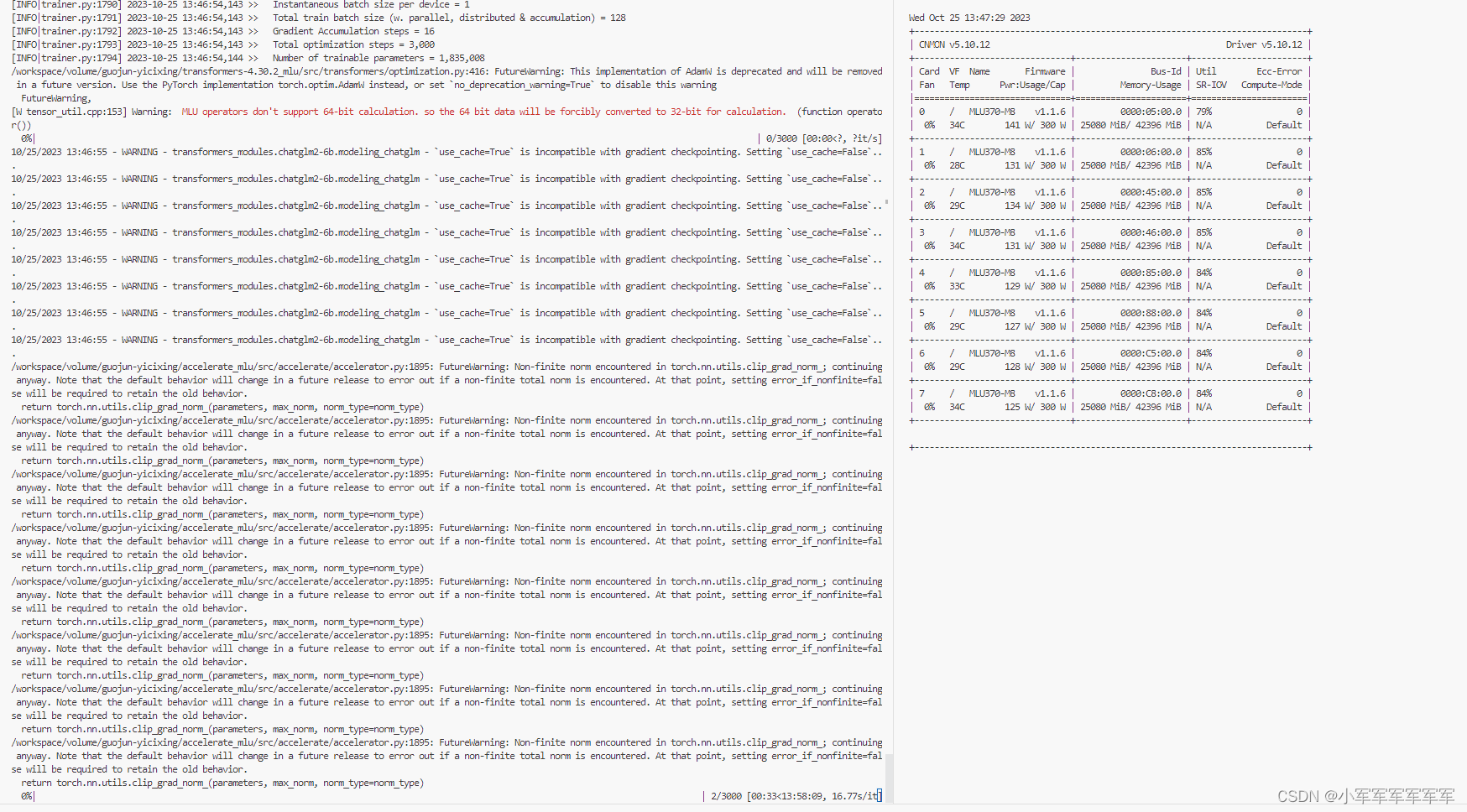

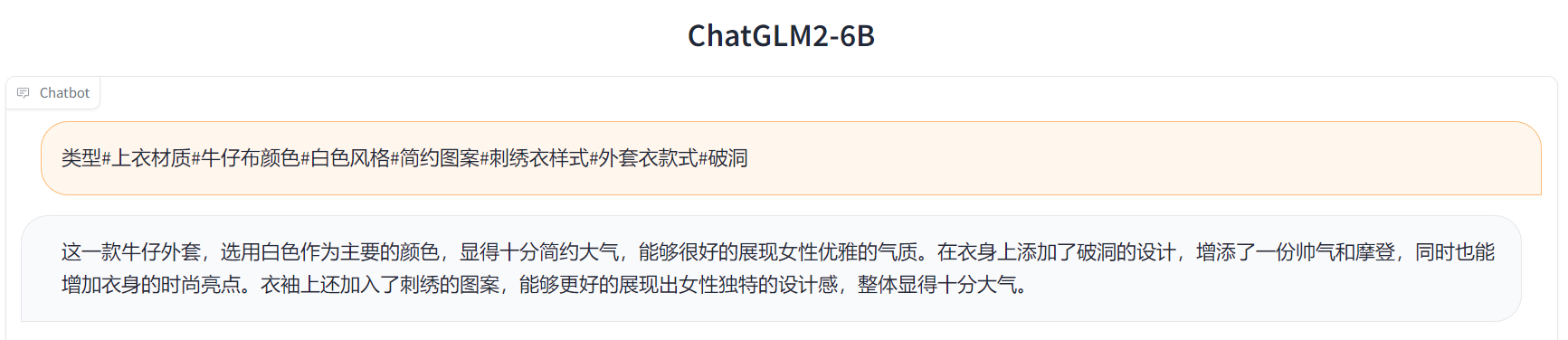

寒武纪芯片MLU370-M8完成GLM2-6B多轮对话Ptuning-v2

文章目录 前言一、环境准备1.云平台环境准备2.私有库安装3.快速模型下载4.代码修改 二、开始运行1.启动脚本2.运行状态 总结 前言 前几篇讲到了有关大模型在寒武纪卡上推理,是不是觉得越来越简单了,接下来上干活知识,基于寒武纪卡完成大模型微调,以及后面还会讲到基于寒武纪卡完成数字人训练+推理,敬请期待。 废话不多说,我们现在开始 一、环境准备 1.云平台环境准备

ChatGLM2-6B的通透解析:从FlashAttention、Multi-Query Attention到GLM2的微调、源码解读

目录 前言 第一部分 相比第一代的改进点:FlashAttention与Multi-Query Attention 第二部分 FlashAttention:减少内存访问提升计算速度——更长上下文的关键 2.1 FlashAttention相关的背景知识 2.1.1 Transformer计算复杂度:编辑——Self-Attention层与MLP层 2.1.1.1 Self-Atte