ggml专题

gpt2使用ggml推理

gpt2使用ggml推理 ggml/examples/gpt-2/main-backend.cpp : #include "ggml/ggml.h"#include "ggml/ggml-alloc.h"#include "ggml/ggml-backend.h"#ifdef GGML_USE_CUDA#include "ggml-cuda.h"#endif#ifdef GGML_US

【LocalAI】(10):在autodl上编译embeddings.cpp项目,转换bge-base-zh-v1.5模型成ggml格式,本地运行main成功

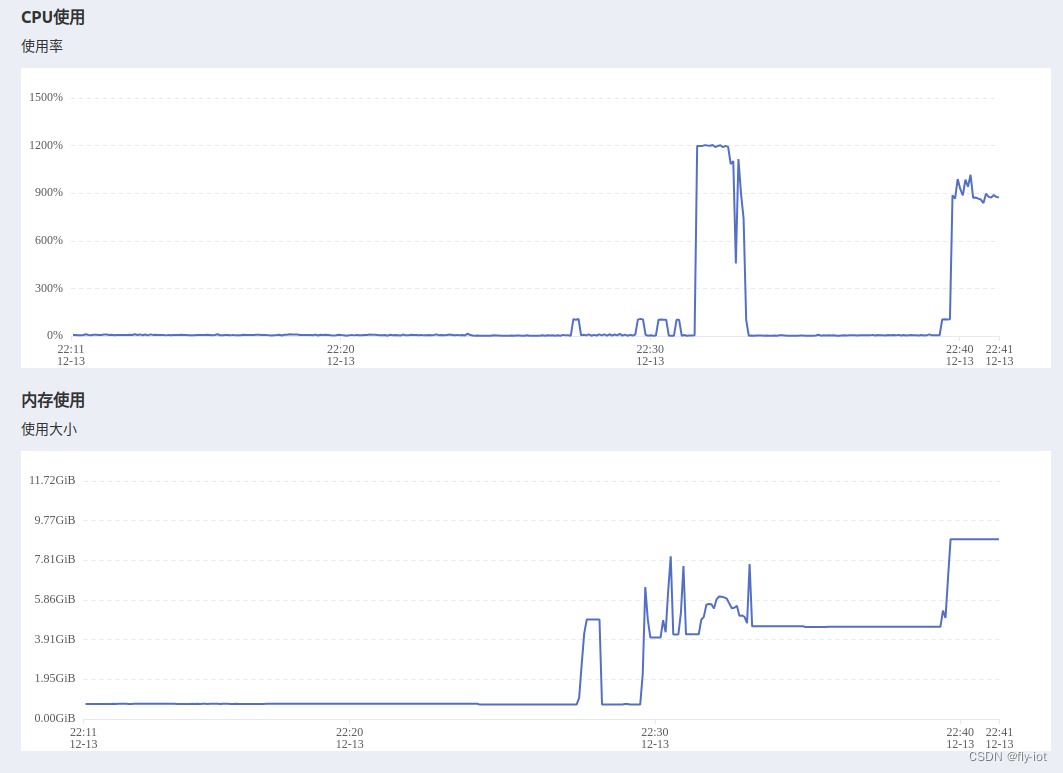

1,关于 localai LocalAI 是一个用于本地推理的,与 OpenAI API 规范兼容的 REST API。 它允许您在本地使用消费级硬件运行 LLM(不仅如此),支持与 ggml 格式兼容的多个模型系列。支持CPU硬件/GPU硬件。 【LocalAI】(10):在autodl上编译embeddings.cpp项目,转换bge-base-zh-v1.5模型成ggml格式

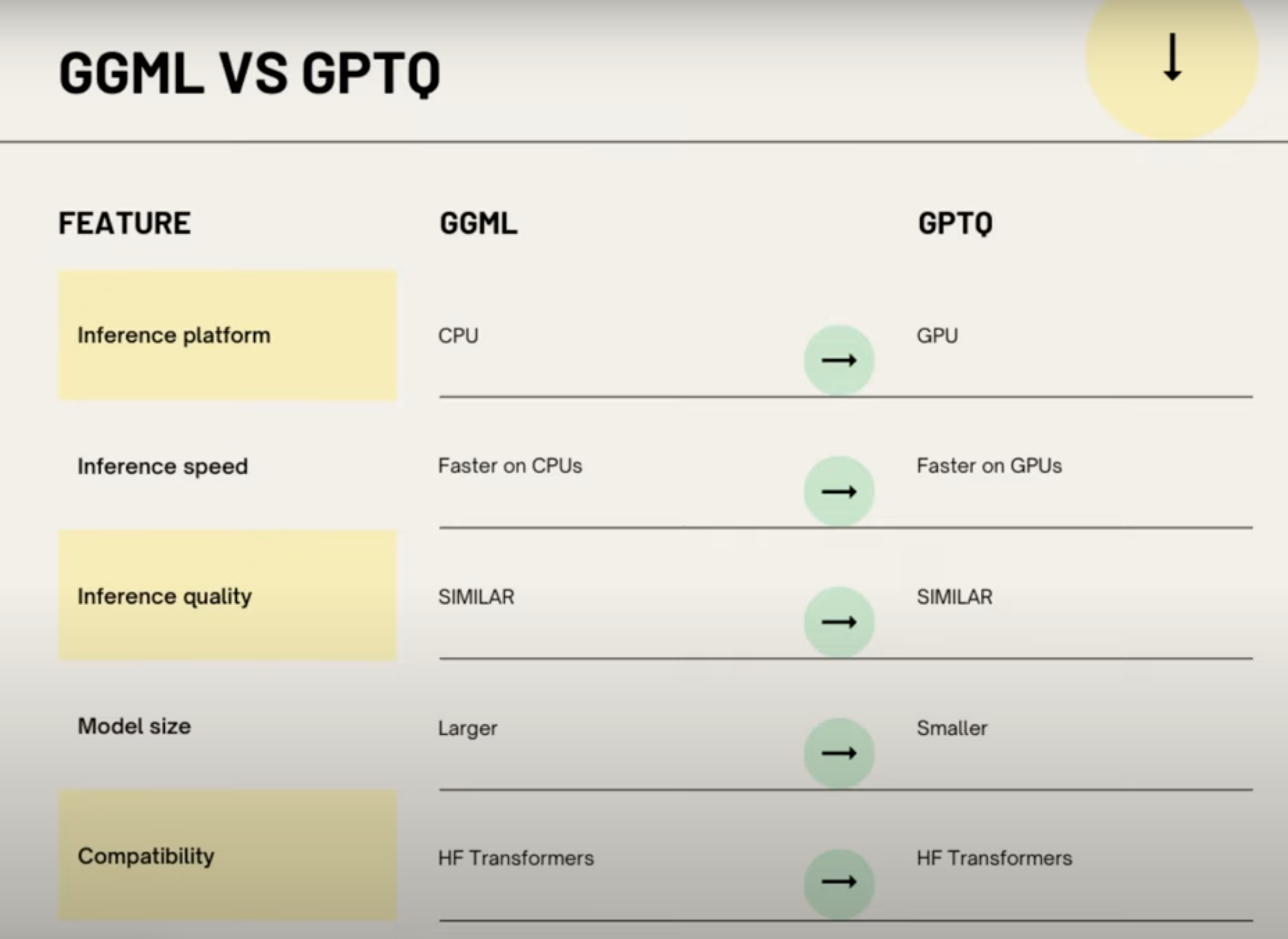

AI大模型量化格式介绍(GPTQ,GGML,GGUF,FP16/INT8/INT4)

在 HuggingFace 上下载模型时,经常会看到模型的名称会带有fp16、GPTQ,GGML等字样,对不熟悉模型量化的同学来说,这些字样可能会让人摸不着头脑,我开始也是一头雾水,后来通过查阅资料,总算有了一些了解,本文将介绍一些常见的模型量化格式,因为我也不是机器学习专家,所以本文只是对这些格式进行简单的介绍,如果有错误的地方,欢迎指正。 What 量化 量化在 AI 模型中,特别是在深度

webassembly003 MINISIT mnist/convert-h5-to-ggml.py

数据结构 # Convert MNIS h5 transformer model to ggml format## Load the (state_dict) saved model using PyTorch# Iterate over all variables and write them to a binary file.## For each variable, write

【candle】(2):使用hf-mirror镜像下载TheBloke/Llama-2-7B-GGML的q4_0.bin文件,并设置HF_HOME,example模块可以识别下载的模型

1,视频演示地址 https://www.bilibili.com/video/BV1Dc41117wT/?vd_source=4b290247452adda4e56d84b659b0c8a2 【candle】(2):使用hf-mirror镜像下载TheBloke/Llama-2-7B-GGML的q4 2,安装rust到其他目录 默认的安装模式: curl --proto