ftrl专题

FTRL(Follow The Regularized Leader)学习总结

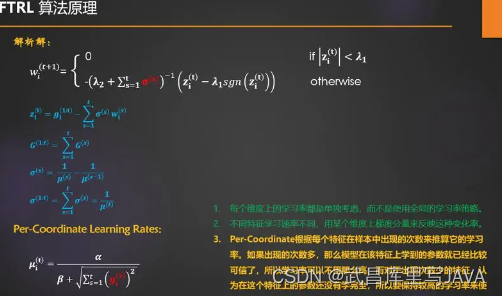

FTRL(Follow The Regularized Leader)学习总结 摘要: 1.算法概述 2.算法要点与推导 3.算法特性及优缺点 4.注意事项 5.实现和具体例子 6.适用场合 内容: 1.算法概述 FTRL是一种适用于处理超大规模数据的,含大量稀疏特征的在线学习的常见优化算法,方便实用,而且效

Online learning系列:从RDA、FOBOS到FTRL

前言 在一般的机器学习任务中,往往是通过batch的训练方法进行离线训练,然后线上进行预测,通常离线模型更新的时间在1天以上,这就使得模型不能及时学到实时的特征;另一方面,如果要进行实时训练的话,需要特征尽量稀疏,因为大规模的机器学习往往伴随着大量的参数,如果做不到特征计量稀疏的话,实时预估时延就会很大,这个时候就要用到online learning的一些方法,其目的是在提高训练参数稀疏性的同时

20240317-2-推荐算法FTRL

FTRL FTRL(Follow the Regularized Leader) 由Google的H. Berendan McMahan 等人于2010年提出【4】,FTRL是一种在线最优化求解算法,结合L1-FOBOS和L1-RDA算法,用于解决在线学习中,权重参数不能产生较好的稀疏性的问题。 由于在线学习涉及内容较多,本文从提升模型稀疏性的角度入手,简单介绍经典的TG, L1-FOBOS

各类优化方法总结(从SGD到FTRL)

目录 目录各类优化方法总结 1. SGD2. Momentum3. Nesterov4. Adagrad5. Adadelta6. Adam7. FTRL 参考资料 各类优化方法总结 为了方便描述,假设第 t t t轮要更新的某参数是wtwtw_t, loss l o s s loss函数关于 wt w t w_t的偏导数表示为 gt g t g_t,即:

FTRL算法性能优化

原算法(Worker端): 1. 对1个mini-batch, 得到每个sample的非0特征值的feature-id,排序(ps-lite要求Key必须有序),去重 2. 以这组feature-id为Key, 从Server上Pull,得到对应的weights 3. 对每个sample[i], 对其所有非0特征值的feature-id对应的weight, 进行加和,得到sum_w[i]