flops专题

pytorch计算网络参数量和Flops

from torchsummary import summarysummary(net, input_size=(3, 256, 256), batch_size=-1) 输出的参数是除以一百万(/1000000)M, from fvcore.nn import FlopCountAnalysisinputs = torch.randn(1, 3, 256, 256).cuda()fl

参数量Params和每秒浮点运算次数FLOPs的单位是多少

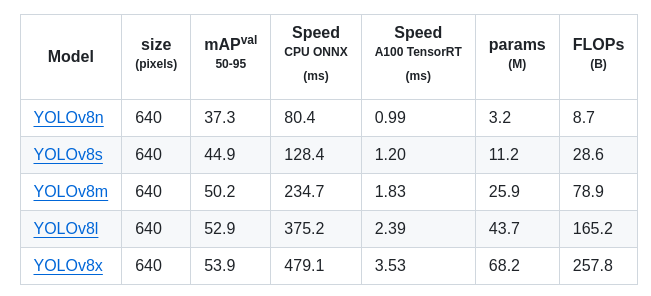

先看一下yolov8的表 模型计算量(FLOPs)和参数量(Params)是衡量深度学习算法复杂度的两个重要指标,它们可以用来评估一个模型的性能和实用性。以下是对这两个指标的理解: 1、Params - 参数量 即模型中需要学习的参数数量,它是衡量模型复杂度的另一个重要指标。模型的参数量越多,表示模型的表达能力越强,但也意味着模型需要更多的计算资源和数据来训练和推断。比如,在训练模型

FLOPs与模型推理速度关系

2020/04/22更新 刚在相关问题回答里跟ResNest作者讨论的时候又发现一个学术论文与工业界需求偏差的地方。 好多使用attention的网络,比如x=x*sigmoid(x),实际上需要把tensor拷贝一次,这其实增大了显存占用,而显存占用是影响工业界实际应用的。因为工业界考虑的不是FLOPs,甚至也不是单纯的inference time,考虑的是把一块儿GPU打满情况下的QPS(

UVA 11552 Fewest Flops

水题 #include<cstdio>#include<iostream>#include<cstring>#include<algorithm>#define MAX 1100using namespace std;char s[MAX];int L,k,dp[MAX][26],count_t[26];void init(){cin>>k;cin>>s;L=strlen(s);

uva 11552 - Fewest Flops(dp)

题目链接:uva 11552 - Fewest Flops 题目大意:给定一个k,和一个字符串,字符串长度是k的倍数,将字符串分成len/k份,每一份中的字母可以任意交换位置,现在要求每一份中的字母重排之后,字母块数最小。 解题思路:dp[i][j]表示在第i/k份以j字符结尾的字母块数。 #include <stdio.h>#include <string.h>#

UVA11552——Fewest Flops(DP)

FEWEST FLOPS A common way to uniquely encode a string is by replacing its consecutive repeating characters (or “chunks”) by the number of times the character occurs followed by the characte

YOLOv8改进 | Conv篇 | CVPR2024最新DynamicConv替换下采样(包含C2f创新改进,解决低FLOPs陷阱)

一、本文介绍 本文给大家带来的改进机制是CVPR2024的最新改进机制DynamicConv其是CVPR2024的最新改进机制,这个论文中介绍了一个名为ParameterNet的新型设计原则,它旨在在大规模视觉预训练模型中增加参数数量,同时尽量不增加浮点运算(FLOPs),所以本文的DynamicConv被提出来了,使得网络在保持低FLOPs的同时增加参数量,从而允许这些网络从大规模视觉预训练中

Matlab中使用FLOPS计算代码复杂度(浮点数运算次数)方法

参考网址 Counting the Floating Point Operations (FLOPS) - File Exchange - MATLAB Central (mathworks.cn) 方法介绍 第1步 准备好需要计算浮点数运算次数的Matlab的.m文件。需要注意的是,尽量让代码结构尽可能简单,只调用常见的函数运算、矩阵操作等。如果代码中必须要调用自己构建的函数,则必须通过

如何计算lstm网络的复杂度 乘法次数 flops(未完成)

计算算法复杂度的一种方法是计算前向算法的乘法次数,因此在这篇文章中计算复杂度的方法是计算lstm网络的乘法运算次数 首先要弄清楚lstm的cell中的乘法次数 cell有4个输入,一个输出 有三个门,input gate控制数据输不输进来,不输入就输入0 forget gate控制保存单元memory cell更不更新,不更新就维持原状 output gate控制计算的值输不输出,不

「HDLBits题解」Latches and Flip-Flops

本专栏的目的是分享可以通过HDLBits仿真的Verilog代码 以提供参考 各位可同时参考我的代码和官方题解代码 或许会有所收益 题目链接:Dff - HDLBits module top_module (input clk, // Clocks are used in sequential circuitsinput d,output reg q );//// Use a

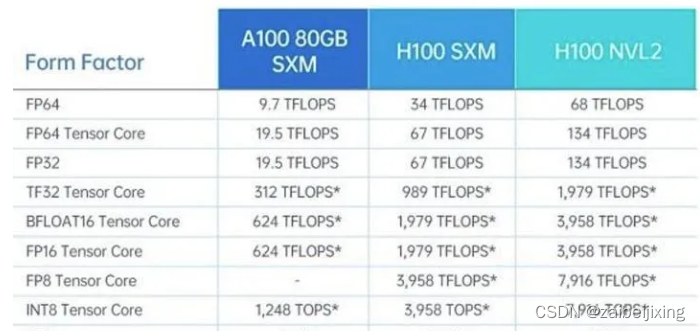

算力-计算量,关于TOPS和FLOPS,及FLOPs

目录 一、易混淆的三个点 二、芯片算力单位详解 四、模型算力单位详解 五、算力单位量级变换 六、计算机存储单位换算 七、科学计算单位换算 一、易混淆的三个点 关于TOPS和FLOPS,及FLOPs,这里有3个易混淆的点。 1、最大的混淆点,上述三个名词是两种东西,注意“S/s”的大小写。TOPS和FLOPS指的是每秒的计算量,算是速度方面的,用在芯片算力性能上。F

FLOPS、TOPS和FLOPs的区别

FLOPS,即每秒浮点运算次数, 是每秒所执行的浮点运算次数(Floating-point operations per second;缩写:FLOPS)的简称,被用来评估电脑效能. FLOPs:注意s小写,是floating point operations的缩写(s表复数),意指浮点运算数,理解为计算量, 可以用来衡量算法/模型的复杂度。 常用框架的复杂度 TOPS(Tera Operat

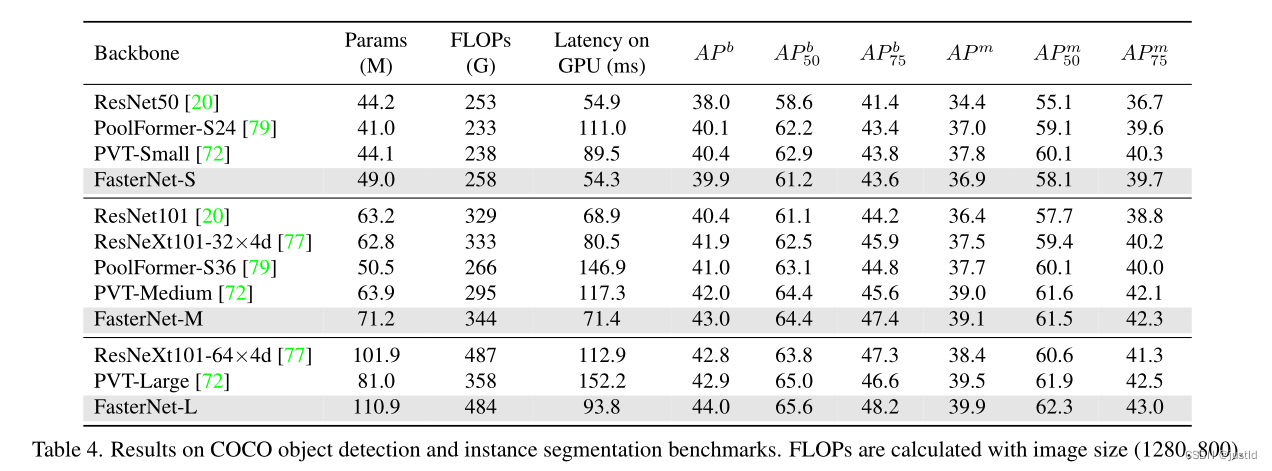

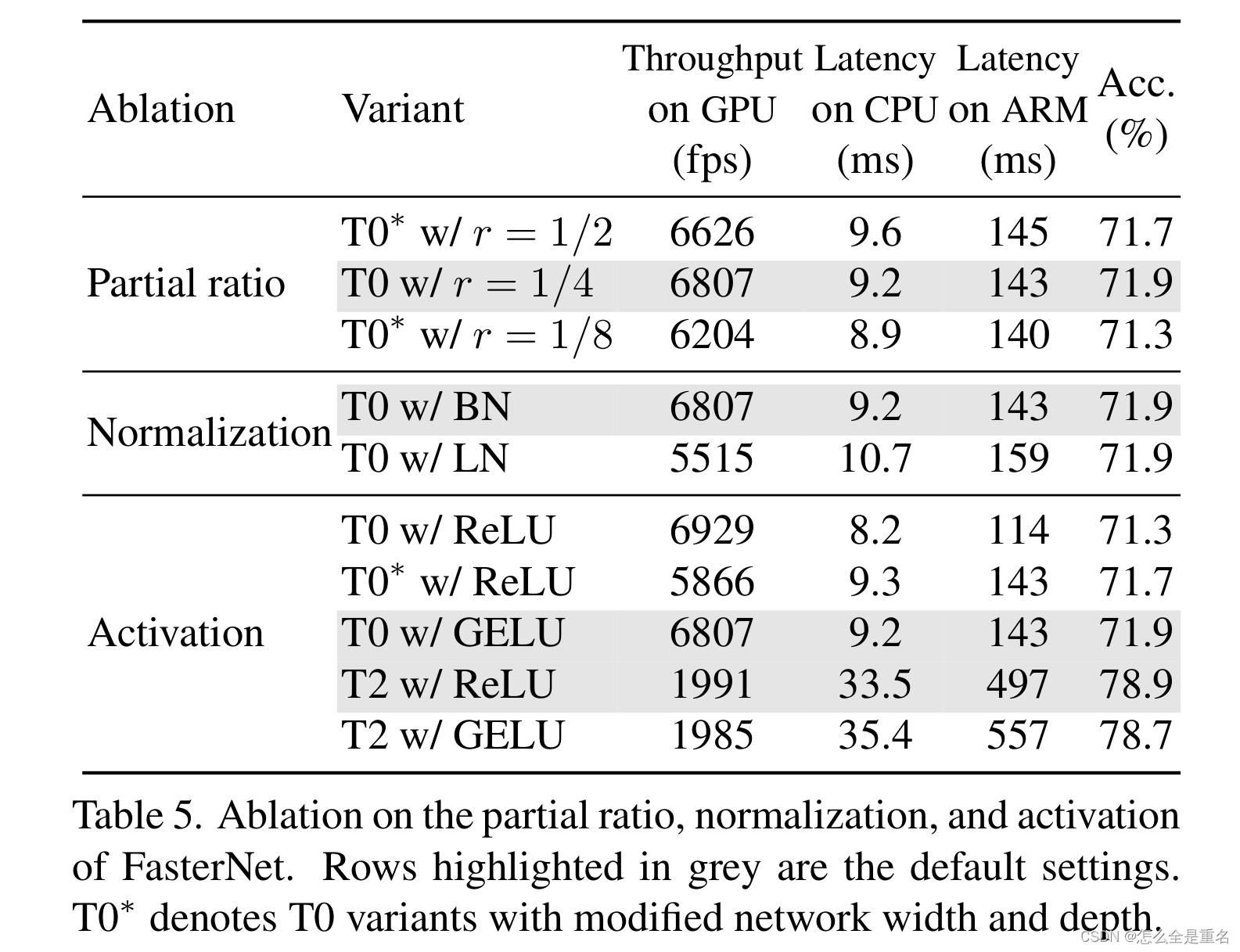

【论文笔记】Run, Don’t Walk: Chasing Higher FLOPS for Faster Neural Networks

论文地址:Run, Don't Walk: Chasing Higher FLOPS for Faster Neural Networks 代码地址:https://github.com/jierunchen/fasternet 该论文主要提出了PConv,通过优化FLOPS提出了快速推理模型FasterNet。 在设计神经网络结构的时候,大部分注意力都会放在降低FLOPs( float

【论文笔记】Run, Don’t Walk: Chasing Higher FLOPS for Faster Neural Networks

论文地址:Run, Don't Walk: Chasing Higher FLOPS for Faster Neural Networks 代码地址:https://github.com/jierunchen/fasternet 该论文主要提出了PConv,通过优化FLOPS提出了快速推理模型FasterNet。 在设计神经网络结构的时候,大部分注意力都会放在降低FLOPs( float

【深度学习】关于CNN网络的FLOPs的计算

在评估一个CNN网络的计算复杂度时,浮点数运算(float point operation)是一个常用的衡量指标。注意本文介绍的主要是MAC(乘法加法操作),在一些论文里是仅仅考虑乘法操作的。 在常规的计算中,通常不考虑非线性函数的计算量(the nonlinearity),对于卷积操作:(带bias) F L O P s = 2 ∗ H W ∗ ( C i n K 2 + 1 ) C o

深度学习中FLOPs计算

深度学习中FLOPs计算 定义:FLOPs(floating point operations),即浮点数运算次数,是一个计算量,所以可以用来衡量一个算法/模型等的复杂度 FLOPs是用来计算整个网络模型中乘法/加法的运行次数,是衡量算法的间接指标。下面通过卷积的例子来阐述计算FLOPs的方式。 假设 输入特征大小: H i n × W i n × C i n H_{in} \times W

Run, Don‘t Walk: Chasing Higher FLOPS for Faster Neural Networks(CVPR2023)

文章目录 AbstractIntroduction过去工作存在的不足我们的工作主要贡献(待参考) Related workCNNViT, MLP, and variants Design of PConv and FasterNetPreliminaryPartial convolution as a basic operatorPConv followed by PWConvFaster

图像处理论文中parameters和FLOPs

看论文时经常遇到FLOPS and the number of parameters,不是很清楚是个什么东西,这篇文章给了一定的说明。 原文链接:https://blog.csdn.net/sinat_34460960/article/details/84779219 在这之前我们先看一下CNN的前向传播计算公式,便于理解什么是parameters和FLOPs,这里参考Andrew老师课堂上的