flannel专题

容器网络(桥接、host、none)及跨主机网络(etcd、flannel、docker)

1.本地网络 1.bridge 所有容器连接到桥就可以使用外网,使用nat让容器可以访问外网,使用ip a s指令查看桥,所有容器连接到此桥,ip地址都是 172.17.0.0/16网段,桥是启动docker服务后出现,在centos使用bridge-utils安装。 下载bridge-utils [root@docker0 ~]# yum -y install bridg

K8S Flannel

k8s Flannel 是Kubernetes集群中的一个重要网络插件,它主要用于为容器提供网络互通能力,实现跨节点的容器网络通信。以下是对Flannel的详细解析: 一、Flannel概述 定义:Flannel是一个用于容器网络的开源项目,是Kubernetes集群中的一个网络插件。它通过使用虚拟网络覆盖技术(如VXLAN、UDP、Host-GW等),为Kubernetes集群中的Pod提供

Kubernetes网络-Flannel网络

一、简介 Flannel是CoreOS团队针对Kubernetes设计的一个网络规划服务,简单来说,它的功能是让集群中的不同节点主机创建的Docker容器都具有全集群唯一的虚拟IP地址。 在默认的Docker配置中,每个节点上的Docker服务会分别负责所在节点容器的IP分配。这样导致的一个问题是,不同节点上容器可能获得相同的内外IP地址。并使这些容器之间能够之间通过IP地址相互找到,也就是相

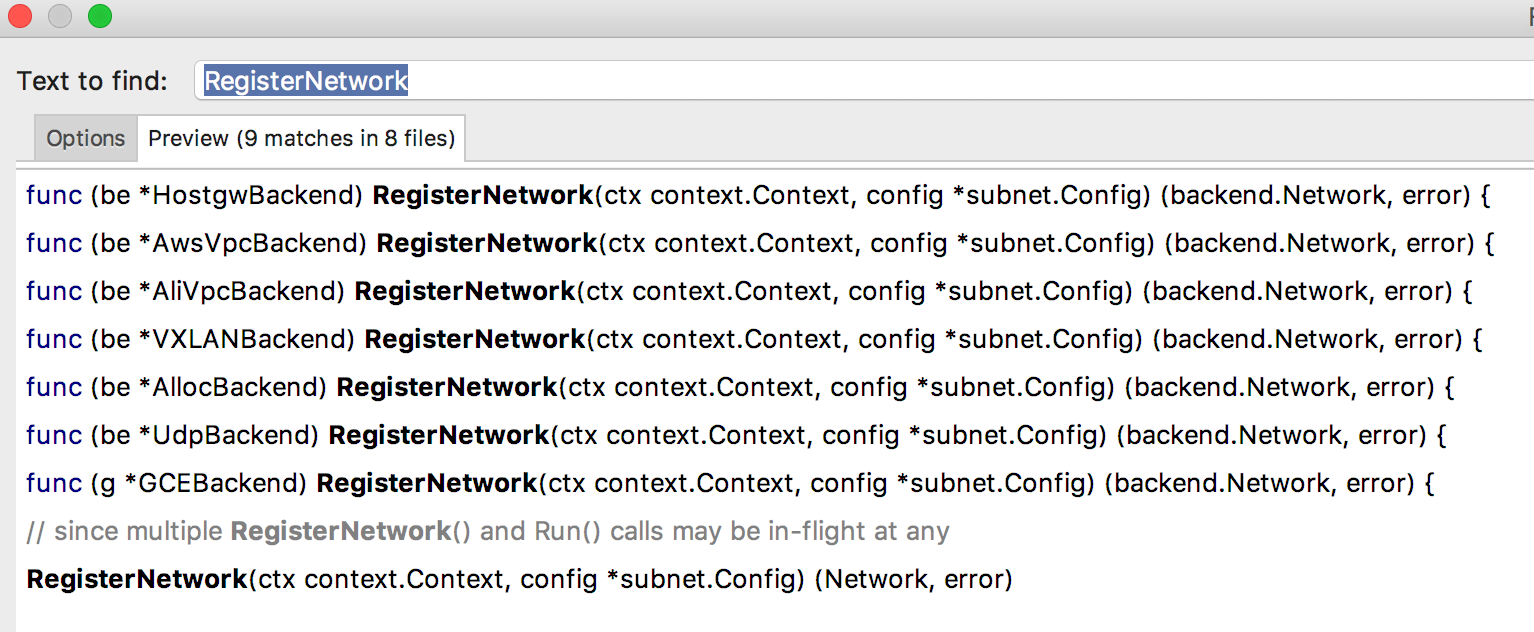

flannel 实战与源码分析(七)

这是flannel最后一篇,我原本不准备介绍UDP,因为这种方案的网络损耗实在是太多,大约一半损耗,vxlan大约是30%损耗。但基本的UDP使用我还是想和大家分享一下的,主要是tun设备的使用。 像UDP的RegisterNetwork和VXLAN一样,我就不单独说了backend/udp/udp_network.go。 func (n *network) Run(ctx context.C

flannel 实战与源码分析(六)

其实flannel的东西基本都说完了,还有一个功能点由于和kubernetes紧密结合的,所以在这里解释一下。相信大家都还记得之前写的创建SubnetManager func newSubnetManager() (subnet.Manager, error) {if opts.kubeSubnetMgr {return kube.NewSubnetManager()}cfg := &etcd

flannel 实战与源码分析(三)

之前一直介绍flannel的使用,现在正是进入代码讲解,看看flannel是如何实现的,先看启动 func main() {flag.Set("logtostderr", "true")// 解析参数flag.Parse()if flag.NArg() > 0 || opts.help {fmt.Fprintf(os.Stderr, "Usage: %s [OPTION]...\n", os.

flannel 实战与源码分析(二)

上一篇介绍了基本使用,这一篇我想详细介绍一下flannel网络包的是怎样传输的,应为这些基本东西没有解释清楚,只看代码是没法理解的。先看看一张经典图: 这个是flannel官方提供的一个数据包图,从这个图片里面里面可以看出docker0分别处于不同的段:10.1.20.1/24 和 10.1.15.1/24 现在从上面的一个pod(10.1.15.2)去连接另一台主机上的pod(10.1.2

flannel 实战与源码分析(一)

Flannel 是由 CoreOS 维护的一个虚拟网络方案。目前是kubernetes默认的网络,它有golang编写,在源码分析之前还是先看看怎样使用。这里不得不提一下kubernetes网络约束: 1. 所有容器之间都可以无须SNAT即可相互直接以IP通信。 2. 所有主机与容器之间都可以无须SNAT即可相互直接以IP通信。 3. 容器看到的自身IP与其他容器看到的容器IP相同。 当然

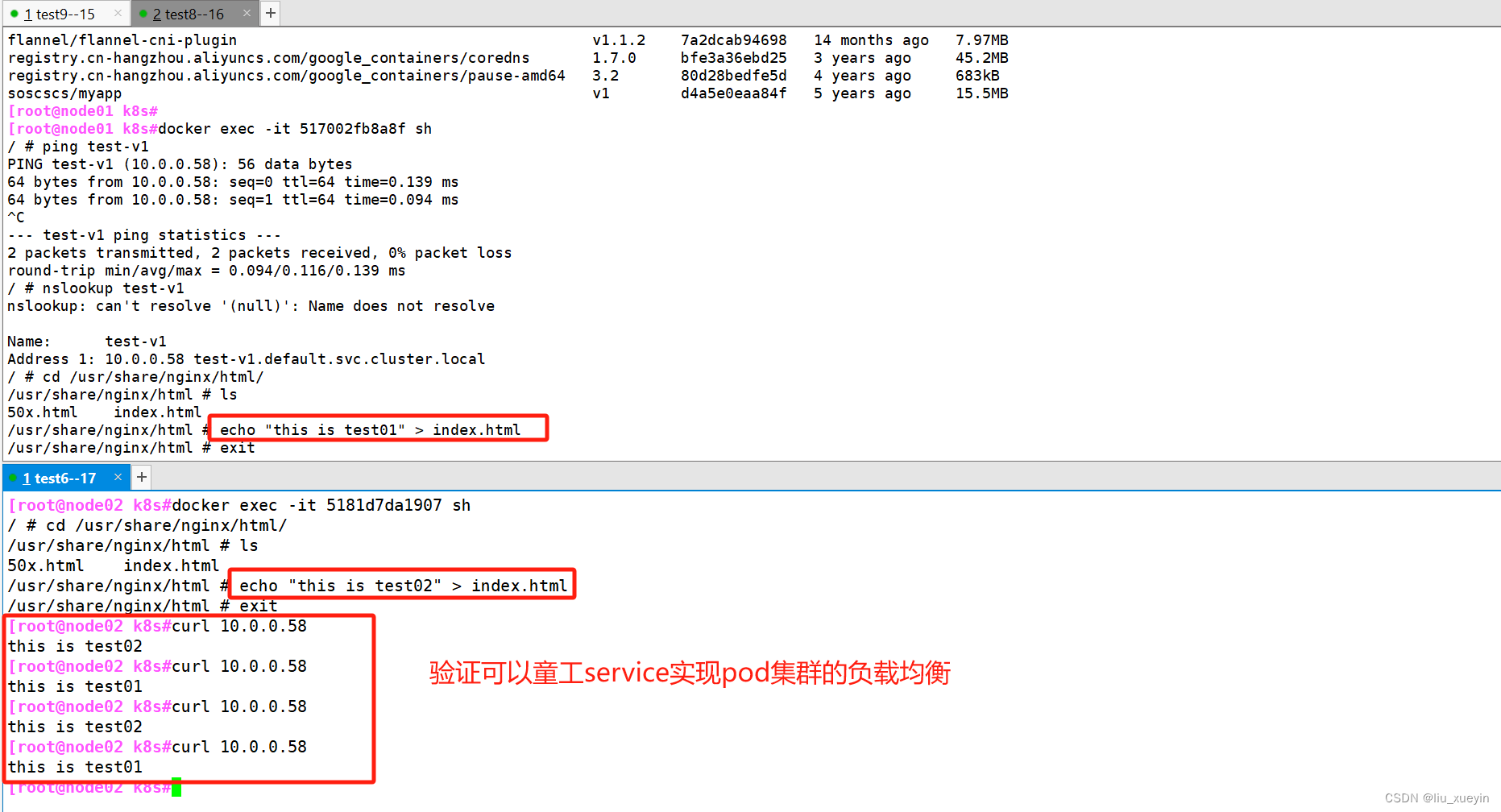

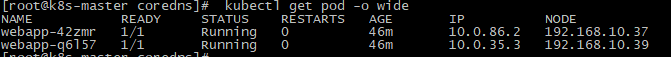

flannel实现跨主机容器通信测试

背景 在上篇《K8S集群搭建——基于CentOS 7系统》中,我们使用flannel解决跨主机容器的通信,但是并没有实际测试,因此我们动手测试验证一下。 测试思路 通过在两台机器上各启动一个centos7容器,并进入容器中ping另一个容器的IP,观察是否能通。 测试前提 在两个node节点上拉取centos 7的镜像,鉴于docker.io过慢,我们使用中科大的镜像仓库拉取, doc

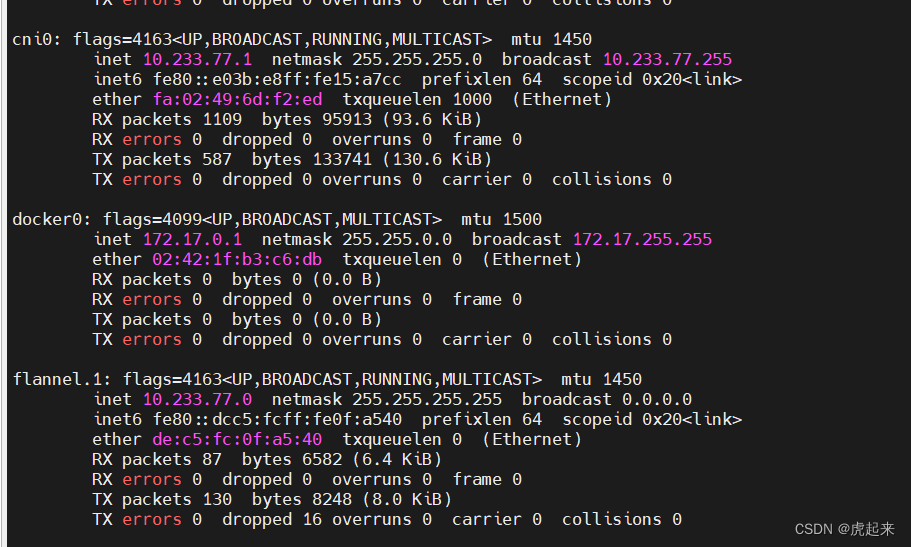

清楚flannel 网络

清楚flannel 网络 ifconfig cni0 downifconfig flannel.1 downifconfig del flannel.1ifconfig del cni0ip link del flannel.1ip link del cni0如果没有 brctl 命令apt install bridge-utilsbrctl delbr flannel.1brct

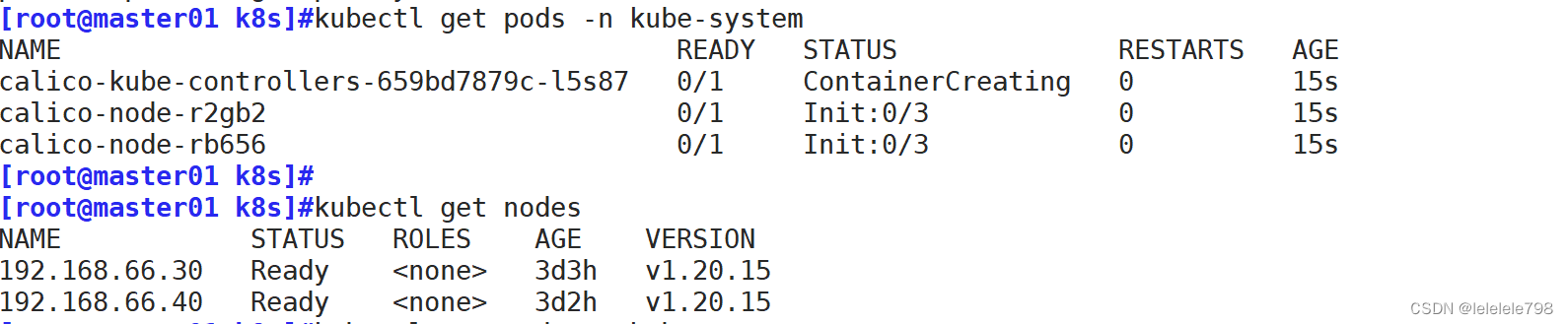

K8S安装网络插件flannel问题修复(cni plugin not initialized)

K8S安装网络插件问题修复 卸载flannel网络步骤: #第一步,在master节点删除flannel kubectl delete -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml kubectl delete -f kube-flannel.yml

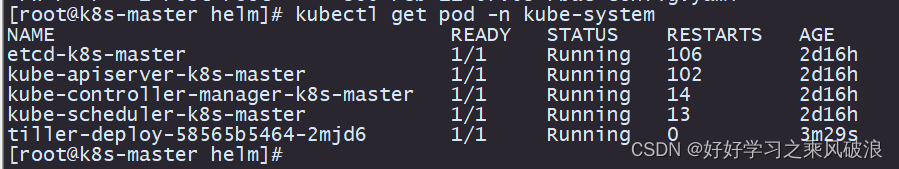

决战k8s,Kubernetes、二进制包安装方式,Etcd集群+Flannel,超细详解 ,安装篇①

文章目录 概念图Kubernetes集群部署方式1、Kubernetes集群部署架构规划机器配置要求: 3G 时间同步,防护墙关闭1部署Etcd集群证书配置完成配置一台即可安装Etcd:配置systemd管理etcd:全部启动并设置开启启动:排错思路自此etcd集群,安装完毕在Node节点安装Docker 接着操作**部署Flannel网络**配置Flannel:systemd管理Flann

k8s的flannel和cilium的pod网络访问链路解析

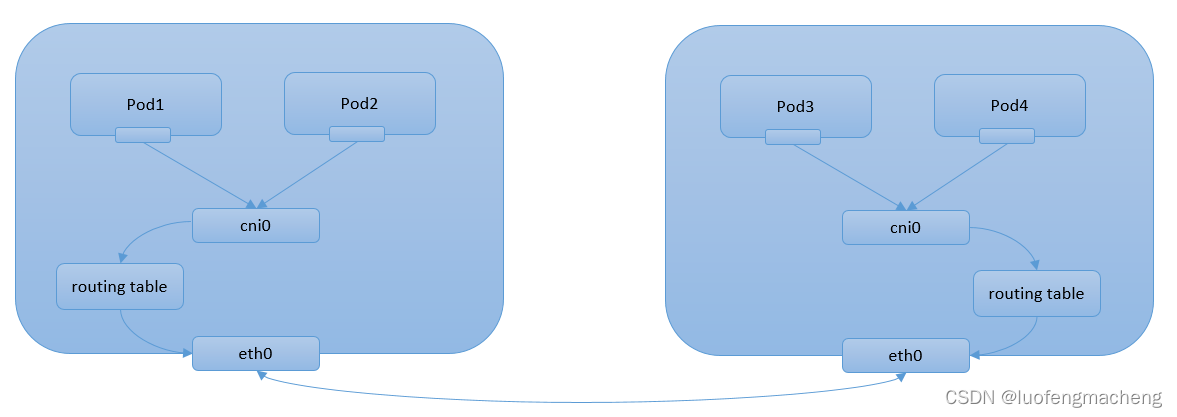

k8s的flannel和cilium的pod网络访问链路解析 1. k8s环境中基础模型1.1. Pod接入网络的具体实现1.1.1. 虚拟网桥1.1.2. 多路复用1.1.3. 硬件交换 1.2. 实现思路1.2.1. 流程图1.2.2 常见插件 2. flannel相关配置2.1. 集群节点的网络分配2.2 各节点flannel分配情况2.3 flannel运行方式2.4. Flann

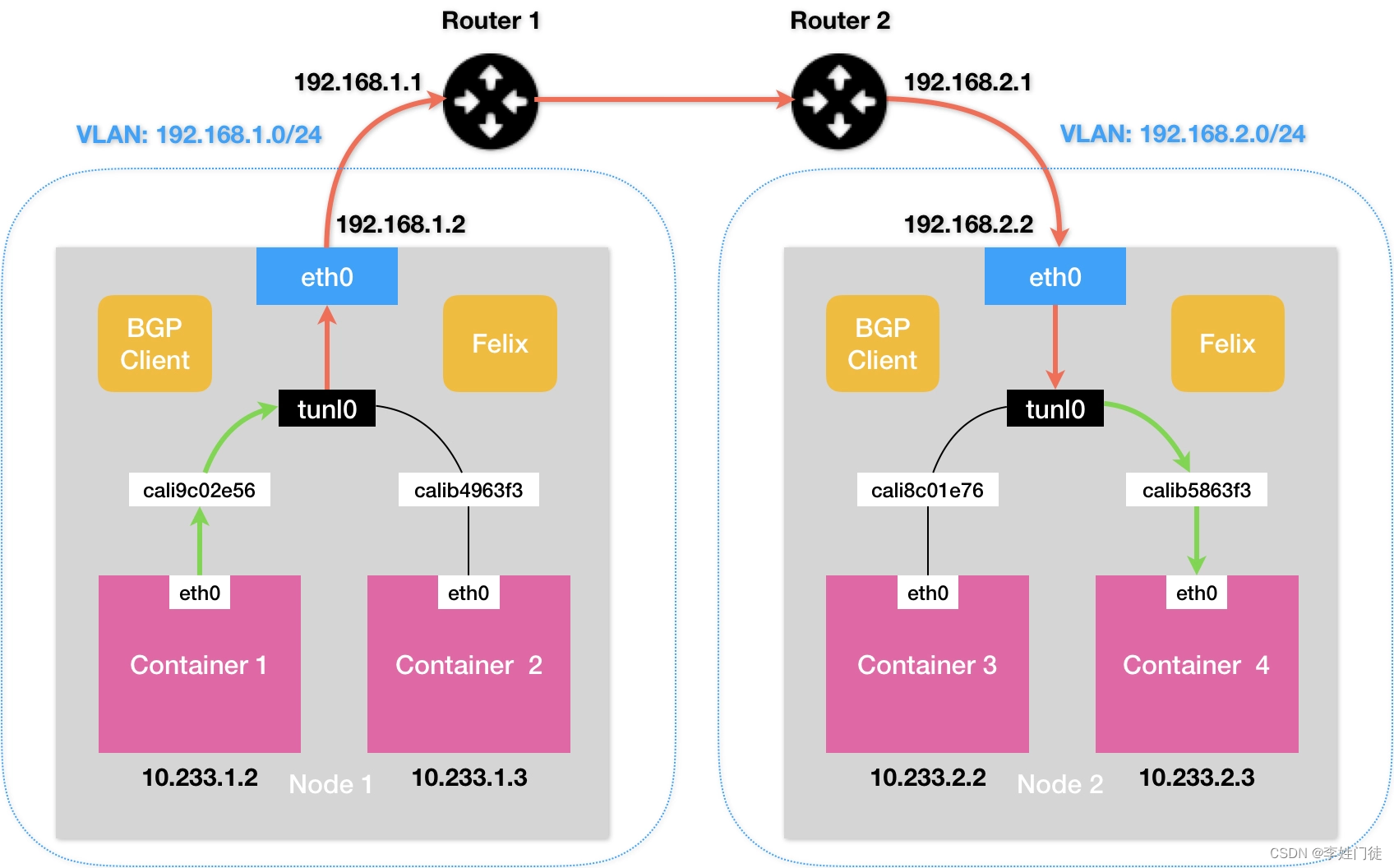

【kubernetes】二进制部署k8s集群之cni网络插件flannel和calico工作原理

k8s集群的三种接口 k8s集群有三大接口: CRI:容器进行时接口,连接容器引擎--docker、containerd、cri-o、podman CNI:容器网络接口,用于连接网络插件如:flannel、calico、cilium CSI:容器存储接口,如nfs、ceph、gfs、oss、s3、minio k8s的三种网络模式 节点网络 nodeIP

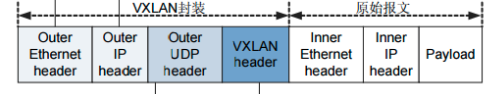

【kubernetes】二进制部署k8s集群之cni网络插件flannel和calico工作原理(中)

↑↑↑↑接上一篇继续部署↑↑↑↑ 目录 一、k8s集群的三种接口 二、k8s的三种网络模式 1、pod内容器之间的通信 2、同一个node节点中pod之间通信 3、不同的node节点的pod之间通信 Overlay Network VXLAN 三、flannel网络插件 1、flannel插件模式之UDP模式(8285端口) 2、flannel插件模式之VXLAN模式 3、

【kubernetes】集群网络(二):Flannel的VxLan、Host-GW模式

文章目录 1 Pod的IP地址的分配2 CNI3 Flannel3.1 Flannel的安装3.2 VxLan3.3 Host-GW 4 总结 1 Pod的IP地址的分配 当节点上只安装了docker,则会用veth pair+docker0实现单个节点上容器之间的通信,并且这些容器都在同一个IP段,如果不修改,则默认为172.17.0.0/16,此时,docker0的ip就

k8s实践(4)--k8s集群网络详解和flannel(转载)

一、Docker网络模式 在讨论Kubernetes网络之前,让我们先来看一下Docker网络。Docker采用插件化的网络模式,默认提供bridge、host、none、overlay、maclan和Network plugins这几种网络模式,运行容器时可以通过–network参数设置具体使用那一种模式。 bridge:这是Docker默认的网络驱动,此模式会为每一个容器分配Network

深入 K8s 网络原理(一)- Flannel VXLAN 模式分析

1. 概述 这周集中聊下 K8s 的集群网络原理,我初步考虑分成3个方向: Pod-to-Pod 通信(同节点 or 跨节点),以 Flannel VXLAN 模式为例; Pod/External-to-Service 通信,以 iptables 实现为例; Ingress 原理,以 NGINX Ingress Controller 实现为例; 其他:(

集群创建(flannel)时候,没有自动创建出cni0网卡

给旧的集群加入四台新的服务器启动时候发现都是正常的,但是pod通信报错 集群通信失败,第一时刻想看看是不是cni0和flannel.1的网段是不是通的,点进去一看发现cni0网卡没有生成。 部署是通过kubeadm方式部署的集群,目前有两种解决方式,亲测都可行 (1)删除节点node,kubectl delete node然后重新加入集群 通过kk方式部署,重新加入集群时候生成 (2)第二种我用

Pod提示NetworkPlugin cni failed to set up .. network:open/run/flannel/subnet.env:nosuchfileordirectory

K8s在创建pod时发现pod状态为ContainerCreating状态 检查pod的日志发现提示 Failed create pod sandbox: rpc error: code = Unknown desc = failed to set up sandbox container "fdd30141bf51b68d4f08a2405ea287508aa0d585d30c853a849

第九课 k8s网络CNI插件学习-Flannel网络插件

第九课 k8s网络CNI插件学习-Flannel网络插件 tags: k8s网络VxlanIPIPIPAM 文章目录 第九课 k8s网络CNI插件学习-Flannel网络插件第一节 Flannel学习准备1.1 Flannel环境1.2 CNI的设计介绍 第二节 Flannel的UDP模式2.1 UDP的模式环境2.2 UDP的模式介绍2.3 同一节点不同pod内的通信2.4 不同节点

Kubernetes(k8s)CNI(flannel)网络模型原理

一、概述 Kubernetes 采用的是基于扁平地址空间的、非NAT的网络模型,每个Pod有自己唯一的IP地址。网络是由CNI(container network interface)插件建立的,而非K8S本身。 二、常见的几种CNI插件介绍 为了使容器之间的通信更加方便,Google 和 CoreOS 主导制定了一个容器网络标准CNI(Conteinre Network Inter

k8s实践(4)--k8s集群网络详解和flannel

一、Docker网络模式 在讨论Kubernetes网络之前,让我们先来看一下Docker网络。Docker采用插件化的网络模式,默认提供bridge、host、none、overlay、maclan和Network plugins这几种网络模式,运行容器时可以通过–network参数设置具体使用那一种模式。 容器网络模型-The Container Network Mo

k8s kubernetes 1.23.6 + flannel公网环境安装

准备环境,必须是同一个云服务厂商,如:华为,阿里、腾讯等,不要存在跨平台安装K8S,跨平台安装需要处理网络隧道才能实现所有节点在一个网络集群中,这里推荐使用同一家云服务厂商安装即可 这里使用centos7进行安装: 必须先开通端口 2380 2379 10250 10257 10259 6443 否则会网络卡死(主节点主机安装即可) 开通安全组端口: 2376/tcp、2379/tcp、238

k8s kubernetes 1.23.6 + flannel公网环境安装

准备环境,必须是同一个云服务厂商,如:华为,阿里、腾讯等,不要存在跨平台安装K8S,跨平台安装需要处理网络隧道才能实现所有节点在一个网络集群中,这里推荐使用同一家云服务厂商安装即可 这里使用centos7进行安装: 必须先开通端口 2380 2379 10250 10257 10259 6443 否则会网络卡死(主节点主机安装即可) 开通安全组端口: 2376/tcp、2379/tcp、238