expectation专题

统计计算二|EM算法(Expectation-Maximization Algorithm,期望最大化算法)

系列文章目录 统计计算一|非线性方程的求解 文章目录 系列文章目录一、基本概念(一)极大似然估计和EM算法(二)EM算法的基本思想(三)定义1、缺失数据, 边际化和符号2、Q函数3、混合高斯模型(Gaussian Mixture Model,简称GMM)4、一般混合模型 三、收敛性(一)琴生不等式(Jensen’s inequality)(二) EM 算法的收敛性质(三)MM 算法 (

期望最大化算法(expectation maximization,EM)

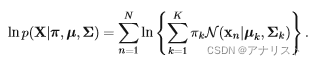

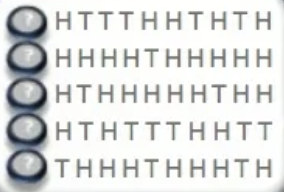

EM算法是一种迭代算法,用于含有隐变量(hidden variable)或缺失数据(incomplete-data)的概率模型参数的极大似然估计。EM算法被广泛用于高斯混合模型(Guassian Mixture Model,GMM)和隐马尔可夫模型(Hidden Markov Model,HMM)的参数估计。每次迭代分为两步:E步,求期望;M步,求极大。概率模型有时既包含观测变量(observab

【概率论】4-7:条件期望(Conditional Expectation)

原文地址1:https://www.face2ai.com/Math-Probability-4-7-Conditional-Expectation转载请标明出处 Abstract: 本文介绍期望的条件版本,也就是条件期望 Keywords: Expectation,Prediction,Law of Total Probability 条件期望 说到条件,我们前面反复说,所有概率都是条件的,

【概率论】4-1:随机变量的期望(The Expectation of a Random Variable Part II)

原文地址1:https://www.face2ai.com/Math-Probability-4-1-The-Expectation-of-a-Random-Variable-P2转载请标明出处 Abstract: 本篇介绍期望的第二部分,关于随机变量的函数的期望 Keywords: Expectation 随机变量的期望 本来这篇可以和前一篇合在一起的,但是看了下还是有点长,控制下篇幅来保证

【概率论】4-1:随机变量的期望(The Expectation of a Random Variable Part I)

原文地址1:https://www.face2ai.com/Math-Probability-4-1-The-Expectation-of-a-Random-Variable-P1转载请标明出处 Abstract: 本文主要介绍期望的基础之知识,第一部分介绍连续和离散随机变量的期望。 Keywords: Expectation 随机变量的期望 好像大家比较喜欢关于学习方面的废话,那么以后就不说

OpenCV(3)ML库-Expectation - Maximization 算法

最大期望算法(Expectation-maximization algorithm,又译期望最大化算法)在统计中被用于寻找,依赖于不可观察的隐性变量的概率模型中,参数的最大似然估计。 在统计计算中,最大期望(EM)算法是在概率(probabilistic)模型中寻找参数最大似然估计或者最大后验估计的算法,其中概率模型依赖于无法观测的隐藏变量(Latent Variable)

DEX:Deep EXpectation of apparent age from a single image(面部矫正+VGG-16 年龄估计)

文章目录 年龄估计论文阅读《DEX:Deep EXpectation of apparent age from a single image》(2015)网络图数据集和评估方法IMDB-WIKI数据集LAP数据集 评估方法实验结果总结 年龄估计论文阅读《DEX:Deep EXpectation of apparent age from a single image》(2015)

EM算法(expectation maximization algorithms)揭秘

EM算法篇 EM算法简介 EM算法,也叫expectation maximization algorithms,是在包含隐变量(未观察到的潜在变量)的概率模型中寻找参数最大似然估计(也叫最大后验估计)的迭代算法。EM 算法在期望 (E步骤) 和最大化 (M步骤) 之间交替执行,前者计算模型参数当前估计的对数似然期望函数,后者对E步骤中找到的预期对数似然计算最大化,然后使用参数新估计值来确定下一

EM(Expectation-Maximum)算法

EM算法 简介 EM算法的核心分为两步 E步(Expection-Step)M步(Maximization-Step) 因为在最大化过程中存在两个参量 r , θ r,\theta r,θ,其中若知道 r r r,则知道 θ \theta θ;若知道 θ \theta θ,则知道 r r r。且两个量未存在明显的关系,但又互相依存可以采用EM算法 其中主要思想为: 首先随机初始化参数

20-EM(Expectation-Maximum)期望最大

文章目录 1. EM 算法简介2.EM 算法来源2.1 EM 算法分解:(EM =E-Step + M-Step)2.2 EM算法来源分析2.3 EM算法来源-琴生不等式(Jensen Inequality) 3. EM算法的收敛性证明3.1 EM算法公式3.2 证明: Q ( θ ( t + 1 ) , θ ( t ) ) ≥ Q ( θ ( t ) , θ ( t ) ) Q(\the