differentially专题

Differentially Private Federated Learning: A Client Level Perspective

介绍 我们的目标并不是只保护数据。相反,我们希望确保一个学习模型不会显示客户是否参与了分散的培训。这意味着客户机的整个数据集受到保护,不受来自其他客户机的差异攻击。 我们的主要贡献:首先,我们展示了在联合学习中保持较高的模型性能时,客户机的参与是可以隐藏的。我们证明了我们提出的算法可以在模型性能损失很小的情况下实现客户级差异隐私。与此同时发表的一项独立研究[6]提出了一个类似的客户级dp程序。然

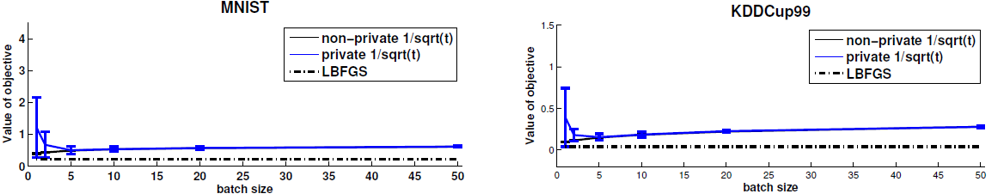

【论文记录】Stochastic gradient descent with differentially private updates

记录几条疑问 The sample size required for a target utility level increases with the privacy constraint.Optimization methods for large data sets must also be scalable.SGD algorithms satisfy asymptotic guara