deeplearning专题

基于spark相关的DeepLearning选择

背景:TensorFlow性能差强人意,但DeepLearning领域优势,spark则反之。TensorFlow训练好的模型在spark中调用各种小问题不断。 基于spark相关的DeepLearning大致看了下面这些,各有优缺点: elephas:参考:https://github.com/maxpumperla/elephas dist-keras:参考:https://github

Deeplearning 两层cnn卷积网络详解

转载地址: https://www.cnblogs.com/sunshineatnoon/p/4584427.html 在实现两层的CNN之前,首先实现了UFLDL中与CNN有关的作业。然后参考它的代码搭建了一个一层的CNN。最后实现了一个两层的CNN,码代码花了一天,调试花了5天,我也是醉了。这里记录一下通过代码对CNN加深的理解。 首先,dataset是MNIST。这里层的概

这是一份优美的信息图,吴恩达点赞的deeplearning.ai课程总结

吴恩达在推特上展示了一份由 TessFerrandez 完成的深度学习专项课程信息图,这套信息图优美地记录了深度学习课程的知识与亮点。因此它不仅仅适合初学者了解深度学习,还适合机器学习从业者和研究者复习基本概念。机器之心认为这不仅仅是一份课程笔记,同时还是一套信息图与备忘录。下面,我们将从深度学习基础、卷积网络和循环网络三个方面介绍该笔记,并提供信息图下载地址。 信息图下载地址: https:

[deeplearning-008] convertional neural networks卷积神经网络

1.卷积神经网络的主要参考文献 1.1 https://mp.weixin.qq.com/s?__biz=MzI0ODcxODk5OA==&mid=2247486731&idx=1&sn=f91e2361e62b0c73e34385143ad35e6a&scene=21#wechat_redirect 1.2 nature上的cnn描述 LeCun,

[deeplearning-007]深度学习的核心bp算法的原创论文1986nature

bp算法在nature上的论文,1986年的,篇幅不长,公式也简单,一阶偏导和逐层反向求解 更多细节需要自己下来搞定。

[deeplearning-006] tensorflow安装和测试

1. 官网 www.tensorflow.org,需要翻墙。 2.tensorflow的概念抽象 节点:表示数据运算。 边:在节点之间传递多维数据(张量) 3.安装 3.1 文档 https://www.tensorflow.org/install/ 3.2 操作系统需要ubuntu 14.04以上

[deeplearning-005] 一般形式的反向传导算法BP最简推导-3

前述两篇推导还是太繁琐了,有一种更简单的方式。因为排版的问题,直接贴图。 根据上述公式,可以实现一个简单的验证性python代码 #!/usr/bin/env python#!-*- coding:utf-8 -*-#bp alogrithmimport mathimport numpy as np#active functiondef f(x):

[deeplearning-004] 一般形式的反向传导算法BP最简推导-2

3.2 梯度下降 训练神经网络,就是让 J(W,b) J(\mathbf W, \mathbf b)的值最小。解法就是梯度下降,或者随机梯度下降。 梯度下降法的迭代公式是: (Wlj,i)s+1=(Wlj,i)s−η∂J(W,b)∂Wlj,i∣Wlj,i=(Wlj,i)s (\mathbf W^l_{j,i})_{s+1}=(\mathbf W^l_{j,i})_s-\eta

[deeplearning-003] 一般形式的反向传导算法BP最简推导-1

1.神经网络结构 设神经网络的层数是 p p,p≥3p\ge 3。 神经网络有三种层:一个输入层,若干个隐层,一个输出层,分别简称 L1 L^1, L2 L^2,…, Lp L^p。 设每层神经元数量分别是 d1 d^1, d2 d^2,…, dp d^p。每个神经元的应激函数是 f(x) f(x)。 2.分析第一层和第二层并推导全局变量 设一个样本是 x∈Rd1×1 \mathbf x

[deeplearning-002] 单节点神经网络推导

这个例子是最基础的例子,深度学习是它的各种形式的扩展。几个关键点:神经网络结构,激活函数,向量化,随机梯度下降算法,是深度学习的基石。 1.训练集 设训练集合是 {x(i),y(i)}i=1...n \{\mathbf x^{(i)}, y^{(i)}\} i=1...n,其中 x∈R1×d \mathbf x\in R^{1\times d}。 x \mathbf x是个向量,数据集有 n

[deeplearning-001] stotisticks gradient descent随机梯度下降算法的最简单例子解释

1.gradient descent梯度下降优化 1.1假设要优化一个函数 f(x)=(x−1)2 f(x)=(x-1)^2求它的最小值。这个函数在 x=1 x=1 时有最小值,这是解析解。如果用梯度下降法,是这样的: f′(x)=2(x−1) f^{'}(x)=2(x-1) 每一步的迭代公式是: xi+1=xi−ηf′(xi) x_{i+1}=x_{i} - \eta f^{'}(x

[deeplearning]常用概念

1.cross entropy https://blog.csdn.net/rtygbwwwerr/article/details/50778098

[deeplearning-016] dl最佳学习路线

1. BP算法。只需要参考 Hinton在natrure上的论文,1986年。https://www.nature.com/articles/323533a0 把算法手动推导十遍,然后用任意一种语言实现,完整跑出一个例子得到合理的预期的结果。这一步最重要,BP是深度学习的核心。BP算法不要找其他论文了,这个就是最好的。 2. CNN网络。LeNet-5论文《Gradient-Based Le

[deeplearning-015]一文理解rnn

1.参考文档 https://iamtrask.github.io/2015/11/15/anyone-can-code-lstm/ 前提,熟悉bp算法推导,熟悉bptt算法推导 2.py源码 #!/usr/bin/env python3#参考文献 https://iamtrask.github.io/2015/11/15/anyone-can-code-lstm/import copy

[deeplearning-014] 深度学习的模型结构历史

[0] 参考文献 http://www.cnblogs.com/skyfsm/p/8451834.html https://www.cnblogs.com/52machinelearning/p/5821591.html [1]Q:什么是深度学习? A:隐层数量多的神经网络,隐层从5~1000不等。 [2]Q:深度学习的网络模型有哪些种类? A:图像处理的卷积神经网络CNN; 自然语言处理的

[deeplearning-013] 机器学习awesome系列

https://www.cnblogs.com/52machinelearning/articles/5821559.html 这个系列太好了。因此转发出来。 IndexAwesome备注1Awesome Machine Learning机器学习资源大全中文版2Awesome Artificial Intelligence人工智能3Awesome AwesomenessAwesomeAweso

[deeplearning-009]mxnet深度学习框架安装和试用

1. 官网 http://mxnet.incubator.apache.org/ https://github.com/apache/incubator-mxnet 2. tutoria http://mxnet.incubator.apache.org/tutorials/index.html 3. python tutorial 3.1 mxnet有两种接口:Gluon A

deeplearning 发展历程

1.ILSVRC榜单便是Deep Learning视觉发展的里程碑式代表 图1. ILSVRC历年的Top-5错误率 2.AlexNet、VGG、GoogLeNet、ResNet对比 LeNet主要是用于识别10个手写数字的,当然,只要稍加改造也能用在ImageNet数据集上,但效果较差。而本文要介绍的后续模型都是ILSVRC竞赛历年的佼佼者,这里具体比较AlexNet、VGG、Goo

去噪自编码器_DeepLearning 0.1 documentation中文翻译

DeepLearning 0.1 documentation中文翻译: Denoising Autoencoders (DA)_去噪自编码器 原文网址: http://deeplearning.net/tutorial/dA.html DeepLearning 01 documentation中文翻译 Denoising Autoencoders DA_去噪自编码器 自编码器Autoe

深度学习教程_DeepLearning 0.1 documentation中文翻译

DeepLearning 0.1 documentation中文翻译:Deep Learning Tutorials_深度学习教程 原文网址:http://deeplearning.net/tutorial/index.html DeepLearning 01 documentation中文翻译Deep Learning Tutorials_深度学习教程DeepLearning 01 d

【强推|双语】吴恩达机器学习Deeplearning.ai课程链接

【【强推|双语】吴恩达机器学习Deeplearning.ai课程(人工智能|深度学习|监督学习|强化学习|神经网络)】 https://www.bilibili.com/video/BV1cm421T7xL/?p=72&share_source=copy_web&vd_source=8bad2ea690ede82d8c212a7b6ad544af 机器学习专业是 DeepLearning.AI 和

deeplearning.ai 吴恩达网上课程学习(八)——深层神经网络分类代码实战

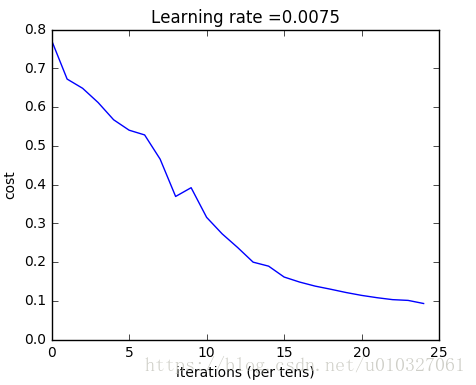

本文将学习如何利用Python的来实现多个隐藏层的图片分类问题:用两层和多层神经网络实现是否是猫图片的分类。 本文的实践平台是Linux,Python3.4,基础库anaconda和spyder, 参考文章的实现平台是jupyter notebook:多层神经网络代码实战 理论知识学习请参看上篇:deeplearning.ai 吴恩达网上课程学习(七)——深层神经网络理论学习 1. 流程概

deeplearning.ai 吴恩达网上课程学习(七)——深层神经网络理论学习

本文主要来对浅层神经网络进行扩展,来了解深层神经网络的基本原理。 本文参考链接:https://www.missshi.cn/api/view/blog/59a6ad67e519f50d040000e6 1.概念初识: Logistic回归: 一个隐藏层的神经网络: 五个隐藏层的神经网络: 深层神经网络主要是指的包含的隐藏层的深度。神经网络的层数越多,可以拟合的场景越复

deeplearning.ai 吴恩达网上课程学习(六)——浅层神经网络分类代码实战

本文将学习如何利用Python的来实现具有一个隐藏层的平面数据分类问题。 本文的实践平台是Linux,Python3.4,基础库anaconda和spyder, 参考文章的实现平台是jupyter notebook:具有一个隐藏层的平面数据分类代码实战 理论知识学习请参看上篇deeplearning.ai 吴恩达网上课程学习(五)——浅层神经网络理论学习 目的:将创建的“花状”数据集分类

deeplearning.ai 吴恩达网上课程学习(四)——Logistic代码实战,基于Linux,Python 3.4

此文章偏向于实践和自己的理解,本文讲述了Python代码的一些基本操作,由浅入深最后实现logistic的代码。(原文中代码实现基于jupyter notebook,文中代码实现基于之前搭建的Linux的Python平台,二者代码会有细小的区别。 搭建平台的链接深度学习(一):搭建TensorFlow) 原创内容来自: https://www.missshi.cn/api/view/blog

deeplearning.ai 吴恩达网上课程学习(三)——Python矢量化实现神经网络

本文主要讲述了矢量化和广播,在Python编程过程中提高了运行速度,中间讲述了Logistic回归中的矢量化表示。 (原文中代码实现基于jupyter notebook,文中代码实现基于之前搭建的Linux的TensorFlow平台,二者代码会有细小的区别,如果使用的是TensorFlow平台可使用本文的代码) 矢量化:在大数据情况下能有效提高运行速度。 example 1:向量*向

![[deeplearning-008] convertional neural networks卷积神经网络](/front/images/it_default2.jpg)

![[deeplearning-005] 一般形式的反向传导算法BP最简推导-3](https://img-blog.csdn.net/20171105151320469?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQvbGl6aGVfZGFzaHVqdQ==/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/Center)

![[deeplearning-003] 一般形式的反向传导算法BP最简推导-1](/front/images/it_default.jpg)