ddpm专题

ddpm和ddim小记

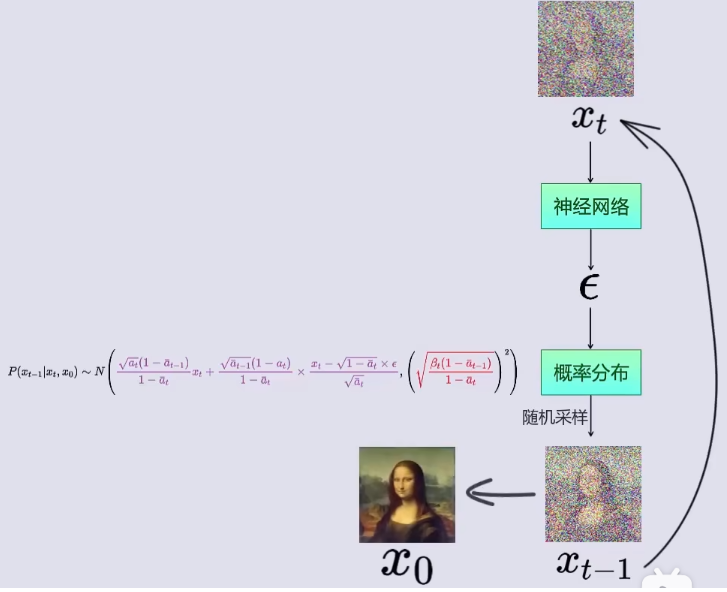

前面分析了DDPM和DDIM,但是仍然感觉对其理解不是和透彻,最近又学习了下,简单记录一下进一步的理解。为了方便理解,这里直接以两个像素的灰度图像为例。前面讲过无论是DDPM还是DDIM,他们的训练过程都是一样的,都遵循下面的这个公式: x t = α t ˉ x 0 + 1 − α t ˉ ϵ x_t = \sqrt{\bar{\alpha_t}}x_0+\sqrt{1-\bar{\alp

结合代码详细讲解DDPM的训练和采样过程

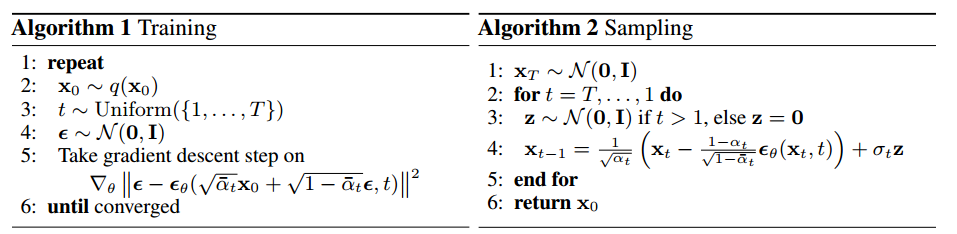

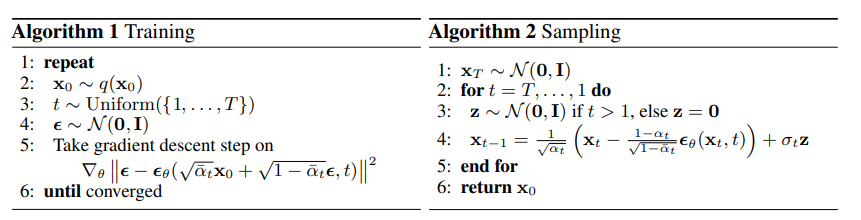

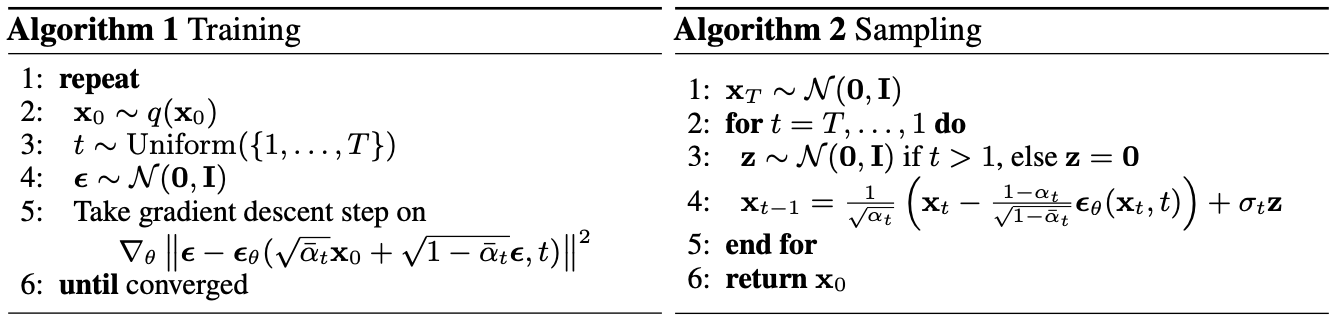

本篇文章结合代码讲解Denoising Diffusion Probabilistic Models(DDPM),首先我们先不关注推导过程,而是结合代码来看一下训练和推理过程是如何实现的,推导过程会在别的文章中讲解;首先我们来看一下论文中的算法描述。DDPM分为扩散过程和反向扩散过程,也就是训练过程和采样过程; 代码来自https://github.com/zoubohao/DenoisingDi

diffusion model(扩散模型)DDPM解析

DDPM 前向阶段 重复 2-5 步骤 x 0 ∼ q ( x 0 ) \mathbf{x}_0\sim q(\mathbf{x}_0) x0∼q(x0)从数据集中采样一张图片 t ∼ U n i f o r m ( { 1 , … , T } ) t\sim\mathrm{Uniform}(\{1,\ldots,T\}) t∼Uniform({1,…,T}),从 1~T 中随机挑选一

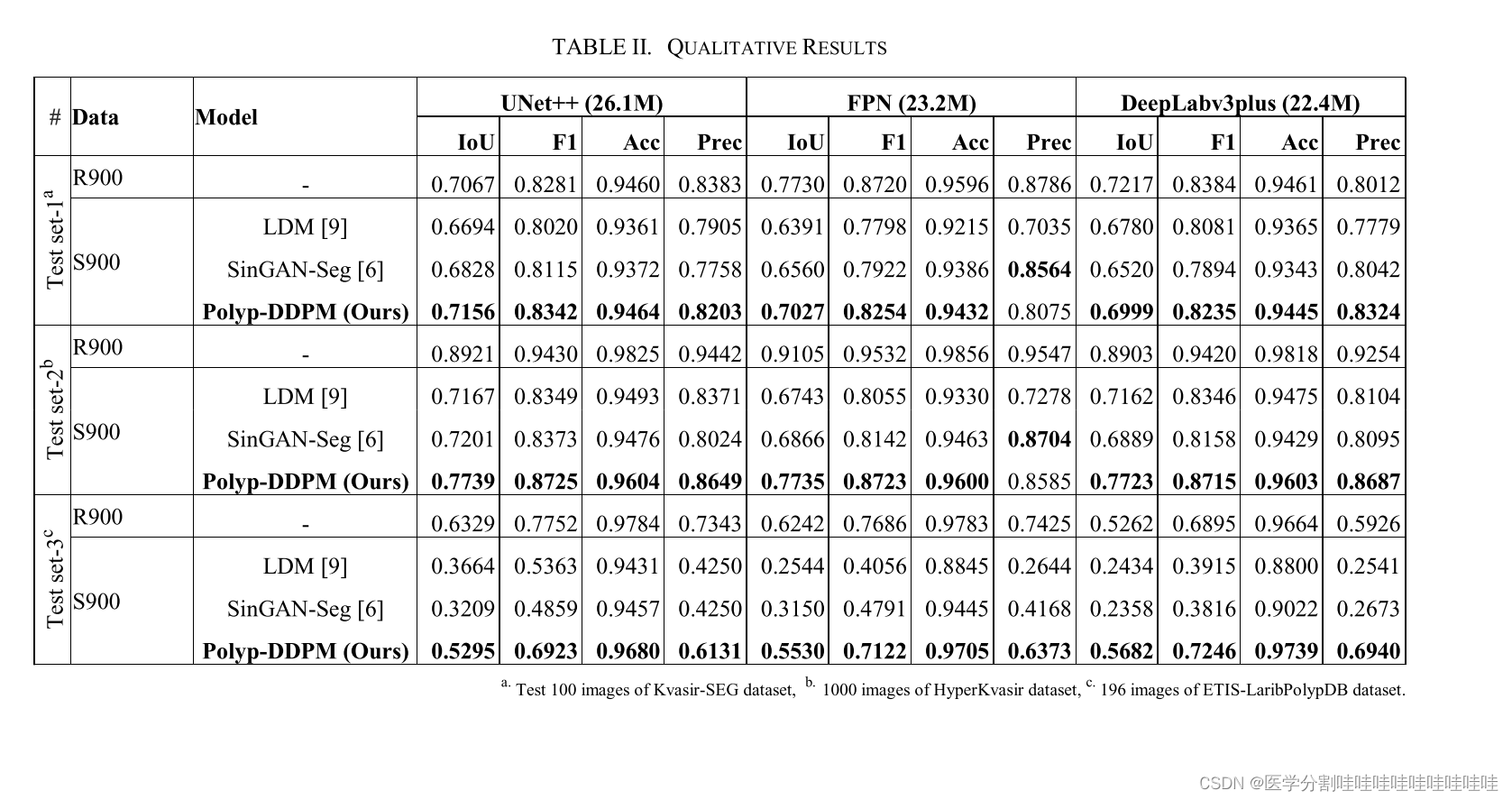

Polyp-DDPM: Diffusion-Based Semantic Polyp Synthesis for Enhanced Segmentation

Polyp- ddpm:基于扩散的语义Polyp合成增强分割 摘要: 本研究介绍了一种基于扩散的方法Polyp-DDPM,该方法用于生成假面条件下息肉的逼真图像,旨在增强胃肠道息肉的分割。我们的方法解决了与医学图像相关的数据限制、高注释成本和隐私问题的挑战。通过对分割掩模(代表异常区域的二进制掩模)的扩散模型进行调节,poly - ddpm在图像质量(实现fr起始距离(FID)得分为78.47

DDPM公式推导(五)

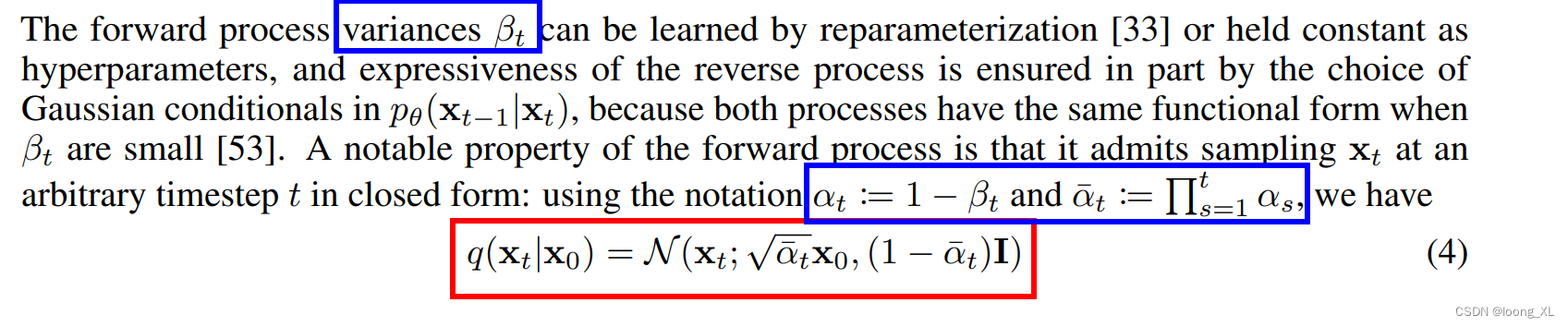

3 Diffusion models and denoising autoencoders 扩散模型可能看起来是一类受限制的潜在变量模型,但它们在实现中允许很大的自由度。必须选择正向过程的方差 β t \beta_t βt以及逆向过程的模型架构和高斯分布参数化。为了指导我们的选择,我们在扩散模型和去噪分数匹配之间建立了一个新的显式连接(第 3.2 节),从而为扩散模型提供了一个简化的加权变分边

DDPM公式推导(四)

3 Diffusion models and denoising autoencoders 扩散模型可能看起来是一类受限制的潜在变量模型,但它们在实现中允许很大的自由度。必须选择正向过程的方差 β t \beta_t βt以及逆向过程的模型架构和高斯分布参数化。为了指导我们的选择,我们在扩散模型和去噪分数匹配之间建立了一个新的显式连接(第 3.2 节),从而为扩散模型提供了一个简化的加权变分边

DDPM公式推导(二)

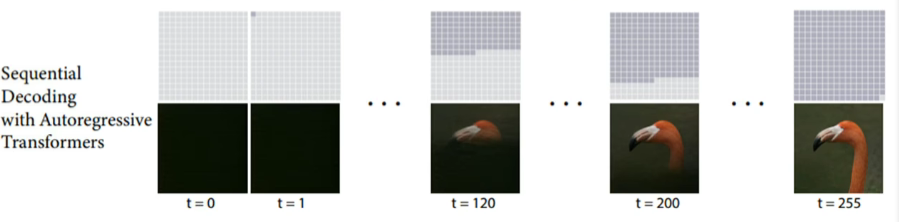

2 Background 扩散模型【53】是一种以 p θ ( x 0 ) : = ∫ p θ ( x 0 : T ) d x 1 : T p_\theta\left(\mathbf{x}_0\right):=\int p_\theta\left(\mathbf{x}_{0: T}\right) d \mathbf{x}_{1: T} pθ(x0):=∫pθ(x0:T)dx1:T 形

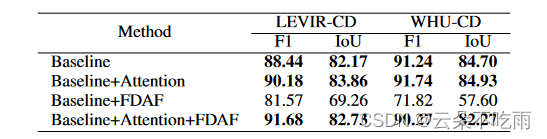

Feature Manipulation for DDPM based Change Detection

基于去噪扩散模型的特征操作变化检测 文章提出了一种基于去噪扩散概率模型(DDPM)的特征操作变化检测方法。变化检测是计算机视觉中的经典任务,涉及分析不同时间捕获的图像对,以识别场景中的重要变化。现有基于扩散模型的方法主要关注提取特征图,而本文的方法专注于操作扩散模型提取的特征图,使其在语义上更有用。文章提出了两种方法:特征注意力(Feature Attention)和流对齐融合(Flow Dua

Pytorch实现扩散模型【DDPM代码解读篇1】

本篇内容属于对DDPM 原理-代码 项目的解读。 具体内容参考一篇推文,里面对DDPM讲解相对细致: 扩散模型的原理及实现(Pytorch) 下面主要是对其中源码的细致注解,帮助有需要的朋友更好理解代码。 目录 ConvNext块 正弦时间戳嵌入 时间多层感知器 注意力 整合 ConvNext块 class ConvNextBlock(nn.Module):def

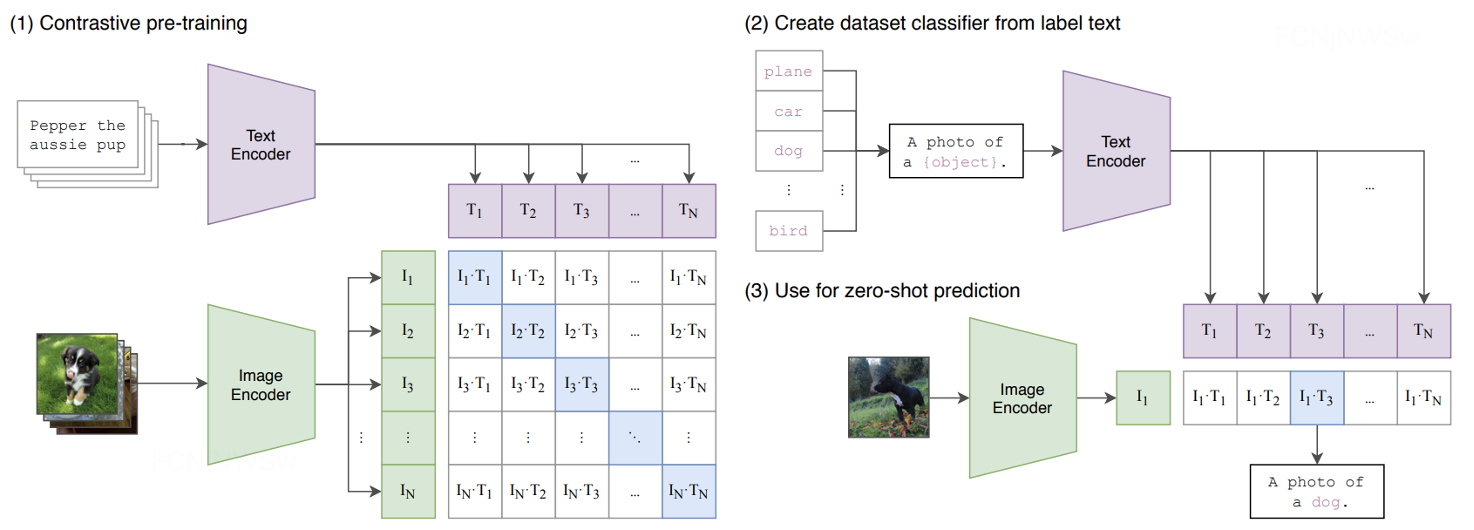

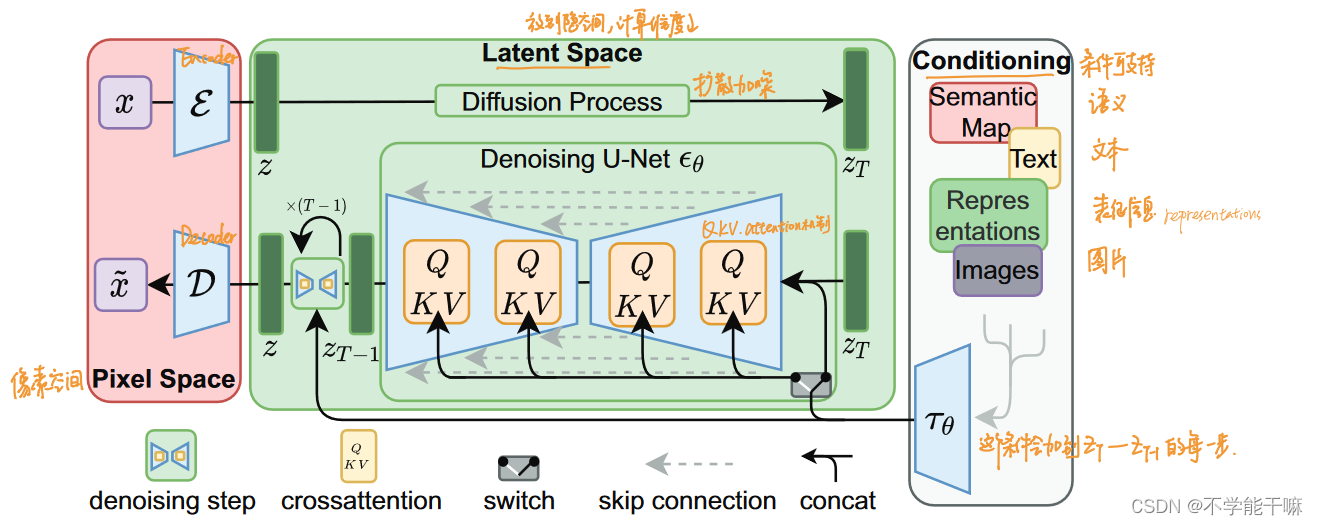

文生图大模型三部曲:DDPM、LDM、SD 详细讲解!

1、引言 跨模态大模型是指能够在不同感官模态(如视觉、语言、音频等)之间进行信息转换的大规模语言模型。当前图文跨模态大模型主要有: 文生图大模型:如 Stable Diffusion系列、DALL-E系列、Imagen等 图文匹配大模型:如CLIP、Chinese CLIP、BridgeTower等 今天主要讨论Stable Diffusion,首先让我们看一下,Stable Di

扩散模型的发展过程梳理 多个扩散模型理论知识总结/DDPM去噪扩散概率/IDDPM/DDIM隐式去噪/ADM/SMLD分数扩散/CGD条件扩散/Stable Diffusion稳定扩散/LM

前言 1.最近发现自己光探索SDWebUI功能搞了快两个月,但是没有理论基础后面科研路有点难走,所以在师兄的建议下,开始看b站视频学习一下扩散模型,好的一看一个不吱声,一周过去了写个博客总结一下吧,理理思路。不保证下面的内容完全正确,只能说是一个菜鸟的思考和理解,有大佬有正确的理解非常欢迎评论告知,不要骂我不要骂我。 2.这里推荐up主,deep_thoughts投稿视频-deep_thoug

【扩散模型】 DDPM和DDIM讲解

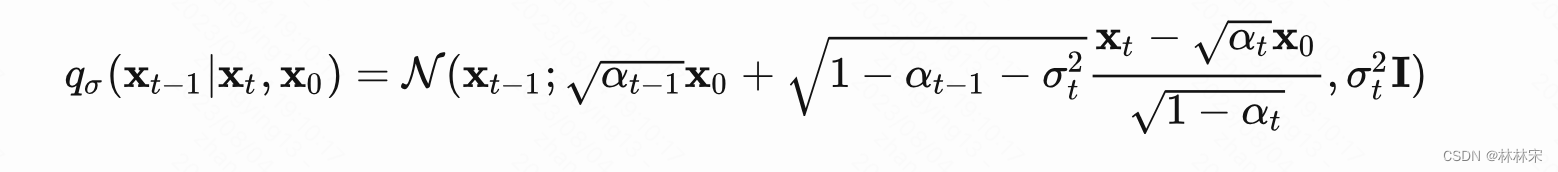

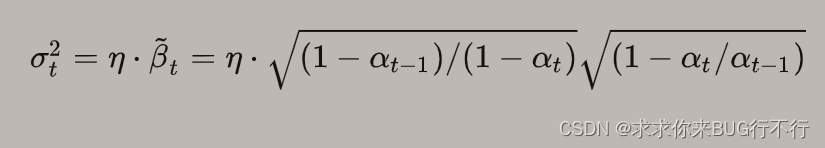

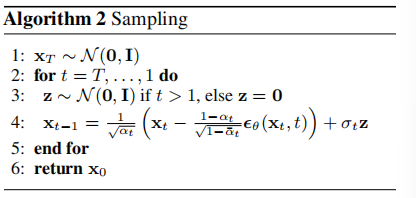

扩散模型DDPM和DDIM 扩散模型之DDPM介绍了经典扩散模型DDPM的原理和实现,那么生成一个样本的次数和训练次数需要一致,导致采样过程很缓慢。这篇文章我们将介绍另外一种扩散模型DDIM(Denoising Diffusion Implicit Models),它两有相同的训练目标,但是它不再限制扩散过程必须是一个马尔卡夫链,这使得DDIM可以采用更小的采样步数来加速生成过程,DDIM的另外

AI绘图之DDIM 与 DDPM

DDPM: 去噪扩散概率模型 (DDPM) 在没有对抗训练的情况下实现了高质量的图像生成,但它们需要模拟马尔可夫链的许多步骤才能生成样本。 为了加速采样,我们提出了去噪扩散隐式模型 (DDIM),这是一类更有效的迭代隐式概率模型,其训练过程与 DDPM 相同。 在 DDPM 中,生成过程被定义为马尔可夫扩散过程的逆过程。 我们构建了一类导致相同训练目标的非马尔可夫扩散过程,但其反向过

DDPM、DDIM区别与联系

它们的前向过程是一样的,只是后向去噪过程不一样。 ddim是ddpm的非马尔可夫变体,允许更快的采样,并可以提供确定性输出。关键思想是,它们改变了逆向过程的计算方式,在不牺牲质量的情况下,允许更少的步骤生成样本。 现在,对于ddimm,这个想法是类似的,但是ddimm不是在许多步骤中去除一点点噪声,而是找到了一种方法,只需几个步骤就可以去除大量噪声。因此,它们可以更快地清除有噪点的照片,因

1. DDPM模型概述

1. DDPM模型概述 扩散模型(DM,Diffusion Model)是一类生成模型,常见的生成模型还有GAN和VAE。扩散模型分为前向阶段和逆向阶段,在前向阶段中逐步向数据中添加噪声,直至数据变成完全的高斯噪声,然后在逆向阶段学习从高斯噪声中还原为原始数据。 图1 扩散模型的前向阶段和逆向阶段. (图片来源:Ho et al. 2020) 前向阶段表示为图1中从右往左的过程。从原

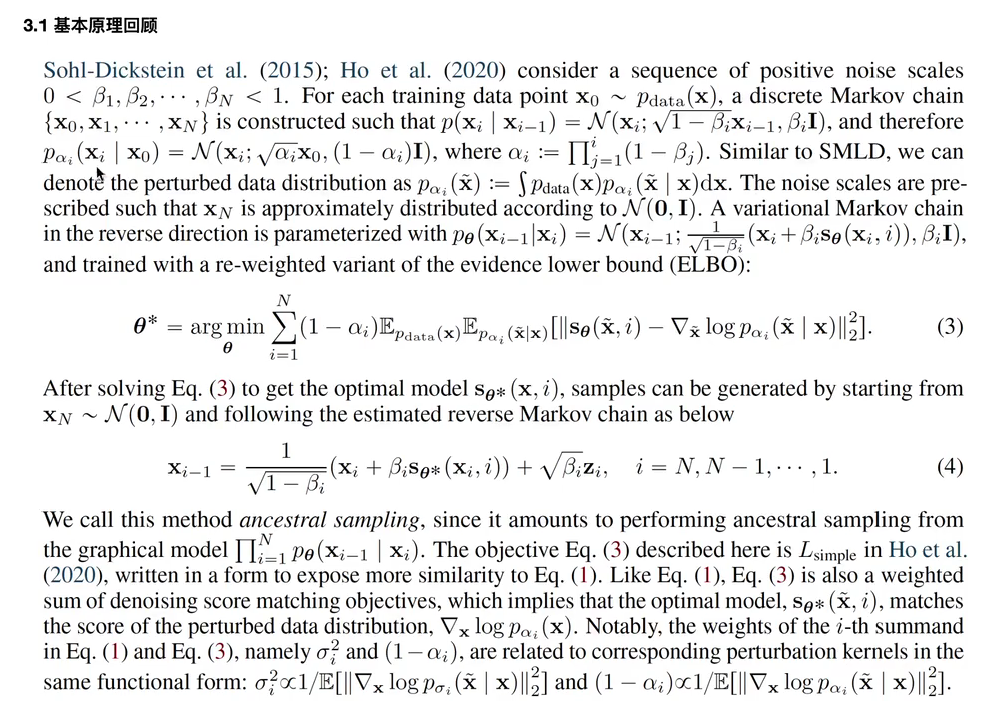

扩散模型原理+DDPM案例代码解析

扩散模型原理+代码解析 一、 数学基础 1.1 一般的条件概率形式 1.2 马尔可夫链条件概率形式 1.3 先验概率和后验概率 1.4 重参数化技巧 1.5 KL散度公式 二、扩散模型的整体逻辑(以DDPM为例) 2.1 Diffusion扩散过程(Forward加噪过程) 2.2 逆向过程(reverse去噪过程) 三、训练过程和采样过程 3.1 训练过程 3.2 采样过程 3.3 模型训练的

图像生成发展起源:从VAE、扩散模型DDPM、DETR到ViT、Swin transformer

前言 2018年我写过一篇博客,叫:《一文读懂目标检测:R-CNN、Fast R-CNN、Faster R-CNN、YOLO、SSD》,该文相当于梳理了2019年之前CV领域的典型视觉模型,比如 2014 R-CNN2015 Fast R-CNN、Faster R-CNN2016 YOLO、SSD2017 Mask R-CNN、YOLOv22018 YOLOv3 随着2019 CenterN

【扩散模型】2、DDPM | 去噪扩散概率模型开山之作

文章目录 数学基础知识一、背景二、DDPM 主要过程2.1 前向扩散过程2.2 逆向去噪过程2.3 训练和推理 论文:Denoising Diffusion Probabilistic Models 代码:https://github.com/hojonathanho/diffusion stable diffusion 代码实现:https://github.com/C

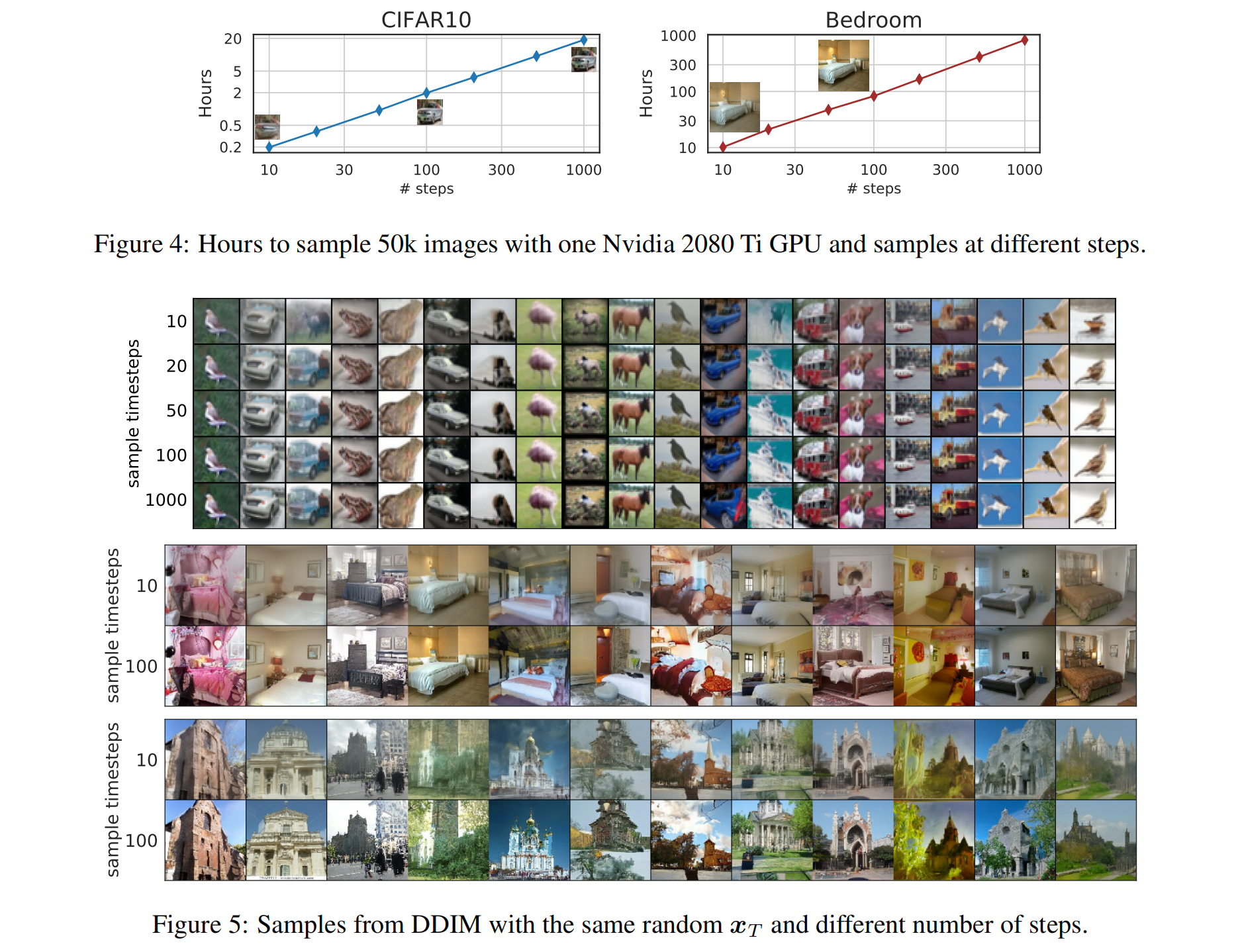

【扩散模型】4、DDIM | 加速 DDPM 的采样速度

文章目录 一、背景二、DDIM 如何改进2.1 DDPM 的原理回顾2.2 DDIM 的非马尔科夫前向扩散过程2.3 非马尔科夫扩散逆过程的采样2.4 加速采样 —— Respacing 三、效果 论文:Denoising Diffusion Implicit Models 代码:https://github.com/CompVis/stable-diffusion/blo

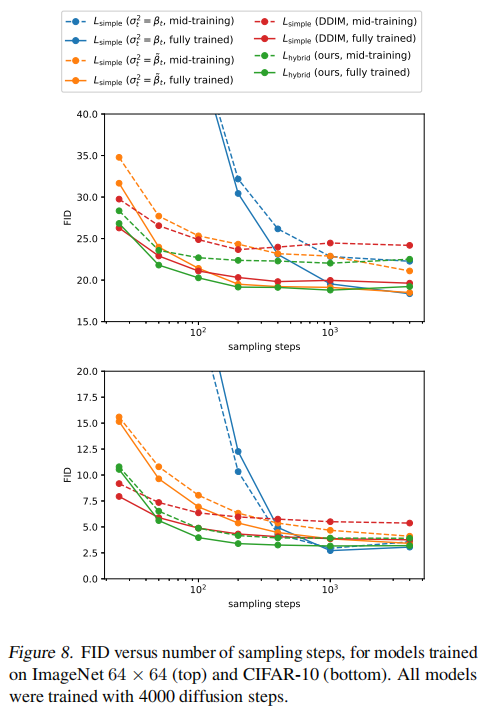

【扩散模型】5、Improved DDPM | 引入可学习方差和余弦加噪机制来提升 DDPM

文章目录 一、背景二、Improved DDPM——提升 Log-likelihood2.1 可学习的方差2.2 改进 noise schedule2.3 降低梯度噪声 三、效果 论文:Improved Denoising Diffusion Probabilistic Models 代码:https://link.zhihu.com/?target=https%3A//gi

生成模型之扩散模型DDPM

扩散模型(Diffusion Model) 当前主要有四大生成模型:生成对抗模型、变分自动编码器、流模型以及扩散模型。 扩散模型(diffusion models)是当前深度生成模型中新SOTA。扩散模型在图片生成任务中超越了原SOTA:GAN,并且在诸多应用领域都有出色的表现,如计算机视觉,NLP、波形信号处理、多模态建模、分子图建模、时间序列建模、对抗性净化等。此外,扩散模型与其他研究领域有

简单基础入门理解Denoising Diffusion Probabilistic Model,DDPM扩散模型

阅前须知:文中存在少许已证实/尚未证实的描述错误,建议结合评论区分析共同理解。 I. 作者的话 最近非常不巧的要研究什么diffusion…然而目前网上能找到的资料完全是设计给非常熟练数学的人看的(哪怕对于许多所谓的"入门教程",基本就是纯数学劝退教程),对于我这种高数概率论约等于挂科的人来说根本没法看。因此希望写一篇尽量通俗易懂,在尽量避免「概率论」的情况下,能把diffusion讲明白

Diffusion扩散模型学习2:DDPM前向加噪过程torch实现

参考: https://arxiv.org/pdf/2006.11239.pdf ##论文 https://github.com/dtransposed/code_videos/blob/main/01_Diffusion_Models_Tutorial/Diffusion%20Model.ipynb ##code https://spaces.ac.cn/archives/9119 1、红色