crossentropy专题

关于sigmoid与binary_crossentropy,以及softmax与categorical_crossentropy的关系,以及各损失函数的定义。

1,用sigmoid作为激活函数,为什么往往损失函数选用binary_crossentropy 参考地址:https://blog.csdn.net/wtq1993/article/details/51741471 2,softmax与categorical_crossentropy的关系,以及sigmoid与bianry_crossentropy的关系。 参考地址:https://www.

[机器学习] Pytorch19种损失函数理解[上]— L1、MSE、CrossEntropy、KL、BCE、BCEWithLogits loss function

损失函数通过torch.nn包实现。 文章目录 1 基本用法2 损失函数(前6种)2-1 L1范数损失 —— L1_Loss2-2 均方误差损失 —— MSELoss2-3 交叉熵损失 CrossEntropyLoss2-4 KL 散度损失 KLDivLoss2-5 二元交叉熵损失 BCELoss2-6 BCEWithLogitsLoss 1 基本用法 criterion =

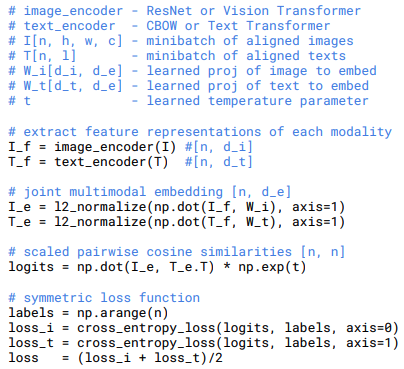

CLIP算法的Loss详解 和 交叉熵CrossEntropy实现

CLIP:Contrastive Language–Image Pre-training(可对比语言-图像预训练算法)是OpenAI提出的多模态预训练的算法,在各种各样的**样本对(图像、文本)**上训练的神经网络。 具体参考:CLIP、OpenCLIP 其中,流程: loss_i和loss_t的具体源码如下,参考 model.py: def forward(self, i

KL散度、CrossEntropy详解

文章目录 0. 概述1. 信息量1.1 定义1.2 性质1.3 例子 2. 熵 Entropy2.1 定义2.2 公式2.3 例子 3. 交叉熵 Cross Entropy3.1 定义3.2 公式3.3 例子 4. KL 散度(相对熵)4.1 公式

![[机器学习] Pytorch19种损失函数理解[上]— L1、MSE、CrossEntropy、KL、BCE、BCEWithLogits loss function](/front/images/it_default.gif)