cogvlm2专题

极速体验媲美GPT4V的国产开源视觉大模型CogVLM2(赠书)

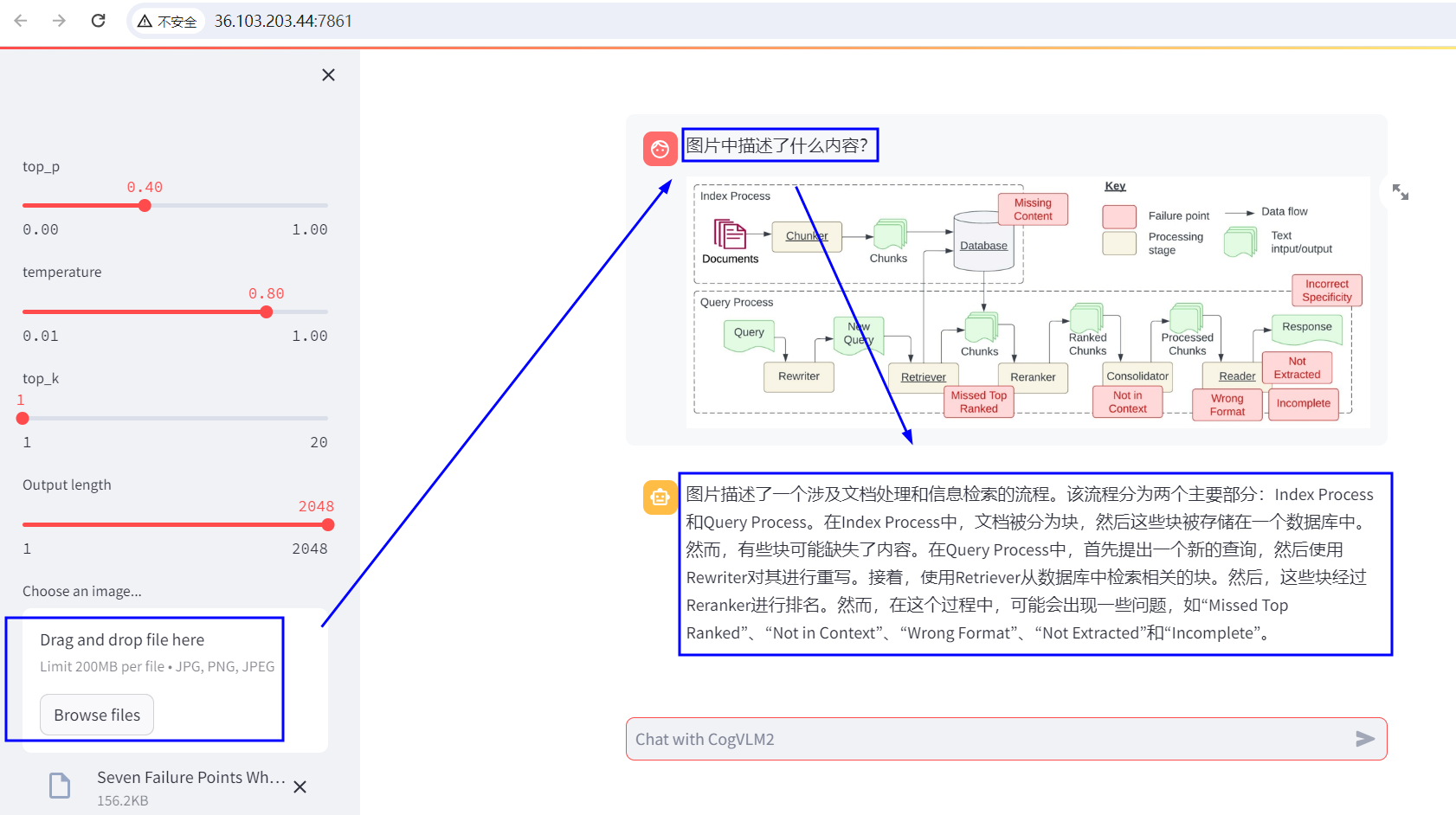

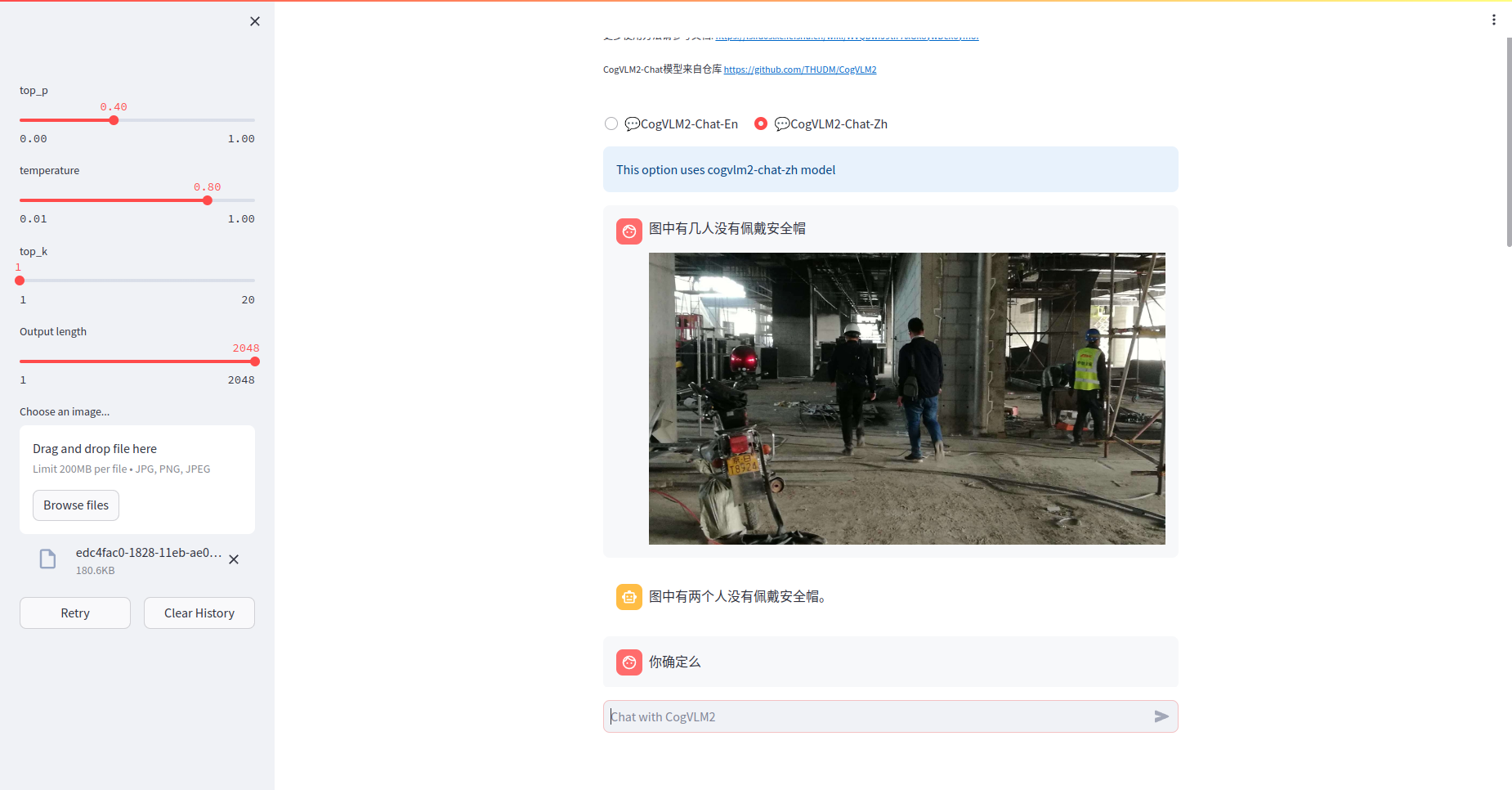

大家好,我是每天分享AI应用的萤火君! 文末赠书 CogVLM2是一款视觉语言模型(Visual Language Model),由智谱AI和清华KEG潜心打磨。这款模型是CogVLM的升级版本,支持高达 1344 * 1344 的图像分辨率,提供支持 中英文双语 的开源模型版本。 这类模型可以做很多跨领域的活儿,比如给图片配上描述文字、回答关于图片的问题(这叫VQA,就是视觉问答)、或者根

CogVLM2多模态开源大模型部署与使用

CogVLM2多模态开源大模型部署与使用 项目简介 CogVLM2 是由清华大学团队发布的新一代开源模型系列。2024年5月24日,发布了Int4版本模型,只需16GB显存即可进行推理。2024年5月20日,发布了基于llama3-8b的CogVLM2,性能与GPT-4V相当或更优。 模型特点 显著提升关键指标,如TextVQA, DocVQA。支持8K文本长度和1344*1344图像分辨

MLM之CogVLM2:CogVLM2(基于Llama-3-8B-Instruct 模型进行微调)的简介、安装和使用方法、案例应用之详细攻略

MLM之CogVLM2:CogVLM2(基于Llama-3-8B-Instruct 模型进行微调)的简介、安装和使用方法、案例应用之详细攻略 目录 CogVLM2的简介 1、更新日志 2、CogVLM2 系列开源模型的详细信息 3、Benchmark 4、项目结构 5、模型协议 CogVLM2的安装和使用方法 1、模型微调 注意 最低配置 开始微调 下载数据集和安

CogVLM2 本地部署体验(Docker容器版)

智普AI推出新一代的 CogVLM2 系列模型,并开源了两款基于 Meta-Llama-3-8B-Instruct开源模型。与上一代的 CogVLM 开源模型相比,CogVLM2 系列开源模型具有以下改进: 在许多关键指标上有了显著提升,例如 TextVQA, DocVQA。支持 8K 文本长度。支持高达 1344 * 1344 的图像分辨率。提供支持中英文双语的开源模型版本。 硬件要求(模

下一代视觉语言模型对比:CogVLM2、InternVL与多模态应用

本文全面对比了最新的开源视觉语言模型(VLM)CogVLM2与InternVL-1.5,探讨了它们在性能、功能和应用场景上的异同。CogVLM2基于Meta-Llama-3-8B-Instruct,表现出强大的多模态理解能力,支持长文本和高分辨率图像,且提供中英文双语模型。InternVL-1.5则通过改进视觉编码器、动态高分辨率策略和高质量双语数据集,缩小了与商业模型的差距。本文详细介绍了两款