broadcasting专题

Pytorch:Tensor数组运算中的Broadcasting【广播机制】

简单来说,Broadcasting 可以这样理解:如果你有一个 m × n m×n m×n 的矩阵,让它加减乘除一个 1 × n 1×n 1×n 的矩阵,它会被复制 m m m 次,成为一个 m × n m×n m×n 的矩阵,然后再逐元素地进行加减乘除操作。 数组在进行矢量化运算时,要求数组的形状是相等的。当形状不相等的数组执行算术运算的时候,就会出现广播机制,该机制会对数组进行扩

10,09_维度变换,view、reshape,unsqueeze,Squeeze,expand,repeat,矩阵转置,transpose维度交换,permute,Broadcasting

1.9.Tensor维度变换 1.9.1.view、reshape 1.9.2.unsqueeze 1.9.3.Squeeze 1.9.4.expand 1.9.5.repeat 1.9.6.矩阵转置 1.9.7.transpose维度交换 1.9.8.permute 1.10.Broadcasting 1.9.Tensor维度变换 1.9.1.view、reshape 1.两者功能一样:将

Digital Signage Broadcasting: Content Management and Distribution Techniques

版权声明:原创作品,允许转载,转载时请务必以超链接形式标明文章原始出版、作者信息和本声明。否则将追究法律责任。 http://blog.csdn.net/topmvp - topmvp Digital Signage Broadcasting is a perfect introduction to this new world of opportunities for media pro

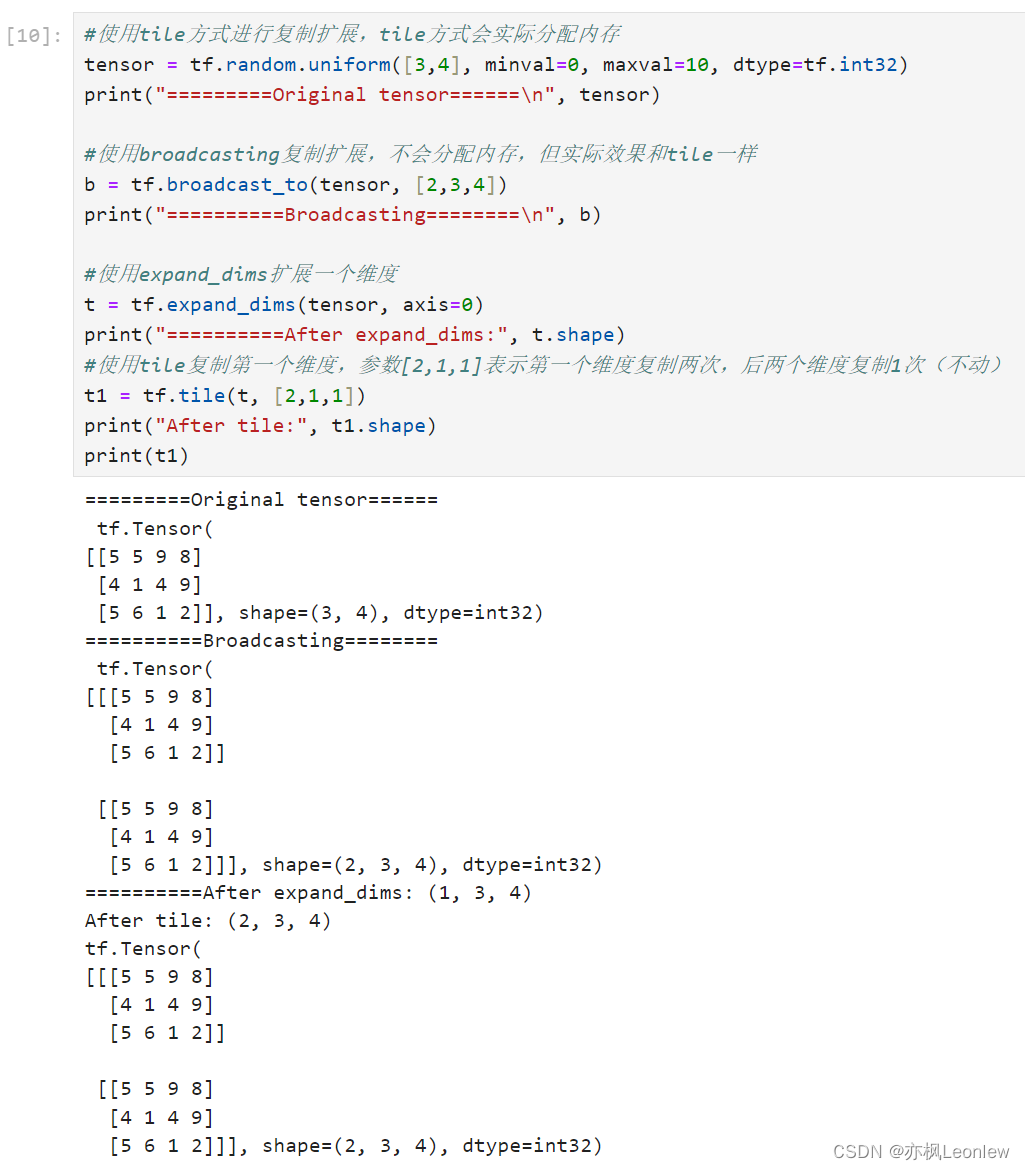

Tensorflow2.0笔记 - Broadcasting和Tile

关于broadcasting的介绍,参考这篇文章。 https://blog.csdn.net/python_LC_nohtyp/article/details/104097417 import tensorflow as tfimport numpy as nptf.__version__#关于broadcasting的介绍,参考这篇文章#https://

TensorFlow的广播机制(Broadcasting)

Broadcasting 也叫广播机制(自动扩展也许更合适),它是一种轻量级张量复制的手段,在逻辑上扩展张量数据的形状,但是只要在需要时才会执行实际存储复制操作。 Broadcasting 和 tf.tile 复制的最终效果是一样的,操作对用户透明,但是 Broadcasting 机制节省了大量计算资源。 import tensorflow as tfx = tf.random.normal

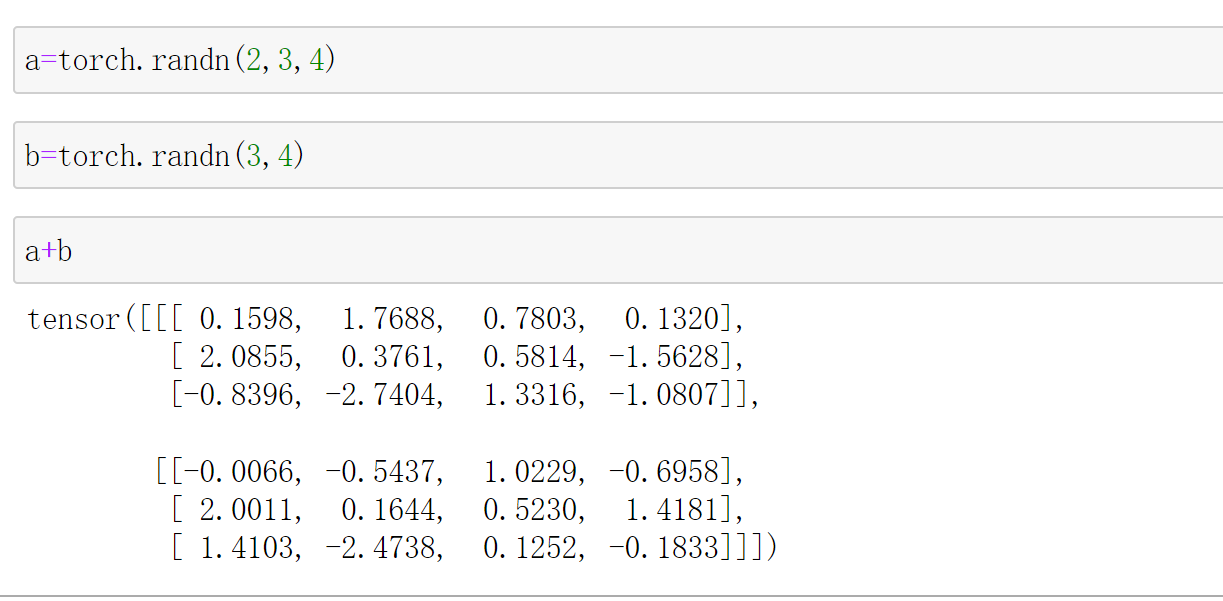

PyTorch BROADCASTING SEMANTICS

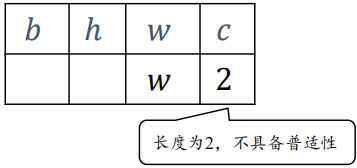

PyTorch BROADCASTING SEMANTICS 官网资料:https://pytorch.org/docs/stable/notes/broadcasting.html Broadcasting 是指不同大小的两个 array 应该怎样处理的操作。通常情况下,小一点的数组会被 broadcast 到大一点的,这样才能保持大小一致。 两个 Tensors 只有在下列情况下才能进行

python中pytorch的广播机制——Broadcasting

广播机制 numpy 在算术运算期间采用“广播”来处理具有不同形状的 array ,即将较小的阵列在较大的阵列上“广播”,以便它们具有兼容的形状。Broadcasting是一种没有copy数据的expand 不过两个维度不相同,在前面插入维度1扩张维度1到相同的维度 例如:Feature maps:[4,32,14,14] Bias:[32,1,1]=>[1,32,1,1]=>[4,3