axial专题

fzu 2035 Axial symmetry(枚举+几何)

题目链接:fzu 2035 Axial symmetry 题目大意:给出n个点,表示n边形的n个顶点,判断该n边形是否为轴对称图形。(给出点按照图形的顺时针或逆时针给出。 解题思路:将相邻两个点的中点有序的加入点集,即保证点是按照图形的顺时针或逆时针出现的,然后枚举i和i + n两点的直线作为对称轴。判断其他所有点是否对称即可。 #include <stdio.h>#

论文精读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation

论文地址:https://arxiv.org/abs/2003.07853 Abstract 卷积利用局部性来提高效率,但代价是缺少长期上下文。自我注意已经被用来通过非局部的交互作用来增强cnn。最近的研究证明,通过将注意力限制在一个局部区域,可以通过叠加自注意层来获得一个完全的注意网络。本文试图通过将二维自注意分解为两个一维自注意来消除这一约束。这降低了计算的复杂度,并允许

Axial-DeepLab: Stand-Alone Axial-Attention for Panoptic Segmentation

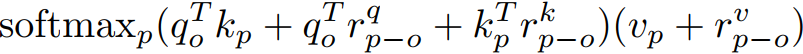

Axis-DeepLab:用于全景分割的独立轴注意 Abstract 卷积利用局部性来提高效率,但代价是丢失长范围上下文。自我注意被用来通过非局部的相互作用来增强CNN。最近的研究证明,通过将注意力限制在局部区域来堆叠自我注意层来获得完全注意网络是可能的。在本文中,我们试图通过将二维自我注意分解为两个一维自我注意来消除这一限制。这降低了计算复杂度,并允许在更大甚至全局区域内进行注意。同时,我们

论文解读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation

论文是一个分割任务,但这里的方法不局限于分割,运用到检测、分类都可以。 论文下载 https://www.yuque.com/yuqueyonghupjh9oc/ovceh4/onilw42ux6e9n1ne?singleDoc# 《轴注意力机制》 一个问题 为什么transformer一开始都有CNN:降低H、W,降低self-attention计算规模O(特征点的个数^2,即(H*W)