autoregressive专题

Glancing Transformer for Non-Autoregressive Neural Machine Translation翻译

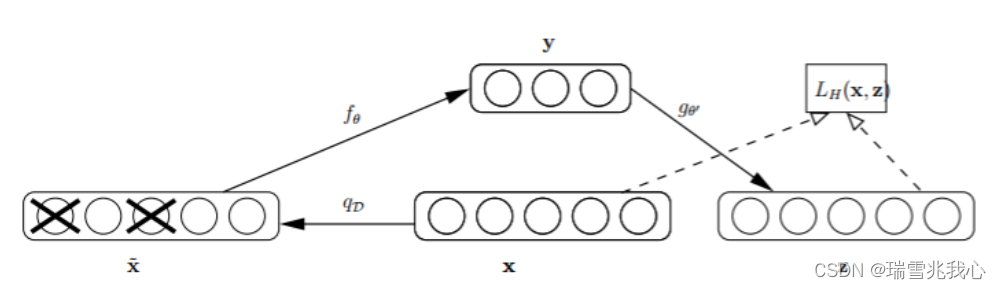

公众号 系统之神与我同在 图1:机器翻译方法的概率模型。(b)普通的神经机器翻译(NAT)采用条件输入凹痕LM。©掩蔽-预测神经网络翻译(NAT)使用掩蔽LM(MLM)和RE需要多次解码。(d)我们提出的Glancing语言模型(GLM)利用解码器的预测来决定Glancing在训练期间进行采样策略,并且在推理期间只需要一次解码。 摘要 最近关于非自回归神经网络翻译(NAT)的研究旨在,

十五、自回归(AutoRegressive)和自编码(AutoEncoding)语言模型

参考自回归语言模型(AR)和自编码语言模型(AE) 1 自回归语言模型( AR) 自回归语言模型(AR)就是根据上文内容(或下文内容)预测下一个(或前一个)可能跟随的单词,就是常说的自左向右(或自右向左)的语言模型任务,即通过前 t - 1(或后 t - 1 ) 个 tokens 来预测当前时刻 t 的 token,代表的自回归语言模型有 ELMO 和 GPT。 1.1 优点 在处

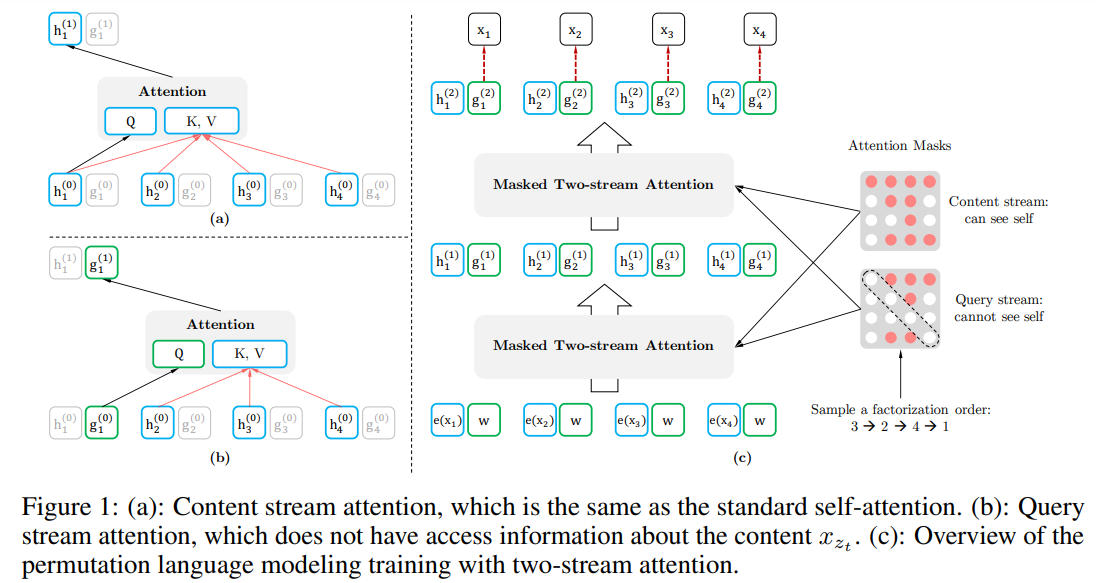

第11章: 挑战BERT地位的Autoregressive语言模型XLNet剖析及源码完整实现

1,作为Autoregressive语言模型的XLNet何以能够在发布时在20个语言任务上都能够正面挑战作为Autoencoding与训练领域霸主地位的BERT? 2,XLNet背后Permutation LM及Two-stream self-attention数学原理解析 3,Autoregressive LM和Autoencoding LM数学原理及架构对比 4,Denoising au

XLNet: 通用自回归预训练语言理解(Generalized Autoregressive Pretraining for Language Understanding)

文章目录 引言提出的方法背景目标:排列语言模型结构:基于目标感知的双流注意力融合Transformer-XL多句建模讨论 Reference: 1. XLNet: Generalized Autoregressive Pretraining for Language Understanding 2. XLNet原理解读 引言 AR模型以前向或后向的单向方式建模语言模型

机器学习-时间序列自回归移动平均模型-翻译(Autoregressive moving average model,ARMA)

目录 0.前言 1.自回归模型(Autoregressive model,简称AR) 2.移动平均模型(Moving Average model,简称MA) 3.自回归滑动平均模型(Autoregressive moving average model,简称ARMA) 4.Note about the error terms 注意误差术语 5.Specification in term

NARX (Nonlinear autoregressive with external input) neural network学习

先看Wikipedia中的简要介绍:Nonlinear autoregressive exogenous model In time series modeling, a nonlinear autoregressive exogenous model (NARX) is a nonlinear autoregressive model which has exogenous inputs. T

DeepAR:Probabilistic forecasting with autoregressive recurrent network

DeepAR:Probabilistic forecasting with autoregressive recurrent network 一般的时间序列预测方法是做点预测,即预测未来某个时间点的具体值。但对于一些具体业务比如预测销量来说预测一个概率区间更加易于决策。DeepAR是一个做概率预测的方法,同时也可以做点预测。 首先简单介绍一下时间序列和常见的处理方法 一、方法介绍 Deep

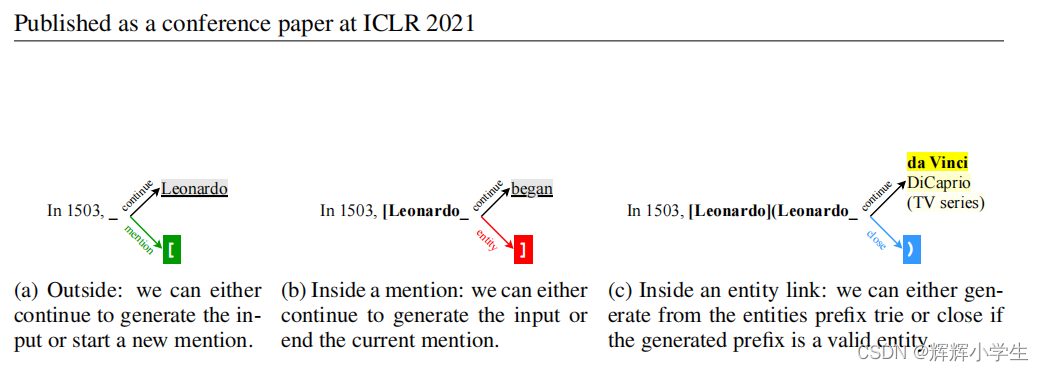

Paper小计:AUTOREGRESSIVE ENTITY RETRIEVAL

1.A BSTRACT : 实体是我们如何表示和聚合知识的中心。(entity很重要。) 检索给定查询的这些实体的能力是知识密集型任务的基础,如实体链接和开放领域的问题回答。(检索给定查询的实体的能力很重要,以及其实际运用。) 该方法导致三个缺点: 1.上下文和实体亲和性主要通过 向量点积捕获,可能 缺少两者之间的 细粒度交互。 2.在考虑 大型实体集时