本文主要是介绍基于 vLLM 搭建 DeepSeek-V2 Chat 服务,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

直奔主题。

安装vLLM

官方实现的代码还没有 merge 到 vLLM 主分支,所以直接 git clone DeepSeek 的分支。

git clone https://github.com/zwd003/vllm.git

cd vllm

pip install -e .

源码安装大概耗时 10 分钟。

OpenAI 接口规范启动

官方 Github 放的是单条推理代码,如果需要启动 api 服务,直接用 OpenAI 接口规范启动即可:

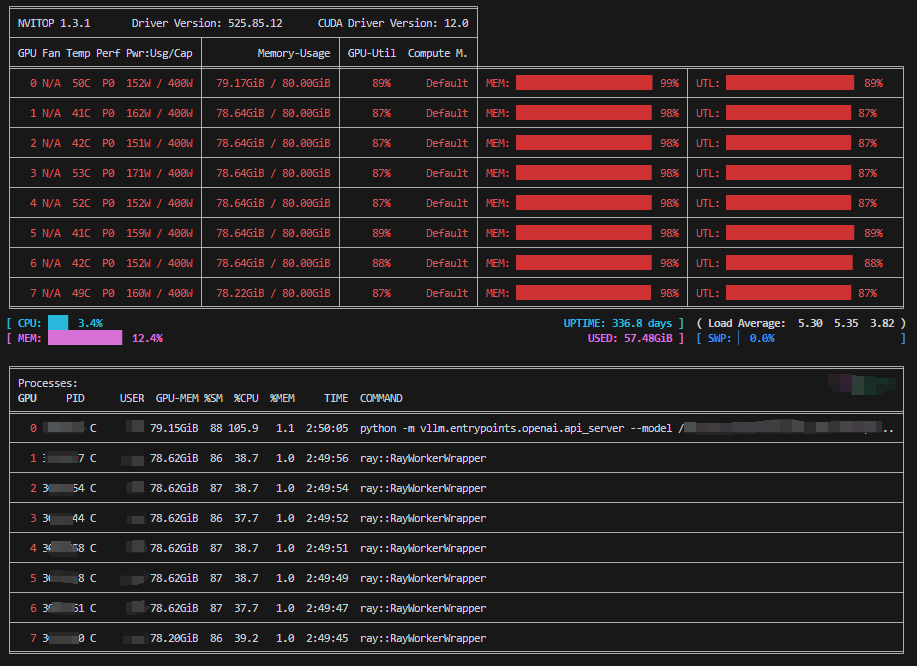

CUDA_VISIBLE_DEVICES=0,1,2,3,4,5,6,7 python -m vllm.entrypoints.openai.api_server --model {YOUR_PATH}/deepseek-ai/DeepSeek-V2-Chat --port 10000 --tensor-parallel-size 8 --gpu-memory-utilization 0.9 --max-model-len 8192 --trust-remote-code

首次启动大概耗时10分钟(8卡80G A100),后续启动差不多1分钟以内。

注:如果跑崩了出现OOM,启动时添加参数 --enforce-eager 即可解决。

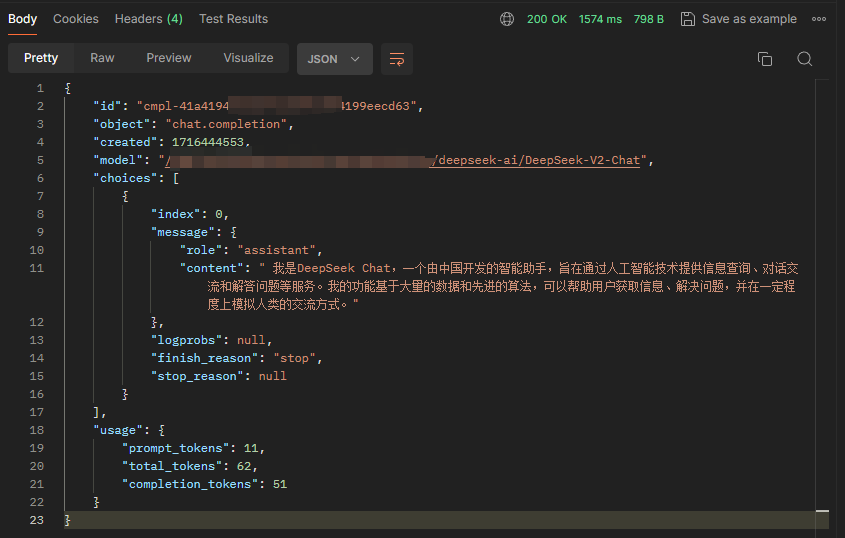

接口测试

{"model": "{YOUR_PATH}/deepseek-ai/DeepSeek-V2-Chat","messages": [{"role": "user", "content": "你是谁"}],"temperature": 0.3,"stream": false

}

参考链接:

https://github.com/deepseek-ai/DeepSeek-V2

这篇关于基于 vLLM 搭建 DeepSeek-V2 Chat 服务的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!