本文主要是介绍Big Bird: Transformers for Longer Sequences论文详解,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- Big Bird大鸟模型

- 论文要解决问题

- 解决方法

- 随机注意力

- 固定窗口注意力

- 全局注意力

- 复杂度分析

- 实验

- 三种注意力的消融实验。

- 语言模型对比roberta、longformer

- QA问题中对比longformer

- 长文本分类任务

- 文章摘要任务

- 基因语言模型实验

- 如有问题欢迎指出,参考论文https://arxiv.org/abs/2007.14062

Big Bird大鸟模型

论文要解决问题

- 如下图,Transformer模型中,注意力中Q、K点乘的内存、速度是序列长度的平方复杂度。长文本时,这个复杂度是不可接受的。一般做法是切成512的块,这种做法损失了块与块之间的信息,例如QA问题中Q必须看到所有A才行,文章摘要中必须看到全部文章。论文提出了一个O(n)复杂度的算法,能够解决以上问题,同时该论文还证明这种方法是图灵完备的。

解决方法

- 论文提出固定窗口、全局注意力、随机注意力。除了随机注意力外,这些方法几乎和longformer一样。longformer可以参考我的另外一篇文章longformer论文解析。和longformer相比,该文做了大量实验,且证明是图灵完备的。

- 如下图,横坐标是Q,纵坐标是K,QK的数量都是序列长度,所以是正方形。图中有色面积代表Q*K的数量。图a是随机注意,图b是固定窗口,c是全局注意力,d是三种汇总。

- 三种注意力都使用稀疏矩阵实现。

随机注意力

- 对于每个Q,都等概率随机关注r个Key,就像图中A所示。实验中r在200左右。

固定窗口注意力

- 对于每个Q,都关注相邻的左边w/2个Key,右边w/2个key。这个主要是大多数nlp任务中,都可以发现,相邻文本影响比较大。实验中w在252左右。

全局注意力

- 有部分特殊的Q关注全部的Key,论文中分两种。一种是BigBird-itc, 也就是在现有的token中选一部分Q关注全部的K。 一种是BigBird-etc,增加token,关注全部的token。全局注意力的数量在256左右。

复杂度分析

- 三种注意力复杂度大概就是(200 + 252 + 256 )* n的复杂度。我们可以看出,虽然是线性复杂度,但是系数非常大。而且稀疏矩阵的乘法远远低于高度优化的原始attention的dense矩阵乘法。但是太长文本,dense矩阵无法存储也无法计算,也是硬伤。

实验

- 文章中做了大量的长序列实验,甚至基因序列实验,证明的改方法的有效性。

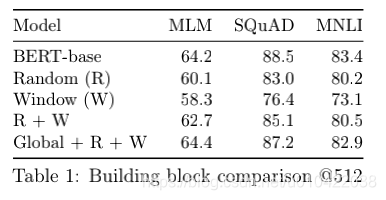

三种注意力的消融实验。

- 用512长度的bert-base对比,三种注意力结合使用,基本接近bert-base效果。

语言模型对比roberta、longformer

- 长文本(4096)的语言模型中,优于roberta,itc低于longformer,etc高于longformer。

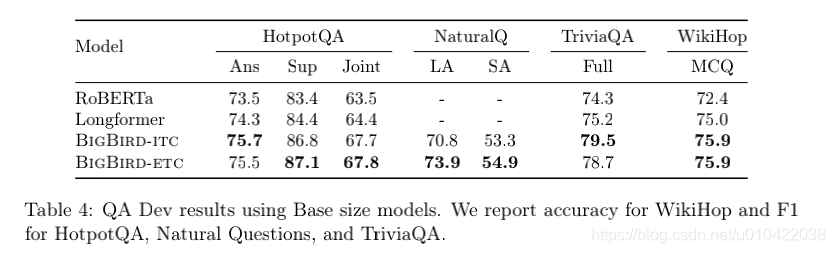

QA问题中对比longformer

- QA问题是一个长文本分析的任务,每个Q都看到所以的A才能回答比较好。big bird-itc、etc都接近longformer。

长文本分类任务

- 在长文本分类任务中,Bigbird比robert提高5个点。

文章摘要任务

- 文章摘要是一个明显的长文本任务,摘要肯定不能只靠前512个token在生成。可以看到big-brid base large模型都明显提升。

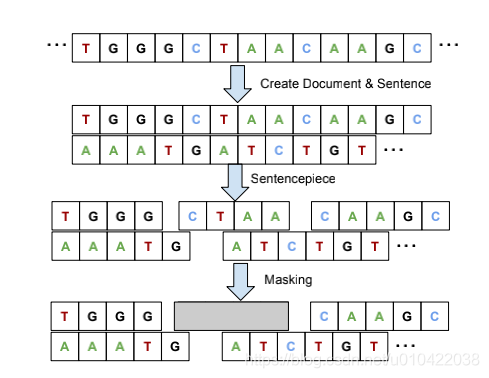

基因语言模型实验

- 基因是明显非常长的片段,是一个非常好的长序列的任务。基因片段也是类似bert的方法,先用sentense piece方法切分成词,然后随机遮住片段(10% 的概率),训练模型预测遮住的片段,使用mlm模型。

- 实验结果展示,好于bert的效果。

如有问题欢迎指出,参考论文https://arxiv.org/abs/2007.14062

这篇关于Big Bird: Transformers for Longer Sequences论文详解的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!