本文主要是介绍Amazon Bedrock 托管 Llama 3 8B70B,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Amazon Bedrock 托管 Llama 3 8B&70B,先来体验:(*实验环境账号有效期为1天,到期自动关停,请注意重要数据保护)

https://dev.amazoncloud.cn/experience/cloudlab?id=65fd86c7ca2a0d291be26068&visitfrom=cloudblogger&sc_medium=owned&sc_campaign=cloudlab&sc_channel=cloudblogger

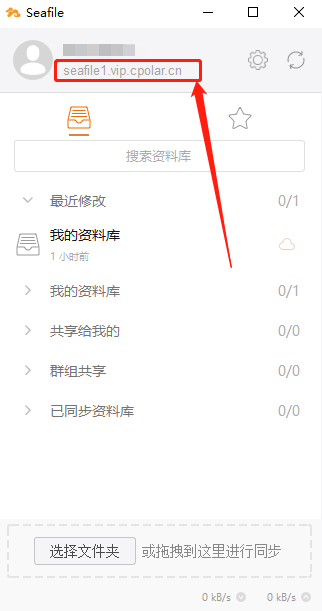

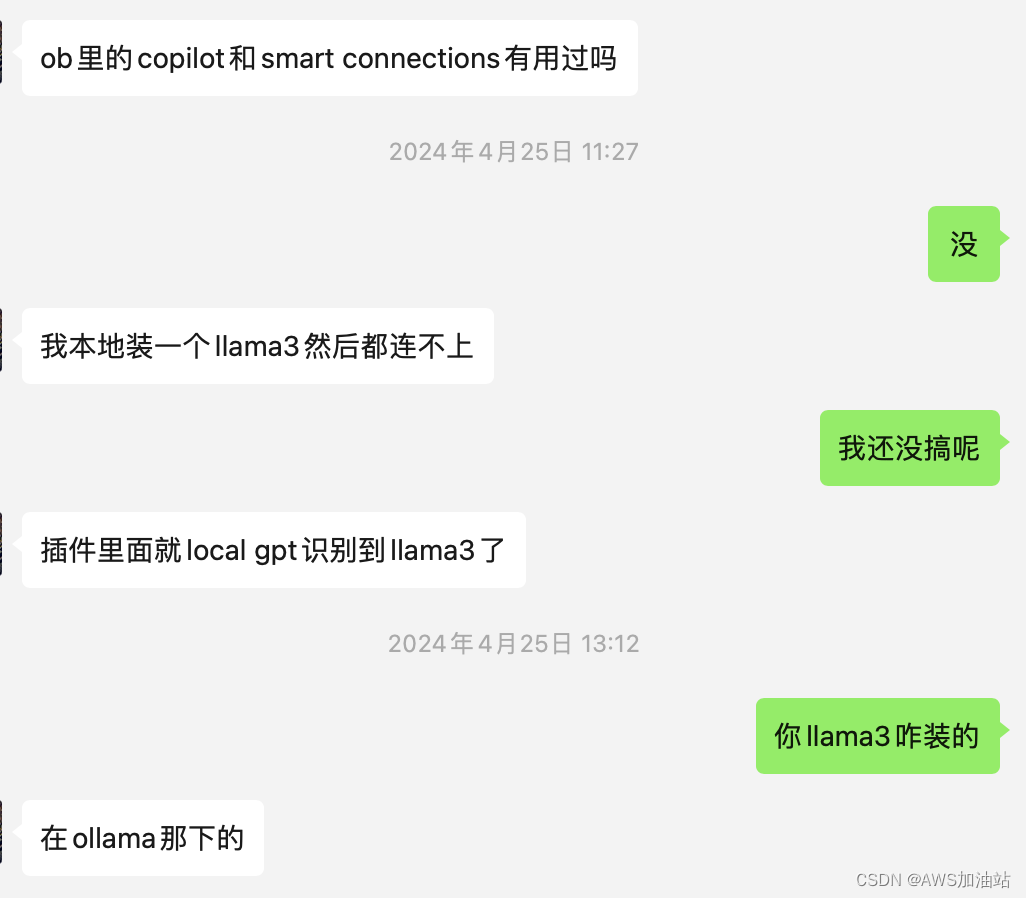

自从Meta开源了Llama之后,现在网上几乎都是超越GPT的言论,除了各种托管平台以及开源自建之外,还有朋友在Obsidian里用上了这个:

本想着在Linux上部署一套的,后来发现Bedrock托管了这个大模型,这样我们就可以用极低的成本来运行这个了。

Github链接:

https://github.com/meta-llama/llama

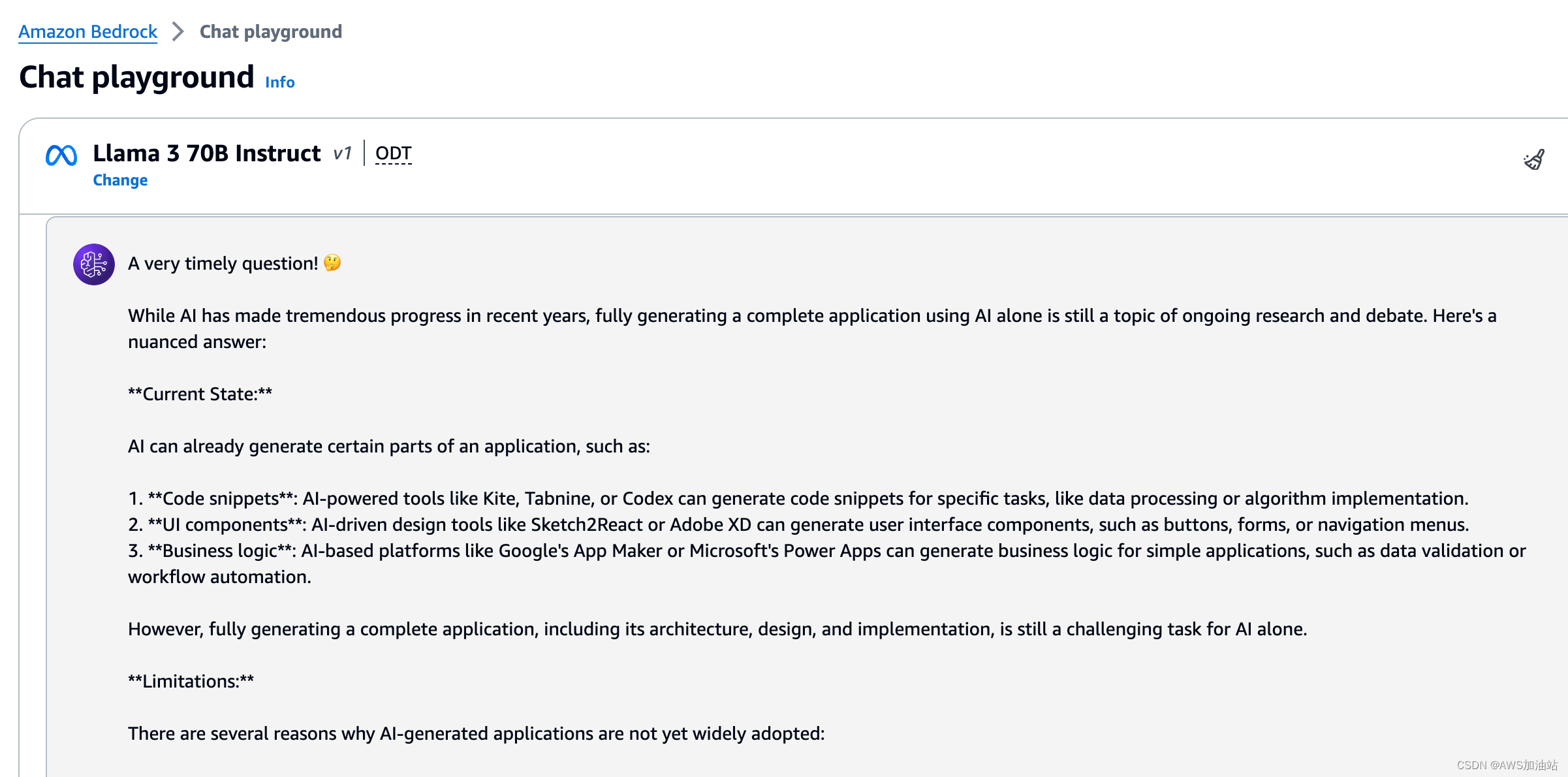

Amazon Bedrock 托管 Llama 3 界面如下:

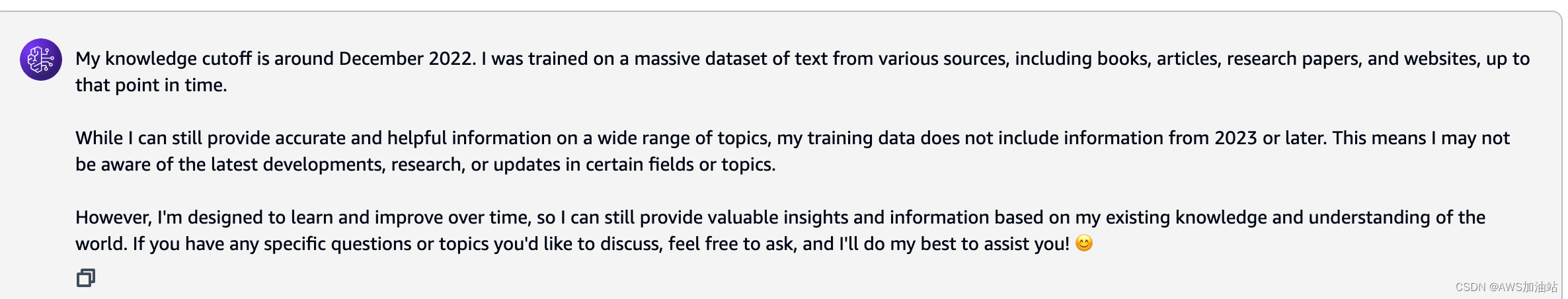

看起来知识库更新到22年12月,期待日后meta多多更新数据。

这篇关于Amazon Bedrock 托管 Llama 3 8B70B的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!