本文主要是介绍论文笔记:Does Writing with Language Models Reduce Content Diversity?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

iclr 2024 reviewer评分 566

1 intro

- 大模型正在迅速改变人们创造内容的方式

- 虽然基于LLM的写作助手有可能提高写作质量并增加作者的生产力,但它们也引入了算法单一文化

- ——>论文旨在评估与LLM一起写作是否无意中降低了内容的多样性

- 论文设计了一个控制实验,要求用户在纽约时报学生意见系列的一个话题下写一篇论证性文章,例如“学校教育中学生学到的最重要的东西是什么?

- 将参与者分为三组:

- 一组控制组,参与者在没有模型帮助的情况下写文章;

- 一组LLM处理组,参与者在基础语言模型(GPT3)的帮助下写文章;

- 一组反馈调优LLM处理组,参与者在经过人类反馈微调的语言模型(InstructGPT)的帮助下写文章。

- 论文雇佣了38名写手

- 对于每组,论文在10个话题上收集了100篇文章

- 然后,论文开发了一组指标并测量LLM对内容多样性的影响,包括个体层面和集体层面:

- 同质化:使用LLM写作的用户彼此写得是否更相似?

- 使用InstructGPT的组在同质化程度上高于控制组和GPT3组

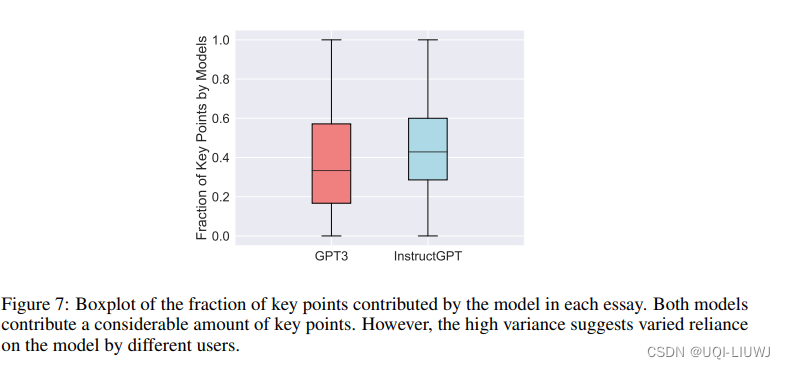

- 通过将模型贡献的文本与每篇文章的总结要点匹配,我们发现InstructGPT贡献的要点导致了同质化增加

- 多样性:与LLM一起写作是否降低了一组用户产生的内容的多样性?

- 与InstructGPT一起写的文章集合显示出较低的词汇多样性,并且表达的关键点的多样性也降低

- 同质化:使用LLM写作的用户彼此写得是否更相似?

- 将参与者分为三组:

2 数据收集

2.1 任务设置

- 用户将获得一个诸如“学校教育中学生学到的最重要的东西是什么?”的主题,并被要求用大约300字表达他们的观点

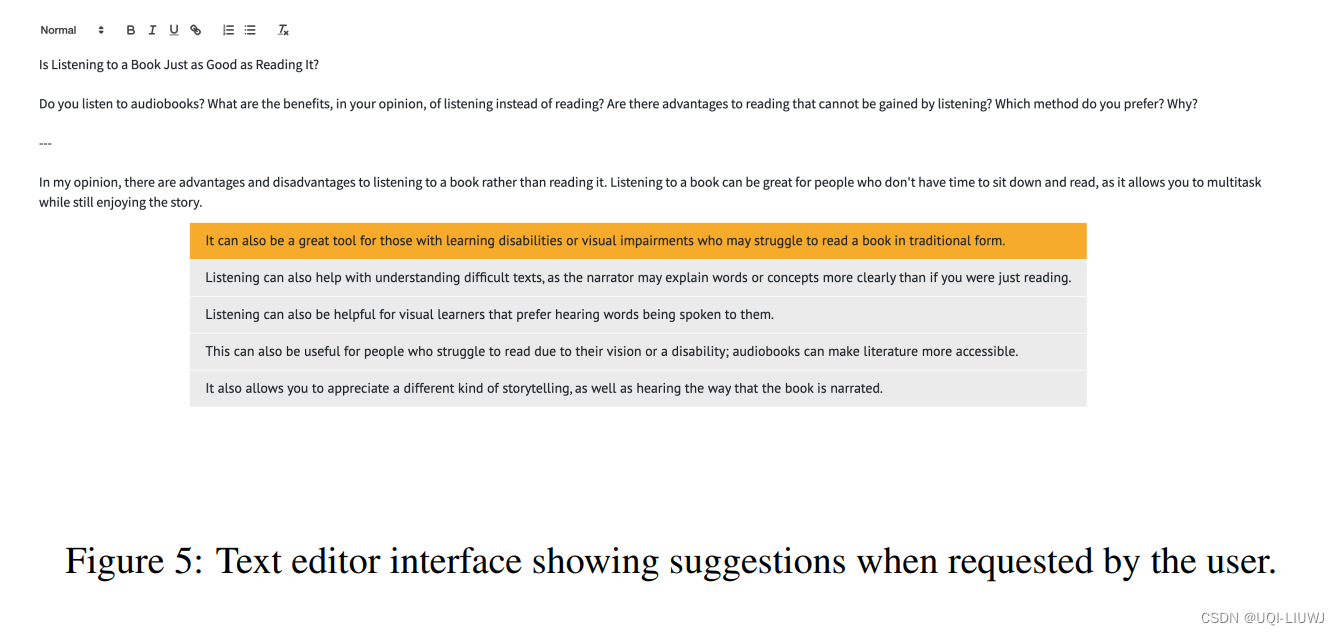

- 用户可以选择接受并编辑其中一个LLM提出的建议,或拒绝所有建议并继续他们的写作过程。

- 要求用户每篇文章至少请求5次建议,但不要求他们必须接受这些建议

3 用户如何与模型互动?

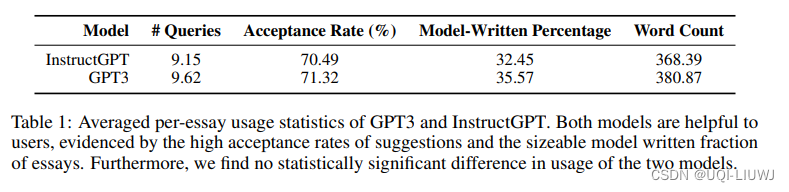

- 用户平均每篇文章查询模型约9次,并接受其中约70%的建议

- 由于用户可能在接受建议后进一步编辑这些建议,论文进一步计算了这些接受的建议是否保留在最终的文章中(model-written percentage)

但是,LLM的贡献是在贡献关键论点还是仅仅支持点的阐述呢?

——>论文过提示 gpt-3.5-turbo 将每篇文章总结为一个关键点列表,然后估计由模型和用户编写的关键点的比例

——>差不多40%的关键点是LLM提供的

4 使用LLM写作是否导致了更相似的文章?

- 使用InstructGPT写作产生了更相似的内容

- 使用GPT3写作并未增加同质化

5 使用LLM写作会降低内容的整体多样性吗?

- 使用InstructGPT写作降低了词汇多样性

- 使用InstructGPT写作降低了关键点多样性。

- InstructGPT组的多样性低于Solo和GPT3组

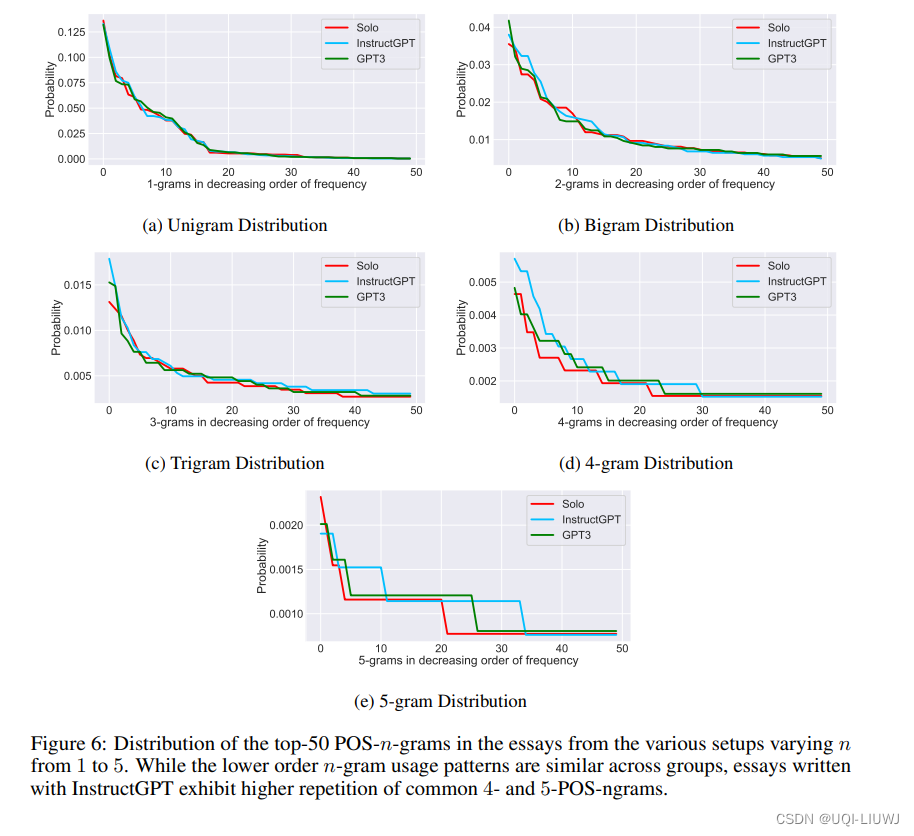

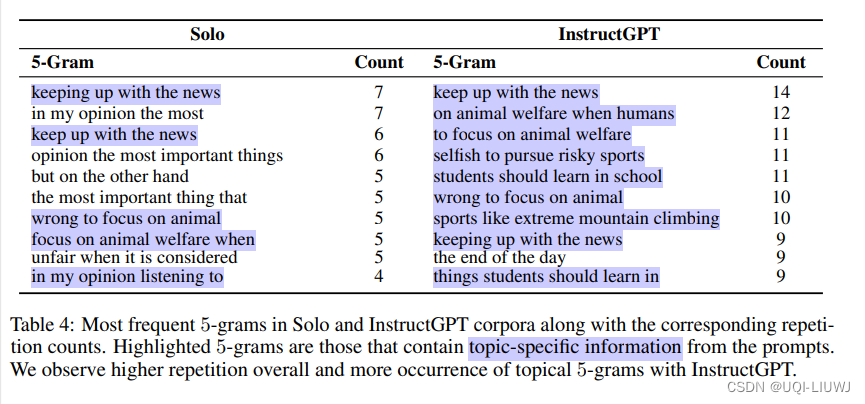

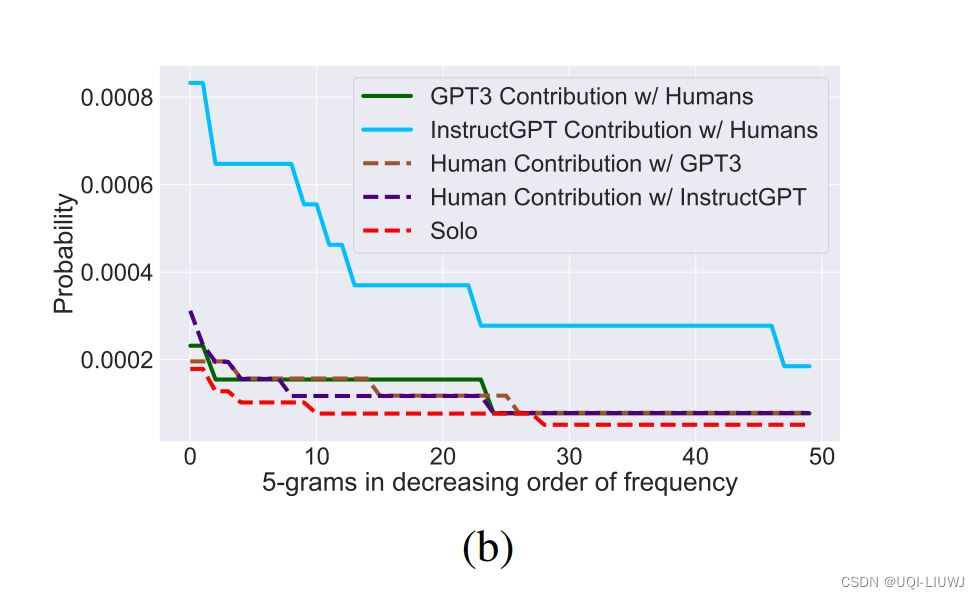

- 使用InstructGPT写作的文章更频繁地重复高阶n-grams

6 为什么使用 InstructGPT 写作会减少多样性?

- InstructGPT 生成的文本比 GPT3 的多样性少

- 与 GPT3 相比,InstructGPT 生成的文本多样性更低,这一点在先前的工作中也有观察到。

- GPT4 的技术报告发现反馈调优的模型校准度更低

- Bai 等人发现微调导致输出分布的熵减少

- 与 GPT3 相比,InstructGPT 生成的文本多样性更低,这一点在先前的工作中也有观察到。

- 模型写作和用户写作的多样性直接检查

- 无论用户是否与模型一起写作,以及他们使用哪个模型,用户写作文本的5-gram分布保持不变。

- ——>用户的短语使用模式不受模型帮助的影响

- InstructGPT 增加了关键点之间的相似性,而用户写作的文本未受影响

这篇关于论文笔记:Does Writing with Language Models Reduce Content Diversity?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!