本文主要是介绍第三节课《香豆:搭建你的 RAG 智能助理》,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、笔记

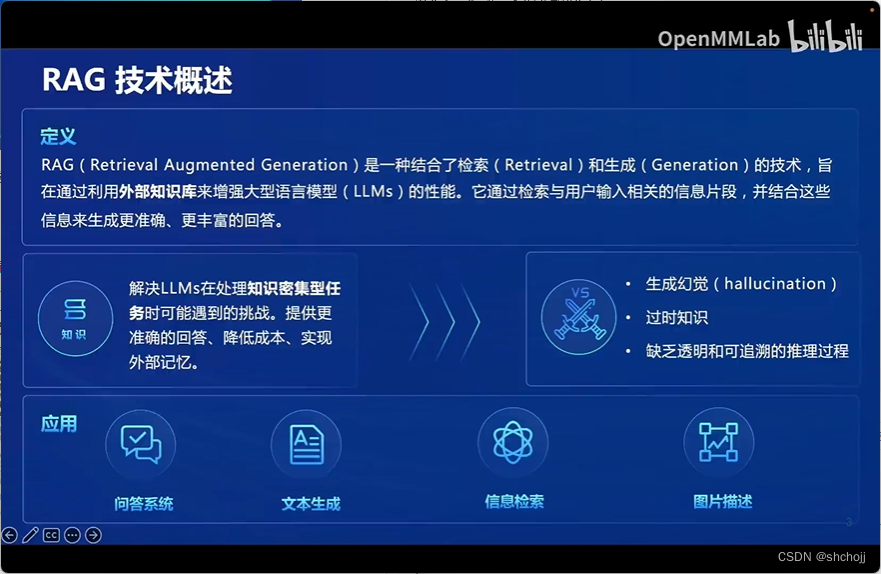

RAG搜索引擎,用户输入就是搜索内容。

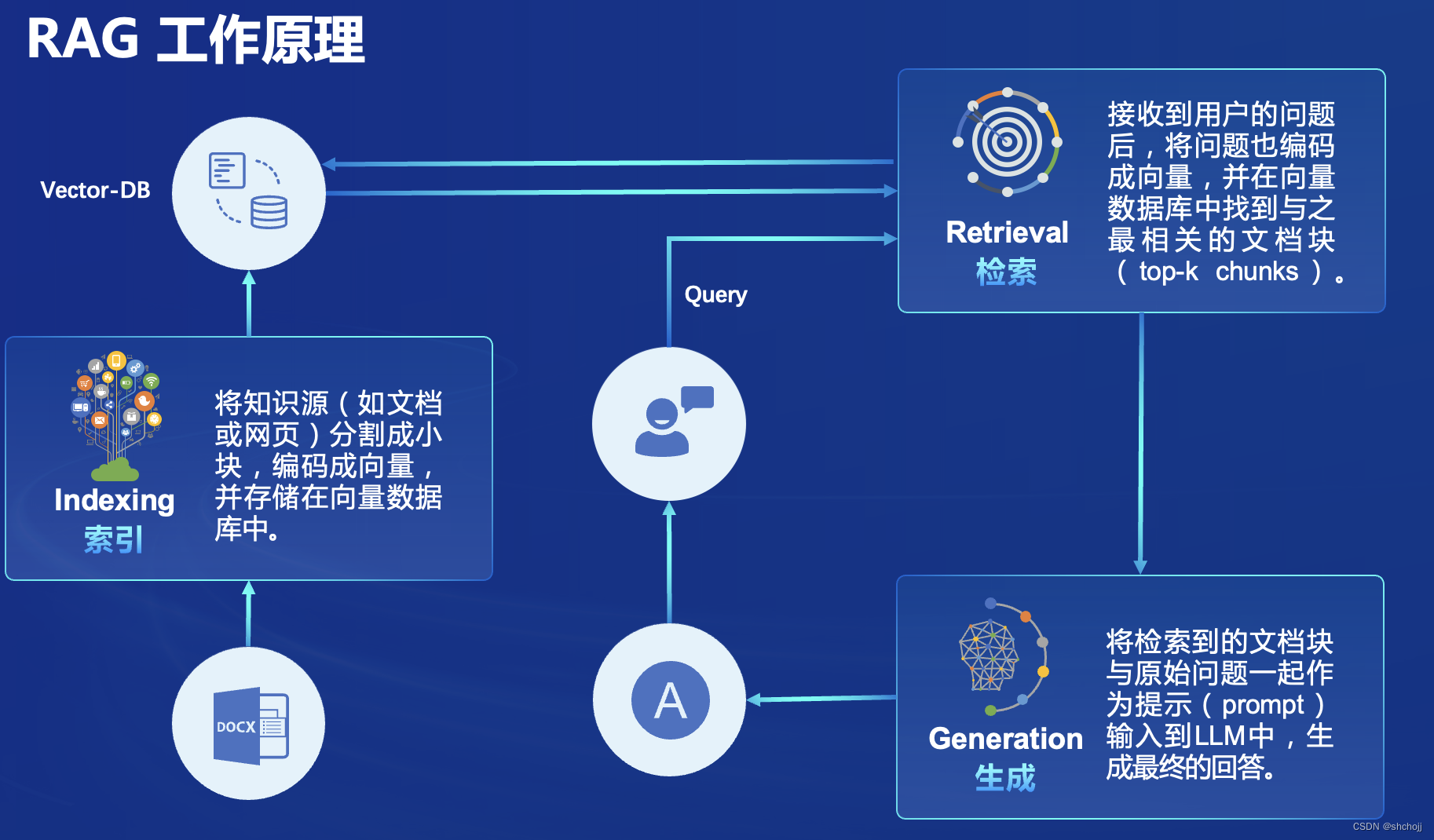

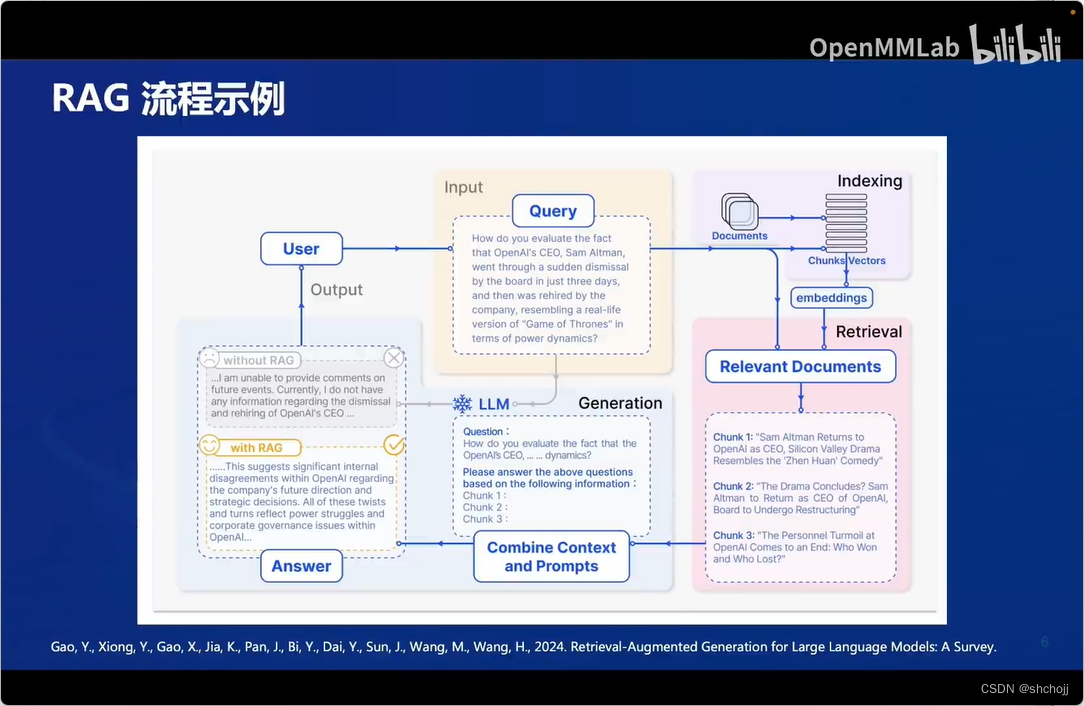

RAG三个部分:index、retrieval、generation。

将检索内容给和原问题一起作为提示prompt输入到LLM中

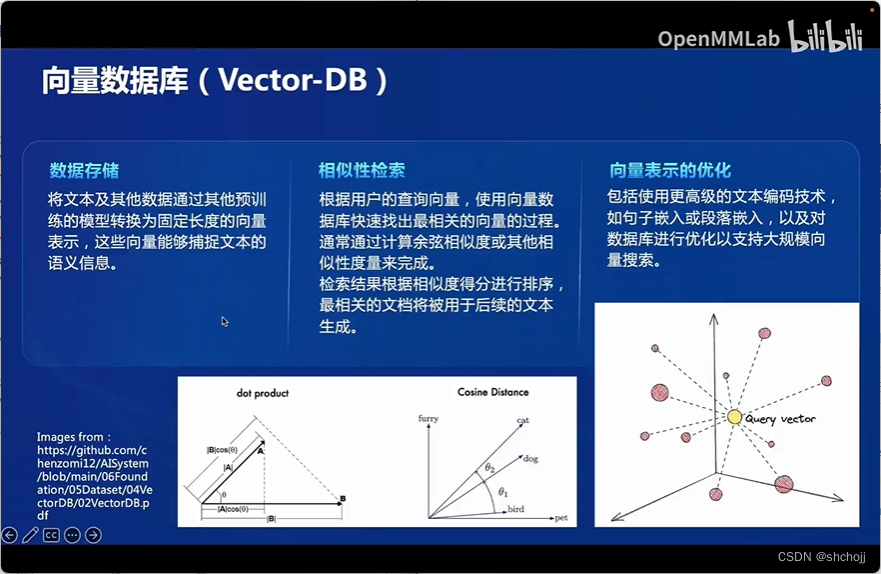

数据存储:将数据通过其他模型转换为固定长度的向量表示。

数据存储:将数据通过其他模型转换为固定长度的向量表示。

相似性检索:查询向量和数据库存储向量余弦相似性度量。

向量表示优化:与模型结果好坏息息相关

无关数据出现幻觉。

传统问答:提问query-->大模型LLM-->回答answer

RAG:提问query-->向量化embedding--->搜索indexing-->检索retieval->

问题+检索结果作为提示词prompts-->生成generation-->回答answer

不断更新向量数据库,就能不断的处理新的数据。

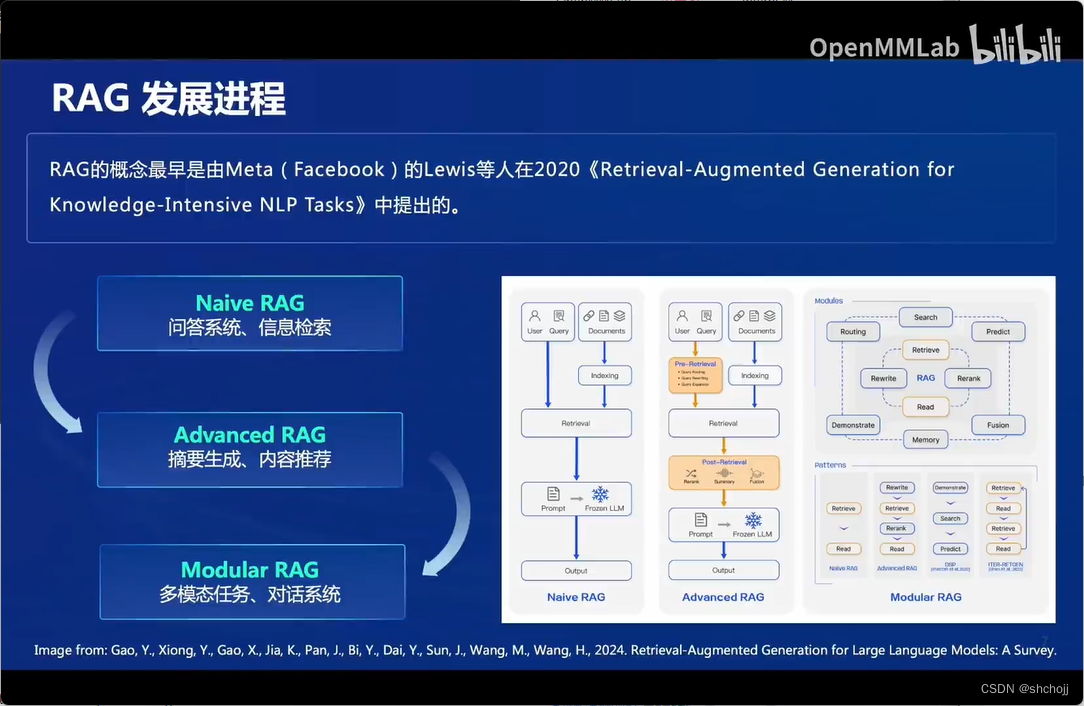

Naive RAG:只有索引、检索、生成。运用在问答系统和信息检索。

Advanced RAG:检索前后都进行增强,检索的问题路由扩展,检索到的信息进行重排序总结融合,运用在摘要生成和内容推荐。

Modular RAG: 将RAG基础部分和后续功能进行模块化,根据业务进行定制,完成多模态任务、对话系统等更高级的任务。

提升向量库的质量:

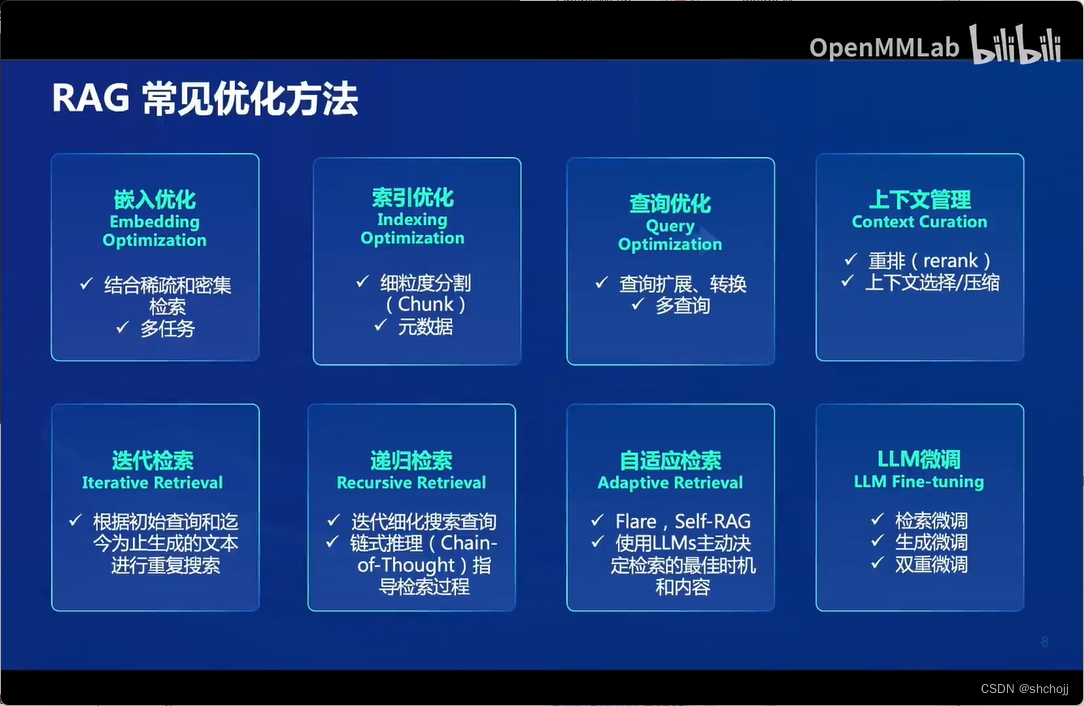

嵌入优化:增强嵌入性能

索引优化:提升索引质量

查询优化:更适应查询

上下文管理:减少冗余信息,提升大模型效率。

检索:

迭代检索:根据检索结果多次迭代检索知识,提供知识基础。

递归检索:改进检索结果的深度和相关性,

自适应检索:

LLM:定向微调、针对性微调。

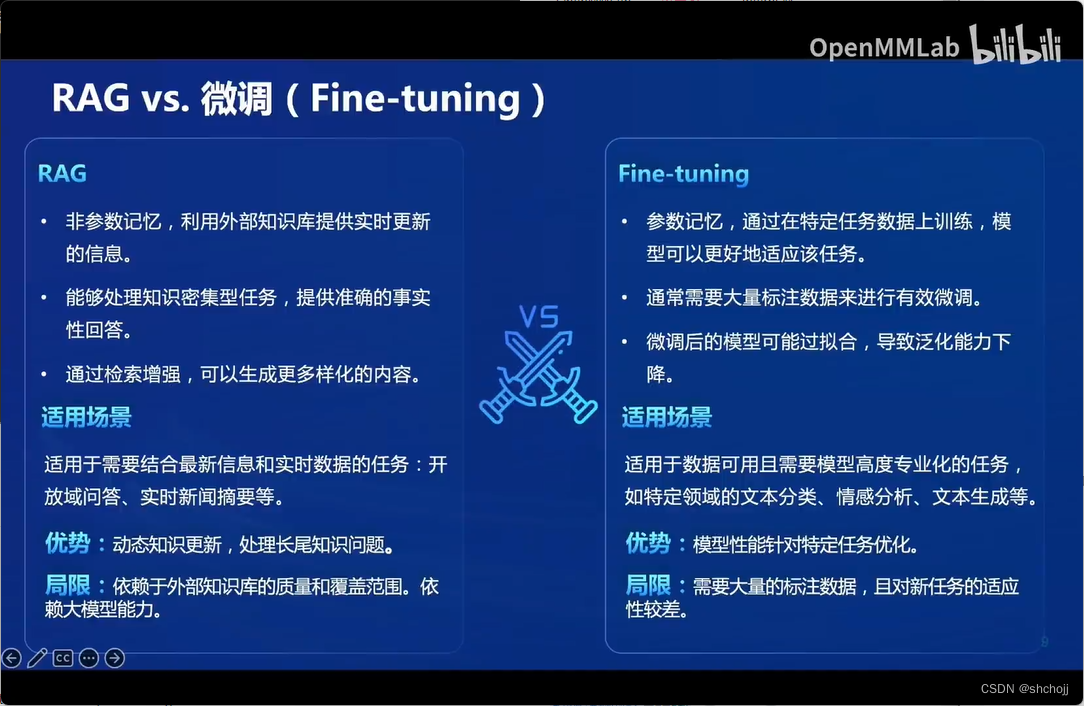

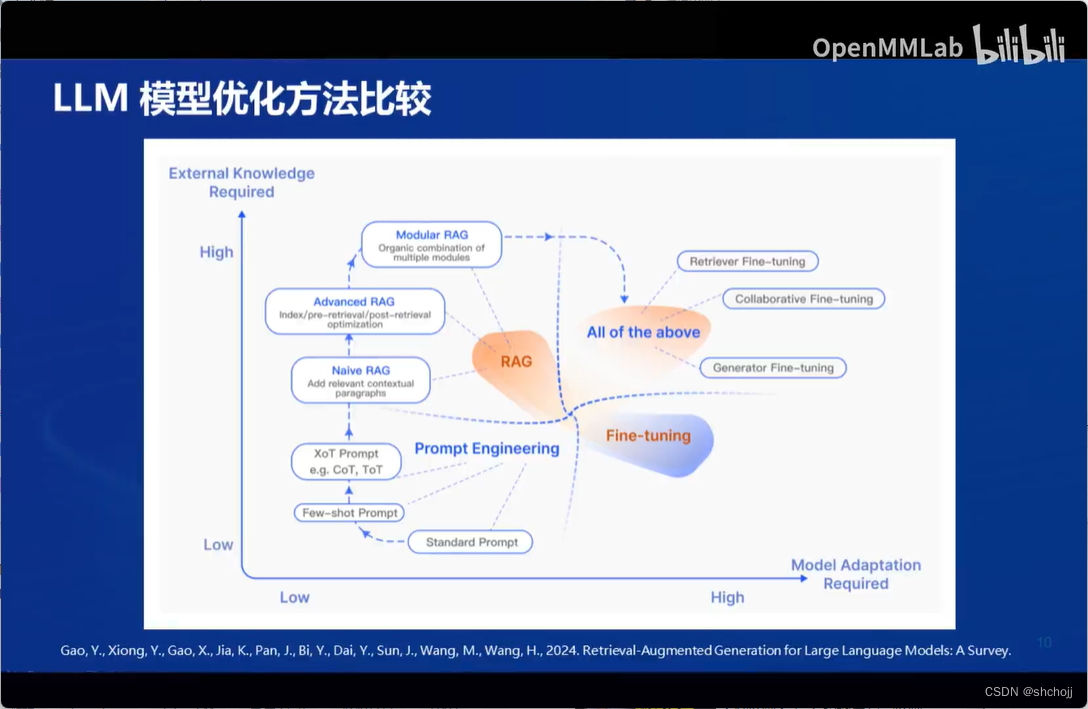

微调、提示工程、RAG

任务对外部知识需求

任务对模型适配度的需求

提示工程:对外部知识和适配度都比较差,不能适应新的知识,同时对特定专业知识也很难专业的回复

微调:对外部数据需求不高,但对模型任务适配度很高。

RAG: 对外部数据需求高,但对模型任务适配度不高。

融合三种方法:

检索阶段、生成阶段分开评价

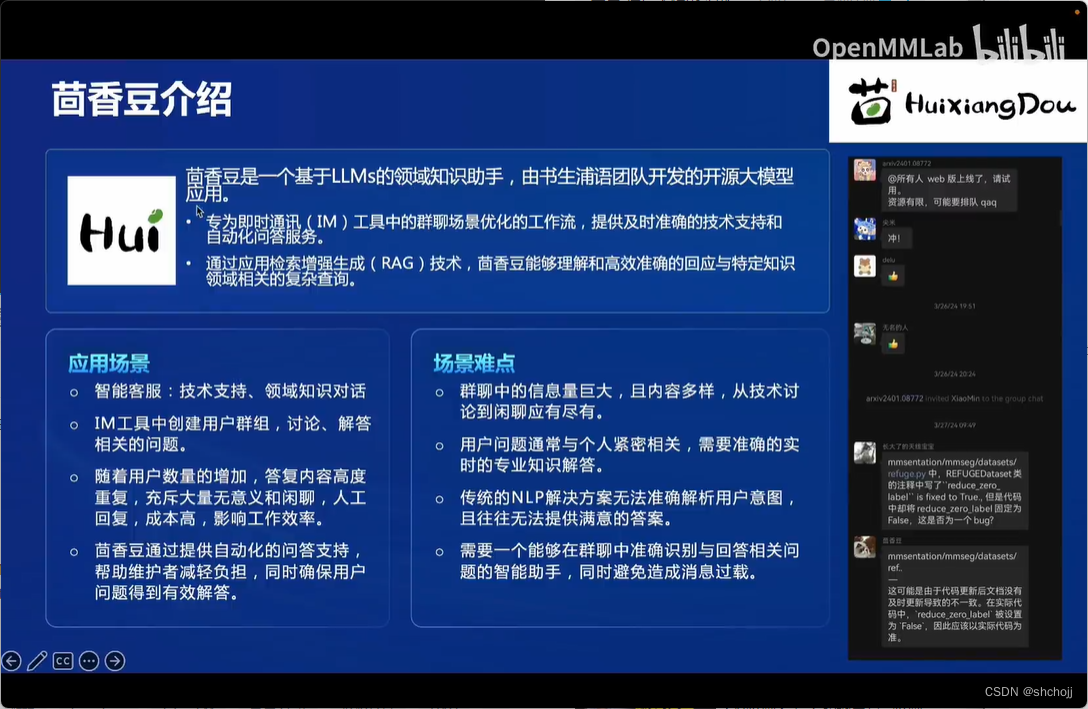

茴香豆

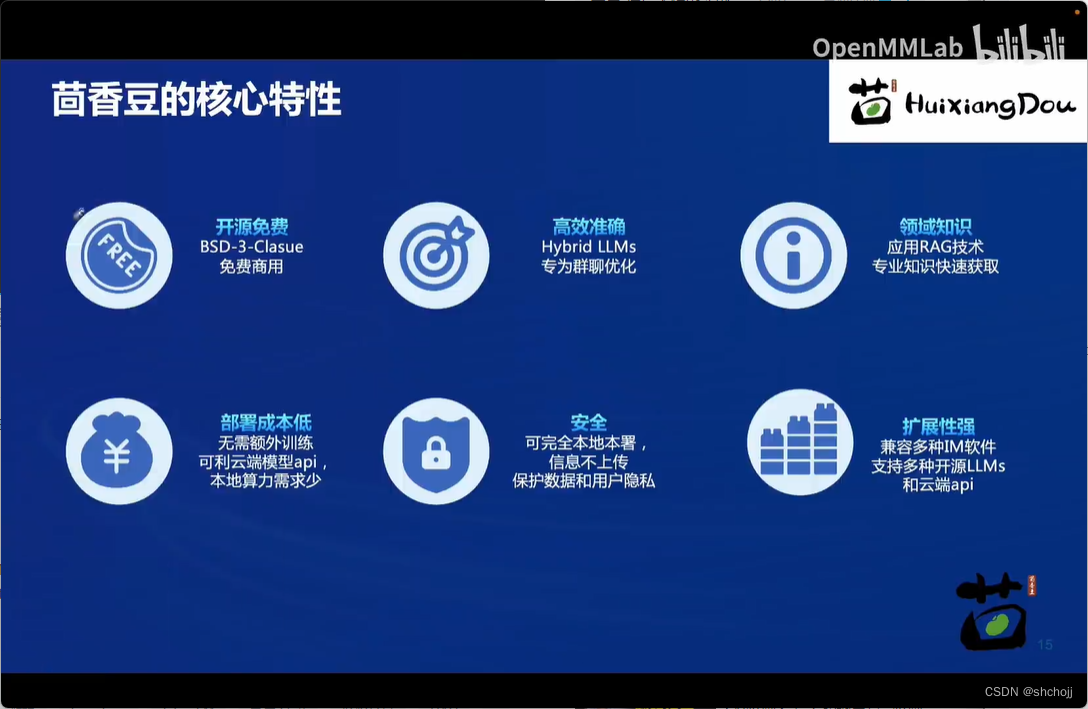

无需训练。

非有效数据,无法分析真实意图,结合LLM和RAG,提取有效信息

开源免费、本地部署、远端部署

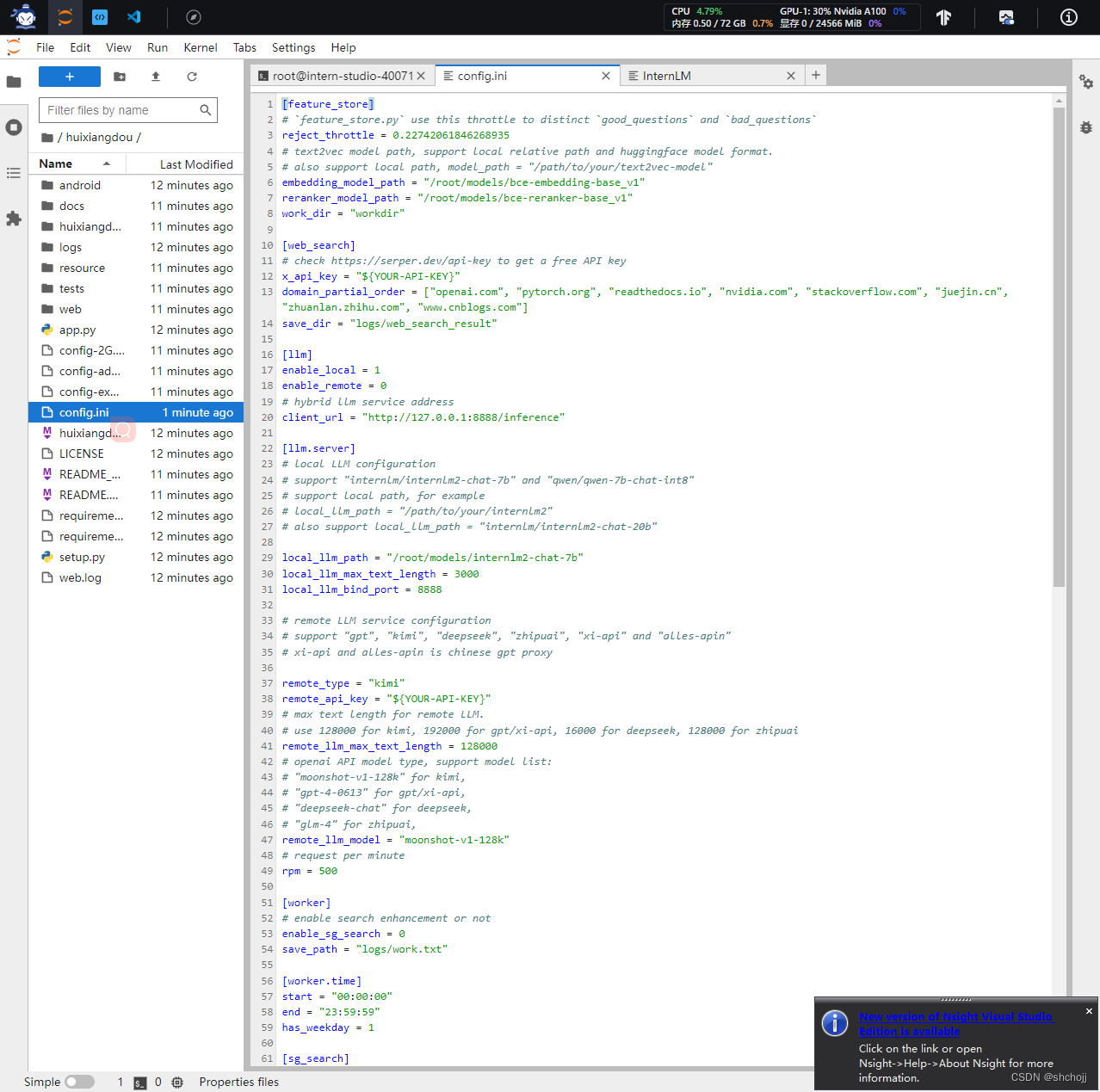

知识库:实时更新的专业领域数据,多种文件格式,设置接受处理范围。

前端:回答平台

大模型:本地(书生浦语、千亿千问)、远端API

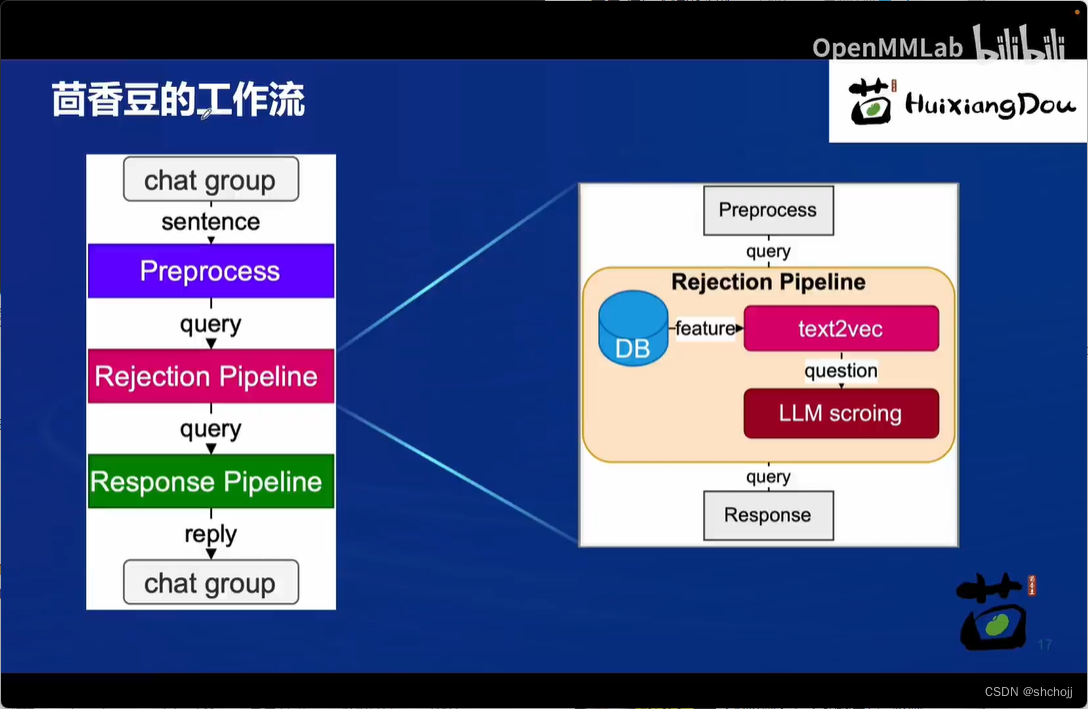

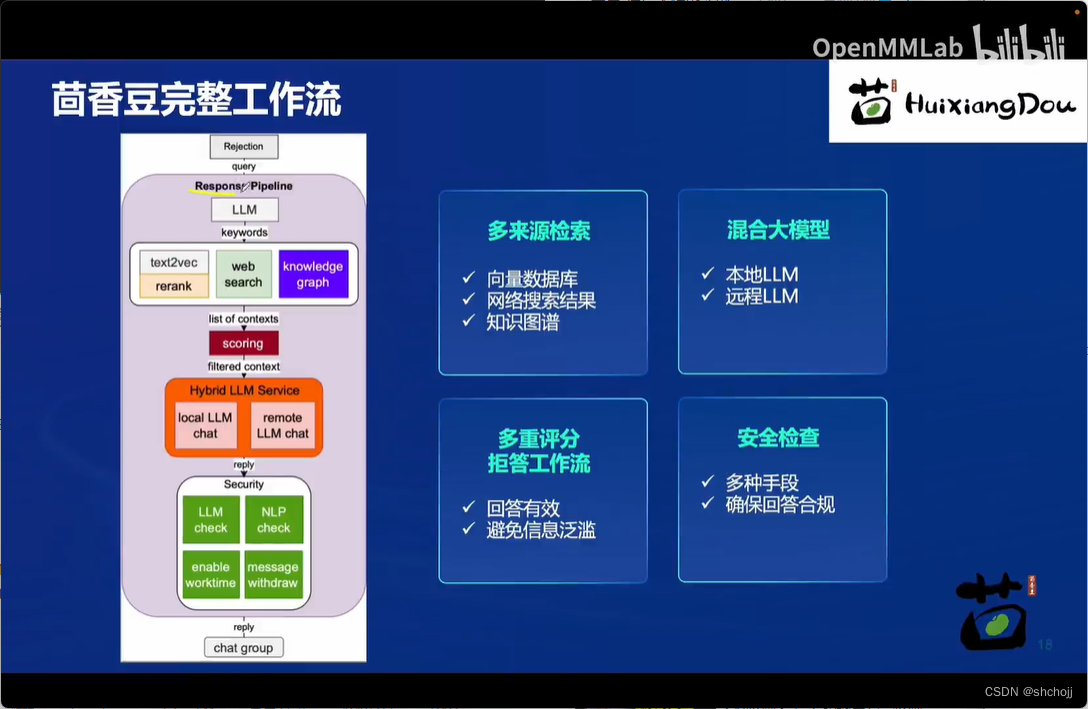

预处理:输入筛选,转换问询

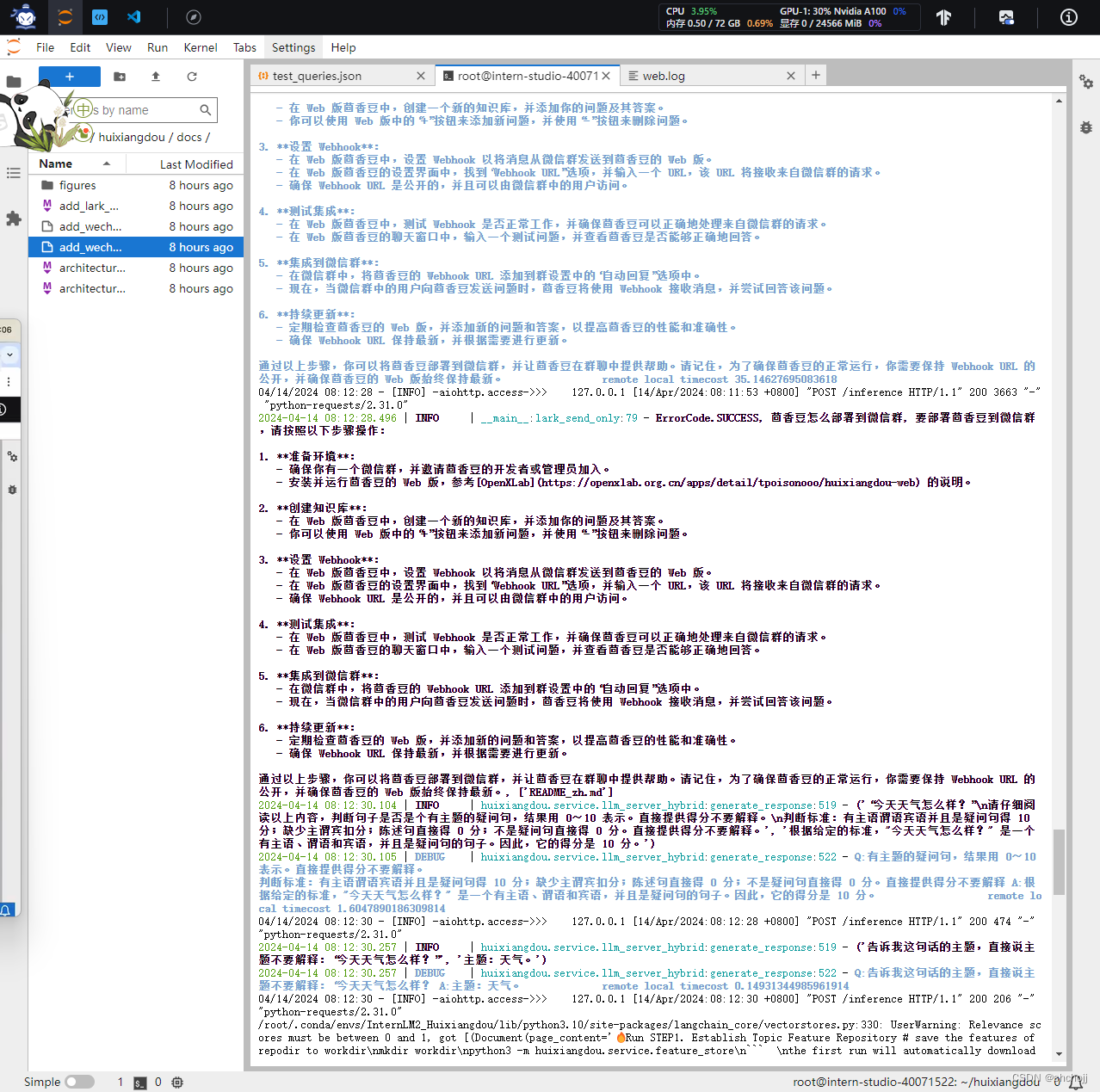

拒答工作流:分析、比较相关性得分

回答工作流:相关性得分达到,开始回答

LLM scroing阈值设定问答助手回答的是话痨还是严谨技术专家。

保证回答内容准确性。

本地或者网络检索。

多重评分回答问题严谨性。

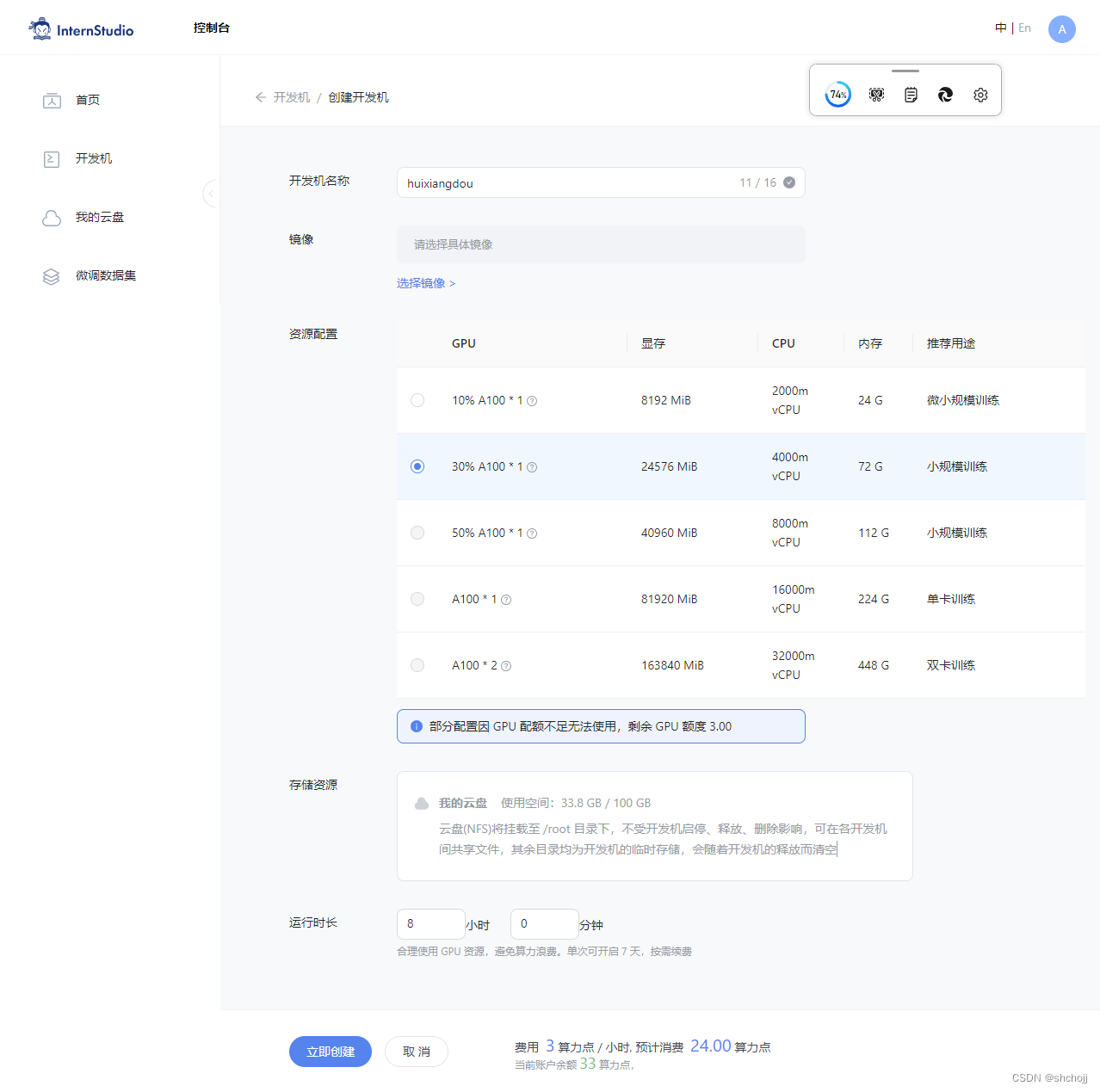

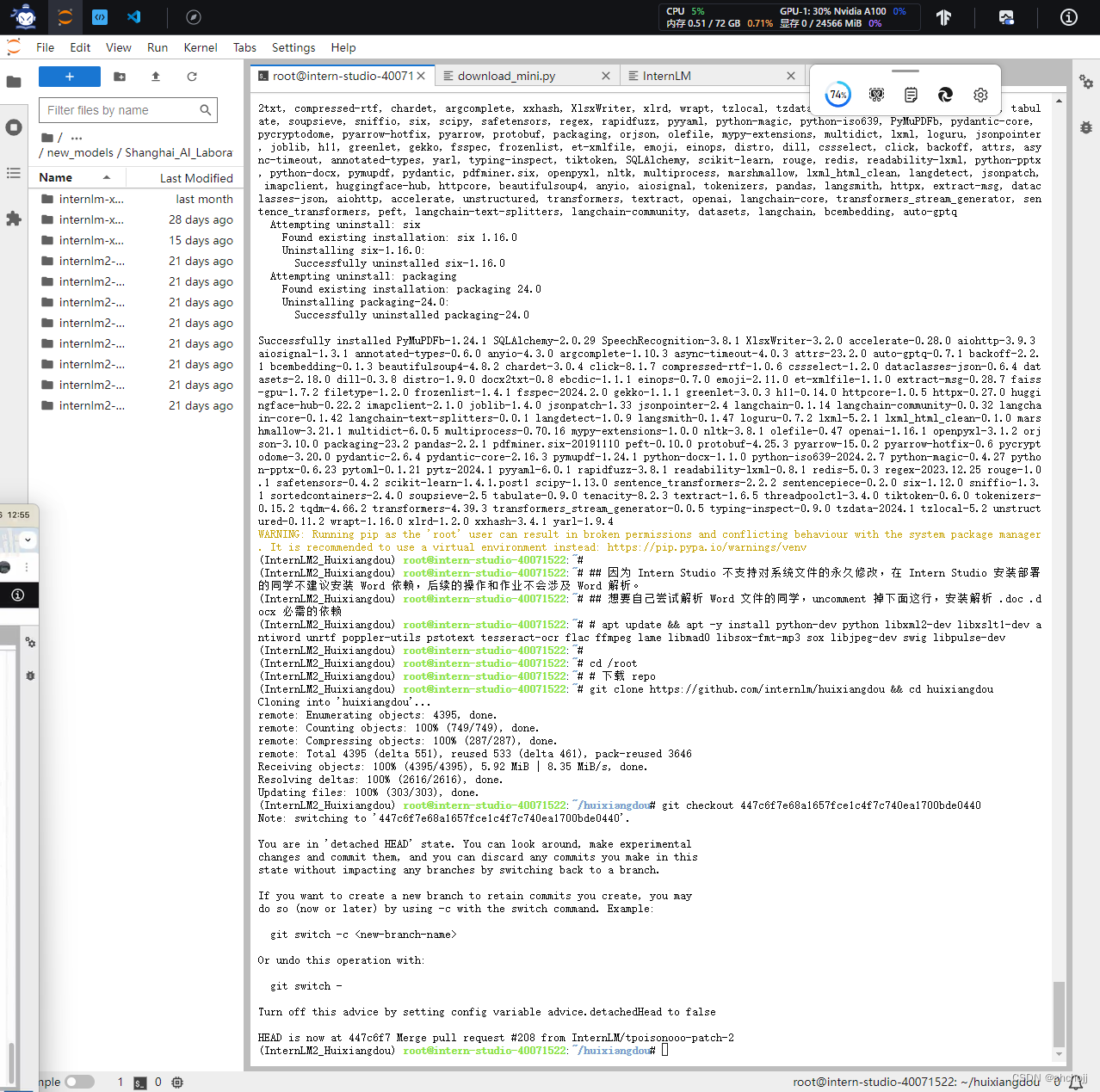

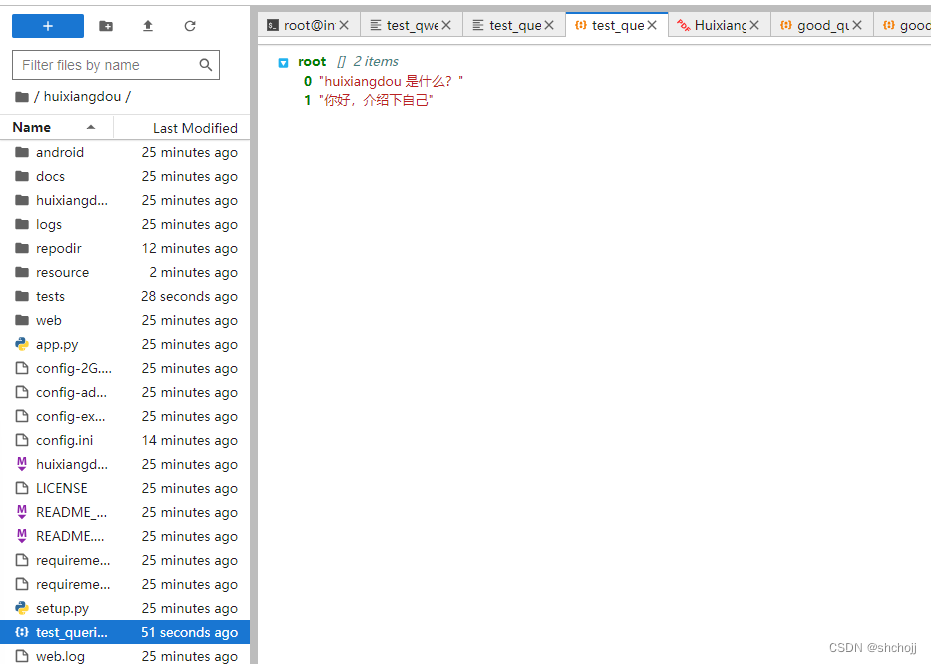

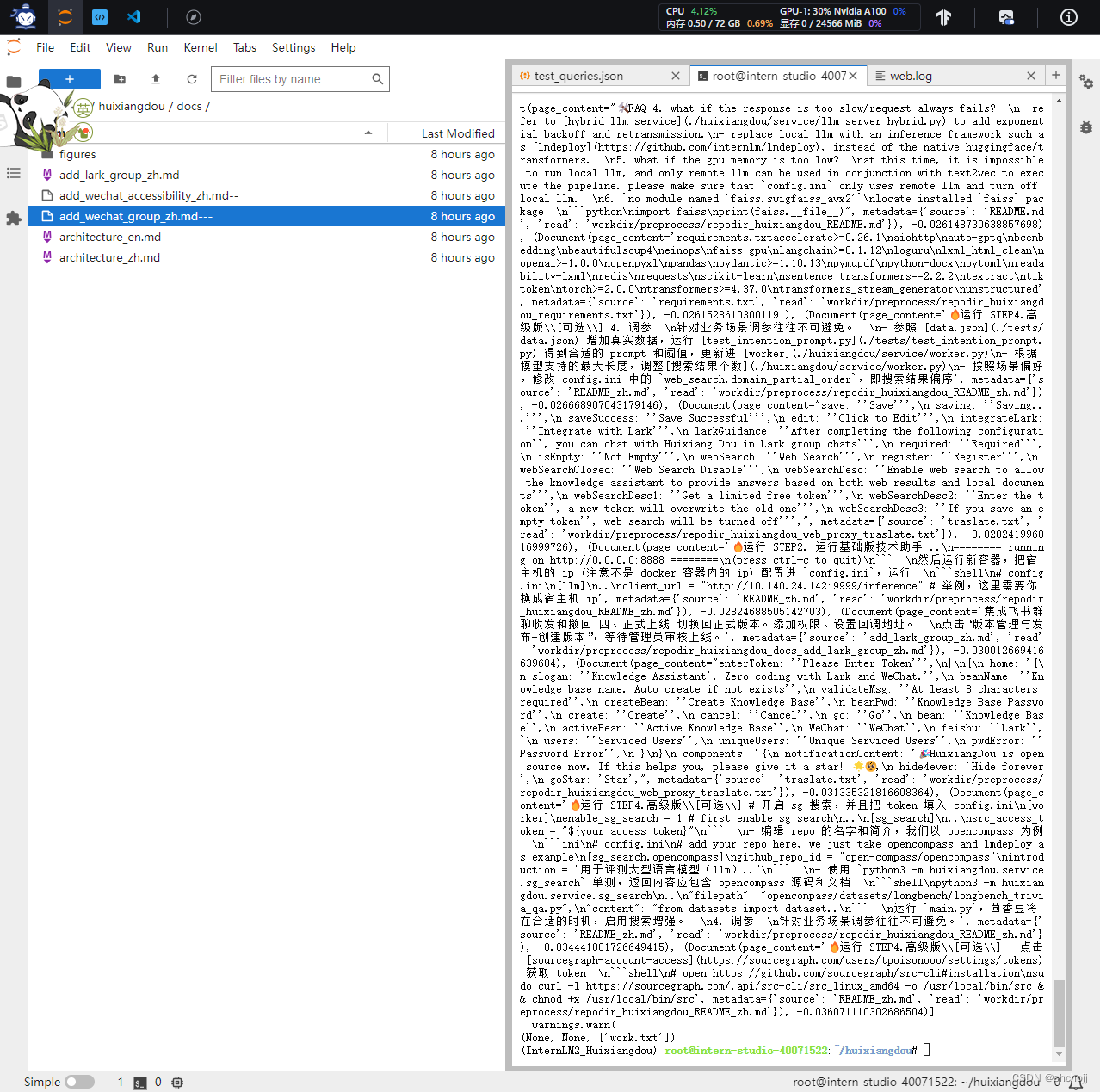

二、网页茴香豆

这里面很多文章应该是超过长度限制了,报错了几次

huixiangdou/repodir/huixiangdou/resource/HuixiangDou.pdf---

huixiangdou/repodir/huixiangdou/docs/add_wechat_accessibility_zh.md--

huixiangdou/repodir/huixiangdou/docs/add_wechat_group_zh.md---

这篇关于第三节课《香豆:搭建你的 RAG 智能助理》的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!