本文主要是介绍AI大模型探索之路-应用篇9:Langchain框架LangSmith模块-AI模型监控神器,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

前言

一、概述

二、准备工作

三、代码实践

二、监控查看

总结

前言

在经过前面多个篇章的学习后,我们已经了解到Langchain框架是一个为开发人员提供的全方位服务方案。从模型封装调用、提示词模板封装、Chain链式操作、检索增强,再到上线部署,它都提供了一站式解决方案。本章将重点讲解最后一个核心框架LangSmith,以补充完整最后的运维监控管理版块。

一、概述

Langchain框架旨在为AI开发者提供一个高效、灵活的工作环境,其中LangSmith模块扮演着至关重要的角色。作为框架中的一个核心组件,LangSmith专注于大规模语言模型(LLM)的管理、监控和维护。它不仅简化了模型的部署过程,还提供了丰富的功能,以确保模型能够在最佳状态下运行。

1) 调试

LangSmith提供了一个统一的平台,使得开发者能够快速调试新创建的链条、代理或工具集。它允许开发者可视化组件之间的关系和使用方式,这有助于识别和解决问题,尤其是在复杂的LLM应用程序中。LangSmith通过记录大模型发起的所有请求,为开发者提供了除输入输出之外的更多细节,从而使得调试过程更加高效和精确。

2) 测试:在测试方面,LangSmith能够对基于任何LLM框架构建的链条和智能代理进行测试。开发者可以在一个集成的环境中进行端到端的测试,确保各个组件能够协同工作,满足预期的功能和性能要求。

3) 评估:LangSmith还提供了评估功能,帮助开发者量化LLM应用程序的性能。通过对模型的响应和行为进行分析,开发者可以评估其准确性、可靠性和效率。

4) 监控:LangSmith的监控功能允许开发者实时跟踪LLM应用程序的运行状态。这包括监控模型的请求和响应,以及链条和代理的行为。通过持续监控,开发者可以确保应用程序的稳定性和可靠性,及时发现并解决可能出现的问题。

二、准备工作

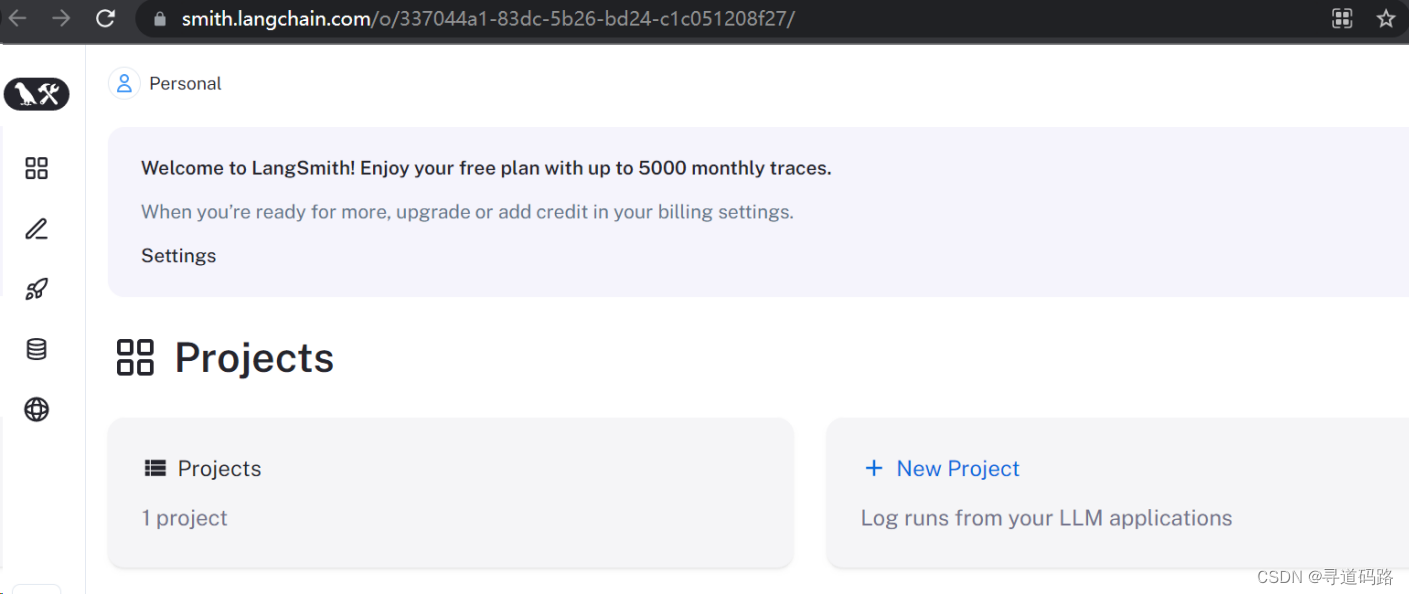

1.官网注册账号

LangSmith

2.创建API KEY

3.创建项目

设置Project名称

4.使用说明

无需开发代码,只要配置好环境变量即可

LANGCHAIN_TRACING_V2=true

LANGCHAIN_ENDPOINT="https://api.smith.langchain.com"

LANGCHAIN_API_KEY="<your-api-key>"

LANGCHAIN_PROJECT="langchain-langsmith01"

三、代码实践

1.简单代码样例

编写一个简单的代码样例

from langchain_openai import ChatOpenAI

llm = ChatOpenAI()

llm.invoke("你好!")2.复杂调用样例

编写一个Agent自我上网查询代码样例

from langchain import hub

from langchain.agents import AgentExecutor, create_openai_tools_agent

from langchain_community.tools.tavily_search import TavilySearchResults

from langchain_openai import ChatOpenAI#需要申请搜索引擎Tavily的API KEY

tools = [TavilySearchResults(max_results=1,tavily_api_key= "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")]#拉取提示词模板

prompt = hub.pull("hwchase17/openai-tools-agent")# 配置LLM 模型

llm = ChatOpenAI(model="gpt-3.5-turbo-1106", temperature=0)# 构建Agent

agent = create_openai_tools_agent(llm, tools, prompt)# 创建Agent 执行器、调用执行器

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

agent_executor.invoke({"input": "现任美国总统的妻子的父亲是?"})二、监控查看

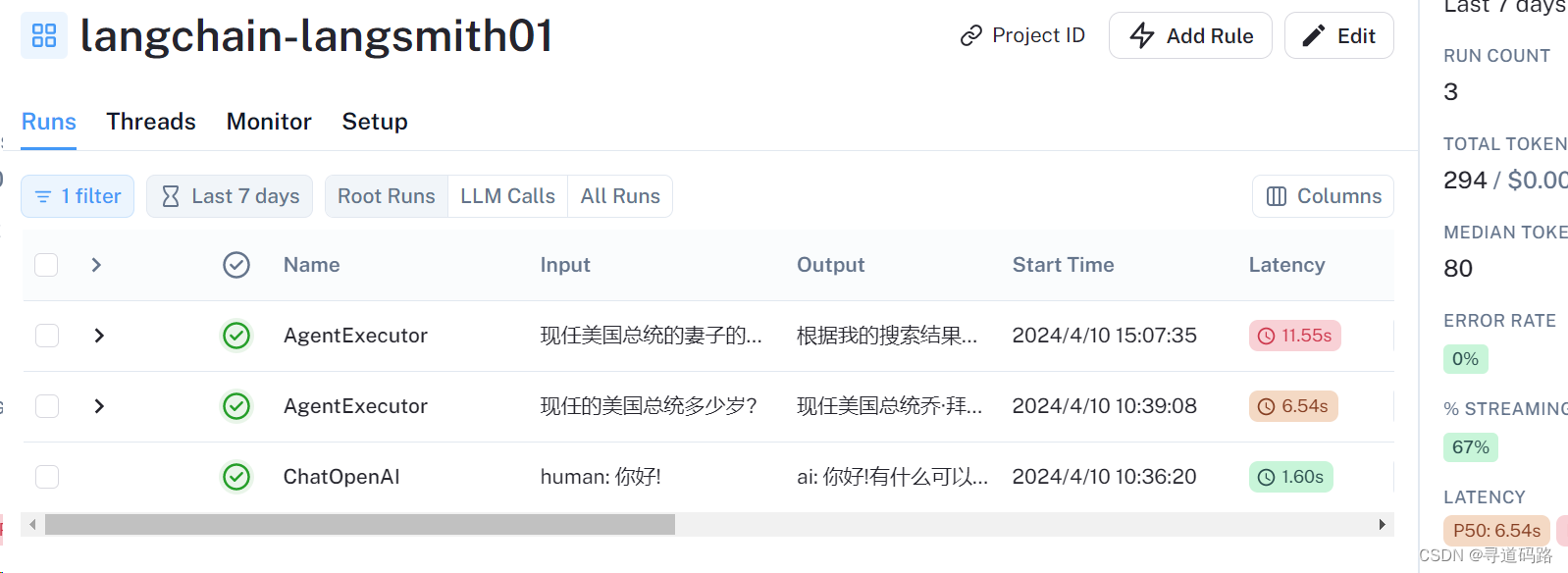

1.查看监控列表

查看所有调用过的LLM清单列表

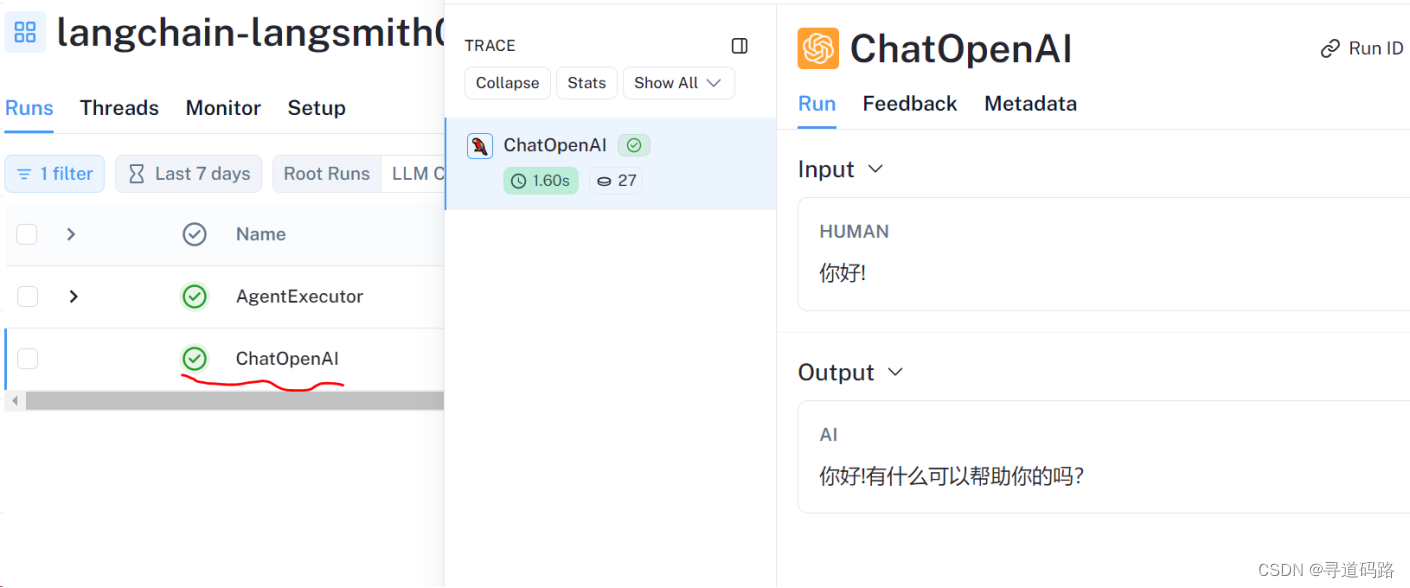

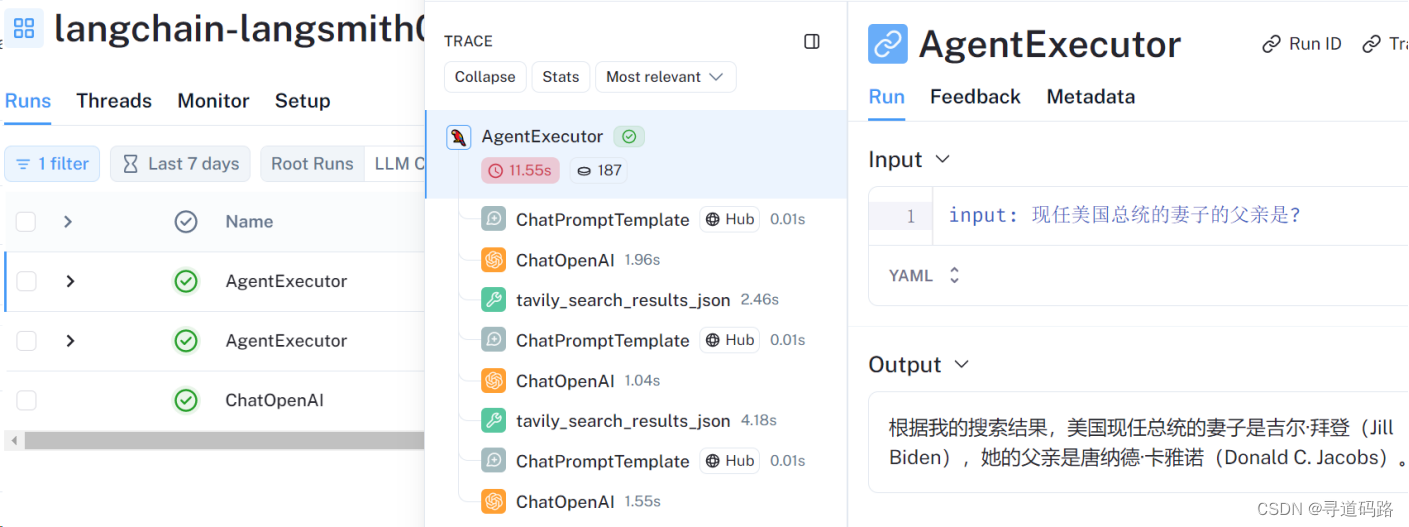

2.查看链路追踪

简单的调用,可以查看输入输出情况

复杂的调用,可以追踪查看推理调用步骤,以及每个步骤耗时情况

通过TRACE可以看到,整个Agent执行过程,比如本样例Agent执行过程中:

1)ChatPromptTemplate拉取组装提示词3次,

2)ChatOpenAI服务调用了3次

3)tavily_search 搜索服务调用了2次,其中网络搜索耗时最长

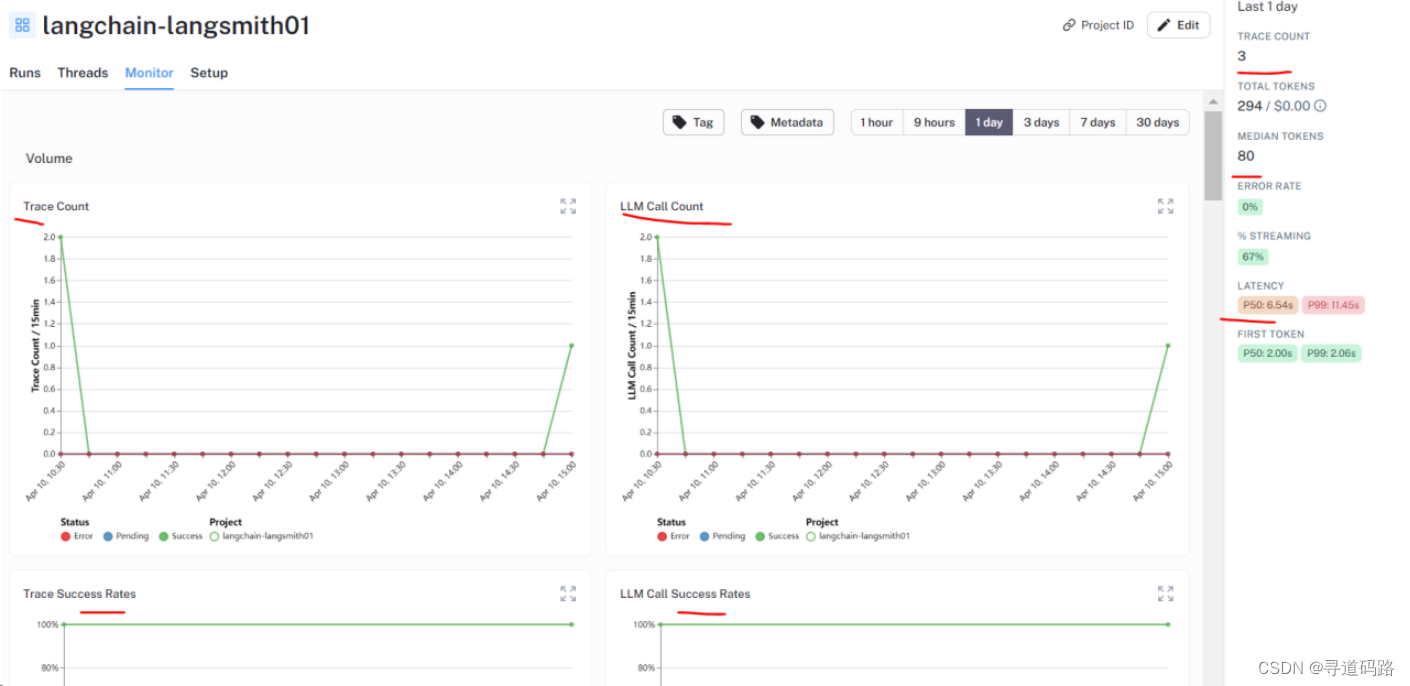

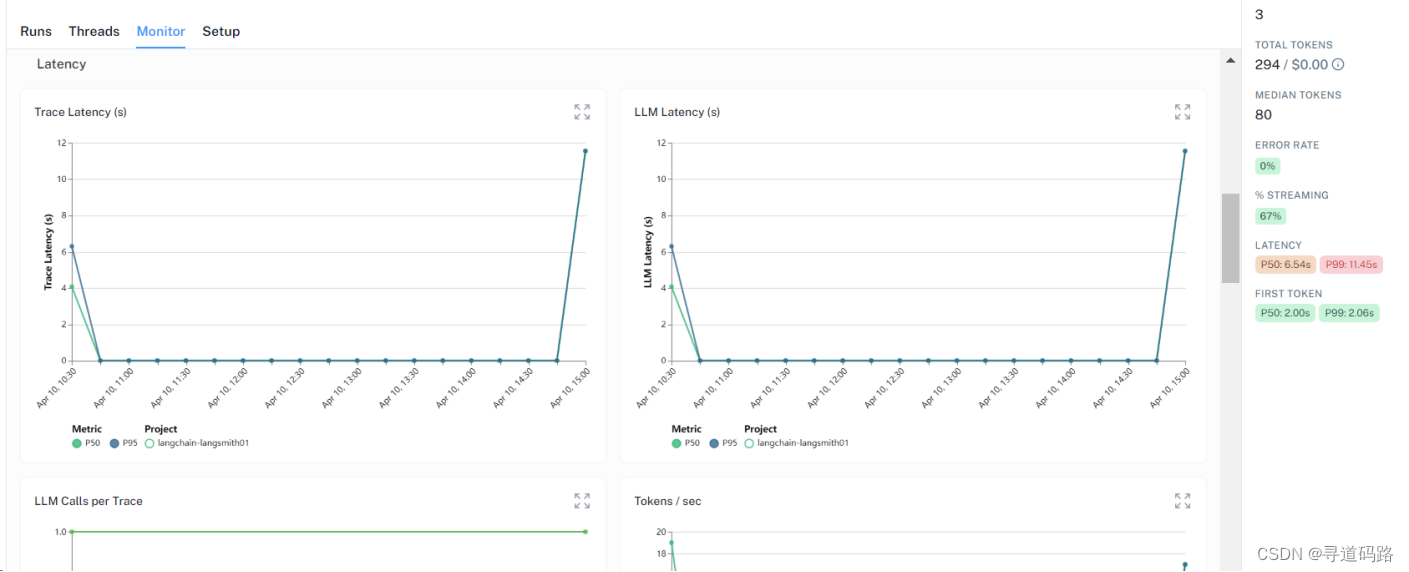

3.查看监控面板

可以查看LLM调用次数、追踪统计、Token消耗,延迟等

1)调用次数和成功率信息查看

2)延迟情况查看分析

3)Token消耗查看

总结

LangSmith模块是LangChain框架中的一个重要组成部分,专门用于支持生产级LLM应用程序的开发和维护。其提供的调试、测试、评估和监控功能,不仅简化了开发过程,也确保了LLM应用程序的质量和性能。通过这些功能,开发者可以更有效地构建、优化和部署基于Langchain框架的应用程序。

探索未知,分享所知;点击关注,码路同行,寻道人生!

这篇关于AI大模型探索之路-应用篇9:Langchain框架LangSmith模块-AI模型监控神器的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!