本文主要是介绍kubeadm方式部署k8s集群、v1.19.1版本,全程超详细,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- kubeadm方式部署k8s集群

- 安装docker--三台机器都操作

- 获取镜像

- 改tag

- 完整安装过程

- **使用kubeadm部署Kubernetes:**

- **配置启动kubelet(所有节点)**

- **配置master节点**

- **配置使用网络插件**

- 启动:

- 所有node节点操作

- 在master操作:

- 总结第二种方法

- 会遇到的问题总结

- 重新生成token

kubeadm方式部署k8s集群

官方文档:

<https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/install-kubeadm/>

切记要关闭防火墙和selinux,cpu核心数至少为2

kubeadm部署k8s高可用集群的官方文档:

<https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/high-availability/>

安装docker–三台机器都操作

做这些的前提是你三台机器都已经下载docker拉,版本最新的没有关系

获取镜像

阿里仓库下载

我这里是用俩种办法做的集群,第一种就是,直接拉取镜像,改tag

第二种就是我先把所有镜像拉完拉把标签都改完,我直接写的脚本往docker里面上传的镜像,这种方法我在最后面会总结

第一种方法:这个是没有提前拉好镜像,先执行这个,我下面有拉好的镜像,而且打好tar了,直接看下面总结,上次镜像就可以

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.19.1

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.19.1

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.19.1

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.19.1

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.6.5

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.3-0

[root@k8s-master ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1docker pull quay-mirror.qiniu.com/coreos/flannel:v0.12.0-amd64 --下载网络插件的配置文件

第二种方法:写个脚本直接全程拉取,不用一个一个去拉取

vim pull.sh

#!/bin/bash

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.19.1

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.19.1

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.19.1

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.19.1

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.6.5

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.3-0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.2docker pull quay-mirror.qiniu.com/coreos/flannel:v0.12.0-amd64改tag

下载完了之后需要将aliyun下载下来的所有镜像打成k8s.gcr.io/kube-controller-manager:v1.17.0这样的tag

第一种方法:

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.19.1 k8s.gcr.io/kube-controller-manager:v1.19.1

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.19.1 k8s.gcr.io/kube-proxy:v1.19.1

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.19.1 k8s.gcr.io/kube-apiserver:v1.19.1

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.19.1 k8s.gcr.io/kube-scheduler:v1.19.1

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.6.5 k8s.gcr.io/coredns:1.7.0

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.3-0 k8s.gcr.io/etcd:3.4.13-0

[root@k8s-master ~]# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1 k8s.gcr.io/pause:3.2

版本号不用变

第二种方法,写个脚本,直接一件改脚本

vim tag.sh

#!/bin/bash

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.19.1 k8s.gcr.io/kube-controller-manager:v1.19.1

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.19.1 k8s.gcr.io/kube-proxy:v1.19.1

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.19.1 k8s.gcr.io/kube-apiserver:v1.19.1

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.19.1 k8s.gcr.io/kube-scheduler:v1.19.1

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.6.5 k8s.gcr.io/coredns:1.7.0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.3-0 k8s.gcr.io/etcd:3.4.13-0

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1 k8s.gcr.io/pause:3.2

版本号不用变

所有机器都必须有镜像

完整安装过程

准备三台机器,时间同步

192.168.246.166 kub-k8s-master

192.168.246.167 kub-k8s-node1

192.168.246.169 kub-k8s-node2制作本地解析,修改主机名。相互解析

# vim /etc/hosts

所有机器系统配置

1.关闭防火墙:

# systemctl stop firewalld

# systemctl disable firewalld

2.禁用SELinux:

# setenforce 0

3.编辑文件/etc/selinux/config,将SELINUX修改为disabled,如下:

# sed -i 's/SELINUX=permissive/SELINUX=disabled/' /etc/sysconfig/selinux

SELINUX=disabled

关闭系统Swap:1.5之后的新规定

# swapoff -a

修改/etc/fstab文件,注释掉SWAP的自动挂载,使用free -m确认swap已经关闭。

2.注释掉swap分区:

[root@localhost /]# sed -i 's/.*swap.*/#&/' /etc/fstab

# free -mtotal used free shared buff/cache available

Mem: 3935 144 3415 8 375 3518

Swap: 0 0 0

使用kubeadm部署Kubernetes:

在所有节点安装kubeadm和kubelet:

配置源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

所有节点:

查看历史版本:# yum list kubectl --showduplicates | sort -r

查看版本所用的镜像: # kubeadm config images list --kubernetes-version=v1.19.1

1.安装

[root@k8s-master ~]# yum install -y kubelet-1.19.1-0.x86_64 kubeadm-1.19.1-0.x86_64 kubectl-1.19.1-0.x86_64 ipvsadm

2.加载ipvs相关内核模块

如果重新开机,需要重新加载(可以写在 /etc/rc.local 中开机自动加载)

# modprobe ip_vs

# modprobe ip_vs_rr

# modprobe ip_vs_wrr

# modprobe ip_vs_sh

# modprobe nf_conntrack_ipv4

3.编辑文件添加开机启动

# vim /etc/rc.local

# chmod +x /etc/rc.local

脚本方式

#!/bin/bash

modprobe ip_vs

modprobe ip_vs_rr

modprobe ip_vs_wrr

modprobe ip_vs_sh

modprobe nf_conntrack_ipv44.配置:

配置转发相关参数,否则可能会出错

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

vm.swappiness=0

EOF

5.使配置生效

sysctl --system

6.如果net.bridge.bridge-nf-call-iptables报错,加载br_netfilter模块

# modprobe br_netfilter

# sysctl -p /etc/sysctl.d/k8s.conf

7.查看是否加载成功

# lsmod | grep ip_vs

ip_vs_sh 12688 0

ip_vs_wrr 12697 0

ip_vs_rr 12600 0

ip_vs 141092 6 ip_vs_rr,ip_vs_sh,ip_vs_wrr

nf_conntrack 133387 2 ip_vs,nf_conntrack_ipv4

libcrc32c 12644 3 xfs,ip_vs,nf_conntrack

配置启动kubelet(所有节点)

1.配置kubelet使用pause镜像

获取docker的cgroups

[root@k8s-master ~]# DOCKER_CGROUPS=`docker info |grep 'Cgroup' | awk 'NR==1{print $3}'`

[root@k8s-master ~]# echo $DOCKER_CGROUPS

cgroupfs

配置kubelet的cgroups

cat >/etc/sysconfig/kubelet<<EOF

KUBELET_EXTRA_ARGS="--cgroup-driver=cgroupfs --pod-infra-container-image=k8s.gcr.io/pause:3.2"

EOF

查看一下

# cat /etc/sysconfig/kubelet #正确的是在一行

启动

# systemctl daemon-reload

# systemctl enable kubelet && systemctl restart kubelet

在这里使用 # systemctl status kubelet,你会发现报错误信息;

配置master节点

运行初始化过程如下:

初始化之前,切记要关闭防火墙和selinux,cpu核心数至少为2

kubeadm init --kubernetes-version=v1.19.1 --pod-network-cidr=10.244.0.0/16 --apiserver-advertise-address=192.168.246.166 --ignore-preflight-errors=Swap

解释

注:

apiserver-advertise-address=192.168.246.166 ---master的ip地址。

--kubernetes-version=v1.19.1 --更具具体版本进行修改

注意在检查一下swap分区是否关闭 如果报错会有版本提示,那就是有更新新版本了

如果报错会有版本提示,那就是有更新新版本了

上面记录了完成的初始化输出的内容,根据输出的内容基本上可以看出手动初始化安装一个Kubernetes集群所需要的关键步骤。

其中有以下关键内容:

[kubelet] 生成kubelet的配置文件”/var/lib/kubelet/config.yaml”

[certificates]生成相关的各种证书

[kubeconfig]生成相关的kubeconfig文件

[bootstraptoken]生成token记录下来,后边使用kubeadm join往集群中添加节点时会用到

配置使用kubectl

如下操作在master节点操作

[root@kub-k8s-master ~]# rm -rf $HOME/.kube

[root@kub-k8s-master ~]# mkdir -p $HOME/.kube

[root@kub-k8s-master ~]# cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@kub-k8s-master ~]# chown $(id -u):$(id -g) $HOME/.kube/config

查看node节点

[root@k8s-master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master NotReady master 2m41s v1.17.4

配置使用网络插件

在master节点操作

下载配置

cd ~ && mkdir flannel && cd flannel

# curl -O https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

修改配置文件kube-flannel.yml:

此处的ip配置要与上面kubeadm的pod-network一致,本来就一致,不用改

第一处配置文件

net-conf.json: |{"Network": "10.244.0.0/16","Backend": {"Type": "vxlan"}}

修改第二处

修改第二处

containers:- name: kube-flannelimage: quay.io/coreos/flannel:v0.11.0-amd64command:- /opt/bin/flanneldargs:- --ip-masq- --kube-subnet-mgr- --iface=ens33- --iface=eth0

修改第三处

修改第三处

- key: beta.kubernetes.io/archoperator: Invalues:- arm64hostNetwork: truetolerations:- operator: Existseffect: NoSchedule- key: node.kubernetes.io/not-ready #添加如下三行---在261行左右operator: Existseffect: NoScheduleserviceAccountName: flannel

启动:

#启动完成之后需要等待一会

kubectl apply -f ~/flannel/kube-flannel.yml

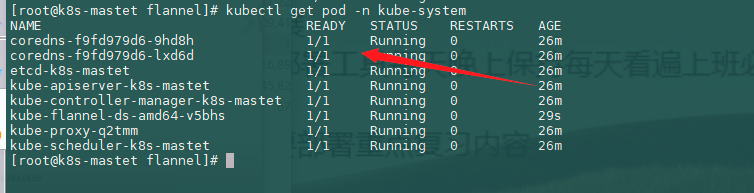

查看:

kubectl get pod -n kube-system

所有node节点操作

配置node节点加入集群:

如果报错开启ip转发:

# sysctl -w net.ipv4.ip_forward=1

在所有node节点操作,此命令为初始化master成功后返回的结果

每个人的都不一样,记得要保存好你们自己的

kubeadm join 192.168.246.166:6443 --token 93erio.hbn2ti6z50he0lqs \--discovery-token-ca-cert-hash sha256:3bc60f06a19bd09f38f3e05e5cff4299011b7110ca3281796668f4edb29a56d9

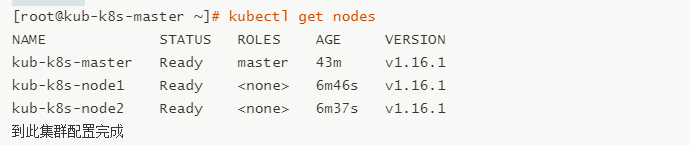

在master操作:

1.查看pods:

[root@kub-k8s-master ~]# kubectl get pods -n kube-system

总结第二种方法

用第一种方法,先把镜像都拉取下了,然后把tag打好。

写个脚本把所有镜像都上传到docker上面去

vim docker.sh

#!/bin/bash

docker load -i etcd.tar

docker load -i flannel.tar

docker load -i kube-apiserver.tar

docker load -i kube-controller-manager.tar

docker load -i kube-proxy.tar

docker load -i kube-scheduler.tar

docker load -i pause.tar

docker load -i coredns.tar

docker images

然后接着 配置使用网络插件这里做,不用下载镜像拉,直接编写配置文件就行。

会遇到的问题总结

查看异常pod信息:

[root@kub-k8s-master ~]# kubectl describe pods kube-flannel-ds-sr6tq -n kube-system

遇到这种情况直接 删除异常pod:

遇到这种情况直接 删除异常pod:

[root@kub-k8s-master ~]# kubectl delete pod kube-flannel-ds-sr6tq -n kube-system

pod "kube-flannel-ds-sr6tq" deleted4.查看pods:

[root@kub-k8s-master ~]# kubectl get pods -n kube-system

5.查看节点

5.查看节点

错误

问题1:服务器时间不一致会报错

查看服务器时间

问题2:kubeadm init不成功,发现如下提示,然后超时报错

[wait-control-plane] Waiting for the kubelet to boot up the control plane as static Pods from directory "/etc/kubernetes/manifests". This can take up to 4m0s

查看kubelet状态发现如下错误,主机master找不到和镜像下载失败,发现pause镜像是从aliyuncs下载的,其实我已经下载好了官方的pause镜像,按着提示的镜像名称重新给pause镜像打个ali的tag,最后重置kubeadm的环境重新初始化,错误解决

解决方式

重置节点(node上-也就是在被删除的节点上)

[root@kub-k8s-node1 ~]# kubeadm reset #所有机器操作

注1:需要把master也驱离、删除、重置,这里给我坑死了,第一次没有驱离和删除master,最后的结果是查看结果一切正常,但coredns死活不能用,搞了整整1天,切勿尝试

注2:master上在reset之后需要删除如下文件

rm -rf /var/lib/cni/ $HOME/.kube/config #所有机器操作

注意:如果整个k8s集群都做完了,需要重置按照上面步骤操作。如果是在初始化出错只需要操作重置节点

重新生成token

kubeadm 生成的token过期后,集群增加节点通过kubeadm初始化后,都会提供node加入的token:

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:https://kubernetes.io/docs/concepts/cluster-administration/addons/You can now join any number of machines by running the following on each node

as root:kubeadm join 192.168.246.166:6443 --token n38l80.y2icehgzsyuzkthi \--discovery-token-ca-cert-hash sha256:5fb6576ef82b5655dee285e0c93432aee54d38779bc8488c32f5cbbb90874bac

默认token的有效期为24小时,当过期之后,该token就不可用了。解决方法:

- 重新生成新的token:

解决方法:

1. 重新生成新的token:

[root@node1 flannel]# kubeadm token create

kiyfhw.xiacqbch8o8fa8qj

[root@node1 flannel]# kubeadm token list

TOKEN TTL EXPIRES USAGES DESCRIPTION EXTRA GROUPS

gvvqwk.hn56nlsgsv11mik6 <invalid> 2018-10-25T14:16:06+08:00 authentication,signing <none> system:bootstrappers:kubeadm:default-node-token

kiyfhw.xiacqbch8o8fa8qj 23h 2018-10-27T06:39:24+08:00 authentication,signing <none> system:bootstrappers:kubeadm:default-node-token2. 获取ca证书sha256编码hash值:

[root@node1 flannel]# openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^.* //'

5417eb1b68bd4e7a4c82aded83abc55ec91bd601e45734d6aba85de8b1ebb0573. 节点加入集群:kubeadm join 18.16.202.35:6443 --token kiyfhw.xiacqbch8o8fa8qj --discovery-token-ca-cert-hash sha256:5417eb1b68bd4e7a4c82aded83abc55ec91bd601e45734d6aba85de8b1ebb057

几秒钟后,您应该注意到kubectl get nodes在主服务器上运行时输出中的此节点。上面的方法比较繁琐,一步到位:

kubeadm token create --print-join-command第二种方法:

token=$(kubeadm token generate)

kubeadm token create $token --print-join-command --ttl=0

这篇关于kubeadm方式部署k8s集群、v1.19.1版本,全程超详细的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!