本文主要是介绍决战k8s,Kubernetes、Master节点部署组件,部署apiserver组件、部署schduler组件、部署controller-manager组件、超细详解 ,安装篇②,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- **在Master节点部署组件**

- 生成证书

- **部署apiserver组件**---在master节点进行

- 如下操作:

- 创建apiserver配置文件:重点提示

- systemd管理apiserver:

- 部署schduler组件---master节点

- systemd管理schduler组件:

- 部署controller-manager组件--控制管理组件

- systemd管理controller-manager组件:

在Master节点部署组件

j接上篇,在部署Kubernetes之前一定要确保etcd、flannel、docker是正常工作的,否则先解决问题再继续,重点,重点,重点。

生成证书

master节点操作–给api-server创建的证书。别的服务访问api-server的时候需要通过证书认证

创建CA证书:

[root@k8s-master1 ~]# mkdir -p /opt/crt/

[root@k8s-master1 ~]# cd /opt/crt/

# vim ca-config.json

以下内容是配置好的,不用修改,复制即可

{"signing": {"default": {"expiry": "87600h"},"profiles": {"kubernetes": {"expiry": "87600h","usages": ["signing","key encipherment","server auth","client auth"]}}}

}

第二个配置文件

# vim ca-csr.json

以下内容是配置好的,不用修改,复制即可

{"CN": "kubernetes","key": {"algo": "rsa","size": 2048},"names": [{"C": "CN","L": "Beijing","ST": "Beijing","O": "k8s","OU": "System"}]

}

生成apiserver证书:

[root@k8s-master1 crt]# cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

第三个配置文件

[root@k8s-master1 crt]# vim server-csr.json

# cat server-csr.json

以下内容需要修改成你自己的ip

{"CN": "kubernetes","hosts": ["10.0.0.1", //这是后面dns要使用的虚拟网络的网关,不用改,就用这个切忌"127.0.0.1","192.168.246.162", // master的IP地址。"192.168.246.164","192.168.246.165","kubernetes","kubernetes.default","kubernetes.default.svc","kubernetes.default.svc.cluster","kubernetes.default.svc.cluster.local"],"key": {"algo": "rsa","size": 2048},"names": [{"C": "CN","L": "BeiJing","ST": "BeiJing","O": "k8s","OU": "System"}]

}

[root@k8s-master1 crt]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes server-csr.json | cfssljson -bare server

生成kube-proxy证书:

[root@k8s-master1 crt]# vim kube-proxy-csr.json

# cat kube-proxy-csr.json

以下文件配置好了,直接复制就可

{"CN": "system:kube-proxy","hosts": [],"key": {"algo": "rsa","size": 2048},"names": [{"C": "CN","L": "BeiJing","ST": "BeiJing","O": "k8s","OU": "System"}]

}[root@k8s-master1 crt]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy

最终生成以下证书文件:

[root@k8s-master1 crt]# ls *pem

ca-key.pem ca.pem kube-proxy-key.pem kube-proxy.pem server-key.pem server.pem

部署apiserver组件—在master节点进行

下载二进制包:https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.11.md

下载这个包(kubernetes-server-linux-amd64.tar.gz)就够了,包含了所需的所有组件。

# wget https://dl.k8s.io/v1.11.10/kubernetes-server-linux-amd64.tar.gz

我用的是安装包

创建目录,解压安装包

创建目录,解压安装包

mkdir /opt/kubernetes/{bin,cfg,ssl} -pv

# tar zxvf kubernetes-server-linux-amd64.tar.gz

# cd kubernetes/server/bin

拷贝文件

cp kube-apiserver kube-scheduler kube-controller-manager kubectl /opt/kubernetes/bin

从生成证书的机器拷贝证书到master1,master2:----由于证书在master1上面生成的,因此这一步不用scp。 重点提示,这一步是你有俩个master,如果你只有一个这一步 省略,省略,省略。

# scp server.pem server-key.pem ca.pem ca-key.pem k8s-master1:/opt/kubernetes/ssl/

# scp server.pem server-key.pem ca.pem ca-key.pem k8s-master2:/opt/kubernetes/ssl/

如下操作:

[root@k8s-master1 bin]# cd /opt/crt/

# cp server.pem server-key.pem ca.pem ca-key.pem /opt/kubernetes/ssl/

创建token文件:

[root@k8s-master1 crt]# cd /opt/kubernetes/cfg/

# vim token.csv

# cat /opt/kubernetes/cfg/token.csv

代码直接复制即可,不用修改

674c457d4dcf2eefe4920d7dbb6b0ddc,kubelet-bootstrap,10001,"system:kubelet-bootstrap"

解释意思

第一列:随机字符串,自己可生成

第二列:用户名

第三列:UID

第四列:用户组

创建apiserver配置文件:重点提示

这个文件不要有任何的空格 以及中文,否则启动报错报错报错报错报错

不要问我为什么,排错一下午

[root@k8s-master1 cfg]# pwd

/opt/kubernetes/cfg

[root@k8s-master1 cfg]# vim kube-apiserver

[root@k8s-master1 cfg]# cat kube-apiserver

源代码,你们只需要修改你们的ip即可

KUBE_APISERVER_OPTS="--logtostderr=true \

--v=4 \

--etcd-servers=https://192.168.246.162:2379,https://192.168.246.164:2379,https://192.168.246.165:2379 \

--bind-address=192.168.246.162 \ #master的ip地址,就是安装api-server的机器地址

--secure-port=6443 \

--advertise-address=192.168.246.162 \

--allow-privileged=true \

--service-cluster-ip-range=10.0.0.0/24 \ #这里就用这个网段切记不要修改

--enable-admission-plugins=NamespaceLifecycle,LimitRanger,ServiceAccount,ResourceQuota,NodeRestriction \

--authorization-mode=RBAC,Node \

--enable-bootstrap-token-auth \

--token-auth-file=/opt/kubernetes/cfg/token.csv \

--service-node-port-range=30000-50000 \

--tls-cert-file=/opt/kubernetes/ssl/server.pem \

--tls-private-key-file=/opt/kubernetes/ssl/server-key.pem \

--client-ca-file=/opt/kubernetes/ssl/ca.pem \

--service-account-key-file=/opt/kubernetes/ssl/ca-key.pem \

--etcd-cafile=/opt/etcd/ssl/ca.pem \

--etcd-certfile=/opt/etcd/ssl/server.pem \

--etcd-keyfile=/opt/etcd/ssl/server-key.pem"

完成截图

配置好前面生成的证书,确保能连接etcd。

参数说明:

* --logtostderr 启用日志

* --v 日志等级

* --etcd-servers etcd集群地址

* --bind-address 监听地址

* --secure-port https安全端口

* --advertise-address 集群通告地址

* --allow-privileged 启用授权

* --service-cluster-ip-range Service虚拟IP地址段

* --enable-admission-plugins 准入控制模块

* --authorization-mode 认证授权,启用RBAC授权和节点自管理

* --enable-bootstrap-token-auth 启用TLS bootstrap功能,后面会讲到

* --token-auth-file token文件

* --service-node-port-range Service Node类型默认分配端口范围

systemd管理apiserver:

[root@k8s-master1 cfg]# cd /usr/lib/systemd/system

# vim kube-apiserver.service

# cat /usr/lib/systemd/system/kube-apiserver.service

下面代码,不用修改,直接复制即可

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-apiserver

ExecStart=/opt/kubernetes/bin/kube-apiserver $KUBE_APISERVER_OPTS

Restart=on-failure[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-apiserver

# systemctl start kube-apiserver

# systemctl status kube-apiserver

完成图

部署schduler组件—master节点

创建schduler配置文件:

[root@k8s-master1 cfg]# vim /opt/kubernetes/cfg/kube-scheduler

# cat /opt/kubernetes/cfg/kube-scheduler

以下配置文件不用修改,复制即可

KUBE_SCHEDULER_OPTS="--logtostderr=true \

--v=4 \

--master=127.0.0.1:8080 \

--leader-elect"

参数说明:

* --master 连接本地apiserver

* --leader-elect 当该组件启动多个时,自动选举(HA)

systemd管理schduler组件:

[root@k8s-master1 cfg]# cd /usr/lib/systemd/system/

# vim kube-scheduler.service

# cat /usr/lib/systemd/system/kube-scheduler.service

以下文件不用修改,直接复制即可

[Unit]

Description=Kubernetes Scheduler

Documentation=https://github.com/kubernetes/kubernetes[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-scheduler

ExecStart=/opt/kubernetes/bin/kube-scheduler $KUBE_SCHEDULER_OPTS

Restart=on-failure[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-scheduler

# systemctl start kube-scheduler

# systemctl status kube-scheduler

查看状态

部署controller-manager组件–控制管理组件

master节点操作:创建controller-manager配置文件:

[root@k8s-master1 ~]# cd /opt/kubernetes/cfg/

[root@k8s-master1 cfg]# vim kube-controller-manager

# cat /opt/kubernetes/cfg/kube-controller-manager

以下配置文件,记得删除中文,不要有任何空格

KUBE_CONTROLLER_MANAGER_OPTS="--logtostderr=true \

--v=4 \

--master=127.0.0.1:8080 \

--leader-elect=true \

--address=127.0.0.1 \

--service-cluster-ip-range=10.0.0.0/24 \ //这是后面dns要使用的虚拟网络,不用改,就用这个 切忌

--cluster-name=kubernetes \

--cluster-signing-cert-file=/opt/kubernetes/ssl/ca.pem \

--cluster-signing-key-file=/opt/kubernetes/ssl/ca-key.pem \

--root-ca-file=/opt/kubernetes/ssl/ca.pem \

--service-account-private-key-file=/opt/kubernetes/ssl/ca-key.pem"

systemd管理controller-manager组件:

[root@k8s-master1 cfg]# cd /usr/lib/systemd/system/

[root@k8s-master1 system]# vim kube-controller-manager.service

# cat /usr/lib/systemd/system/kube-controller-manager.service

下面文件不用修改,复制即可

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/kubernetes/kubernetes[Service]

EnvironmentFile=-/opt/kubernetes/cfg/kube-controller-manager

ExecStart=/opt/kubernetes/bin/kube-controller-manager $KUBE_CONTROLLER_MANAGER_OPTS

Restart=on-failure[Install]

WantedBy=multi-user.target

启动:

# systemctl daemon-reload

# systemctl enable kube-controller-manager

# systemctl start kube-controller-manager

# systemctl status kube-controller-manager

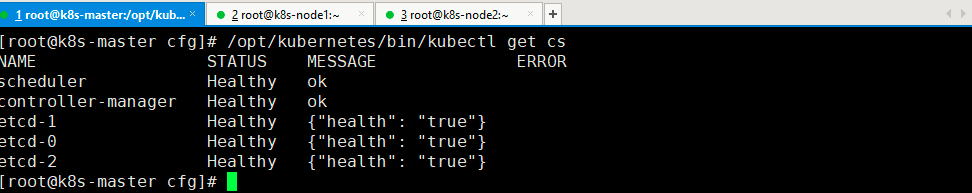

所有组件都已经启动成功,通过kubectl工具查看当前集群组件状态:

[root@k8s-master1 ~]# /opt/kubernetes/bin/kubectl get cs

NAME STATUS MESSAGE ERROR

scheduler Healthy ok

controller-manager Healthy ok

etcd-2 Healthy {"health": "true"}

etcd-0 Healthy {"health": "true"}

etcd-1 Healthy {"health": "true"}

如上输出说明组件都正常。

如上输出说明组件都正常。

配置Master负载均衡 这里讲一下,可以不用布置,不重要

所谓的Master HA,其实就是APIServer的HA,Master的其他组件controller-manager、scheduler都是可以通过etcd做选举(–leader-elect),而APIServer设计的就是可扩展性,所以做到APIServer很容易,只要前面加一个负载均衡轮询转发请求即可。

在私有云平台添加一个内网四层LB,不对外提供服务,只做apiserver负载均衡,配置如下:

其他公有云LB配置大同小异,只要理解了数据流程就好配置了。

其他公有云LB配置大同小异,只要理解了数据流程就好配置了。

k8s还没有部署完毕,还有最后一篇 ,加油 你是最棒的

这篇关于决战k8s,Kubernetes、Master节点部署组件,部署apiserver组件、部署schduler组件、部署controller-manager组件、超细详解 ,安装篇②的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!