本文主要是介绍【爬虫基础】第6讲 opener的使用,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在爬虫中,opener是一个用来发送HTTP请求的对象。它可以用来模拟浏览器发送请求,包括设置请求头、处理Cookie等操作。使用opener可以实现一些高级功能,如模拟登录、处理验证码等。

方法1:

from urllib.request import Request,build_opener

from fake_useragent import UserAgenturl ='http://httpbin.org/get'

headers ={'User-Agent':UserAgent().chrome

}

req = Request(url,headers=headers)

opener = build_opener()

resp = opener.open(req)

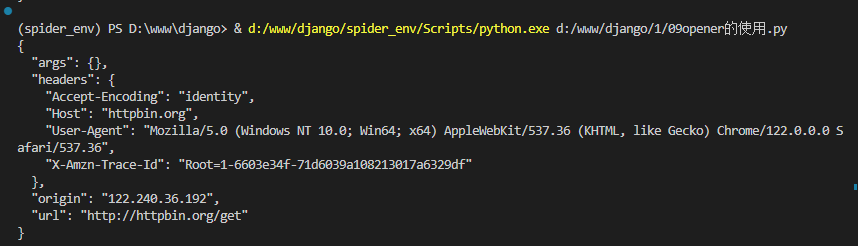

print(resp.read().decode())执行结果:

方法2:使用控制器

from urllib.request import Request,build_opener

from fake_useragent import UserAgent

from urllib.request import HTTPHandlerurl ='http://httpbin.org/get'

headers ={'User-Agent':UserAgent().chrome

}

req = Request(url,headers=headers)

handler = HTTPHandler(debuglevel=1)

opener = build_opener(handler)

resp = opener.open(req)

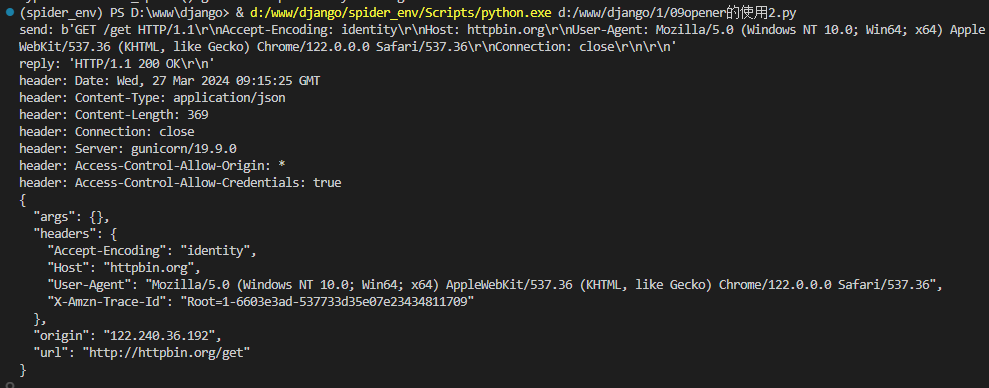

print(resp.read().decode())执行结果:

对比方法1和方法2,方法2明显输出内容更多更详细。

需要注意的是,opener对象默认会自动处理重定向和Cookie等操作,所以无需手动处理。如果需要手动处理重定向,可以使用

urllib.request.install_opener(opener)来安装opener对象。

这篇关于【爬虫基础】第6讲 opener的使用的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!