本文主要是介绍t-rex2开放集目标检测,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文链接:http://arxiv.org/abs/2403.14610v1

项目链接:https://github.com/IDEA-Research/T-Rex

这篇文章的工作是基于t-rex1的工作继续做的,核心亮点:

- 是支持图片/文本两种模态的prompt进行输入,甚至进一步利用两种模态的组合来达到检测和检索的目的,比如文本检索目标、以图搜图或者两个组合的方式

- 还有一个非常关键的地方,t-rex2开放了一个负样本抑制的方法,这个极大的缓解了开集目标检测器中使用clip作为head导致的分类器出问题从而有大量误检的情况

可以作为zero-shot的检测器或者一些快速数据集生成的data-engine方式

1、核心框架

text-cv的双模态通用框架还是同时对文本和图像做编码,如文中所说,text依旧使用clip做文本编码,图像上用的是deformable detr(DETR的升级版本),将单/多个图像转换为视觉embedding,然后进一步的利用了一个文本\图像对齐的模块来显示对齐,因此网络能够从文本和图像中互相学习到对方的feature,然后持续地提高相互的能力,该方法适用于4(3)种工作流:

- 交互式视觉prompt,类似于SAM,可以理解为框选一个目标后找到同一类目标(跨多个图像来框选也可以)

- 文本prompt,类似于clip或者glip/groundingdino的输入方式

- 混合prompt输入,结合文本和图像一起做inference

t-rex2模型框架:

如上图框架所示,一句话总结流程,分别对视觉和文本做特征提取, 视觉上结合backbone做视觉编码、输入prompt做位置编码、初始化向量concat(全局注意力+特征聚合)、交叉注意力得到最终的特征提取,然后结合DINO系系列的box预测方式得到各个roi的坐标,利用clip的方式预测出label(训练和完整的inference代码似乎没有开源出来,只能看论文上的工作去猜了,源码更新后再把本文完善下);

框架支持同时对visual和text prompts进行encoder:

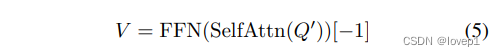

对于visual prompt,对于给定的归一化的坐标或者box位置4维坐标,文中提到继承于DETR依旧使用正余弦编码将其编码为位置embedding,然后使用一个线性层将其进行变换(物理意义上可能是一次特征提取?),其中B代表box的prompt,P代表point的prompt,如下图中的1式和2式所示,进一步地,此时文中初始化了一个可学习的embedding(这里特别像DETR系列后续的工作,初始化一个embedding作为类似于anchor或者其他作用)C并广播到K维度,C`是来自其他所有视觉输入的一个聚合向量,然后将C+C`的值相加后然后与第一步提取的位置向量进行通道上的concat(我听下来理解这段是将C广播得到C`,然后将B全局提取得到B`,然后做concat,具体还得看代码理解下),paper写的太复杂了,最后使用交叉注意力后在各个FPN层的特征中得到query,从框架上可以看到这些query物理意义上应该是自注意力到各个层关注的roi部分,然后如5式做自注意力的特征提取,这样保证提取出来的query应该是结合视觉prompt得到的(在前向做inference时是不是会因为不同的输入promp导致每一次inference的特征不一样)

对于text prompt,使用clip将其进行编码,此处略过,文章也没提,有兴趣的同学直接参照clip进行理解就好了;

BOX解码器:最后就是box解码器了,参照DINO以及他们实验室的工作,将传统检测的anchor作为query初始化,然后与grounding-dino一样是直接预测出各层目标的x、y、w、h,将解码器预测出的值得到Qdec,得到最后的box坐标:

类别估计就是使用clip的方式做predict了,毕竟开集检测应该都是这个套路(晚点还得看看代码确认下)

文中提到了对每一个视觉目标和文本目标做对齐,类似于一个相互蒸馏的过程:

训练过程(损失函数):

损失函数分为5部分,对于框,使用L1+GIOU作为损失函数,对于分类,使用clip的logits和直接提取的logits计算相似性,还有一个是align对齐,L-DINO应该是文中提及的DINO中的加入噪声训练的部分,文中这里有一个细节,就是使用DETCLIP的方式,对于图片正样本边界以外的数据,随机进行负样本采集,这应该是一种很好的负样本抑制策略

输入的处理:

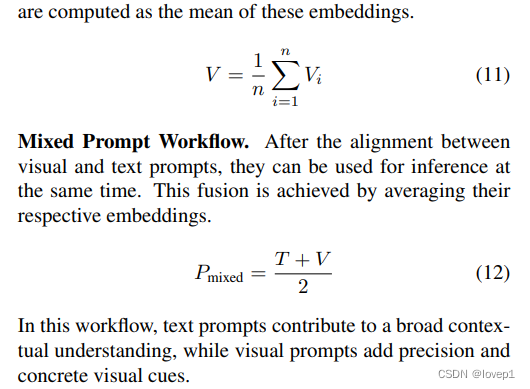

如果是多个输入,则对其求均值,如果结合文本,则是(视觉+文本)/2就可以了:

2、其他细节

训练集的维护:当前各种多模态模型的关键是数据集如何从各种乱七八糟来源上获取,本文也提到了,还未看,略过

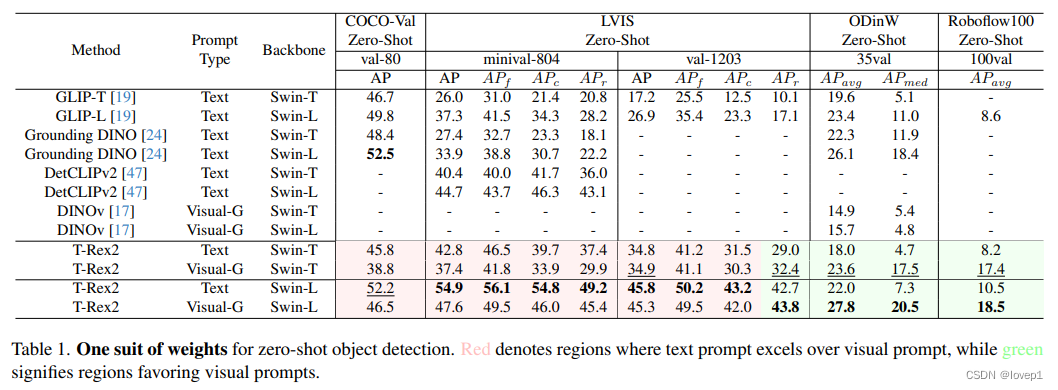

结果对标:

其他细节进一步读paper再来改正和补充

这篇关于t-rex2开放集目标检测的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[数据集][目标检测]血细胞检测数据集VOC+YOLO格式2757张4类别](https://i-blog.csdnimg.cn/direct/22c867ab717d44c78b985ed667169b42.png)