转自:https://www.zhihu.com/question/25097993

我和@杨军类似, 也是半路出家. 现在的工作内容主要就是使用CNN做CV任务. 干调参这种活也有两年时间了. 我的回答可能更多的还是侧重工业应用, 技术上只限制在CNN这块.

先说下我的观点, 调参就是trial-and-error. 没有其他捷径可以走. 唯一的区别是有些人盲目的尝试, 有些人思考后再尝试. 快速尝试, 快速纠错这是调参的关键.

看了杨军的回答. 对于这个回答, 下面的评论里面

@纪秋佳

说的很对. 这个回答主要内容更多的是侧重理解网络. 而非训练网络.

我要再强调下, 杨军的回答更多的涉及是理解网络而非训练网络. 是的, 没错. 你看完回答中的所有内容, 对不起, 你还是不知道怎么实际训练一个网络, 尤其是复杂任务下的网络(因为简单任务根本不需要, 直接上来效果就会很好, 除非你要刷简单任务的排行榜).

- 首先说下可视化:

我个人的理解, 对于可视化, 更多的还是帮助人类以自己熟悉的方式来观察网络. 因为, 你是不可能边观察网络, 还边调参的. 你只是训练完成后(或者准确率到达一个阶段后), 才能可视化. 在这之前, 网络没有学习到良好的参数, 你可视化了也没意义, 网络达到不错的准确率了, 你看看其实也就听个响. 同样, 你的网络训练的一塌糊涂, 你可视化也没什么意义, 唯一能够看到的就是中间结果乱七八糟, 或者全黑全白, 这时候你直接看最后准确率就可以知道这网络没救了.

- 关于权重的可视化[Visualize Layer Weights](现在是否强求smooth其实意义不大, 这个后面说.):

同样, 你看到一个不满足平滑结果的图像, 你知道, 这网络训练的不好, 但是为什么呢? 是数据不好? 没有预处理? 网络结构问题? Learning Rate太大或者太小? 或者就是差了一个LRN层(之前我就遇到, 加个LRN就能出smooth的weights, 当然这其实和预处理有关)?

Smooth是需要看一下的, 心里有个数. 但是具体调参怎么调是没辙的. 第一, 你不可能告诉网络, 这层你得学个边界检测的功能出来. 第二, 不同任务下会有不同的weights(虽然底层的特征有很大的通用性), 你觉得你凭什么来指导一个看图片比你快得多的机器?

再说现在是否需要强求smooth. 现在的趋势是鼓励使用小filter, 3x3大小, 多加层次(这样, 非线性更好点). 换句话说, 3x3的图片, 总共才9个像素, 你怎么判断smooth与否呢? 当然如果你使用大的filter, 一般5x5往上, 运气不差的话, 你是可以看到smooth的结果的.

咱们再说另外一个极端, 一个网络,运行的完美(满足应用要求就算完美), 打开一看, 这weights不smooth啊. 你告诉我, 你打算怎么办? 没错, 具有不平滑的权重的网络同样可以获得很好的结果(这种情况我都习以为常了).

- 那么可视化网络就不重要了?

非常重要, 但是不在训练这块, 而是帮助理解网络的原理这块. 理解网络原理后, 你才能在设计结构的时候心里有感觉(只是有感觉而已), 网络出了问题, 或者在某些情况下不满意, 有更好的直觉去调整.(没错, 只是直觉, 虽然有些情况下的调整从网络原理来看逻辑上应该可以工作, 但是人家就是不工作, 你能咬机器去么?)

- 那么怎样训练一个不错的网络呢?

这是一个很好的链接, 说明了如何从零开始不断的trial-and-error(其实这里面没遇到什么error):

Using convolutional neural nets to detect facial keypoints tutorial

========================================================

我自己的经验, 有下面这些:

基本原则:

快速试错

一些大的注意事项:

1. 刚开始, 先上小规模数据, 模型往大了放, 只要不爆显存, 能用256个filter你就别用128个. 直接奔着过拟合去. 没错, 就是训练过拟合网络, 连测试集验证集这些都可以不用.

为什么?

+ 你要验证自己的训练脚本的流程对不对. 这一步小数据量, 生成速度快, 但是所有的脚本都是和未来大规模训练一致的(除了少跑点循环)

+ 如果小数据量下, 你这么粗暴的大网络奔着过拟合去都没效果. 那么, 你要开始反思自己了, 模型的输入输出是不是有问题? 要不要检查自己的代码(永远不要怀疑工具库, 除非你动过代码)? 模型解决的问题定义是不是有问题? 你对应用场景的理解是不是有错? 不要怀疑NN的能力, 不要怀疑NN的能力, 不要怀疑NN的能力. 就我们调参狗能遇到的问题, NN没法拟合的, 这概率是有多小?

+ 你可以不这么做, 但是等你数据准备了两天, 结果发现有问题要重新生成的时候, 你这周时间就酱油了.

2. Loss设计要合理.

+ 一般来说分类就是Softmax, 回归就是L2的loss. 但是要注意loss的错误范围(主要是回归), 你预测一个label是10000的值, 模型输出0, 你算算这loss多大, 这还是单变量的情况下. 一般结果都是nan. 所以不仅仅输入要做normalization, 输出也要这么弄.

+ 多任务情况下, 各loss想法限制在一个量级上, 或者最终限制在一个量级上, 初期可以着重一个任务的loss

3. 观察loss胜于观察准确率

准确率虽然是评测指标, 但是训练过程中还是要注意loss的. 你会发现有些情况下, 准确率是突变的, 原来一直是0, 可能保持上千迭代, 然后突然变1. 要是因为这个你提前中断训练了, 只有老天替你惋惜了. 而loss是不会有这么诡异的情况发生的, 毕竟优化目标是loss.

给NN一点时间, 要根据任务留给NN的学习一定空间. 不能说前面一段时间没起色就不管了. 有些情况下就是前面一段时间看不出起色, 然后开始稳定学习.

4. 确认分类网络学习充分

分类网络就是学习类别之间的界限. 你会发现, 网络就是慢慢的从类别模糊到类别清晰的. 怎么发现? 看Softmax输出的概率的分布. 如果是二分类, 你会发现, 刚开始的网络预测都是在0.5上下, 很模糊. 随着学习过程, 网络预测会慢慢的移动到0,1这种极值附近. 所以, 如果你的网络预测分布靠中间, 再学习学习.

5. Learning Rate设置合理

+ 太大: loss爆炸, 或者nan

+ 太小: 半天loss没反映(但是, LR需要降低的情况也是这样, 这里可视化网络中间结果, 不是weights, 有效果, 俩者可视化结果是不一样的, 太小的话中间结果有点水波纹或者噪点的样子, 因为filter学习太慢的原因, 试过就会知道很明显)

+ 需要进一步降低了: loss在当前LR下一路降了下来, 但是半天不再降了.

+ 如果有个复杂点的任务, 刚开始, 是需要人肉盯着调LR的. 后面熟悉这个任务网络学习的特性后, 可以扔一边跑去了.

+ 如果上面的Loss设计那块你没法合理, 初始情况下容易爆, 先上一个小LR保证不爆, 等loss降下来了, 再慢慢升LR, 之后当然还会慢慢再降LR, 虽然这很蛋疼.

+ LR在可以工作的最大值下往小收一收, 免得ReLU把神经元弄死了. 当然, 我是个心急的人, 总爱设个大点的.

6 对比训练集和验证集的loss

判断过拟合, 训练是否足够, 是否需要early stop的依据, 这都是中规中矩的原则, 不多说了.

7 清楚receptive field的大小

CV的任务, context window是很重要的. 所以你对自己模型的receptive field的大小要心中有数. 这个对效果的影响还是很显著的. 特别是用FCN, 大目标需要很大的receptive field. 不像有fully connection的网络, 好歹有个fc兜底, 全局信息都有.

简短的注意事项:

- 预处理: -mean/std zero-center就够了, PCA, 白化什么的都用不上. 我个人观点, 反正CNN能学习encoder, PCA用不用其实关系不大, 大不了网络里面自己学习出来一个.

- shuffle, shuffle, shuffle.

- 网络原理的理解最重要, CNN的conv这块, 你得明白sobel算子的边界检测.

- Dropout, Dropout, Dropout(不仅仅可以防止过拟合, 其实这相当于做人力成本最低的Ensemble, 当然, 训练起来会比没有Dropout的要慢一点, 同时网络参数你最好相应加一点, 对, 这会再慢一点).

- CNN更加适合训练回答是否的问题, 如果任务比较复杂, 考虑先用分类任务训练一个模型再finetune.

- 无脑用ReLU(CV领域).

- 无脑用3x3.

- 无脑用xavier.

- LRN一类的, 其实可以不用. 不行可以再拿来试试看.

- filter数量2^n.

- 多尺度的图片输入(或者网络内部利用多尺度下的结果)有很好的提升效果.

- 第一层的filter, 数量不要太少. 否则根本学不出来(底层特征很重要).

- sgd adam 这些选择上, 看你个人选择. 一般对网络不是决定性的. 反正我无脑用sgd + momentum.

- batch normalization我一直没用, 虽然我知道这个很好, 我不用仅仅是因为我懒. 所以要鼓励使用batch normalization.

- 不要完全相信论文里面的东西. 结构什么的觉得可能有效果, 可以拿去试试.

- 你有95%概率不会使用超过40层的模型.

- shortcut的联接是有作用的.

- 暴力调参最可取, 毕竟, 自己的生命最重要. 你调完这个模型说不定过两天这模型就扔掉了.

- 机器, 机器, 机器.

- Google的inception论文, 结构要好好看看.

- 一些传统的方法, 要稍微了解了解. 我自己的程序就用过1x14的手写filter, 写过之后你看看inception里面的1x7, 7x1 就会会心一笑..

来源:https://www.zhihu.com/question/25097993/answer/161393876

趁着模型正在跑,我来强答一发。

我只对卷积网络有一点点了解,所以接下来谈的都是和卷积网络相关的内容。

调参请在验证集上!调参请在验证集上!调参请在验证集上!

首先我们假设我们手上有一个正确的,没有bug,可以训练的模型,以及预先设立的误差目标。那么分三种情况:

1、模型表现非常好,在训练集和验证集上都满足我们的目标。那不用调了。

2、模型在训练集上的误差很小,且各种(softmax 等等) loss 能减小到一个很小的值(对于我自己而言小于0.01),但是验证集的 loss 相对较大(对我的问题而言,一般会在0.3~0.6)。那就是过拟合了。

3、在训练集和验证集上的loss都比较大,都大于0.3,那可能就是欠拟合了。

——————————————————————————————————————————

模型的训练是在拟合训练集的规律,模型的使用却是将规律作用于测试集。那么我们假设训练集和测试集所包含的规律是大方向相同的,小细节存在差异的。

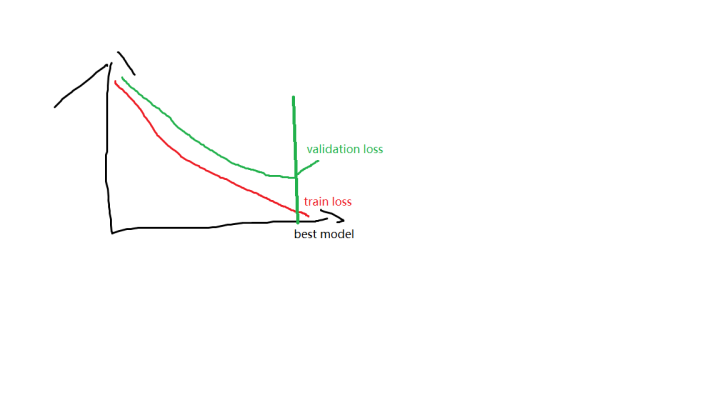

如果一个模型在训练集上一直一直训练下去,那么它会很好的拟合训练集所有的大方向规律和小细节规律,过拟合就是必然的了。因为训练的目标是将训练集 loss 降到 0。理想的训练过程如图:

我们假设模型在验证集的表现由两部分组成:1、对训练集规律的掌握(主要指标 trainset loss),2、学习结果对训练集的适应程度(主要指标 validation set loss)。如上图所示,调参的本质就是要找到那个best model 平衡点。

——————————————————————————————————————————

出现上述情况该调什么?调试hyperparameters 的先后顺序是什么?

1、优先调 learning rate!优先调 learning rate!优先调 learning rate!

学习速率会很大程度上影响模型的表现。同样的模型采用不同的learning rate 可能会表现迥异。所以凭感觉建好一个模型后如果对表现不满意应该优先调学习速率。我前段时间在知乎上看一个哥们说学习速率可以有解析解,希望他早日成功拯救我脱离调学习速率的苦海。模型具有理论容量和有效容量两种能力指标,理论容量是由卷积核数量,模型深度等决定的。但是有效容量会受学习速率影响。

2、加 Dropout, 加 BN, 加Data Argument

一般而言,在设计模型之初我们都信奉大力出奇迹。模型尽量深,卷积核尽量多,强行让模型拟合训练集。这时容易遇到的问题就是过拟合。解决过拟合的第一要素是模型的正则化,最有效方法是加大训练数据集。如果有钱任性,那请多标记数据。如果没钱要认命(比如我),那就给训练数据加增强,什么图像裁剪,对称变换,旋转平移,都可以让模型在验证集上的表现更好。此外,增加常用的正则化也可以提升模型的表现。

3、调模型的层数和卷积核数量

走到这一步的时候都是迫不得已了。这两个参数都是对模型理论容量具有巨大影响的参数,一旦调整了之后所有东西都要重新调。增大模型的层数和卷积核的数量都会提升模型的容量。不同的是,增大模型层数(让模型变高)可以让模型获得更好的非线性,模型容量指数增加,缺点是加大层数会让模型更难训练,面临梯度消失的风险,引入死单元。增加卷积核(让模型变胖)可以在不引入训练困难的情况下让模型更好的拟合训练集,也就是降低 training loss,但是会更容易过拟合。

总之,理想情况下表现优越的模型一般长的高高瘦瘦(深,每层卷积核不多),但是为了便于我们训练,有时候不得不让他更矮壮一些。模型的调参除了学习速率和正则化这些比较耗时的工作外,还需要一些灵感,来确定模型的身材。

来源:https://www.zhihu.com/question/25097993/answer/37525469

感觉除了层数和每层隐节点的个数,也没啥好调的。其它参数,近两年论文基本都用同样的参数设定:迭代几十到几百epoch。sgd,mini batch size从几十到几百皆可。步长0.1,可手动收缩,weight decay取0.005,momentum取0.9。dropout加relu。weight用高斯分布初始化,bias全初始化为0。最后记得输入特征和预测目标都做好归一化。做完这些你的神经网络就应该跑出基本靠谱的结果,否则反省一下自己的人品。

转自:https://mp.weixin.qq.com/s?__biz=MzU0NTAyNTQ1OQ==&mid=2247484020&idx=3&sn=6882d32290f44d15cb353ea92849356b&chksm=fb727ea8cc05f7be022025b20d6e8e71170eb5eb1ce383d526aabe8b92a759fd426e9cd114b3#rd

今天给大家讲讲DNN(深度神经网络)在训练过程中遇到的一些问题,然后我们应该怎么去注意它,并学会怎么去训练它。

1、数据集的准备:

必须要保证大量、高质量且带有准确标签的数据,没有该条件的数据,训练学习很困难的(但是最近我看了以为作者写的一篇文章,说明不一定需要大量数据集,也可以训练的很好,有空和大家来分享其思想---很厉害的想法);

2、数据预处理:

这个不多说,就是0均值和1方差化,其实还有很多方法;

3、Minibatch:

这个有时候还要根据你的硬件设备而定,一般建议用128,8这组,但是128,1也很好,只是效率会非常慢,注意的是:千万不要用过大的数值,否则很容易过拟合;

4、梯度归一化:

其实就是计算出来梯度之后,要除以Minibatch的数量,这个可以通过阅读源码得知(我之前有写过SGD);

5、学习率:

① 一般都会有默认的学习率,但是刚开始还是用一般的去学习,然后逐渐的减小它;

② 一个建议值是0.1,适用于很多NN的问题,一般倾向于小一点;但是如果对于的大数据,何凯明老师也说过,要把学习率调到很小,他说0.00001都不为过(如果记得不错,应该是这么说的);

③ 一个对于调度学习率的建议:如果在验证集上性能不再增加就让学习率除以2或者5,然后继续,学习率会一直变得很小,到最后就可以停止训练了;

④ 很多人用的一个设计学习率的原则就是监测一个比率(每次更新梯度的norm除以当前weight的norm),如果这个比率在10e-3附近,且小于这个值,学习会很慢,如果大于这个值,那么学习很不稳定,由此会带来学习失败。

6、验证集的使用:

使用验证集,可以知道什么时候开始降低学习率和什么时候停止训练;

7、weight初始化:

① 如果你不想繁琐的话,直接用0.02*randn(num_params)来初始化,当然别的值也可以去尝试;

② 如果上面那个建议不太好使,那么就依次初始化每一个weight矩阵用init_scale / sqrt(layer_width) * randn,init_scale可以被设置为0.1或者1;

③ 初始化参数对结果的影响至关重要,要引起重视;

④ 在深度网络中,随机初始化权重,使用SGD的话一般处理的都不好,这是因为初始化的权重太小了。这种情况下对于浅层网络有效,但是当足够深的时候就不行,因为weight更新的时候,是靠很多weight相乘的,越乘越小,类似梯度消失的意思。

8、RNN&&LSTM(这方面没有深入了解,借用别人的意思):

如果训练RNN或者LSTM,务必保证gradient的norm被约束在15或者5(前提还是要先归一化gradient),这一点在RNN和LSTM中很重要;

9、梯度检查:

检查下梯度,如果是你自己计算的梯度;如果使用LSTM来解决长时依赖的问题,记得初始化bias的时候要大一点;

10、数据增广:

尽可能想办法多的扩增训练数据,如果使用的是图像数据,不妨对图像做一点扭转,剪切,分割等操作来扩充数据训练集合;

11、dropout:(先空着,下次我要单独详细讲解Dropout)

12、评价结果:

评价最终结果的时候,多做几次,然后平均一下他们的结果。

补充:

1、选择优化算法

传统的随机梯度下降算法虽然适用很广,但并不高效,最近出现很多更灵活的优化算法,例如Adagrad、RMSProp等,可在迭代优化的过程中自适应的调节学习速率等超参数,效果更佳;

2、参数设置技巧

无论是多核CPU还是GPU加速,内存管理仍然以字节为基本单元做硬件优化,因此将参数设定为2的指数倍,如64,128,512,1024等,将有效提高矩阵分片、张量计算等操作的硬件处理效率;

3、正则优化

除了在神经网络单元上添加传统的L1/L2正则项外,Dropout更经常在深度神经网络应用来避免模型的过拟合。初始默认的0.5的丢弃率是保守的选择,如果模型不是很复杂,设置为0.2就可以;

4、其他方法

除了上述训练调优的方法外,还有其他一些常用方法,包括:使用mini-batch learning方法、迁移训练学习、打乱训练集顺序、对比训练误差和测试误差调节迭代次数、日志可视化观察等等。

转载请注明:炼丹实验室

之前曾经写过一篇文章,讲了一些深度学习训练的技巧,其中包含了部分调参心得:深度学习训练心得。不过由于一般深度学习实验,相比普通机器学习任务,时间较长,因此调参技巧就显得尤为重要。同时个人实践中,又有一些新的调参心得,因此这里单独写一篇文章,谈一下自己对深度学习调参的理解,大家如果有其他技巧,也欢迎多多交流。

好的实验环境是成功的一半

由于深度学习实验超参众多,代码风格良好的实验环境,可以让你的人工或者自动调参更加省力,有以下几点可能需要注意:

- 将各个参数的设置部分集中在一起。如果参数的设置分布在代码的各个地方,那么修改的过程想必会非常痛苦。

- 可以输出模型的损失函数值以及训练集和验证集上的准确率。

- 可以考虑设计一个子程序,可以根据给定的参数,启动训练并监控和周期性保存评估结果。再由一个主程序,分配参数以及并行启动一系列子程序。

画图

画图是一个很好的习惯,一般是训练数据遍历一轮以后,就输出一下训练集和验证集准确率。同时画到一张图上。这样训练一段时间以后,如果模型一直没有收敛,那么就可以停止训练,尝试其他参数了,以节省时间。

如果训练到最后,训练集,测试集准确率都很低,那么说明模型有可能欠拟合。那么后续调节参数方向,就是增强模型的拟合能力。例如增加网络层数,增加节点数,减少dropout值,减少L2正则值等等。

如果训练集准确率较高,测试集准确率比较低,那么模型有可能过拟合,这个时候就需要向提高模型泛化能力的方向,调节参数。

从粗到细分阶段调参

实践中,一般先进行初步范围搜索,然后根据好结果出现的地方,再缩小范围进行更精细的搜索。

- 建议先参考相关论文,以论文中给出的参数作为初始参数。至少论文中的参数,是个不差的结果。

- 如果找不到参考,那么只能自己尝试了。可以先从比较重要,对实验结果影响比较大的参数开始,同时固定其他参数,得到一个差不多的结果以后,在这个结果的基础上,再调其他参数。例如学习率一般就比正则值,dropout值重要的话,学习率设置的不合适,不仅结果可能变差,模型甚至会无法收敛。

- 如果实在找不到一组参数,可以让模型收敛。那么就需要检查,是不是其他地方出了问题,例如模型实现,数据等等。可以参考我写的深度学习网络调试技巧

提高速度

调参只是为了寻找合适的参数,而不是产出最终模型。一般在小数据集上合适的参数,在大数据集上效果也不会太差。因此可以尝试对数据进行精简,以提高速度,在有限的时间内可以尝试更多参数。

- 对训练数据进行采样。例如原来100W条数据,先采样成1W,进行实验看看。

- 减少训练类别。例如手写数字识别任务,原来是10个类别,那么我们可以先在2个类别上训练,看看结果如何。

超参数范围

建议优先在对数尺度上进行超参数搜索。比较典型的是学习率和正则化项,我们可以从诸如0.001 0.01 0.1 1 10,以10为阶数进行尝试。因为他们对训练的影响是相乘的效果。不过有些参数,还是建议在原始尺度上进行搜索,例如dropout值: 0.3 0.5 0.7)。

经验参数

这里给出一些参数的经验值,避免大家调参的时候,毫无头绪。

- learning rate: 1 0.1 0.01 0.001, 一般从1开始尝试。很少见learning rate大于10的。学习率一般要随着训练进行衰减。衰减系数一般是0.5。 衰减时机,可以是验证集准确率不再上升时,或固定训练多少个周期以后。

不过更建议使用自适应梯度的办法,例如adam,adadelta,rmsprop等,这些一般使用相关论文提供的默认值即可,可以避免再费劲调节学习率。对RNN来说,有个经验,如果RNN要处理的序列比较长,或者RNN层数比较多,那么learning rate一般小一些比较好,否则有可能出现结果不收敛,甚至Nan等问题。 - 网络层数: 先从1层开始。

- 每层结点数: 16 32 128,超过1000的情况比较少见。超过1W的从来没有见过。

- batch size: 128上下开始。batch size值增加,的确能提高训练速度。但是有可能收敛结果变差。如果显存大小允许,可以考虑从一个比较大的值开始尝试。因为batch size太大,一般不会对结果有太大的影响,而batch size太小的话,结果有可能很差。

- clip c(梯度裁剪): 限制最大梯度,其实是value = sqrt(w1^2+w2^2….),如果value超过了阈值,就算一个衰减系系数,让value的值等于阈值: 5,10,15

- dropout: 0.5

- L2正则:1.0,超过10的很少见。

- 词向量embedding大小:128,256

- 正负样本比例: 这个是非常忽视,但是在很多分类问题上,又非常重要的参数。很多人往往习惯使用训练数据中默认的正负类别比例,当训练数据非常不平衡的时候,模型很有可能会偏向数目较大的类别,从而影响最终训练结果。除了尝试训练数据默认的正负类别比例之外,建议对数目较小的样本做过采样,例如进行复制。提高他们的比例,看看效果如何,这个对多分类问题同样适用。

在使用mini-batch方法进行训练的时候,尽量让一个batch内,各类别的比例平衡,这个在图像识别等多分类任务上非常重要。

自动调参

人工一直盯着实验,毕竟太累。自动调参当前也有不少研究。下面介绍几种比较实用的办法:

- Gird Search. 这个是最常见的。具体说,就是每种参数确定好几个要尝试的值,然后像一个网格一样,把所有参数值的组合遍历一下。优点是实现简单暴力,如果能全部遍历的话,结果比较可靠。缺点是太费时间了,特别像神经网络,一般尝试不了太多的参数组合。

- Random Search。Bengio在Random Search for Hyper-Parameter Optimization中指出,Random Search比Gird Search更有效。实际操作的时候,一般也是先用Gird Search的方法,得到所有候选参数,然后每次从中随机选择进行训练。

- Bayesian Optimization. 贝叶斯优化,考虑到了不同参数对应的实验结果值,因此更节省时间。和网络搜索相比简直就是老牛和跑车的区别。具体原理可以参考这个论文: Practical Bayesian Optimization of Machine Learning Algorithms ,这里同时推荐两个实现了贝叶斯调参的Python库,可以上手即用:

- jaberg/hyperopt, 比较简单。

- fmfn/BayesianOptimization, 比较复杂,支持并行调参。

总结

- 合理性检查,确定模型,数据和其他地方没有问题。

- 训练时跟踪损失函数值,训练集和验证集准确率。

- 使用Random Search来搜索最优超参数,分阶段从粗(较大超参数范围训练较少周期)到细(较小超参数范围训练较长周期)进行搜索。

神经网络的代码,比一般的代码要难调试不少,和编译错误以及运行时程序崩溃相比,神经网络比较棘手的地方,往往在于程序运行正常,但是结果无法收敛,这个检查起来可要麻烦多了。下面是根据我平时调试神经网络的经验,总结的一些比较通用的调试技巧,后续会再写一篇文章,专门介绍一下theano如何进行调试,希望能对大家调试神经网络有所帮助。

遇到Nan怎么办?

Nan问题,我相信大部分人都遇到过,一般可能是下面几个原因造成的:

- 除0问题。这里实际上有两种可能,一种是被除数的值是无穷大,即Nan,另一种就是除数的值是0。之前产生的Nan或者0,有可能会被传递下去,造成后面都是Nan。请先检查一下神经网络中有可能会有除法的地方,例如softmax层,再认真的检查一下数据。我有一次帮别人调试代码,甚至还遇到过,训练数据文件中,有些值就是Nan。。。这样读进来以后,开始训练,只要遇到Nan的数据,后面也就Nan了。可以尝试加一些日志,把神经网络的中间结果输出出来,看看哪一步开始出现Nan。后面会介绍Theano的处理办法。

- 梯度过大,造成更新后的值为Nan。特别是RNN,在序列比较长的时候,很容易出现梯度爆炸的问题。一般有以下几个解决办法。

- 对梯度做clip(梯度裁剪),限制最大梯度,其实是value = sqrt(w1^2+w2^2….),如果value超过了阈值,就算一个衰减系系数,让value的值等于阈值: 5,10,15。

- 减少学习率。初始学习率过大,也有可能造成这个问题。需要注意的是,即使使用adam之类的自适应学习率算法进行训练,也有可能遇到学习率过大问题,而这类算法,一般也有一个学习率的超参,可以把这个参数改的小一些。

- 初始参数值过大,也有可能出现Nan问题。输入和输出的值,最好也做一下归一化。具体方法可以参考我之前的一篇文章:深度学习个人炼丹心得 - 炼丹实验室 - 知乎专栏

神经网络学不出东西怎么办?

可能我们并没有遇到,或者解决了Nan等问题,网络一直在正常的训练,但是cost降不下来,预测的时候,结果不正常。

- 请打印出训练集的cost值和测试集上cost值的变化趋势,正常情况应该是训练集的cost值不断下降,最后趋于平缓,或者小范围震荡,测试集的cost值先下降,然后开始震荡或者慢慢上升。如果训练集cost值不下降,有可能是代码有bug,有可能是数据有问题(本身有问题,数据处理有问题等等),有可能是超参(网络大小,层数,学习率等)设置的不合理。

请人工构造10条数据,用神经网络反复训练,看看cost是否下降,如果还不下降,那么可能网络的代码有bug,需要认真检查了。如果cost值下降,在这10条数据上做预测,看看结果是不是符合预期。那么很大可能网络本身是正常的。那么可以试着检查一下超参和数据是不是有问题。 - 如果神经网络代码,全部是自己实现的,那么强烈建议做梯度检查。确保梯度计算没有错误。

- 先从最简单的网络开始实验,不要仅仅看cost值,还要看一看神经网络的预测输出是什么样子,确保能跑出预期结果。例如做语言模型实验的时候,先用一层RNN,如果一层RNN正常,再尝试LSTM,再进一步尝试多层LSTM。

- 如果可能的话,可以输入一条指定数据,然后自己计算出每一步正确的输出结果,再检查一下神经网络每一步的结果,是不是一样的。