本文主要是介绍Google研究者们提出了VLOGGER模型,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

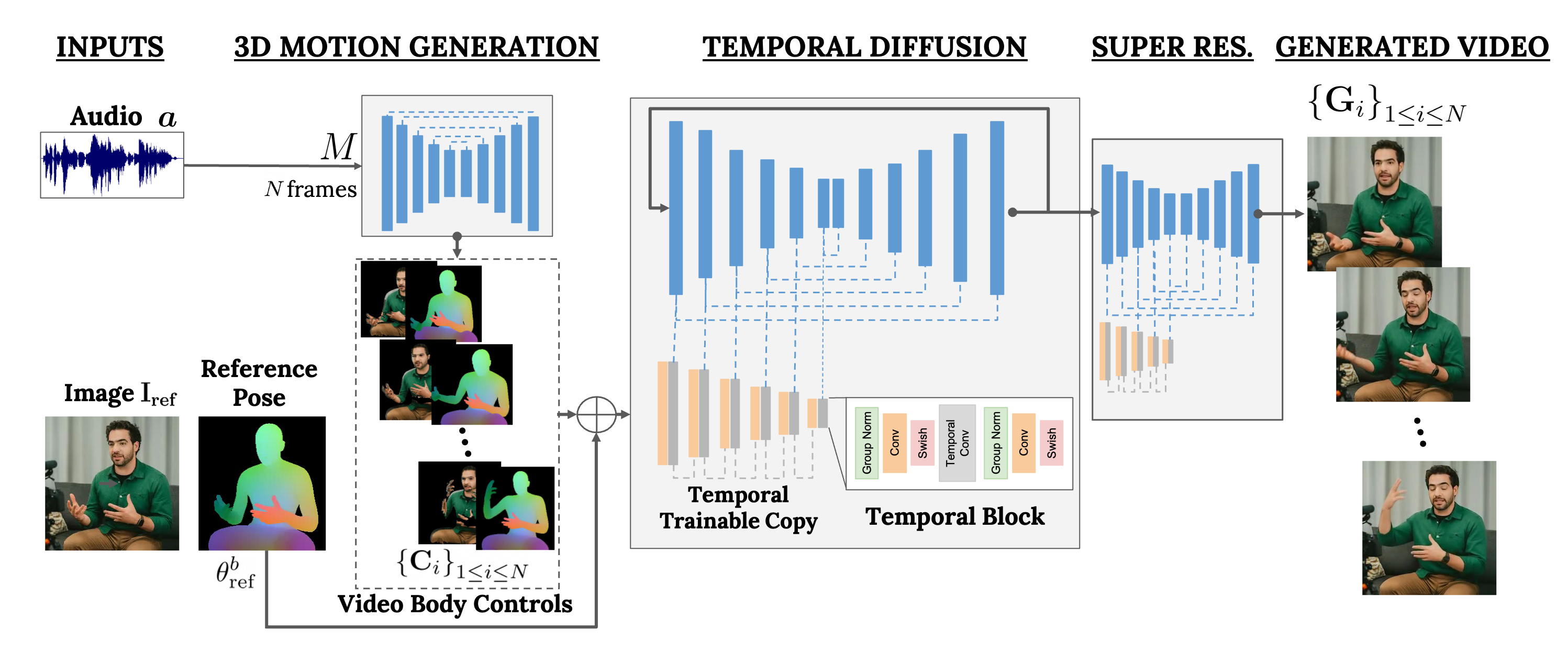

Google研究者们提出了VLOGGER (VLOGGER),这是一种基于单张人物图像进行文本和音频驱动的人物视频生成方法,该方法基于最近生成式扩散模型的成功。该方法包含两部分:1)一个随机人体到3D运动的扩散模型,以及2)一种新颖的基于扩散的架构,该架构通过时间和空间控制增强了文本到图像模型。这种方法能够生成高质量、可变长度的视频,并且可以通过人脸和身体的高级表示轻松控制。与以往的工作不同,该方法不需要针对每个人进行训练,不依赖于人脸检测和裁剪,能够生成完整图像(而不仅仅是脸部或嘴唇),并考虑了广泛的场景(例如,可见的躯干或多样的主体身份),这对于正确合成交流的人类至关重要。

研究者们在三个不同的基准测试上评估了VLOGGER,并展示了所提出的模型在图像质量、身份保持和时间一致性方面超越了其他最先进的方法。他们收集了一个新的、多样化的数据集MENTOR,其规模比之前的数据集大一个数量级(2200小时、800000个身份,以及一个测试集120小时、4000个身份),在此数据集上训练和消融了主要技术贡献。研究者们报告了VLOGGER在多个多样性指标上的性能,显示出他们的架构选择有利于大规模训练一个公平和无偏见的模型。

VLOGGER如何工作?

研究者们的目标是生成一个变长的真实感视频,描绘目标人物的说话场景,包括头部和手势。他们称之为VLOGGER的框架是一个基于随机扩散模型的两阶段管道,用以模拟从语音到视频的一对多映射。第一个网络以音频波形为输入,生成中间的身体动作控制信号,这些控制信号负责目标视频长度内的注视、面部表情和姿势。

第二个网络是一个时间图像到图像转换模型,扩展了大型图像扩散模型,利用预测的身体控制信号生成相应的帧。为了将过程条件化到特定身份,网络还需要一张人物的参考图像。

这篇关于Google研究者们提出了VLOGGER模型的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!