本文主要是介绍Figure 01掀起了具身智能的崭新篇章,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在人工智能的发展历程中,OpenAI始终扮演着创新的先锋角色。最近,他们与Figure公司的合作成果尤为引人注目,这一合作将多模态大模型技术成功应用于Figure 01机器人的开发中,为人类与机器的互动开辟了全新的时代。该机器人不仅能够与人类进行深入的对话交流,而且在最近的演示中,其展现出的互动能力令人印象深刻。

Figure公司在获得了包括OpenAI在内的多位重量级投资者的支持后,正式发布了Figure 01机器人。这一举措不仅标志着人工智能在具身智能领域的一大步,也展示了其在执行复杂任务方面的能力。Figure 01能够完成如递苹果、收拾塑料袋、归置杯盘等一系列复杂任务,这些任务的完成依赖于多模态大模型和由视觉驱动的transformer结构的policy network。

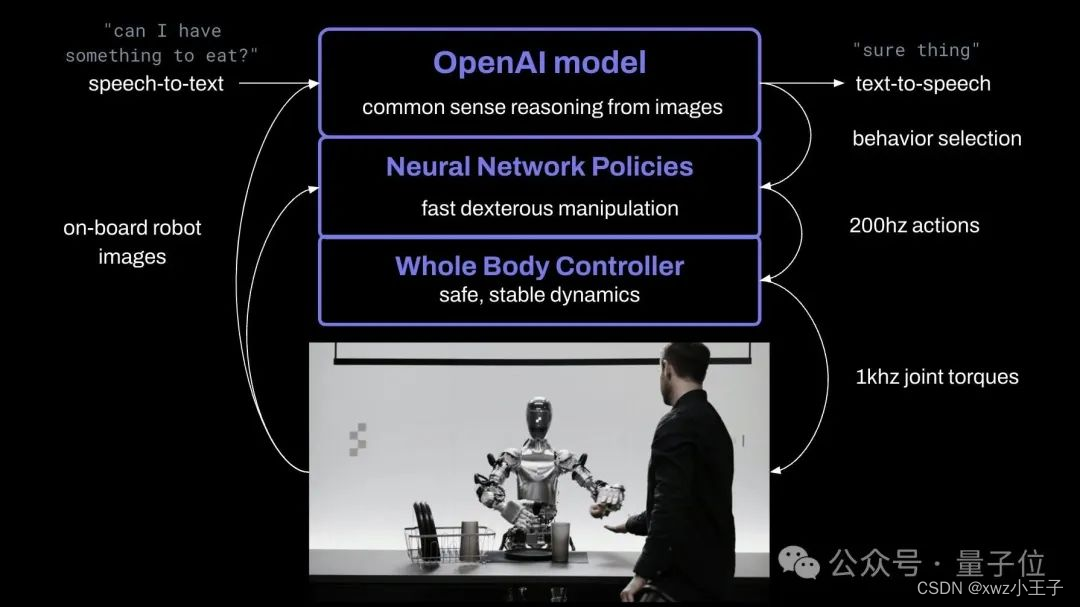

特别值得一提的是,Figure 01的policy network能够以高达200Hz的控制频率输出动作指令,这一成就在业界是极为罕见的。相比之下,谷歌的机器人大模型在控制频率上的最优结果仅为3Hz。如果Figure 01的policy network能够实现从图像输入端到端直接输出到动作,且达到200Hz的控制频率,这无疑是一项令人惊叹的技术突破。

Figure 01的核心技术在于其端到端的神经网络框架。机器人通过摄像头和麦克风捕获环境中的图像和声音,这些数据随后被输入到OpenAI的多模态模型中。该模型不仅处理对话记录,还能结合过去的图像数据和对话数据,生成语言响应和执行策略。尤其值得关注的是,Figure 01采用了端到端的视觉到action的transformer网络来执行策略,这种策略能够直接将像素信息映射为动作指令,并以极高的频率生成这些指令,从而实现精准且迅速的响应。

一些个人的推测:

1)理解和规划部分大概率用的是openai 内部的GPT4V或更强的模型

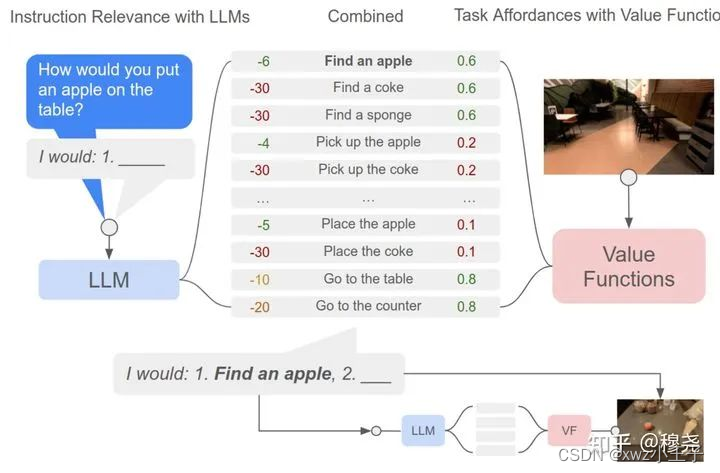

2)按照他公布的policy network的控制频率来看,不太像是一个RT系列的那种通用大模型,RT系列随着不断地scale up能力不断提升,而推理速度和控制频率随着模型变大牺牲了很多,其最快的控制频率也只做到3HZ,因此从这方面推测,Figure01的policy network大概率是一些被封装成API可被上层多模态大模型调用的小的端到端的策略网络,能够实现一小类任务和在一类物体之间的泛化,并由他们组建成为了一个庞大的技能库来供上层的多模态大模型调用。这块最典型的例子是谷歌出品的SayCan[1], 其构建了囊括上百个技能的技能库(但都比较简单以桌面的pick and place为主)通过大语言模型的决策和技能库的适配度选取当前步需要调用的技能。

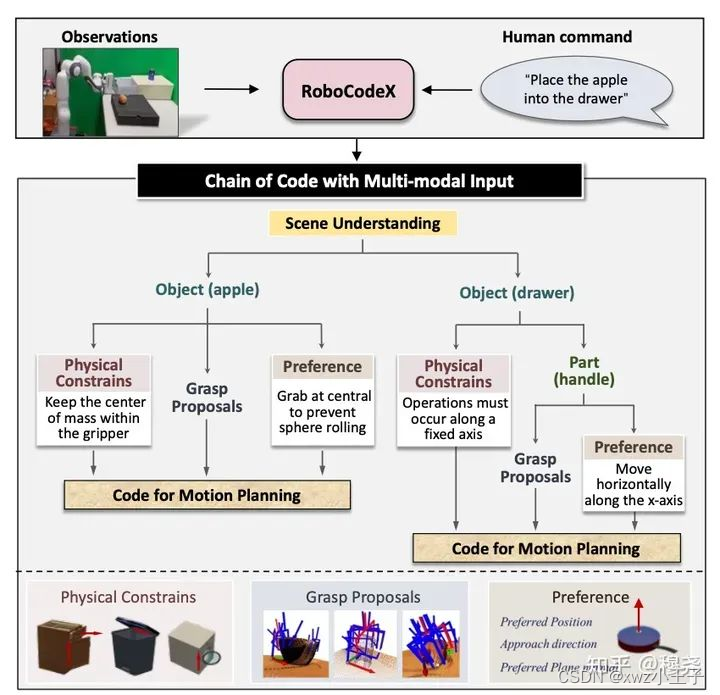

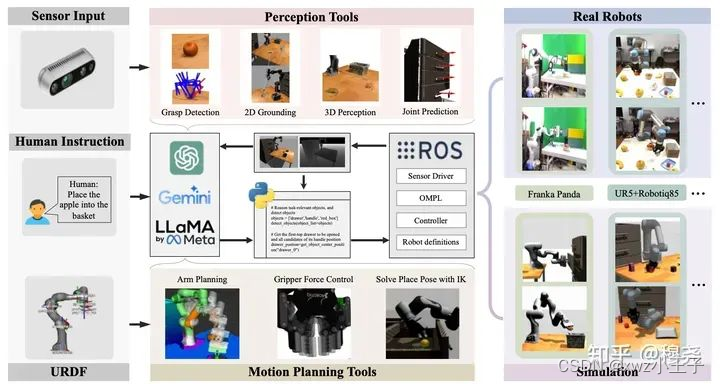

目前国内团队也在搭建类似的多模态细粒度决策框架,典型的例子是RoboCodeX[2],其由多模态大模型做code层级的细粒度调度,根据任务需要和视觉观测以具体问题具体分析的方式调用各种机器人专用模型来完成工作(工具包括抓取模型anygrasp、关节体预测模型GAMMA等)。在这类框架下,不断收集高质量的机器人数据,利用模仿学习得到能够解决复杂任务的netwotk并补充进技能库之中是关键。上海人工智能实验室最近还推出了基于ROS系统支持多模态大模型和大语言模型做代码生成的机器人评测平台RoboScript[3].

Framework of RoboCodeX

Framework of RoboScript

3)Figure01应该建立了庞大的数据飞轮,包括遥操作体系下的人类辅助数据收集和仿真平台上的自动化数据收集,利用数据飞轮收集了海量的专家示范数据,并基于端到端模仿学习的框架封装成了可被上层多模态大模型调用的API的形式。真机数据收集的廉价化和仿真数据收集的自动化是实现这一路径的关键。斯坦福有两篇代表性的工作:

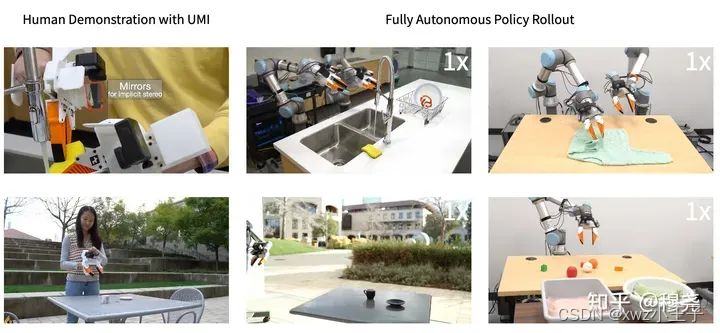

a) Universal Manipulation Interface[4]:

这是一个由斯坦福大学、哥伦比亚大学和丰田研究所的研究者开发的框架,用于数据收集和策略学习。

UMI使用手持夹持器,可以简单快速且低成本地收集训练机器人所需的数据。

它考虑了机器人观察环境的延迟、拿到环境数据后做推理的延迟,以及推理完成到做出动作的延迟。

UMI使用鱼眼镜头感知环境,并通过改造SLAM与GoPro内置的IMU传感器结合使用,提供立体观察。

它使用扩散策略进行动作预测,这是一种将机器人的视觉运动策略表示为条件去噪扩散过程来生成机器人行为的新方法。

UMI的硬件成本相对较低,使得数据收集更加经济高效。

项目地址:UMI GitHub(链接:https://github.com/real-stanford/universal_manipulation_interface)

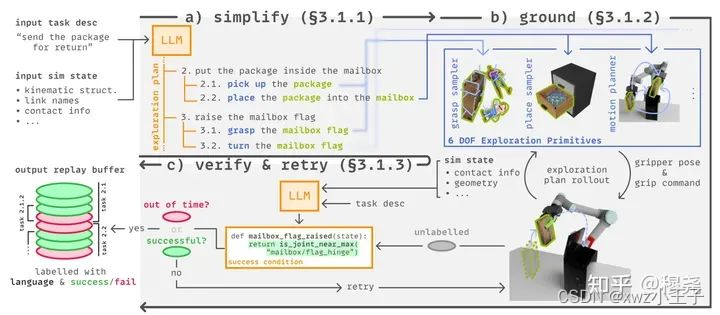

b) Scaling Up and Distilling Down[5]: Language-Guided Robot Skill Acquisition(利用大语言模型辅助自动化利用仿真环境收集专家数据)

为了扩展数据生成,使用大型语言模型(LLM)指导高级规划,并通过基于采样的机器人规划器生成丰富和多样的操作轨迹。

为了强化数据收集过程,语言模型还推断出每个任务的成功条件代码片段,这使得数据收集过程能够检测失败并重试,同时自动标记轨迹为成功或失败。

为了将数据提炼成实际部署的政策,扩展了单任务行为克隆方法到多任务设置中,并加入语言条件。

4)Figure01的机械臂和灵巧手的动作高度丝滑,这样的表现背后应该是一系列先进机器人控制技术的集成和应用。要达到这样的丝滑效果应该包括速度控制器和力矩控制技术的结合(汇总自@东林钟声大佬的分析),以及对重力和摩擦力的精确计算和补偿。在机械臂的控制系统中,速度控制器扮演着至关重要的角色。它能够确保机械臂在执行任务时,无论是加速还是减速,都能保持平滑过渡,避免因速度突变而产生的振动或冲击,这对于提高作业效率和保护机械结构都至关重要。力矩控制技术则是确保机械臂和灵巧手能够精确施加力量的关键。在灵巧手的关节内部,通常会配置力矩传感器,这些传感器能够实时监测和反馈手部施加的力量。精确地读取和响应力量变化,从而实现对灵巧手动作的精确控制。这种精确的力量控制,使得机械臂不仅能够抓取和操作各种形状和重量的物体,还能够模拟人类手部的细腻动作,如轻柔地抚摸或者稳定地握持。为了实现更高级别的精确控制,系统还需要能够计算和补偿各种外部和内部因素的影响。重力和摩擦力是影响机械臂和灵巧手动作的两个主要因素。通过先进的算法,系统可以预测和计算这些力的作用,并在控制过程中进行相应的补偿。这样,即使在复杂的操作环境中,机械臂和灵巧手也能够保持稳定和精确的性能。为了实现更高级别的精确控制,系统还需要能够计算和补偿各种外部和内部因素的影响。重力和摩擦力是影响机械臂和灵巧手动作的两个主要因素。通过先进的算法,系统可以预测和计算这些力的作用,并在控制过程中进行相应的补偿。这样,即使在复杂的操作环境中,机械臂和灵巧手也能够保持稳定和精确的性能。

这篇关于Figure 01掀起了具身智能的崭新篇章的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!