本文主要是介绍智算中心元年:如何理解“AI工厂”,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在如今“智算”属性不足的大背景下,建设智算中心不单纯是一项资金游戏,更是一个思维观念、企业架构转化的新模型。

作者|思杭

编辑|皮爷

出品|产业家

过去12个月,英伟达市值飙升了238%。这已经算是商业史上的现象级事件。

成为热点的不止有英伟达,还有站在英伟达背后的“人物”黄仁勋。就像当年的马斯克一样,现在的黄仁勋几乎每次发言都是科技界的“头条”。

“AI工厂”便是黄仁勋近期频繁提到的词语。在2月的英伟达2024财年第四季度财报电话会上,黄仁勋将一种专注于AI生成的新型数据中心定义为“AI工厂”。其中,为AI工厂输送“能源”的正是让英伟达市值上涨万亿美元的GPU芯片。

而黄仁勋口中新型的数据中心“AI工厂”也正是国内近两年异常火热的智算中心。

那么,究竟什么是智算中心?以及,黄仁勋口中的AI工厂到底是什么?

简单来理解,智算中心就是为如今的AI大模型、AI应用,以及未来所有的人工智能项目提供计算力的新型“发电厂”。它是专为AI而生的。

与传统计算中心不同的是,智算中心所需要的算力是由GPU提供,而前者则是由CPU提供。在过去,GPU的用处则更多是在游戏行业,而到了今天的AI时代,GPU芯片则变成了一种“必需品”。

2023年10月前,阿里、腾讯、字节跳动、百度等国内大型科技公司都是从英伟达手里获取AI芯片。 但伴随着美国禁止英伟达等本土企业向中国出售A100/H100等AI芯片,这也一定程度上导致了国内的算力短缺。在过去的2023年,“缺卡”也更在成为一众大模型企业的普遍现状。

但实际上,早在之前,国内的AI算力军备竞赛早已打响。从国家启动“东数西算”工程开始,传统IT企业、云厂商和电信运营商就已经在紧锣密鼓地布局智算中心。

早在2022年已有相关动作。1月,商汤科技智能计算中心在上海市临港区启动运营;8月,阿里云张北超级智算中心在张家口张北县;9月,百度智能云(盐城)智算中心在江苏省盐城市落地,以及包括华为晟腾系列、昆仑芯、寒武纪等越来越多中国厂商也都在2022年甚至之前已经在稳步布局。

在过去的一年中,智算中心的建设在中国大地上可谓如火如荼。

纵观2023年的整个算力产业发展上,在智算中心之外,AI芯片、AI服务器、数据训练中台等等,如今也更在成为云厂商、传统IT企业和电信运营商的一块兵家必争之地。 而在2024的今年,这些节奏更在进一步提速。智算中心,飞奔在路上。

一、2024,欢迎来到智算中心「元年」

国家队的入场无疑是最引人注目的 。

2023年,超30座城市抢建智算中心。这是国家信息中心与相关部门联合发布的《智能计算中心创新发展指南》中给出的一组数据。

而2024年,智算中心则更是迎来它的“元年”。

在刚刚结束的两会,一个产业界最关注的话题便是,政府工作报告提出开展“人工智能+”行动。而在这其中,据《证券日报》的记者了解到,不少企业界人士都认为,“人工智能+算力基础”会率先“动起来”。

事实也的确如此。从2024年初开始盘点:1月8日,中国移动智算中心(武汉)在武汉未来科技城开放运营,预计成为华中地区规模最大的智算中心;1月22日,上海电信在上海点亮“大规模算力集群暨人工智能公共算力服务平台”,预计成为国内首个超大规模国产算力液冷集群;1月30日,中国联通人工智能创新中心成立仪式在京举行。 此外,北电数智承建的北京数字经济算力中心达产后将实现1000P智能算力供给。

从中可以看到一个明显的信号,包括互联网厂商、通信厂商、电信运营商在内的一众企业都正在加大力度建设智算中心。

判定算力资源的最直观指标便是看服务器规模。后者规模越大,前者算力资源就更多。

而在2024年初中国移动发布的一份供应商信息核查公告中透露,2024年~2025年,中国移动将采购特定场景AI训练服务器6000台。如果按照中国移动《2023年至2024年新型智算中心(试验网)招标》中第12个标包——1250台(包括风冷和液冷)中标价24.7亿元粗略估算,这笔投资将超过120亿元。

实际上,与电信运营商相比,云厂商和传统IT企业的投入其实占比更大。

国际数据公司IDC的一位中国分析师对《财经》记者表示,从服务器采购量占比来看,互联网云厂商等科技公司占比约40%,电信运营商占比超过15%,数据中心服务商、地方大数据产业园以及其他IT服务公司占比约10%。

实际上,再往前追溯,在这种强投入的背景下,互联网云厂商则在更早之前已经便开始投入到智能计算当中。从一组云厂商的动态中即可窥见出这一趋势:

2019年,百度智能云提出ABC战略(AI,Big data,Cloud Computing),致力于智能计算、智能应用、智能生态的全面发展;

2021年7月,腾讯在合肥设立的腾讯智慧产业总部基地正式揭牌;

截至2021年上半年,华为云的“南贵北乌”智算中心已经全面建设完成,并于2022年进入年度国家绿色数据中心名单;

2023年9月,京东云发布数智算力矩阵;

2023年,火山引擎与理想汽车合作,在山西省建设智算中心;

...

这种对于智能计算的强调对大模型厂商而言也更是自然趋势。此外,在如今国外GPU芯片困难的背景下,互联网厂商和传统IT企业也都在加速“追赶”,力争自研能应用于AI大模型及其他AI应用的芯片。比如华为的昇腾、阿里巴巴的含光和百度的昆仑等等。

而在AI服务器的供应上,这部分的市场份额目前主要还在传统IT企业手中。 据IDC数据,2022年中国AI服务器市场(按销售额),浪潮以46.6%份额占据首位,新华三、宁畅分别以11%和9%占据第二、第三名。

在如此AI算力军备竞赛打响的背后,实际上隐藏起来的是如今国内巨大的算力缺口。

据不完全统计,过去一年单单是中国大模型创新企业就超过250家,而中国更是凝聚了1070万名开发者,服务23.5万家企事业单位。更不用说,伴随着如今的产业落地,这种需求更将会加速涌现。

首次提出“智算中心”的浪潮认为,未来人工智能计算需求占比将在80%以上。而且未来对一个大模型训练所需的算力,可能每3~4个月就翻一番,这意味着一年就要增加10倍。阿里云智能解决方案首席架构师郑海超也曾公开提到,大模型带来的算力需求为每两年275倍的增长。

在如此巨大的算力缺口下,智算中心在国内的大规模建设也成为了一种必然。

而对于像“智算中心”这种基础设施而言,政策的推动则起到了加速的作用。2017年,《新一代人工智能发展规划》提出“建立人工智能超级计算中心”,自此智算中心也被提高到国家战略的高度。

从2020年开始至今,智算中心更是多次出现在“十四五”报告、新型数据中心发展三年行动计划、数字中国建设整体布局规划等等白皮书中。战略地位被一再提高,直到2024年3月的两会上,“人工智能+”行动被写入政府工作报告,相关产业都将得到高度重视。

根据IDC圈不完全统计,截至2023年底,全国带有“智算中心”的项目有128个,其中83个项目有规模 披露,超过7.7万P。 这也正是企业与国家队共同努力得到的一份成绩单。

然而,在传统IT厂商、云厂商和电信运营商“抢建”智算中心的当下,一些问题也正 在被看见。

二、建一个智算中心,难在哪?

2024年哈尔滨平房区批复了4.6亿元的哈投智算中心;2023年长春公布了4.8亿元长春新区智算中心的建设计划,青岛市公布了17.7亿元的元宇宙智慧算力中心建设计划,南昌市公布了4.5亿元的江西人工智能计算中心建设计划。

地方城市正在市场和政策的驱动下积极响应,投入建设智算中心。

然而,这种异常高涨的热情背后,对应的并非是实际的算力需求。一方面,据《财经》了解,一些城市投资智算中心的逻辑是,希望以此扩大基建、招商引资、吸纳人才,推 动本地产业升级。很多地方政府还会为企业发放算力券,进行市场补贴。

而在没有合理规划和试验的情况下,盲目建设智算中心的行为则会导致极大的资源浪费。

全国政协委员、中科院计算所研究员张云泉也在《算力经济发展趋势分析与展望》中分析道,“有些地方只是为了追求排名、追求规模效应,运营过程不透明、缺乏监管,建成之后发现需求不足,没有大的应用,出现了很多智算中心直接空转、关机的现象,造成很大浪费。”

实际上,建一个智算中心需要更为合理的规划和实验验证。对此,张云泉给到的第一点建议便是,“对新增建设类算力网工程技术装置进行实验验证,在验证的基础上再放大。”

尤其是大型算力网的构建则更需要通过原型实验,进行严格论证。一个正常大型项目的逻辑是,在应用场景确定下来的基础上,再衡量项目建设的投入产出比。但如今在算力的架构、调度、测量、交易、安全技术等方面都尚不成熟。

严格意义上讲,目前国内的智算中心还并不能称之为真正的“智算”,在运营模式、服务等方面都还深受传统IDC行业影响。

北电数智首席战略官杨震告诉产业家,AI时代,企业需要的,除了能够精准匹配需求、极具性价比的智能算力服务,还要有端到端的人工智能全栈服务。

除了算力,企业应用人工智能还涉及数据、模型开发和调优、AI应用等多个环节。每个环节对于传统企业都存在技术门槛高、人才缺失、开发周期长等难题。据了解,北电数智的做法是联合生态伙伴提供底座大模型、丰富的行业垂直大模型、一栈式AI工具链,企业可以灵活调用各种能力,加工出所需要的AI应用;此外,其也围绕数据要素打造赋能工具,帮助拥有丰富数据的企业挖掘数据价值。

杨震告诉产业家,事实上,具有全智算属性的AIDC,是在提供从底层算力到顶层应用使能的全栈能力。在他看来,北电数智承建的北京数字经济算力中心就是在打造新型的AIDC,也就是黄仁勋说的“AI工厂”。

实际 上,智算中心与传统数据中心的区别一方面在于能够帮助AI企业提供AI算力;另一方面则在于改变运营方式。

而提供AI算力的前提除了需要AI芯片,更重要的则是如何发挥“平台”作用,为企业提供配套的算力服务。尤其是在如今的大模型时代,一个参数规模达千亿甚至万亿级的大模型, GPU卡的需求就高达数万张。

因此,于企业而言,“算力服务除了提供算力外,还要有底座大模型、丰富的行业垂直大模型、一栈式AI工具链等。而这些都是智算中心应该做到的。”杨震表示。

但从目前的智算中心建设情况来看,整体的现状是只注重“量”,而忽视“质”。在智算中心的华丽外壳下,却装着传统数据中心的“里子”。

此外,在如今智算中心占领高地的当下,一个更新的问题也在被放到台面上:传统IDC将如何转型?

“过去,云厂商和传统IDC企业存在竞争关系,而未来将是互补,甚至是合作的关系。”在2月末的阿里云战略发布会上刘伟光曾公开表示。与此同时,AIDC企业北电数智也同样认为,传统IDC实现转型则要避免“单打独斗”,要和生态合作伙伴共同发挥各自优势,联合创新。

换言之,如果实现智算中心的“AI工厂”的平台价值,在算力之外,还需要关于数据的训练、标注以及后期的微调等等。能够预测的是,在2024年将会有越来越多围绕智算中心的生态出现。这里面不仅包括晟腾、寒武纪等芯片企业,更多的也恰是整个大模型生产链上的企业,比如标注企业、大模型isv开发者等等。

此外,从ChatGPT到Sora,大模型应用不仅仅带动了算力需求的爆发,能耗也在急剧增长。比如最近ChatGPT爆出日消耗电力超50万度,相当于美国家庭每天用电量的1.7万多倍。而在此背景下,智算中心的绿色节能也被提上日程。

这也恰是如今越来越多的智算中心开始选择液冷配置的原因。但相较于传统的水电模式,液冷需要的硬件配备以及对应的成本都将会更大,对不少算力规模较小的智算中心而言,这也更是一项难覆盖的成本。

但在单点上,国内企业也有突破。比如在2023中国算力大会期间,联想问天发布的AI大模型训练服务器便实现了相比同级别服务器功耗降低约10%,恰是基于液冷对服务器的加持。

不难看出,在种种难题下,不论其算力规模大小,智算中心的建设实际上都并非容易,一方面是如何实现技术突破,这些包括和芯片的兼容、适配等等,另一方面是如何打通生 态,开辟新的运营方式。

对智算中心而言,这不单纯是一项资金的游戏,更是一个思维观念、企业架构转化的新模型。

换句话说,这是一个基于AI时代的新IDC企业模型。如果要做好,在资金和技术之外,更要有兼容和共创。

三、算力,狂飙在大模型时代

在越发强烈的市场需求下,行业本身的问题也更在加速浮现。

过去一年,ChatGPT发生过多次宕机事件,最长宕机时间甚至达到16小时21分钟。尽管OpenAI所用到的芯片都来自于全球生产GPU芯片最厉害的企业英伟达,但算力依然捉襟见肘。

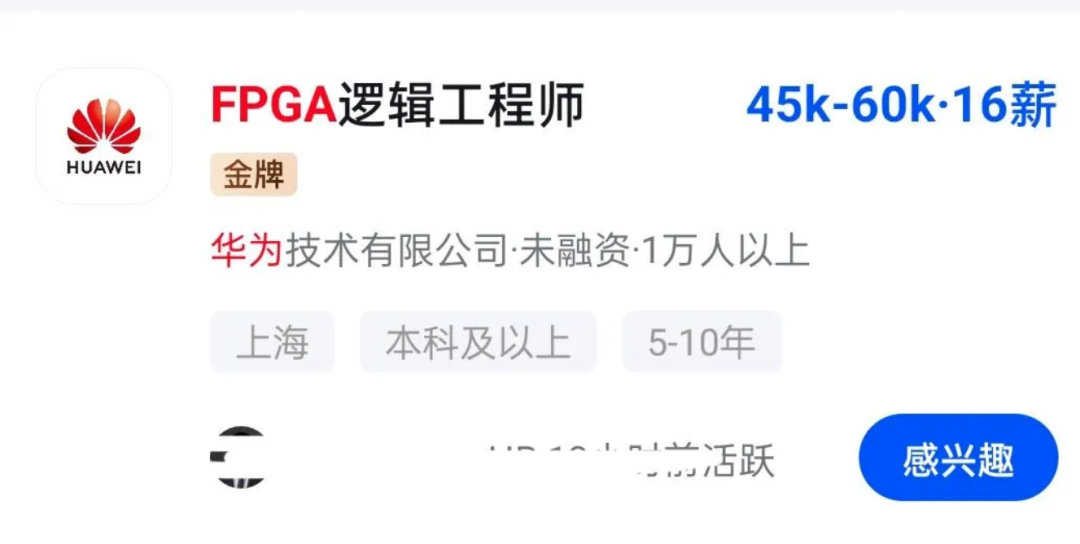

从AI芯片的架构来分析,目前最为核心的架构是GPU、FPGA、ASIC。其中,GPU通用性较强,适合大规模并行计算,且设计及制造工艺较成熟,目前占据AI芯片市场的主要份额。

而FPGA则可以更好地解决当下AI时代所出现的暗硅效应,其中,暗硅效应(Dark Silicon)指由于芯片工艺和尺寸的限制,芯片上只有一小部分区域可以同时运行,其余的区域被闲置或关闭,这些闲置或关闭的区域被称为“暗硅”。

能看到的是,国内的大型科技企业都在尝试FPGA架构,如阿里、华为等等。

从全球范围来看,智算中心的军备竞赛早已拉响。首先是美国,斥资3000亿美元重点投资数据中心和智算中心;接下来是出资50亿欧元支持人工智能研究的德国。而在日本,NTT(日本电报电话公司)2023年宣布,未来5年内向人工智能、数据中心等领域投资590亿美元。另外,Meta甚至叫停部分在建数据中心,转而打造智算中心。

张云泉在《算力经济发展趋势分析与展望》中写道,“工业互联网、自动驾驶、全息通信等业务对网络时延、带宽和确定性等条件的要求远远高于消费互联网。如L3~L5级别的自动驾驶要求端到端的时延不超过3毫秒,而传统的集中式的云服务时延一般会超过50毫秒。在这样的情况下,把海量数据上传到云计算中心进行集中处理的模式难以为继。”

这些都将是算力狂飙的最直接需求。面对这些更为广泛的需求,圈内更多的观点是算力分布式理念。即从单一的CPU走向CPU、GPU、NPU、FPGA等多架构,进而满足需求。

未来,“算力会像水、电一样通用”。这是如今大模型时代里一个美好的畅想。

那么,今天距离这样的畅想还有多远?

二十年前,“十五计划”提出了电信网、互联网、有线电视网三网融合的概念。此后的八年一直到2008年北京奥运会,中国已经完全实现让居民接入高速宽带传输网络的愿景。

二十年后的今天,这样的场景也在重新上演。在如今的算力时代,“算网融合”被提升到重要位置,其主要模式恰是让居民和企业使用算力像使用网络一样方便、便捷。

想象一下在个人移动端,某天你可以在手机上办理“算力套餐”,直接购买算力,像现在购买流量一样;而在企业端也是如此,比如教育、能源、工业、交通等等领域都可以更廉价地购买算力。未来,随着智算中心的规模扩大、技术提升,以及算力订阅式、分布式的普及,有理由相信,这些都将会一一实 现。

按照这样的速度,“算力像水电一样通用”这样的畅想也许不需要第二个“八年”。

这篇关于智算中心元年:如何理解“AI工厂”的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!