本文主要是介绍【IR】什么是对抗攻击 | 视觉跟踪,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

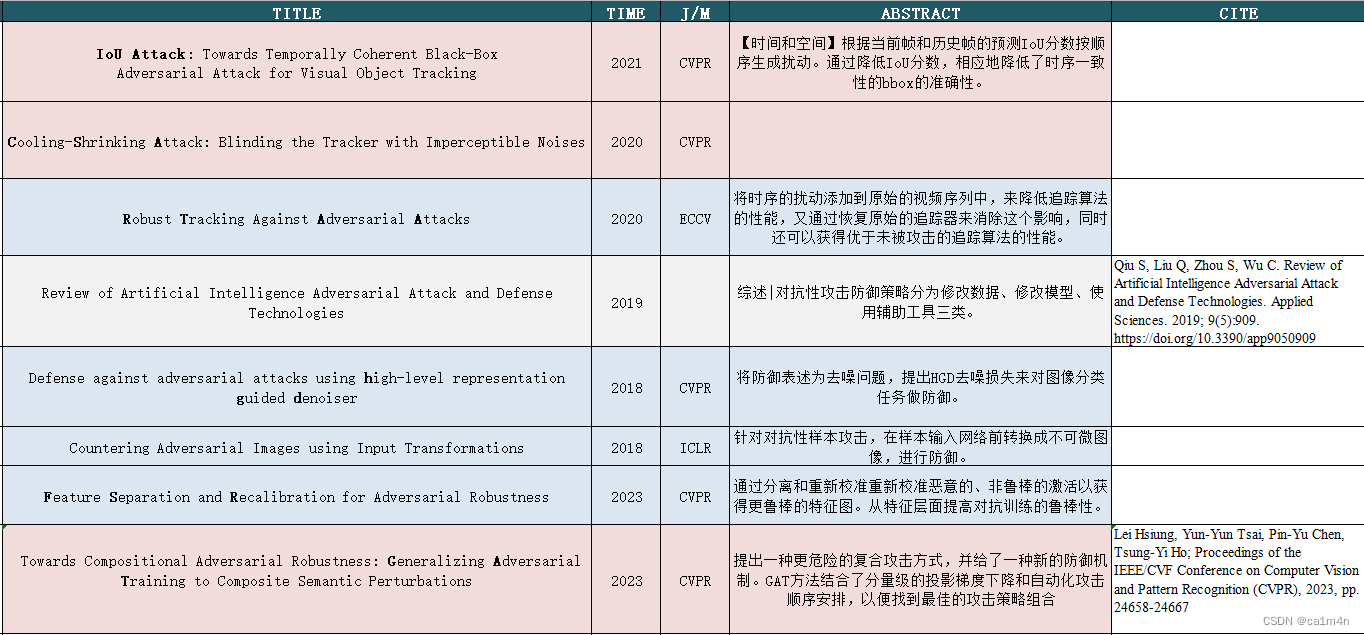

现在有机会接触一下针对深度学习神经网络的对抗攻击,并做整理如下🤔

对于CV攻防,其实去年组会听过就浏览过相关文章👉面向目标检测的对抗样本综述+后门防御, NIPS2022

adversarial attack for tracking

- 一些攻|防方法

- CVPR2021 | IoU Attack

- 导读

- 方法

- 结果

- 相关工作

- CVPR2020 | CSA

- 摘要

- 方法

- 结果

一些攻|防方法

CVPR2021 | IoU Attack

IoU Attack: Towards Temporally Coherent Black-Box Adversarial Attack for Visual Object Tracking

IoU Attack: Towards Temporally Coherent Black-Box Adversarial Attack for Visual Object Tracking

Code

上海交大,腾讯

导读

对抗性攻击的产生是由于深度神经网络在感知注入了难以察觉的扰动的输入样本方面的脆弱性。

本文提出了一种基于决策的视觉目标跟踪黑盒攻击方法。与现有的处理静态图像来进行图像分类的黑盒对抗攻击方法相比,IoU attack根据当前帧和历史帧的预测IoU分数按顺序生成扰动。通过降低IoU分数,所提出的攻击方法相应地降低了时序一致性的边界框(物体的运动)的准确性。此外,我们将学习到的扰动转移到接下来的几帧来初始化时间运动攻击。我们在最先进的深度跟踪器上验证了提出的IoU攻击方法。

方法

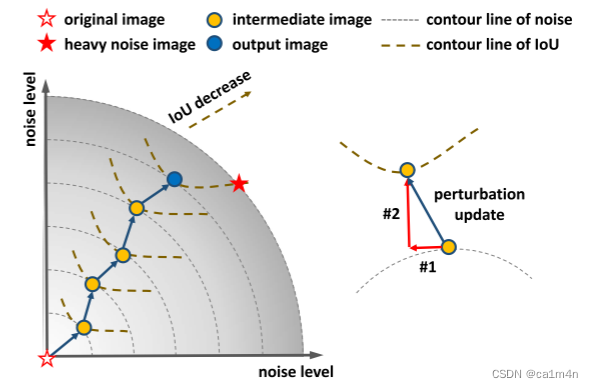

目标:通过使用最小数量的噪声在迭代期间逐渐降低IoU分数(即bbox重叠值)。

IoU攻击在帧之间逐渐降低IoU分数的直观视图👇

(左侧图)迭代扰动更新:噪声水平的增加与IoU分数的减少呈正相关,但它们的方向并不完全相同。IoU攻击方法迭代地找到噪声增加和IoU减少的每条轮廓线之间的交叉点(即中间图像)。这些中间图像以最低的噪声量逐渐降低IoU分数。

(右侧图)正交合成:根据当前轮廓线切向生成噪声假设(即#1),并在法线方向上增加少量噪声(即#2)。将根据在相同噪声水平下产生最低IoU的假设来识别交叉点。每次迭代中更新的扰动是#1和#2的组合。

给定的一个干净的输入帧,添加重均匀噪声来生成IoU分数较低的重噪声图像。沿着从干净图像到重噪声图像的方向,当噪声水平增加时,IoU分数逐渐降低。IoU降低的方向与噪声增加的方向正相关,但它们并不完全相同。IoU攻击旨在逐步找到降低的IoU分数,同时引入最低量的噪声。

我们将第t帧的原始图像表示为 I 0 I_0 I0,将重噪声图像表示为 H H H,将第 k k k次迭代上的中间图像表示为 I k I_k Ik。在第k+1次迭代中,我们首先随机生成几个高斯分布噪声 η \eta η~ N ( 0 , 1 ) N(0,1) N(0,1),并从n个噪声中选择切向扰动 η \eta η为: d ( I 0 , I k ) = d ( I 0 , I k + η ) d(I_0,I_k)=d(I_0,I_k+\eta) d(I0,Ik)=d(I0,Ik+η)d是两个图像之间的像素级距离测量值。

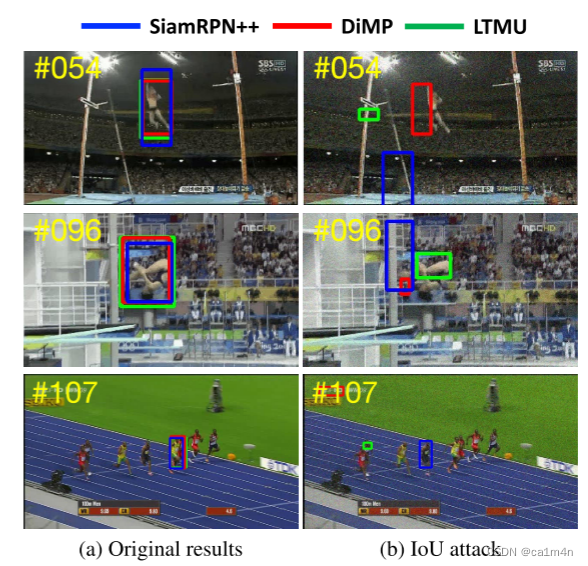

结果

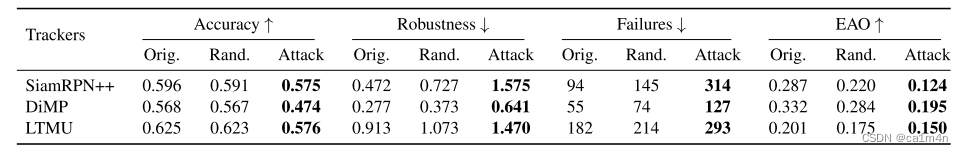

在VOT2019数据集上分别与SiamRPN、DiMP和LTMU的原始序列、随机噪声和IoU攻击的跟踪结果的比较:

VOT2019数据集中包含60个具有挑战性的序列。与其他数据集不同,VOT数据集具有重新初始化模块。VOT数据集具有重新初始化模块。当追踪器失去目标(即预测结果与标注之间的重叠为零)时,追踪器将使用真实标注重新初始化。

VOT2019数据集中包含60个具有挑战性的序列。与其他数据集不同,VOT数据集具有重新初始化模块。VOT数据集具有重新初始化模块。当追踪器失去目标(即预测结果与标注之间的重叠为零)时,追踪器将使用真实标注重新初始化。

Failures表示重新初始化的次数,Accuracy评估成功跟踪帧的平均重叠率,Robustness衡量的是总体追踪失败次数,预期平均重叠(EAO)通过准确性和稳健性的组合进行评估。

还有在数据集VOT2018、VOT2016、OTB100、NFS30上的比较结果,详见论文。

消融实验:

消融实验:

S t e m p o r a l S_{temporal} Stemporal表示时间IoU分数, P t − 1 P_{t−1} Pt−1表示从历史帧中学习到的扰动。

相关工作

Visual Object Tracking

现有跟踪器通常可以分为离线跟踪器和在线跟踪器

- offline trackers

在推理过程中,不会更新模型参数,从而提高了速度。这些tracker将跟踪视为一个判别性目标检测问题。它们生成候选区域,并对要定位的目标或背景进行分类。边界框回归总是用于精确定位。其中,基于Siamese的方法是由模板分支和搜索分支组成的典型结构。 - online update trackers

在线更新跟踪器在推理过程中不断更新模型参数,以适应当前场景。

本文提出的黑盒攻击方法对一个离线跟踪器(SiamRPN++)和两个在线跟踪器(DiMP、LTMU)实现对抗攻击,以说明该攻击方法的通用性。

- SiamRPN绘制了一个区域建议网络,通过比较两个分支之间的相似性来制定一次性检测。SiamRPN++应用了更深层次的网络ResNet,而不是常用的AlexNet,以提高跟踪精度并保持实时速度。

- DiMP学习判别学习损失,以利用目标和背景外观信息进行目标模型预测。

- LTMU是一个具有meta更新器的长期跟踪器,它学习引导跟踪器的更新,以获得有用的外观信息,从而提高准确性。

CVPR2020 | CSA

Cooling-shrinking attack: Blinding the tracker with imperceptible noises

Code

大连理工,鹏程实验室

摘要

CNN的对抗攻击旨在通过给图像增加难以察觉的扰动来欺骗模型,使其失灵。这一特点有助于深入理解神经网络,提高深度学习模型的鲁棒性。尽管有几项工作专注于攻击图像分类器和对象检测器,但仍然缺乏一种以model-free的方式攻击任何目标的单个对象跟踪器的有效方法。

在本文中,提出了一种冷却收缩攻击方法来欺骗最先进的基于SiameseRPN的跟踪器。使用精心设计的对抗性损失训练一个有效且高效的扰动生成器,它可以同时冷却热图上存在目标的热点区域,并迫使预测的边界框收缩,使追踪目标对跟踪器不可见。

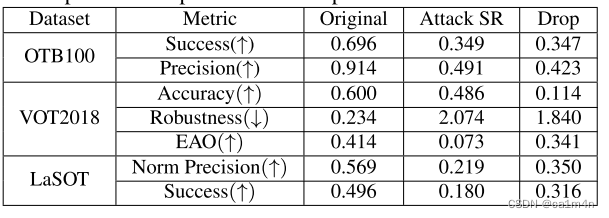

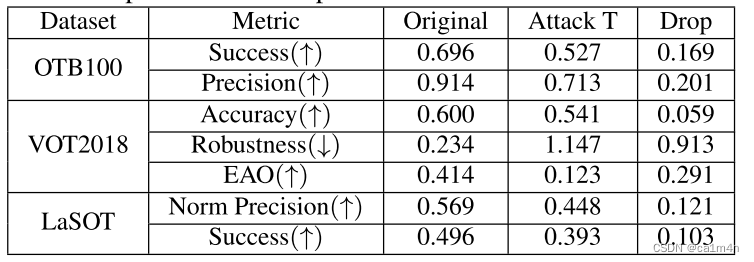

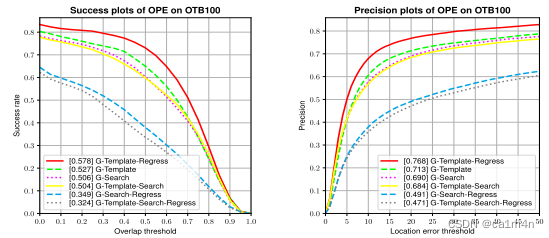

在 O T B 100 OTB100 OTB100、 V O T 2018 VOT2018 VOT2018和 L a S O T LaSOT LaSOT数据集上的大量实验表明,本文提出的方法可以通过向模板或搜索区域添加小扰动来有效地欺骗最新的 S i a m e s e R P N + + SiameseRPN++ SiameseRPN++跟踪器的状态。此外,本方法具有良好的可转移性,能够欺骗其他顶级性能跟踪器,如 D a S i a m R P N DaSiamRPN DaSiamRPN、 D a S i a m R P − U p d a t e N e t DaSiamRP-UpdateNet DaSiamRP−UpdateNet和 D i M P DiMP DiMP。

方法

- 用于搜索区域的扰动生成器的网络架构:

- 冷却收缩损失:

cooling loss用于干扰热图 M H M_H MH,用于干扰回归图 M R M_R MR的shrinking loss。

结果

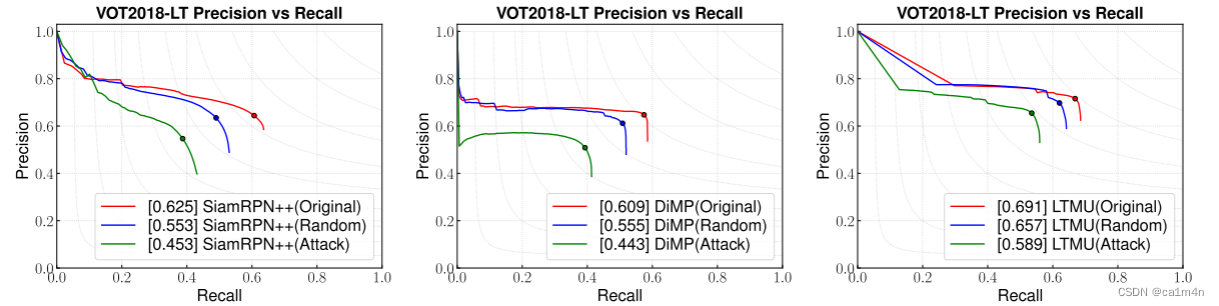

仅攻击搜索区域:

仅攻击模板:

消融实验:

消融实验:

也就是,shrinking loss有助于攻击搜索区域,但对攻击模板有一定的危害。

可视化效果图和讨论,详见论文

这篇关于【IR】什么是对抗攻击 | 视觉跟踪的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!