本文主要是介绍《Single-step Adversarial training with Dropout Scheduling》 论文笔记,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Abstract

在对抗训练中,mini-batches 通过对抗样本进行数据增强,然后在进行训练。通常使用快速、简单的方法来生成对抗样本,目的是减少计算复杂度。然而使用单步对抗训练方法训练的模型的鲁棒性是伪性的。

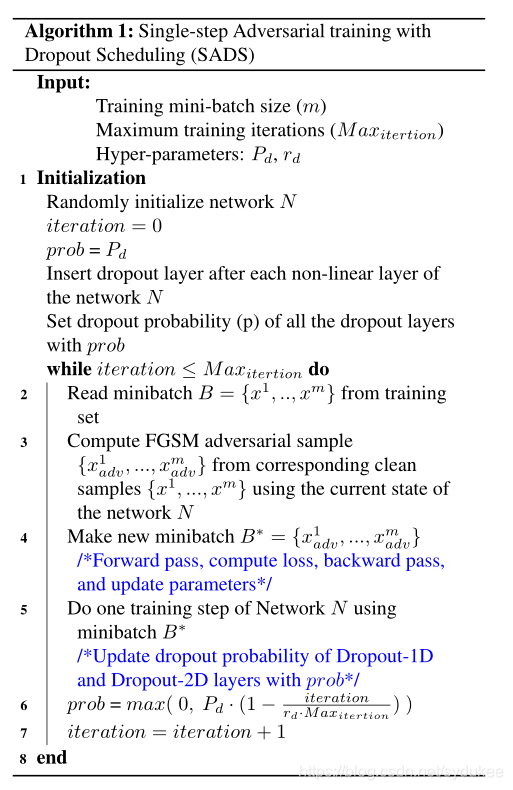

本文的工作中,作者表明了使用单步对抗训练方法训练的模型会逐渐学习避免单步对抗的产生,这是因为模型在初始训练阶段的过拟合。为了减小这种现象,作者提出了一个带有dropout scheduling的单步对抗训练方法。与其他现有的对抗训练方法不同,使用提出的单步对抗训练方法在对抗单步和多步攻击时都是鲁棒的。在白盒和黑盒设置中,性能与使用计算昂贵的多步对抗训练方法训练的模型相当。

Introduction

梯度遮蔽效应导致在单步对抗训练中生成对抗样本的 loss 函数的线性估计变得不可靠。

本文工作中,我们尝试回答两个问题:为什么单步对抗训练方法存在梯度遮蔽效应;在单步对抗训练的什么阶段模型开始出现梯度遮蔽效应,并且本文还提出了一个新的单步对抗训练来学习鲁棒模型。首先我们展示使用单步对抗训练的模型学习避免单步对抗样例的产生,并且这是因为在训练的初始阶段的过拟合。

为避免过拟合,作者引入了 dropout layer。而且与标准设定不同,作者在每个非线性层后都引入了dropout layer。(在conv2D+ReLU之后引入dropout-2D,在FC+ReLU之后引入dropout-1D )

Single-step Adversarial training with Dropout Scheduling

这篇关于《Single-step Adversarial training with Dropout Scheduling》 论文笔记的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!