本文主要是介绍基于扩散模型的图像编辑:首篇综述,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

AIGC 大模型最火热的任务之一——基于 Diffusion Model 的图像编辑(editing)领域的首篇综述。长达 26 页,涵盖 297 篇文献!本文全面研究图像编辑前沿方法,并根据技术路线精炼地划分为 3 个大类、14 个子类,通过表格列明每个方法的类型、条件、可执行任务等信息。此外,本文提出了一个全新 benchmark 以及 LMM Score 指标来对代表性方法进行实验评估,为研究者提供了便捷的学习参考工具。强烈推荐 AIGC 大模型研究者或爱好者阅读,紧跟热点。

-

作者:Yi Huang, Jiancheng Huang, Yifan Liu, Mingfu Yan, Jiaxi Lv, Jianzhuang Liu, Wei Xiong, He Zhang, Liangliang Cao, Shifeng Chen

-

单位: 中科院、Adobe公司、苹果公司(曹亮亮等)、南科大

-

链接:https://arxiv.org/abs/2402.17525

-

https://github.com/SiatMMLab/Awesome-Diffusion-Model-Based-Image-Editing-Methods

摘要

去噪扩散模型已成为各种图像生成和编辑任务的有力工具,有助于以无条件或输入条件的方式合成视觉内容。这些模型背后的核心理念是学习如何逆转逐渐向图像中添加噪声的过程,从而从复杂的分布中生成高质量的样本。

在这份调查报告中,我们详尽概述了使用扩散模型进行图像编辑的现有方法,涵盖了该领域的理论和实践方面。我们从学习策略、用户输入条件和可完成的一系列具体编辑任务等多个角度对这些作品进行了深入分析和分类。此外,我们还特别关注图像的inpainting和outpainting,并探讨了早期的传统上下文驱动方法和当前的多模态条件方法,对其方法论进行了全面分析。

为了进一步评估文本引导图像编辑算法的性能,我们提出了一个系统基准 EditEval,其特点是采用了创新指标 LMM Score。最后,我们讨论了当前的局限性,并展望了未来研究的一些潜在方向。

附带的资源库发布在:https://github.com/SiatMMLab/Awesome-Diffusion-Model-Based-Image-Editing-Methods。

统计图

基于扩散模型的图像编辑中研究出版物的统计概述。上图:学习策略。中:输入条件。下图:编辑任务。

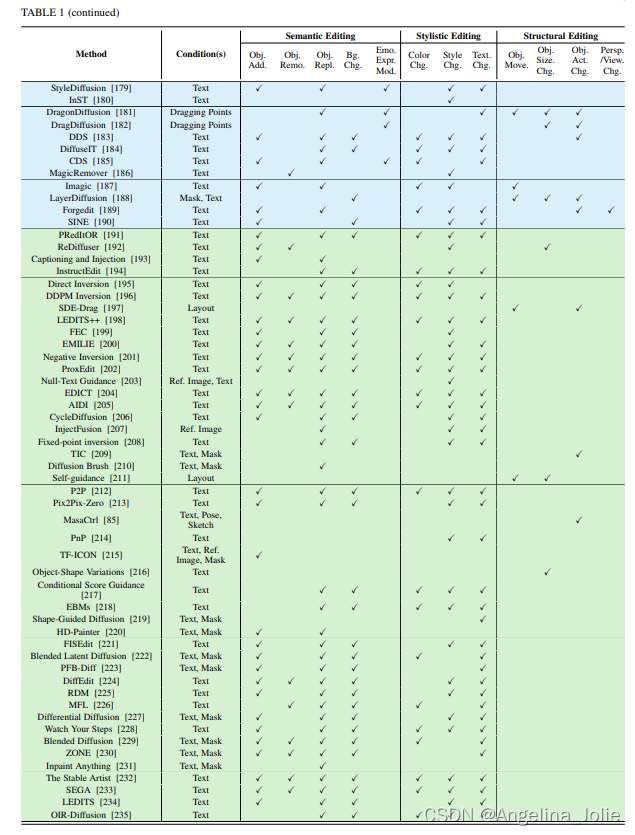

从多角度对基于扩散模型的图像编辑方法进行了全面地分类。这些方法是根据训练、微调和免训练进行颜色渲染的。输入条件包括文本、类别、参考图像,分割图、姿态、蒙版、布局、草图、拖动点和音频。打勾表示可以做的任务。

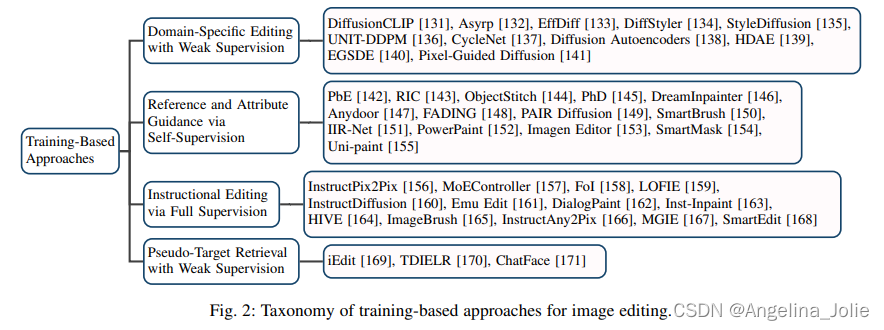

训练大类的分类属性图以及框架图

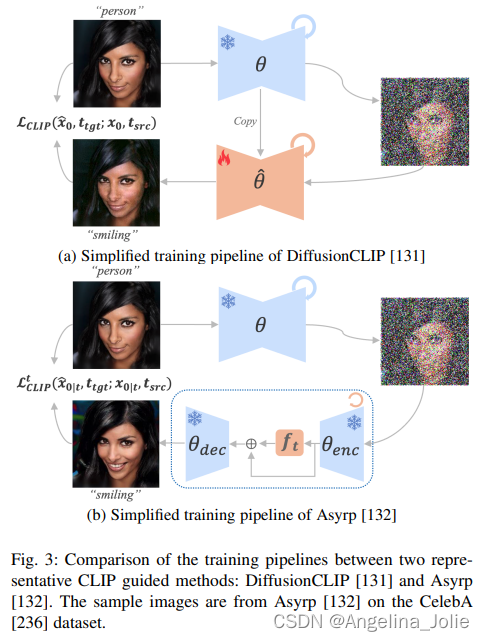

比较两种有代表性的CLIP导引方法:DiffusionCLIP 和 Asyrp 的框架图。样本图像来自CelebA数据集上的Asyrp

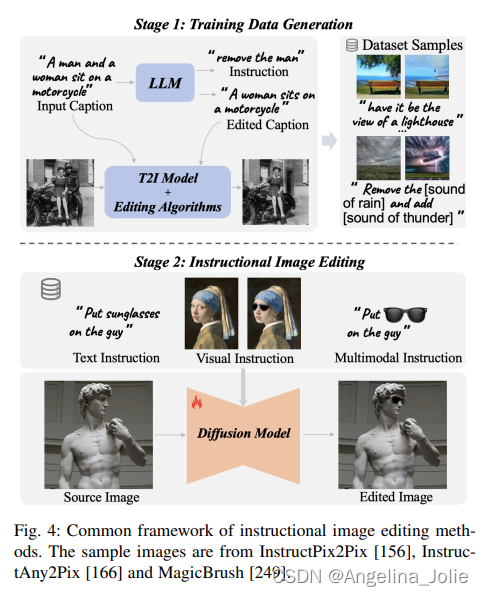

指令图像编辑方法的通用框架。示例图像来自InstructPix2Pix、InstructAny2Pix和MagicBrush。

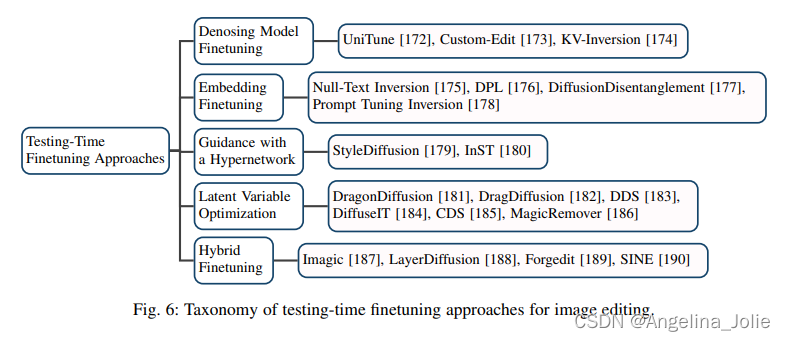

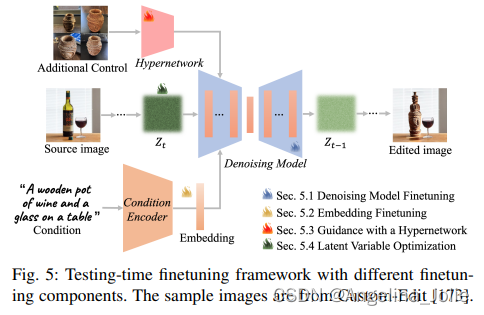

微调大类的分类属性图以及框架图

使用不同微调组件的微调框架。样本图像来自Custom-Edit。

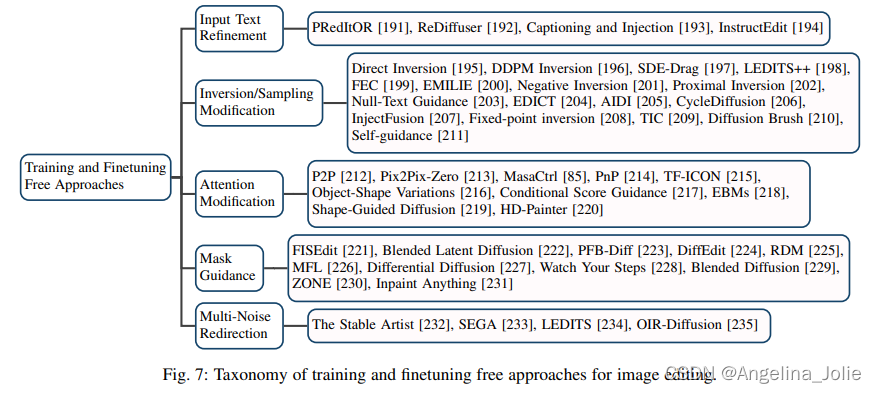

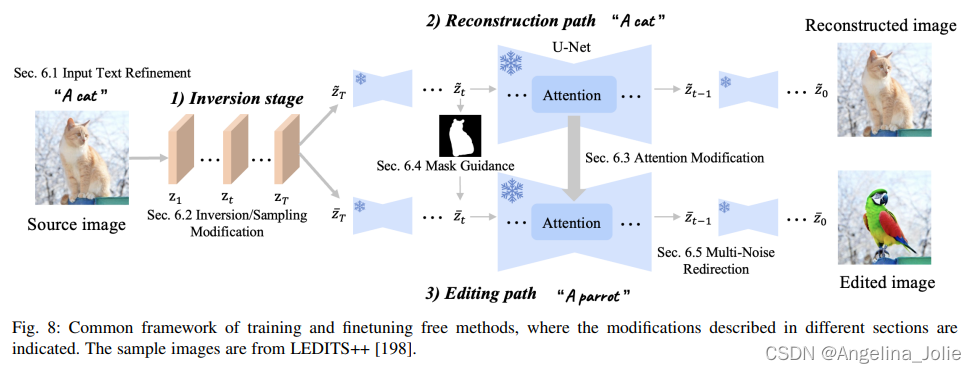

免训练大类的分类属性图以及框架图

免训练方法的通用框架,其中指出了不同部分中描述的修改。样本图片来自LEDITS++。

Benchmark

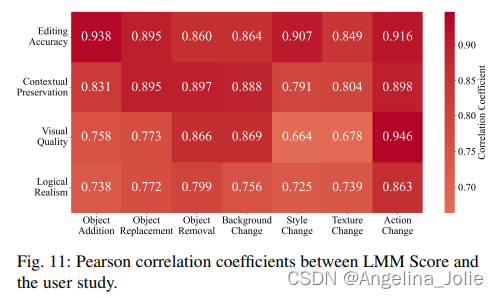

LMM Score与用户研究的皮尔逊相关系数。

LMM Score/CLIPScore与用户研究的皮尔逊相关系数比较。

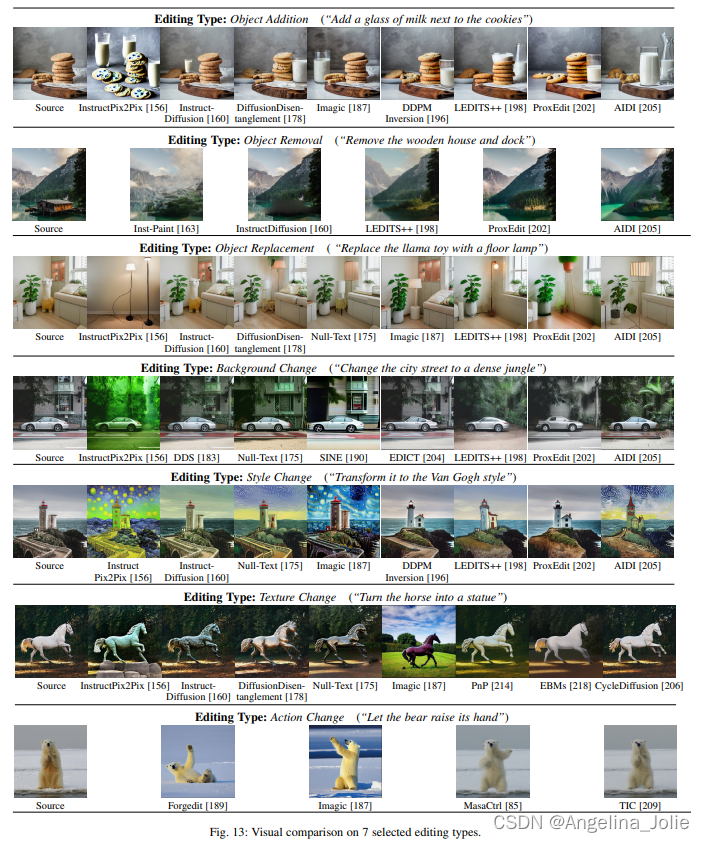

对7种选定的编辑类型进行直观比较。

对7种选定的编辑类型进行直观比较。

这篇关于基于扩散模型的图像编辑:首篇综述的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!