本文主要是介绍深度神经网络联结主义的本质,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、介绍

在新兴的人工智能 (AI) 领域,深度神经网络 (DNN) 是一项里程碑式的成就,突破了机器学习、模式识别和认知模拟的界限。这一技术奇迹的核心是一个与认知科学本身一样古老的思想:联结主义。本文深入探讨了联结主义的基本原理,探讨了它对深层神经网络的发展和功能的影响,并说明了它在模拟反映人类智能的复杂认知任务中的重要性。

在神经元和突触错综复杂的舞蹈中,深层神经网络体现了联结主义的本质,用简单的线索编织了一幅认知的挂毯。

二、背景知识

深度神经网络 (DNN) 的主要基本思想确实是联结主义,这是认知科学中的一个概念,它提出人类思维的认知过程是大脑中简单单元(神经元)之间庞大连接网络的结果。这一思想通过以下方式反映在深度神经网络的架构和功能中:

- 来自生物神经网络的启发: DNN 的基本单元是人工神经元或节点,它模仿大脑中生物神经元的功能。这些人工神经元接收输入,对其进行处理,然后将输出传递到下一层神经元,类似于生物神经元传输信号的方式。

- 分层结构:深度神经网络由多层神经元组成,包括输入层、隐藏层和输出层。这种分层结构允许对信息进行抽象和分层处理,从早期层的简单模式到较深层的复杂概念。这反映了在大脑中观察到的分层处理。

- 连接权重: DNN 中神经元之间的连接由权重表示,权重在训练过程中进行调整。这种学习过程类似于大脑从经验中学习时突触的加强或减弱。

- 并行处理:正如大脑通过神经元的并行操作处理信息一样,DNN 利用现代计算硬件的并行处理能力来同时处理大量数据。

- 从经验中学习:深度神经网络从大量数据中学习,其方式类似于人类从经验中学习的方式。通过称为反向传播的过程,DNN 根据输出误差调整连接权重,随着时间的推移逐渐提高其任务性能。

在深度神经网络中实现的连接主义强调分布式表示和并行计算以实现学习和泛化的能力。这使得 DNN 在图像和语音识别、自然语言处理等许多其他任务中特别有效,它们可以捕获数据中的复杂模式和关系。

三、历史背景和理论基础

联结主义的根源可以追溯到早期的心理学理论和计算模型,这些理论和计算模型试图理解人脑如何处理信息。它假设认知过程源于一个巨大的简单单元网络的相互作用,类似于大脑中的神经元。这种观点与经典的符号人工智能形成鲜明对比,后者依赖于基于明确规则的符号操作来模仿智能。联结主义提供了一种更细致、受生物学启发的方法,表明智能是从相互关联的单元的集体动态中产生的。

四、深度神经网络的架构

深度神经网络通过人工神经元或节点的结构化层体现了联结主义的原理。这些层包括输入层、隐藏层和输出层,每个层都包含执行简单计算的单元。DNN 中的“深度”是指存在多个隐藏层,这些隐藏层使网络能够对数据中复杂的分层模式进行建模。这种架构允许逐渐抽象特征,从初始层的基本形状或声音到更深层次的复杂概念和表示,反映了在人脑中观察到的认知分层。

五、通过联系学习

DNN 中学习的本质以及扩展连接主义在于神经元之间连接权重的调整。这些权重决定了一个神经元对另一个神经元的强度和影响,类似于生物神经元之间的突触强度。通过称为反向传播的过程,DNN 根据其输出与期望结果之间的差异迭代地调整这些权重。这种学习机制反映了人脑的可塑性,可根据新的经验和信息进行自我调整和重组。

六、并行处理和分布式表示

连接主义强调并行处理和分布式表示的重要性,这两者都是 DNN 操作所固有的。正如大脑通过其神经网络同时处理多个刺激一样,DNN 利用现代计算能力同时执行大量计算。此外,DNN 中的信息并不局限于单个神经元。相反,它分布在整个网络中,从而实现信息处理的稳健性和灵活性。这种表示和计算的分布式特性使 DNN 能够处理数据中的歧义、噪声和复杂性,就像人类认知系统一样。

七、影响和启示

深度神经网络的联结主义基础推动了人工智能的重大进步,使机器能够执行以前被认为是人类智能独有的任务。从掌握复杂的游戏到驾驶自动驾驶汽车、实时翻译语言和诊断医疗状况,DNN 的功能不断扩展。这些成就强调了联结主义作为人工智能研究指导原则的力量,凸显了 DNN 模拟并在某些方面超越人类认知能力的潜力。

八、参考代码

为了使用 Python 说明深度神经网络中的连接主义概念,我们可以创建一个简单的示例,其中涉及构建深度神经网络来对合成数据集进行分类。此示例将涵盖生成合成数据集、使用 TensorFlow 和 Keras 构建神经网络模型、训练模型、使用指标评估其性能以及使用绘图可视化结果。

第 1 步:生成综合数据集

我们将首先创建一个适合分类问题的合成数据集。我们可以使用 scikit-learn 的make_moons函数生成一个包含两个类之间具有非线性边界的数据集,这可以有效地展示深度神经网络捕获复杂模式的能力。

第 2 步:构建深度神经网络

对于神经网络,我们将使用 TensorFlow 和 Keras 定义多层模型。这将通过神经元的互连层来说明联结主义的概念。

第 3 步:训练模型

我们将编译模型,指定损失函数和优化器,然后在合成数据集上对其进行训练。此步骤将根据训练数据调整网络中连接的权重。

第 4 步:评估模型

训练后,我们将使用准确性作为指标来评估模型在测试集上的性能。

第 5 步:可视化结果

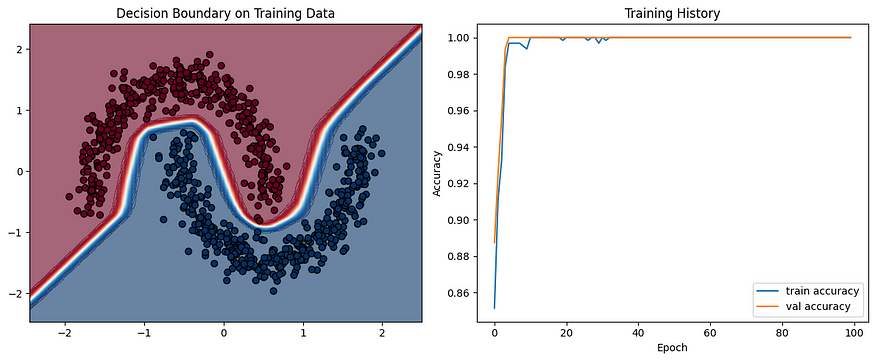

最后,我们将绘制网络学习的决策边界和训练历史,以直观地评估模型如何学习对合成数据集进行分类。

让我们用 Python 来实现这些步骤:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_moons

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

from tensorflow.keras.optimizers import Adam# Step 1: Generate a synthetic dataset

X, y = make_moons(n_samples=1000, noise=0.1, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# Standardize the data

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)# Step 2: Build the deep neural network

model = Sequential([Dense(64, activation='relu', input_shape=(2,)),Dense(64, activation='relu'),Dense(1, activation='sigmoid')

])# Step 3: Train the model

model.compile(optimizer=Adam(learning_rate=0.01), loss='binary_crossentropy', metrics=['accuracy'])

history = model.fit(X_train_scaled, y_train, epochs=100, verbose=0, validation_split=0.2)# Step 4: Evaluate the model

test_loss, test_acc = model.evaluate(X_test_scaled, y_test, verbose=0)

print(f"Test Accuracy: {test_acc:.4f}")# Step 5: Visualize the results

# Plotting the decision boundary

def plot_decision_boundary(model, X, y):x_min, x_max = X[:, 0].min() - 0.5, X[:, 0].max() + 0.5y_min, y_max = X[:, 1].min() - 0.5, X[:, 1].max() + 0.5xx, yy = np.meshgrid(np.linspace(x_min, x_max, 100), np.linspace(y_min, y_max, 100))Z = model.predict(np.c_[xx.ravel(), yy.ravel()])Z = Z.reshape(xx.shape)plt.contourf(xx, yy, Z, levels=np.linspace(Z.min(), Z.max(), 100), cmap='RdBu', alpha=0.6)plt.scatter(X[:, 0], X[:, 1], c=y, s=40, cmap='RdBu', edgecolors='k')plt.xlim(xx.min(), xx.max())plt.ylim(yy.min(), yy.max())plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plot_decision_boundary(model, X_train_scaled, y_train)

plt.title("Decision Boundary on Training Data")# Plotting training history

plt.subplot(1, 2, 2)

plt.plot(history.history['accuracy'], label='train accuracy')

plt.plot(history.history['val_accuracy'], label='val accuracy')

plt.title('Training History')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.tight_layout()

plt.show()测试精度:1.0000

313/313 [================================] - 1s 1ms/步

此代码片段演示了从数据准备到模型评估和可视化的整个过程。通过执行它,您可以观察深度神经网络如何学习对非线性可分离数据集进行分类,从而展示联结主义的实际原理。

九、结论

连接主义强调互连单元的涌现属性,为理解和开发深度神经网络提供了一个令人信服的框架。通过从人脑的结构和功能中汲取灵感,DNN 融合了计算效率和认知深度,弥合了人工智能和自然智能形式之间的差距。随着我们不断探索联结主义的深度,深度神经网络的进化有望进一步阐明认知的奥秘并开启人工智能的新领域。

这篇关于深度神经网络联结主义的本质的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!