本文主要是介绍【kubernetes】关于k8s集群中kubectl的陈述式资源管理,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

一、k8s集群资源管理方式分类:

(1)陈述式资源管理方式:增删查比较方便,但是改非常不方便

(2)声明式资源管理方式:yaml文件管理

二、陈述式资源管理方法:

三、kubectl命令分类:

(1)基本管理信息查看

查看版本信息

查看资源对象简写

查看集群信息

设置配置kubectl自动补全

查看node节点的日志

master节点状态查看

查看资源对象的通用命令格式

(2)针对资源对象信息的增删查

创建资源对象信息

删除资源对象

查看资源对象的详细信息

pod的扩容与缩容

跨主机登录容器

查看日志

四、项目的生命周期

关于创建

关于发布

关于更新

关于回滚

关于删除

五、详解service资源

(1)service的端口分类

(2)service的四大基础类型

(3)查看service关联的端点的方式

一、k8s集群资源管理方式分类:

(1)陈述式资源管理方式:增删查比较方便,但是改非常不方便

使用一条kubectl命令和参数选项来实现资源对象管理操作

(2)声明式资源管理方式:yaml文件管理

使用yaml配置文件里定义的配置,实现资源对象的管理操作

二、陈述式资源管理方法:

1.kubernetes 集群管理集群资源的唯一入口是通过相应的方法调用 apiserver 的接口

2.kubectl 是官方的CLI命令行工具,用于与 apiserver 进行通信,将用户在命令行输入的命令,组织并转化为 apiserver 能识别的信息,进而实现管理 k8s 各种资源的一种有效途径

3.kubectl 的命令大全:kubectl --help

k8s中文文档:http://docs.kubernetes.org.cn/683.html

4.对资源的增、删、查操作比较方便,但对改的操作就不容易了

三、kubectl命令分类:

(1)基本管理信息查看

查看版本信息

kubectl version

#查看版本

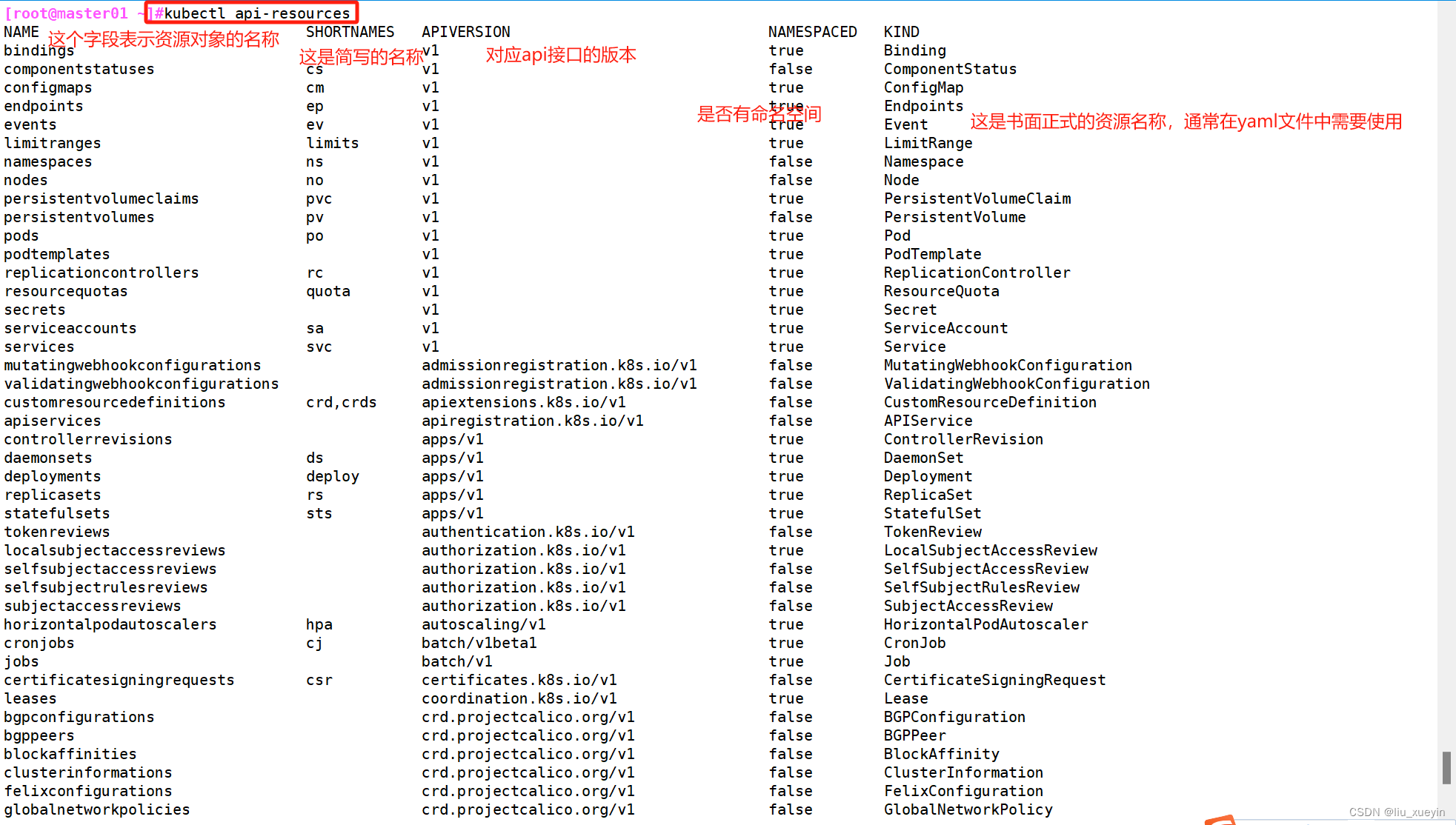

查看资源对象简写

//查看资源对象简写

kubectl api-resources

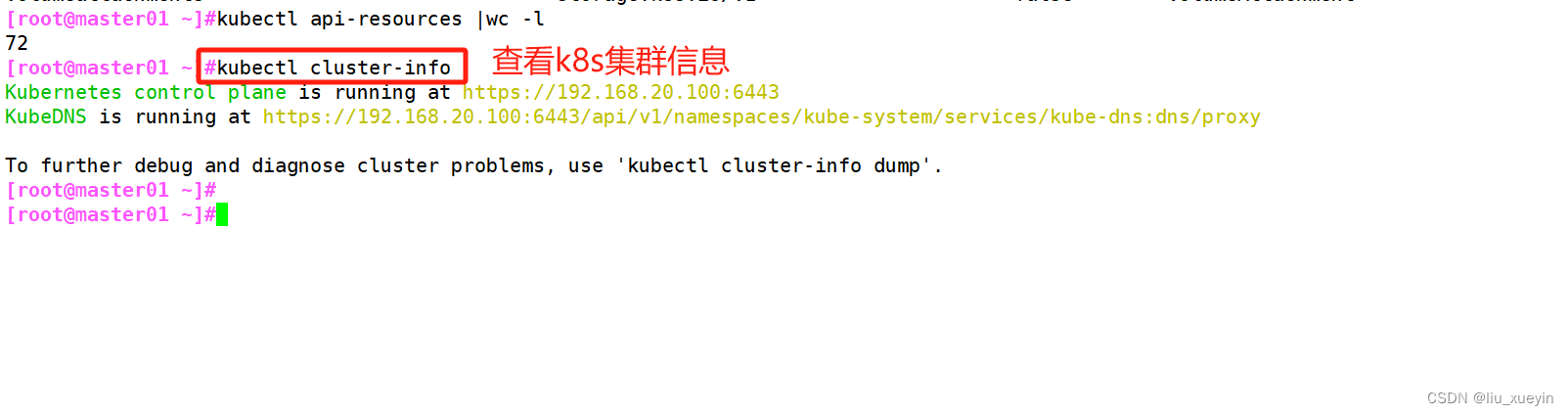

查看集群信息

//查看集群信息

kubectl cluster-info

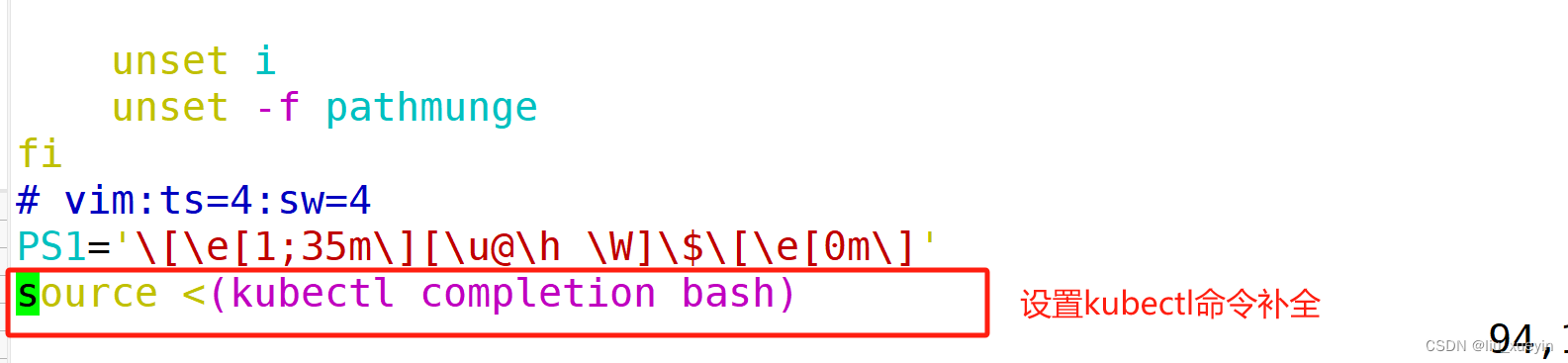

设置配置kubectl自动补全

//配置kubectl自动补全

source <(kubectl completion bash)可以配置的文件有很多

~/.nashrc

~/.bash_profile ##需要用source加载一下

/etc/profile ##需要用source加载一下

/etc/bashrc

查看node节点的日志

//node节点查看日志

journalctl -u kubelet -f

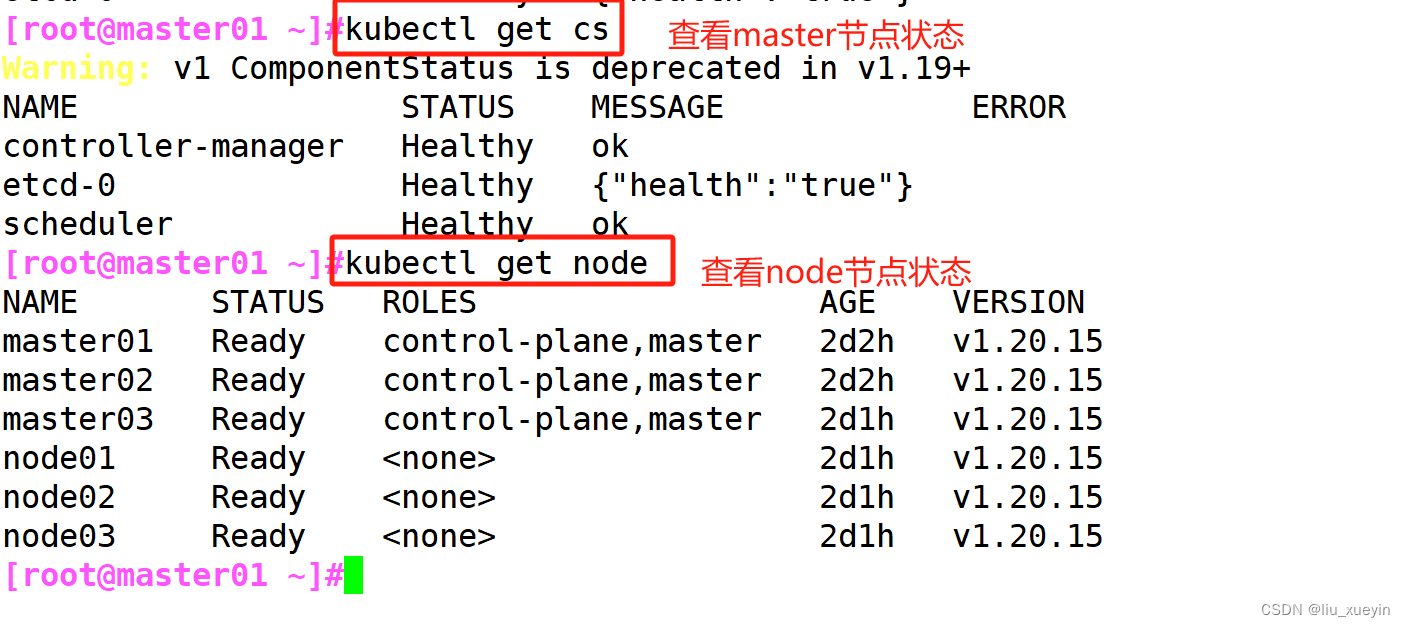

master节点状态查看

//查看master节点的状态

kubectl get cs

cs是componentstatus的简写//查看node节点的状态

kubectl get nodes

查看资源对象的通用命令格式

kubectl get <资源对象类型> <资源名称> -n <指定命名空间> [-o wide|json|yaml] --show-label [-l 标签key-值value]-n 指定命令空间

-o 指定输出格式

resource可以是具体资源名称,如pod nginx-xxx;也可以是资源类型,如pod;或者all(仅展示几种核心资源,并不完整)

--all-namespaces 或 -A :表示显示所有命名空间,

--show-labels :显示所有标签

-l app :仅显示标签为app的资源

-l app=nginx :仅显示包含app标签,且值为nginx的资源

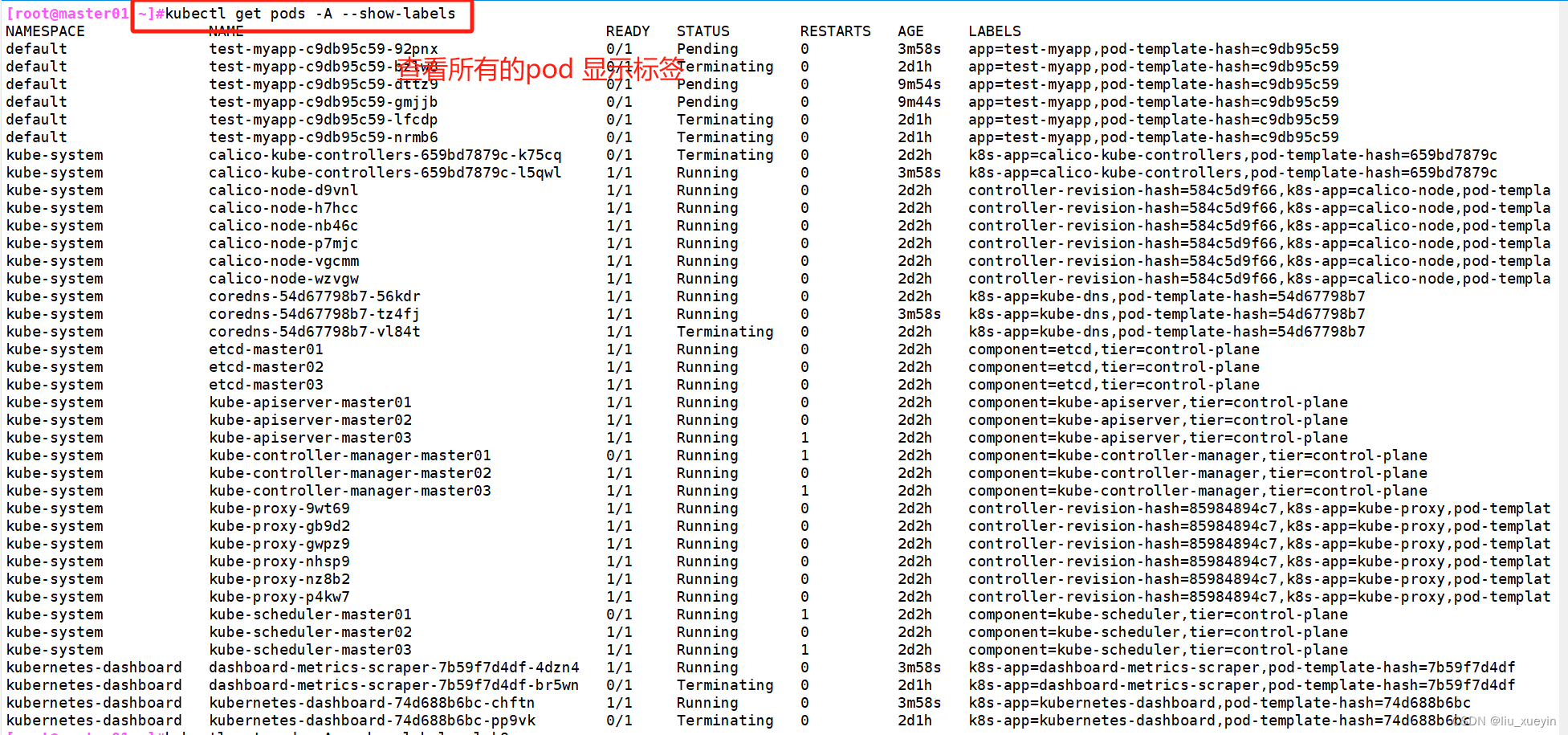

[root@master01 ~]#kubectl get pods -A --show-labels

//查看所有的pod以及显示标签

[root@master01 ~]#kubectl get pods -A --show-labels -l k8s-app

//过滤k8s-app的标签名称[root@master01 ~]#kubectl get pods -A --show-labels -l k8s-app=kube-dns

//过滤k8s-app:kube-dns的标签

[root@master01 ~]#kubectl get all -n default

//查看关键的资源类型

通常-n 命名空间放在前面

all 表示查看关键的资源 包含pod控制器、pod资源、service资源

(2)针对资源对象信息的增删查

创建资源对象信息

创建命名空间

//查看命名空间

kubectl get namespace

kubectl get ns

//命令空间的作用:用于允许不同 命名空间 的 相同类型 的资源 重名的//查看default命名空间的所有资源

kubectl get all [-n default]//创建命名空间app

kubectl create ns app

kubectl get ns

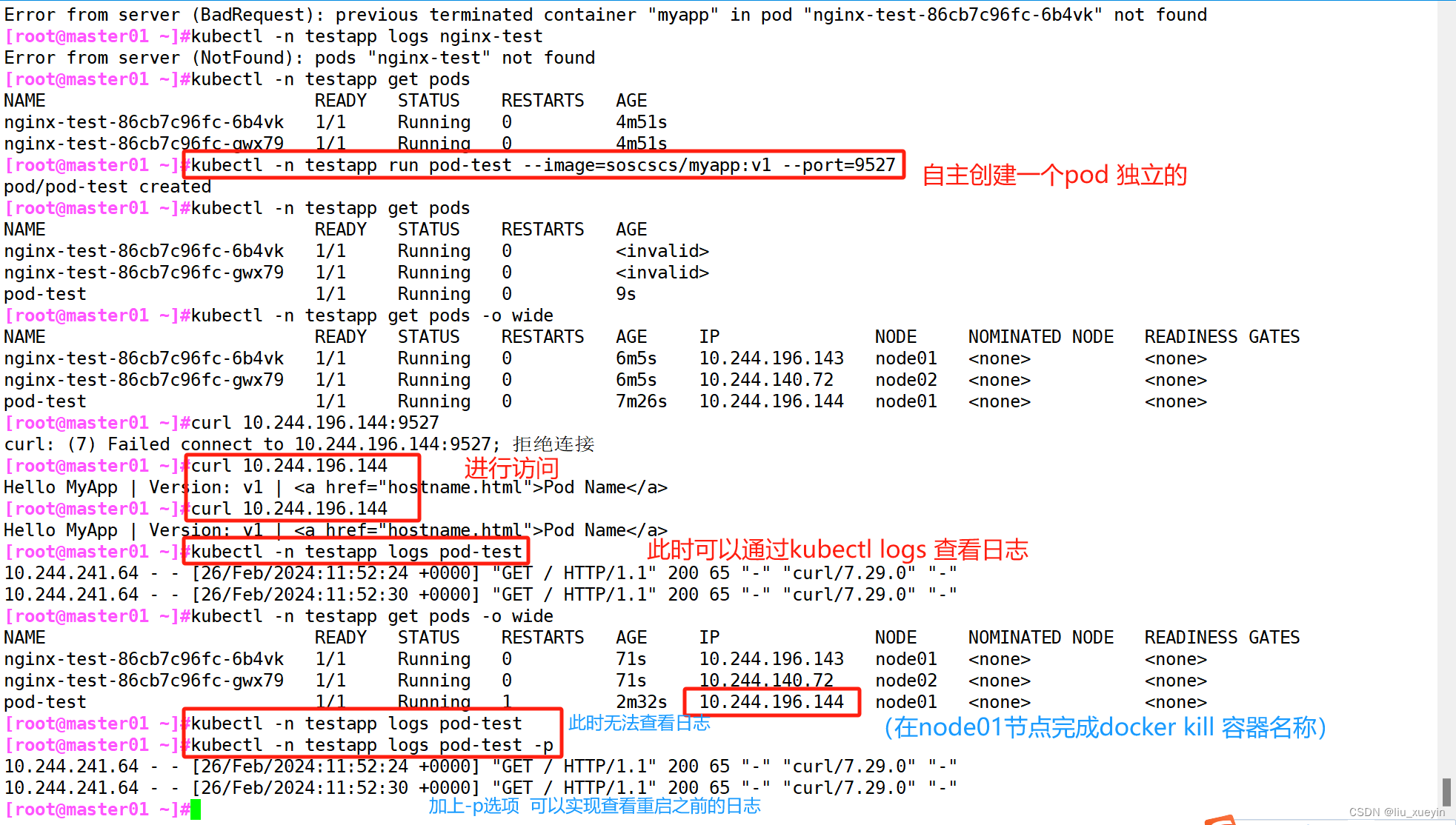

基于pod控制器创建pod资源

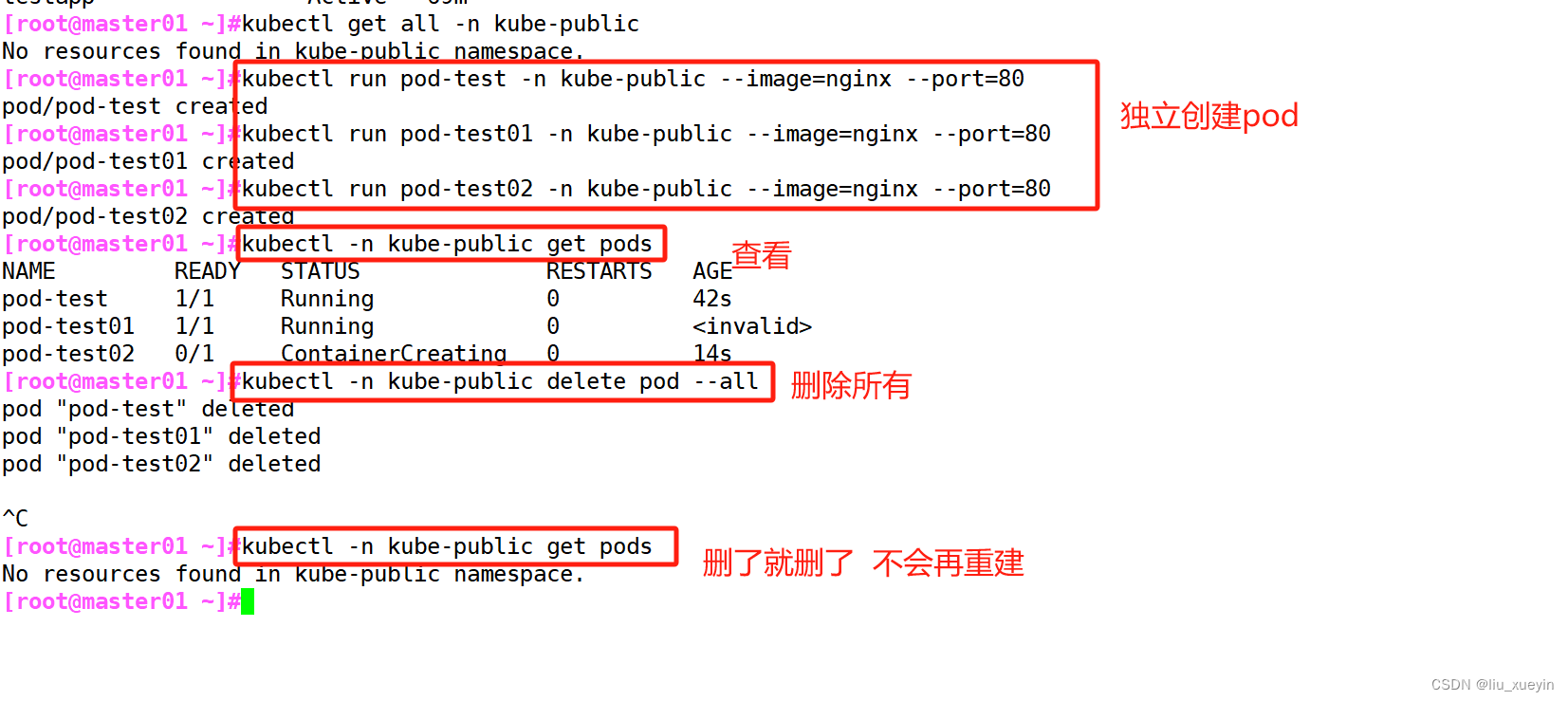

独立创建pod资源

kubectl -n 命名空间 run pod名称 --image=镜像 --port=容器端口

//独立创建pod资源kubectl run pod-test02 -n kube-public --image=nginx --port=80//删除所有

kubectl -n 命名空间 delete pod --all

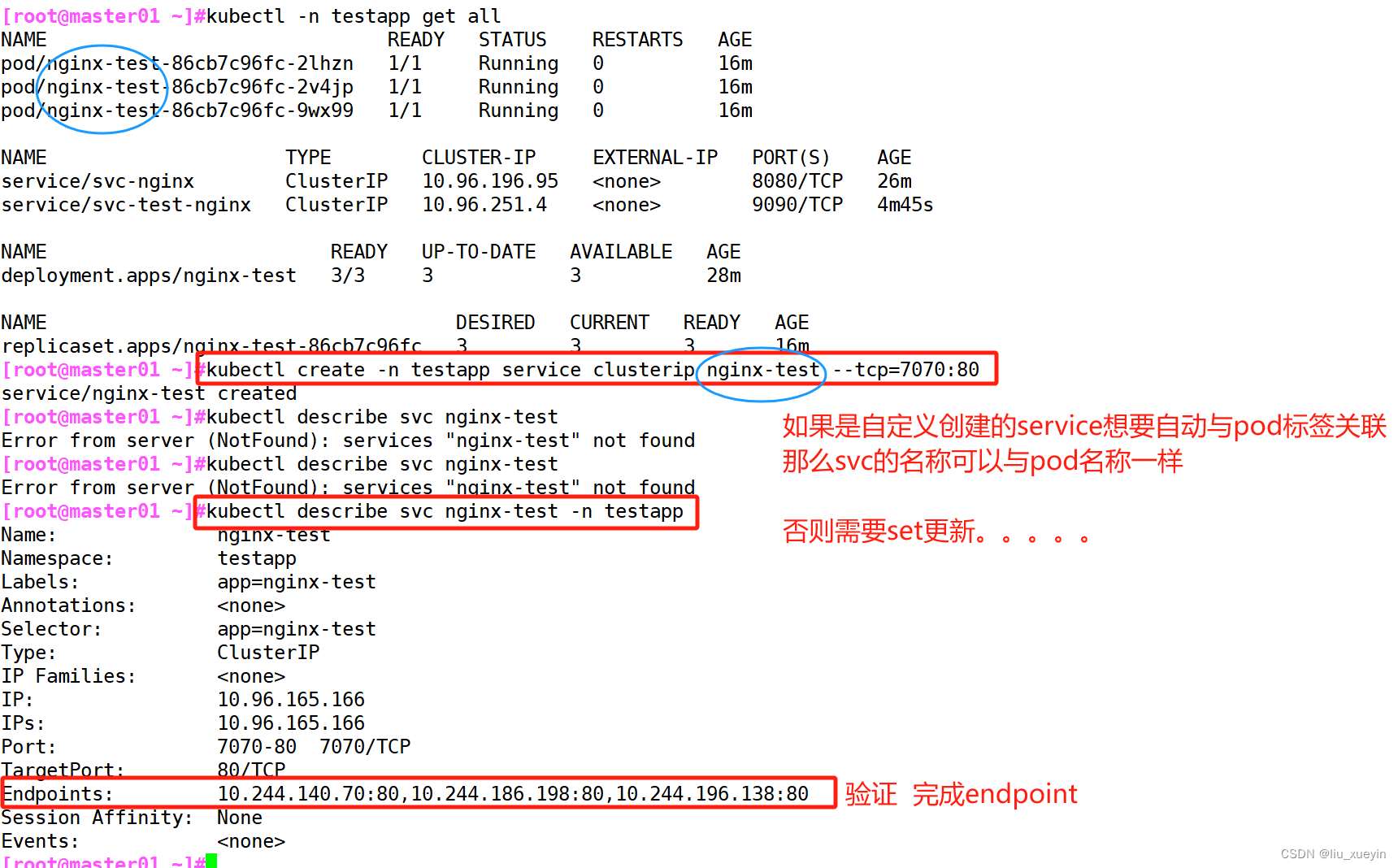

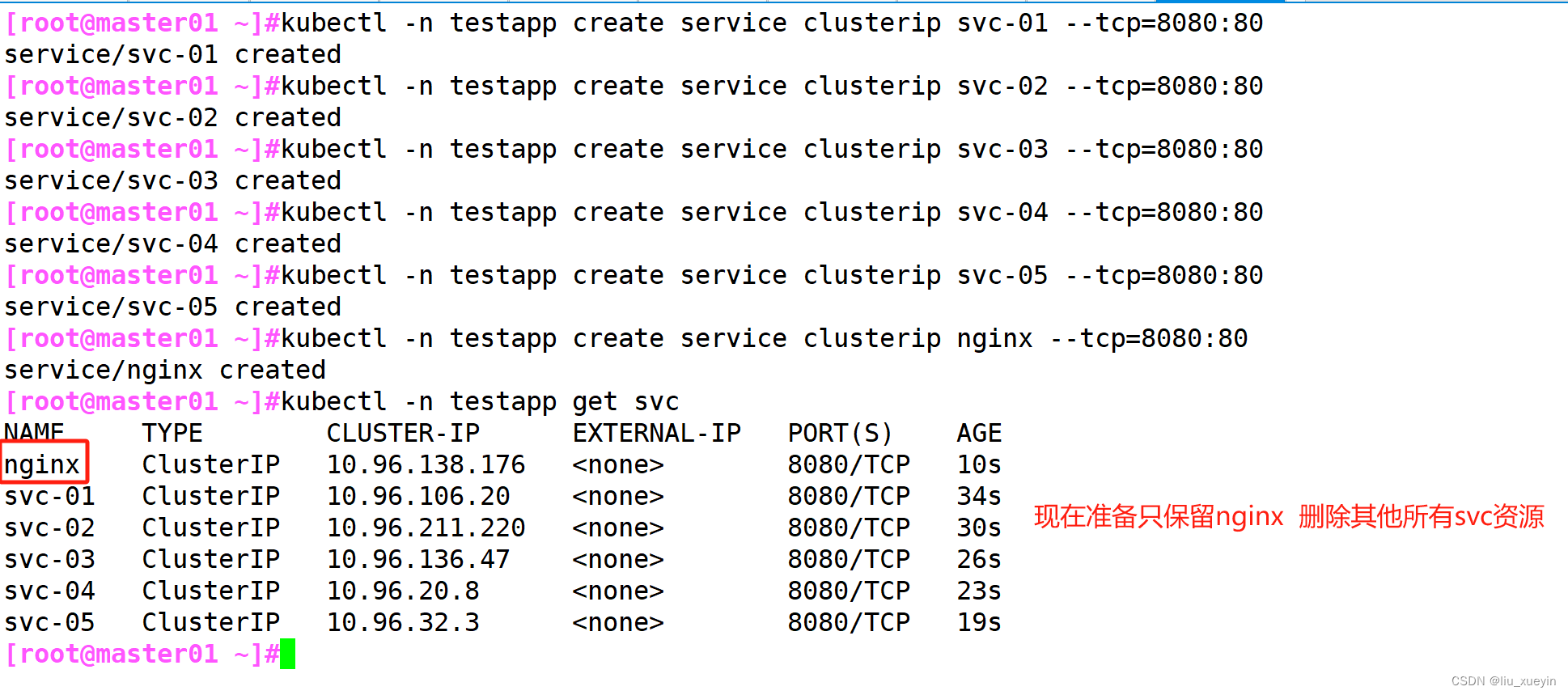

创建service资源的方式

两种方式:

- 基于deployment创建

- 一种直接创建

基于deployment创建

kubectl expose -n 命名空间 pod控制器类型 资源名称 --name=svc名称 --port指定clusterip端口 --type指定service类型 --target-port 指定pod的端口

//基于pod控制器创建service资源kubectl expose -n testapp deployment nginx-test --name=svc-nginx --port=8080 --target-port=80

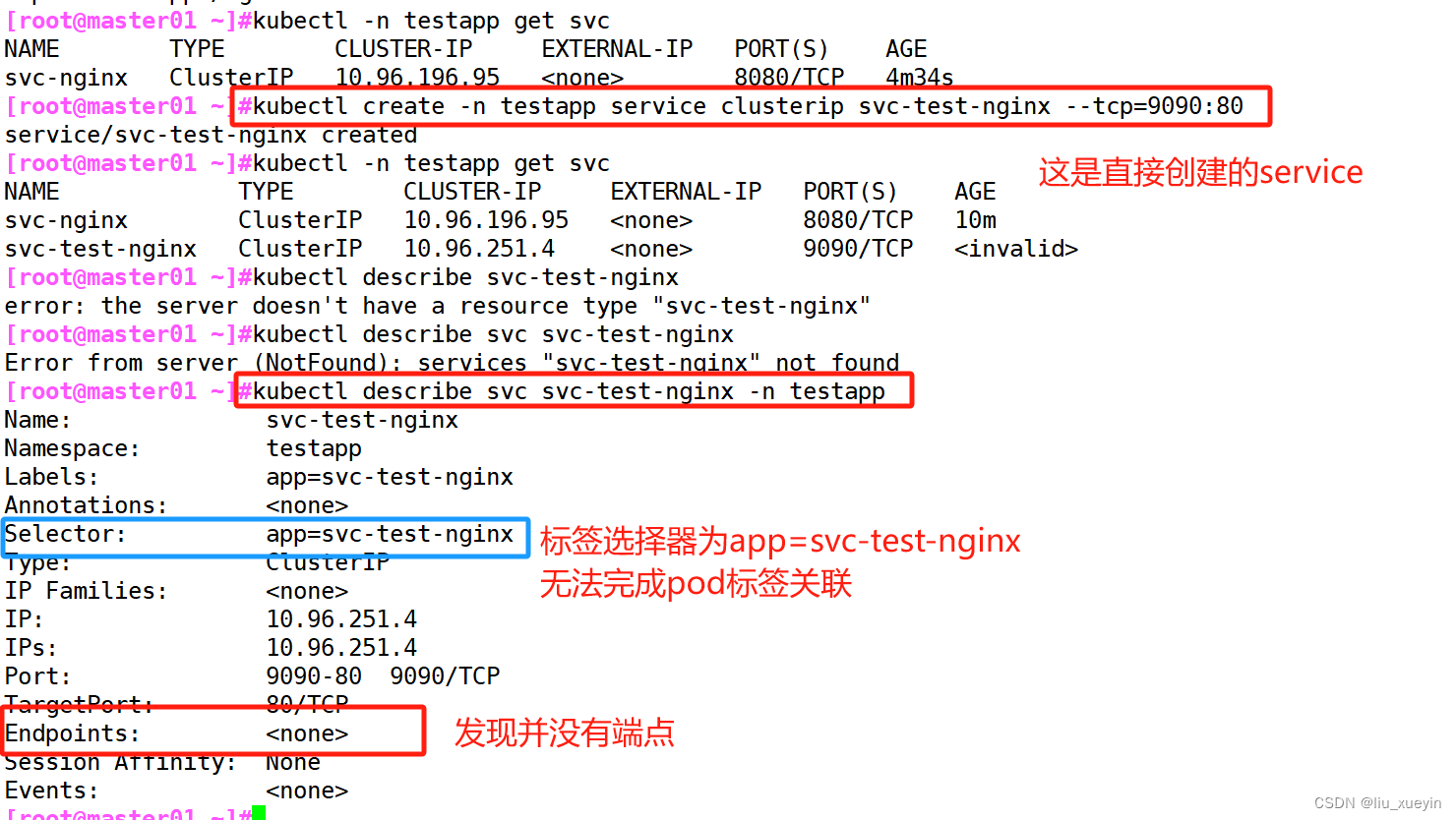

一种直接创建

kubectl -n 命名空间 create service svc资源类型 svc资源名称 --tcp=clusterip的端口:容器的端口kubectl create -n testapp service clusterip svc-test-nginx --tcp=9090:80

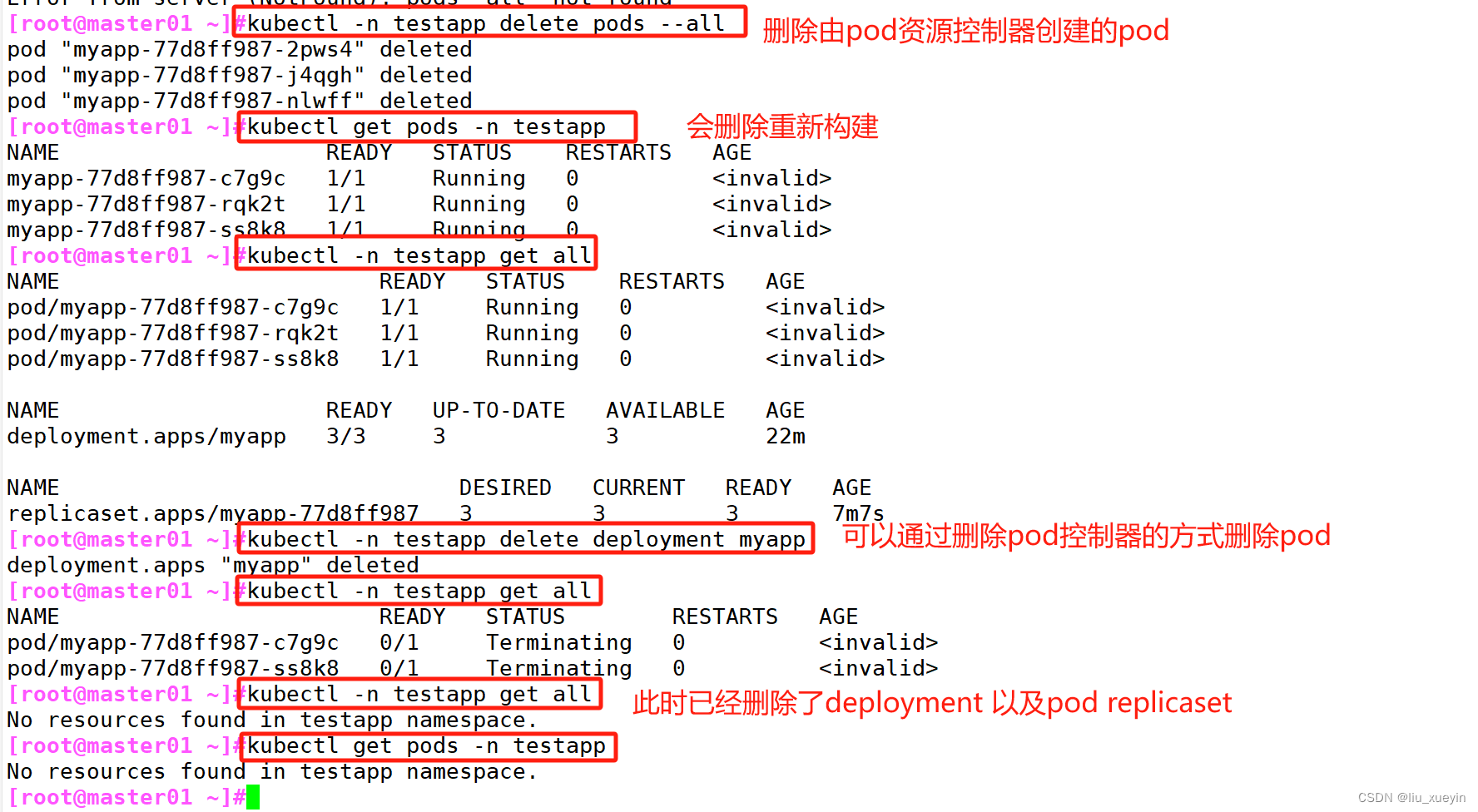

删除资源对象

kubectl < -n 命名空间>delete <资源类型> <资源名称> [--force --grace-period=0] [ --all ]

--force --grace-period=0 强制删除,默认情况下会先发送sigterm信号 等待30秒以后 强制删除

--all 表示删除所有

//若pod无法删除,总是处于terminate状态,则要强行删除pod

kubectl delete pod <pod-name> -n <namespace> --force --grace-period=0

#grace-period表示过渡存活期,默认30s,在删除pod之前允许pod慢慢终止其上的容器进程,从而优雅退出,0表示立即终止pod

删除命名空间

kubectl delete ns accp

//kubectl delete ns 命名空间资源名称

删除pod资源

[root@master01 ~]#kubectl -n testapp delete pods --all

//删除testapp命名空间的所有pod 针对pod控制器管理的pod,删除pod会重新被拉取

针对kubectl run自行创建的pod可以直接删除//删除(重启)pod资源,由于存在deployment/rc之类的副本控制器,删除pod也会重新拉起来

如果非要删除pod控制器创建的pod,那么需要先删除pod控制器

kubectl -n testapp delete deployment myapp

//删除pod控制器资源 来删除 对应的pod

可以使用kubectl get pods -n testapp -w 实时查看pod的变化

kubectl get pods -n 命名空间 -w

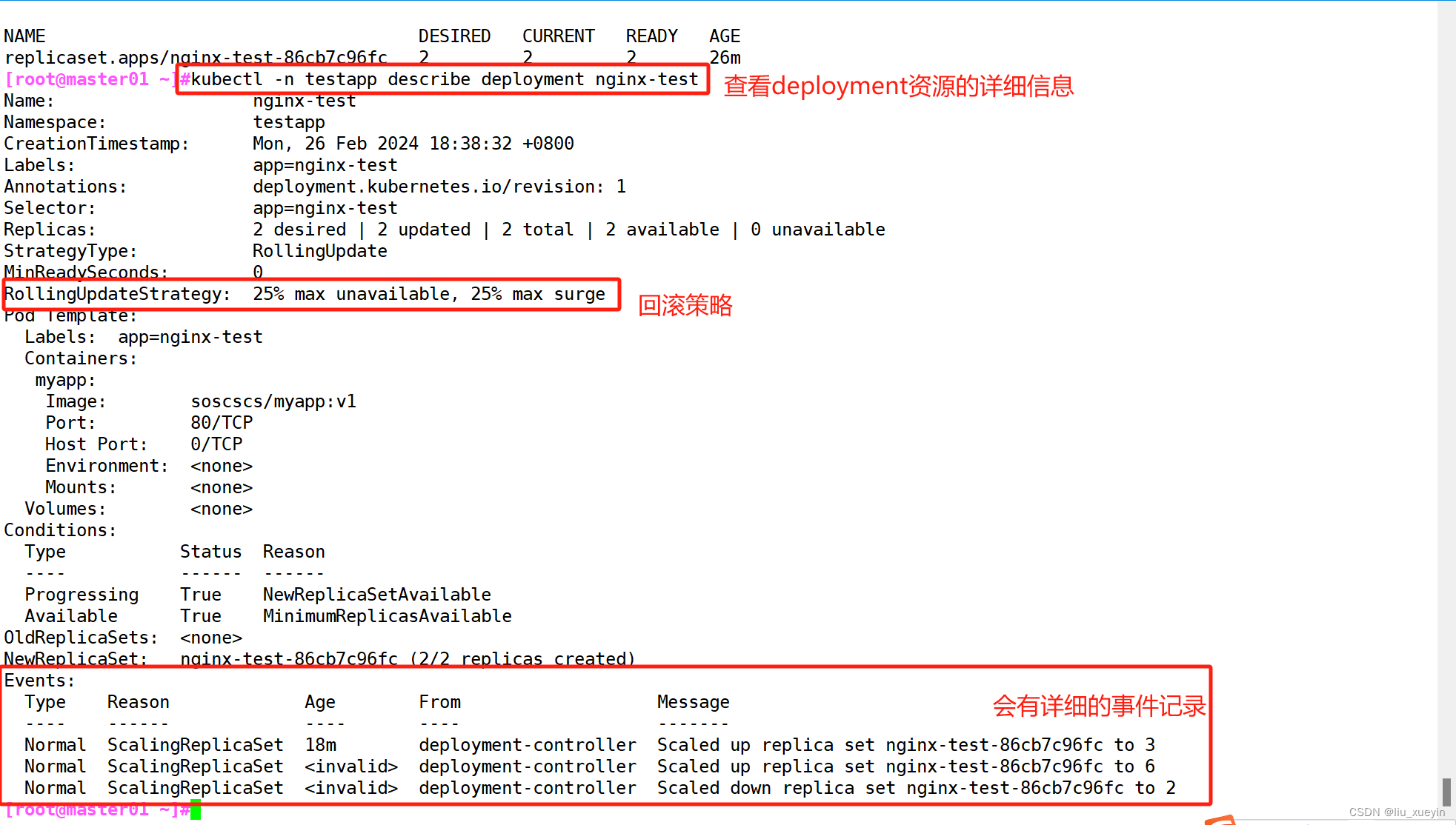

查看资源对象的详细信息

kubectl -n 命名空间 describe 资源类型 资源名称

//查看资源详细信息kubectl -n testapp describe svc nginx-test

kubectl -n 命名空间 describe deployment nginx-test

//查看deployment资源的详细信息

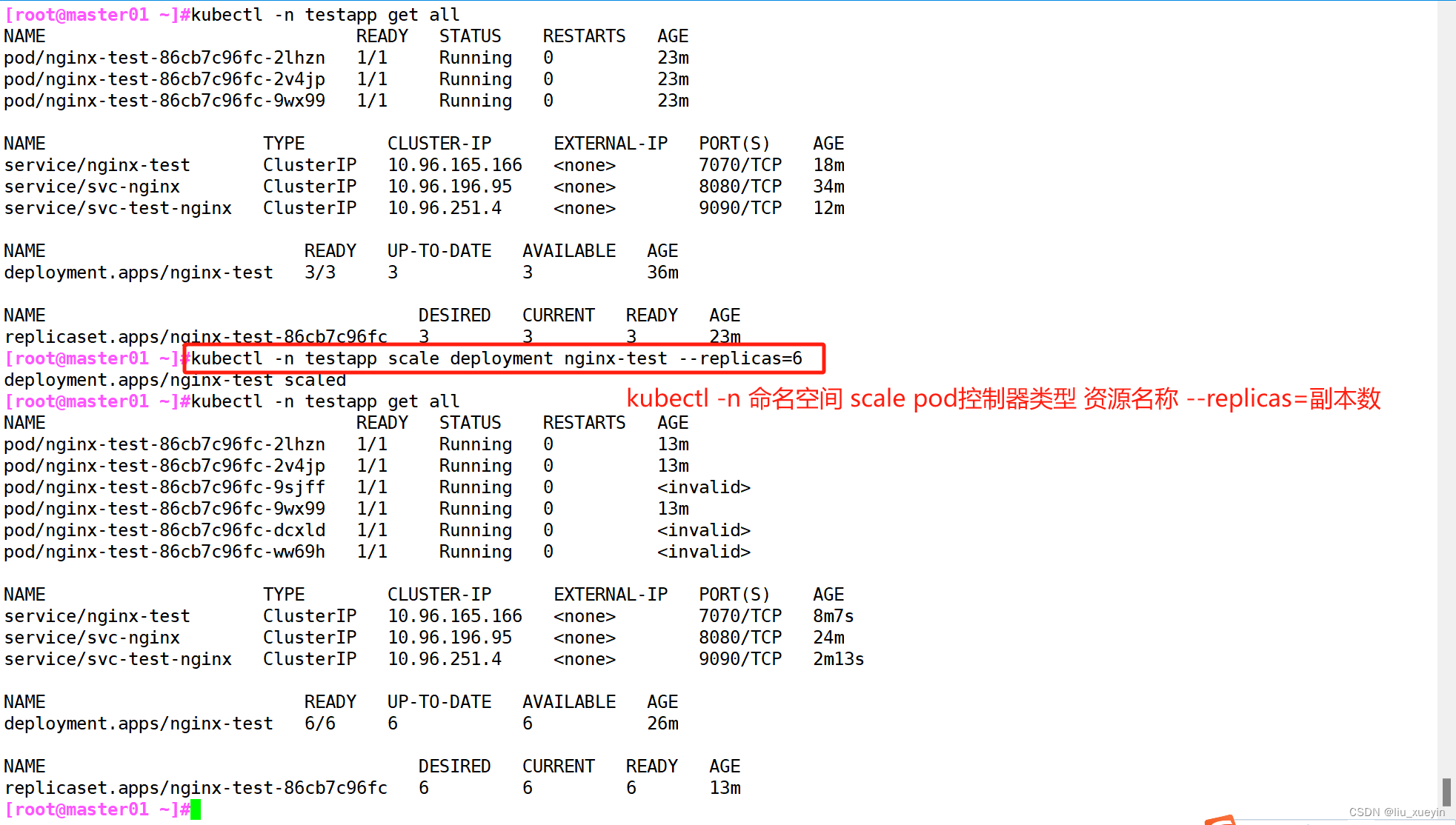

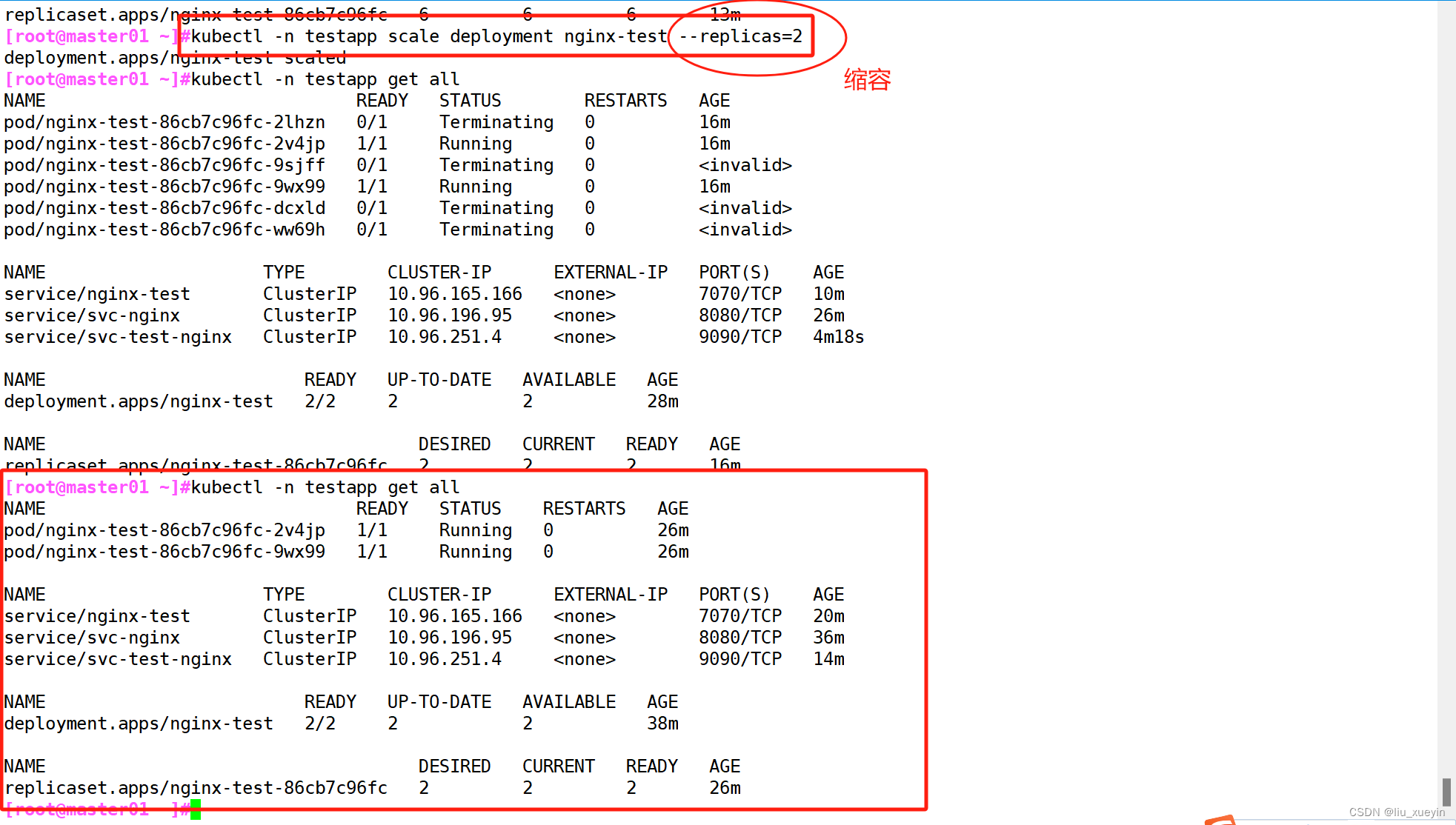

pod的扩容与缩容

kubectl -n 命名空间 scale pod控制器类型 资源名称 --replicas=副本数

##副本数决定扩容还是缩容kubectl -n testapp scale deployment nginx-test --replicas=6

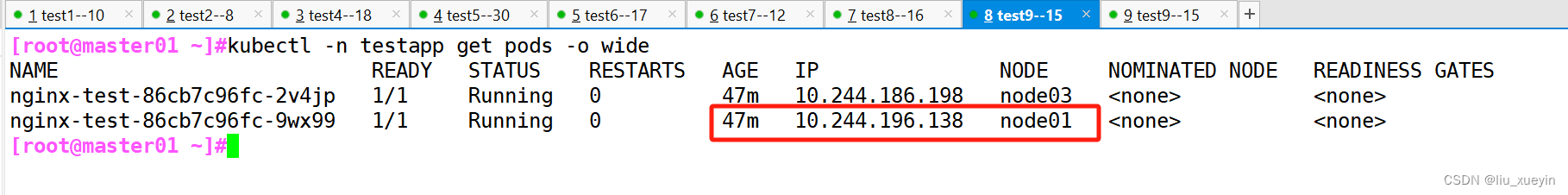

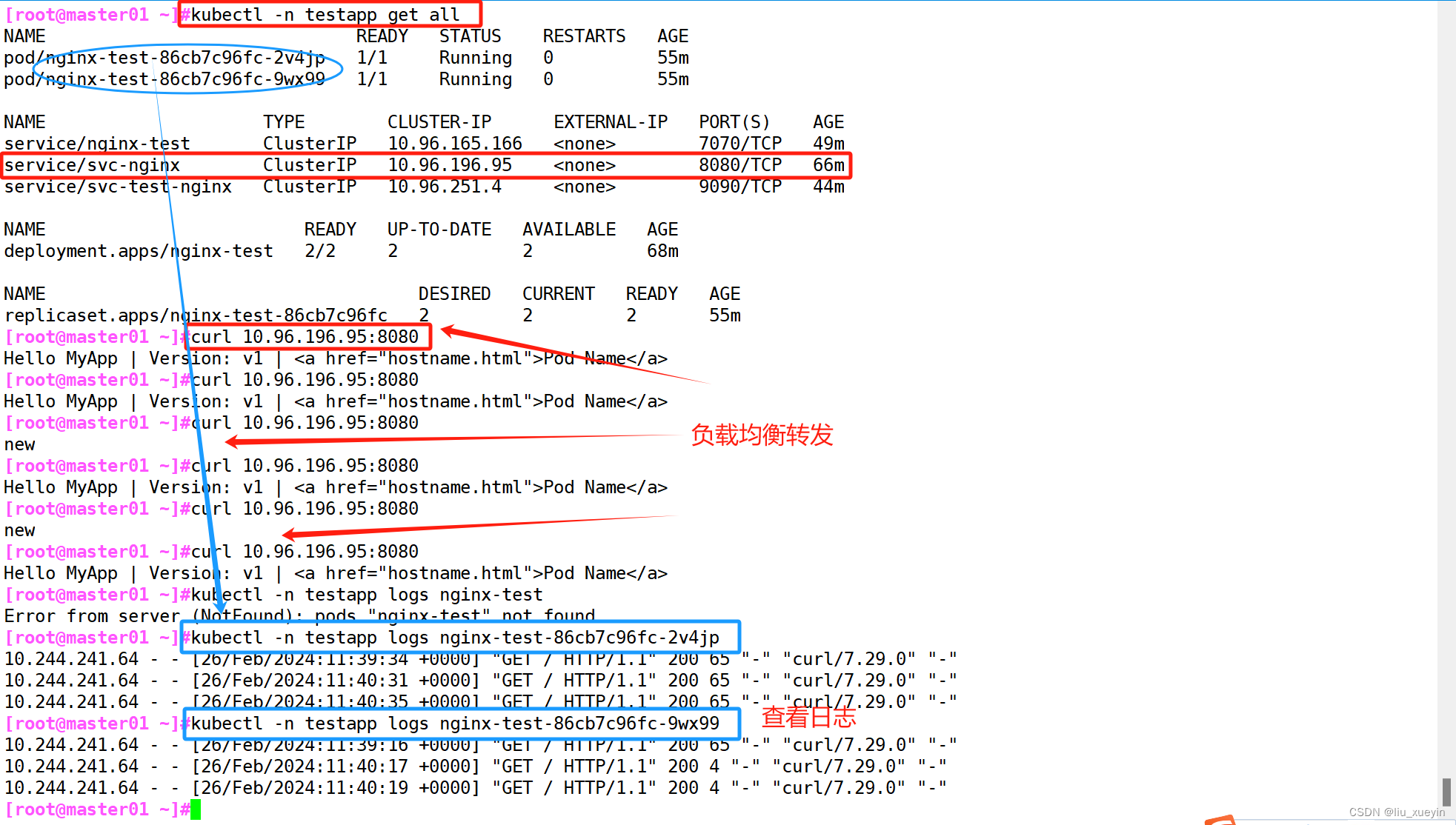

跨主机登录容器

//kubectl exec可以跨主机登录容器,docker exec 只能在容器所在主机上登录

kubectl -n 命名空间 exec -it 单个pod的名称 --sh|bash|命令 [ -c 容器名称 ]kubectl exec -n testapp -it nginx-test-86cb7c96fc-9wx99 -- cat /test/hello.txt

//命名行查看数据kubectl exec -n testapp -it nginx-test-86cb7c96fc-9wx99 sh

//进入pod容器中

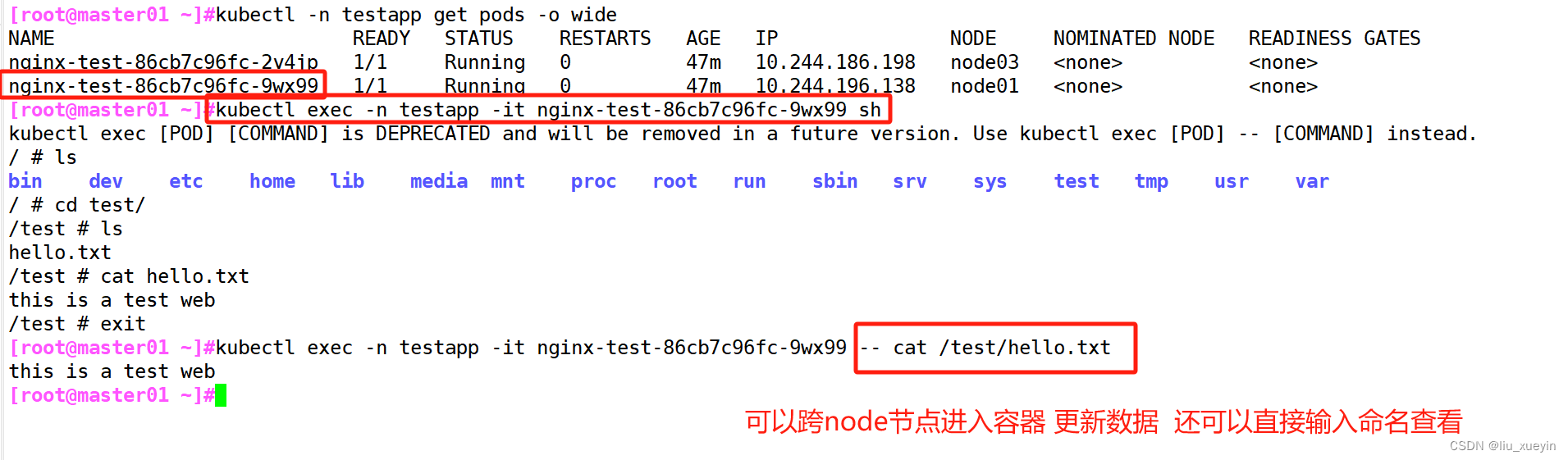

查看日志

kubectl -n 命名空间 logs pod资源名称 [ -c容器名称 ] [ -p ][ -f ]

//查看日志

-c 进入容器

-p表示查看重建pod之前的容器的日志

-f 表示实时查看

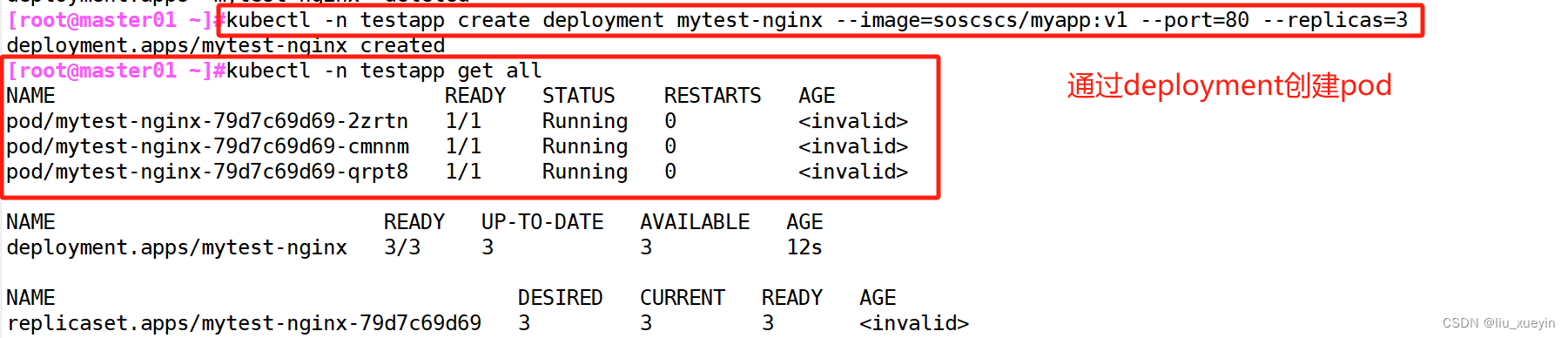

四、项目的生命周期

关于创建

创建 kubectl create命令

●创建并运行一个或多个容器镜像。

●创建一个deployment 或job 来管理容器。

kubectl create --help//启动 nginx 实例,暴露容器端口 80,设置副本数 3

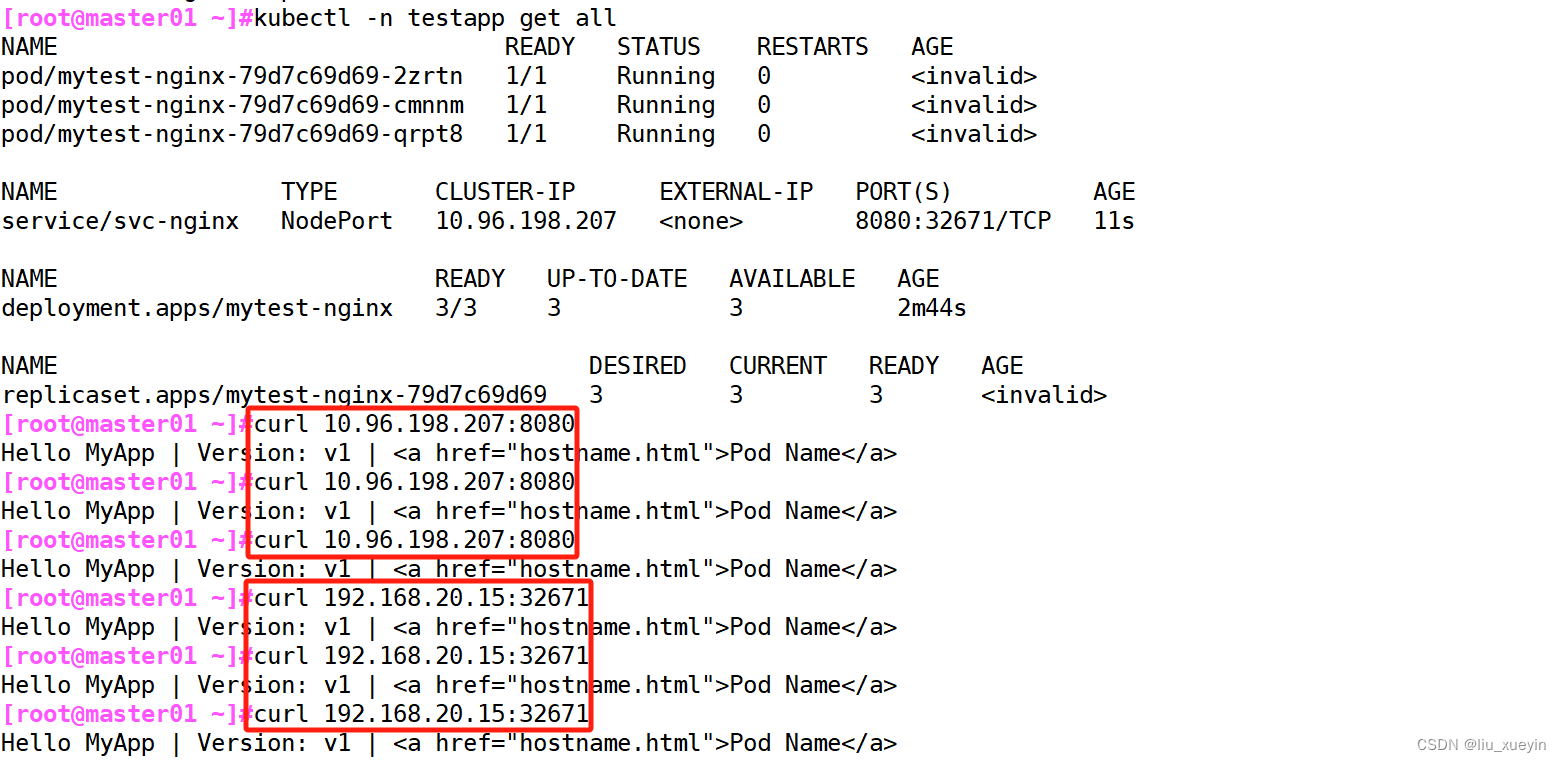

kubectl -n 命名空间 create deployment 资源名称 --image=镜像 --port=容器的端口 --replicas=副本数kubectl -n testapp create deployment mytest-nginx --image=soscscs/myapp:v1 --port=80 --replicas=3kubectl get pods

kubectl get all

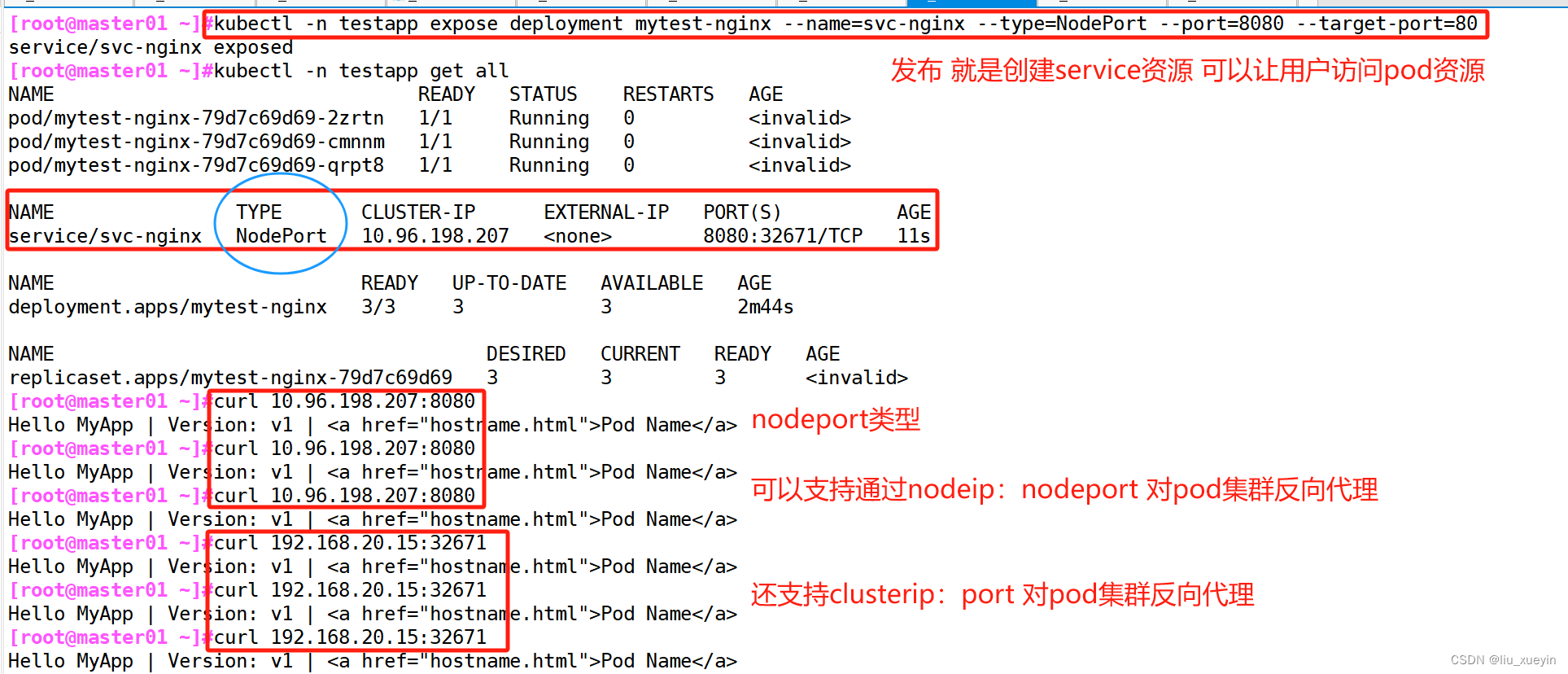

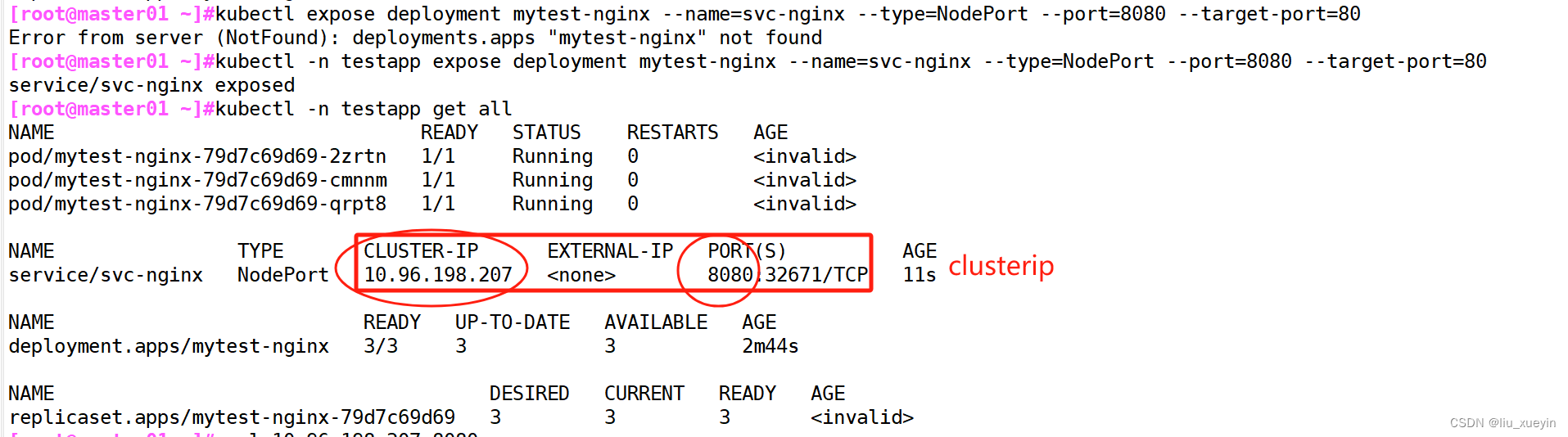

关于发布

发布 kubectl expose命令

●将资源暴露为新的 Service。

kubectl expose --help//为deployment的nginx创建service,并通过Service的8080端口转发至容器的80端口上,Service的名称为svc-nginx ,类型为NodePort

kubectl -n testapp expose deployment mytest-nginx --name=svc-nginx --type=NodePort --port=8080 --target-port=80命令格式kubectl -n 命名空间 expose deployment 资源名称 --name=service名称 --type=service资源类型 --port=clusterip的端口 --target-port=容器的端口

------------------------------------------------------------------------------------------

Kubernetes 之所以需要 Service,一方面是因为 Pod 的 IP 不是固定的(Pod可能会重建),另一方面则是因为一组 Pod 实例之间总会有负载均衡的需求。

Service 通过 Label Selector 实现的对一组的 Pod 的访问。

对于容器应用而言,Kubernetes 提供了基于 VIP(虚拟IP) 的网桥的方式访问 Service,再由 Service 重定向到相应的 Pod。

service 的 type 类型:

●ClusterIP:提供一个集群内部的虚拟IP以供Pod访问(service默认类型)

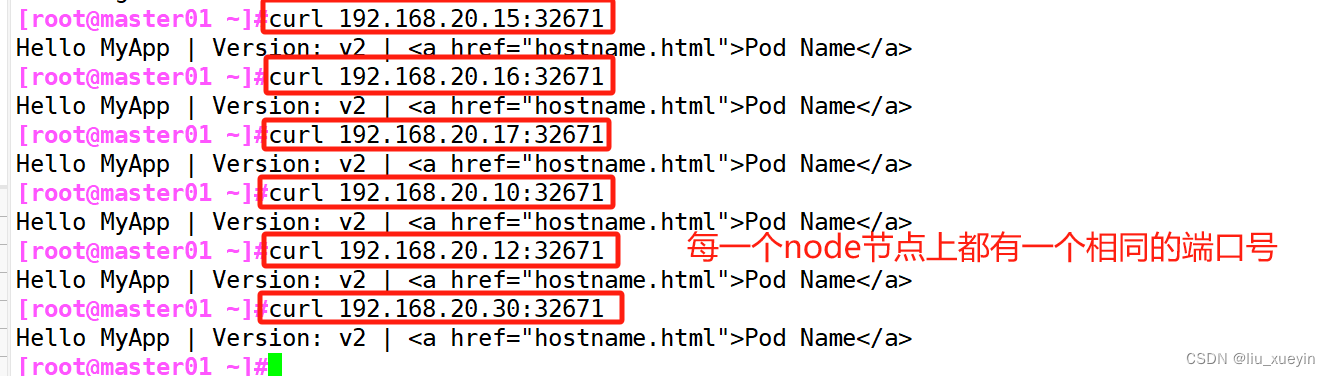

●NodePort:在每个Node上打开一个端口以供外部访问,Kubernetes将会在每个Node上打开一个端口并且每个Node的端口都是一样的,通过 NodeIp:NodePort 的方式Kubernetes集群外部的程序可以访问Service。同时还支持k8s集群内部通过clusterip:端口访问pod资源

每个端口只能是一种服务,端口范围只能是 30000-32767。

●LoadBalancer:通过设置LoadBalancer映射到云服务商提供的LoadBalancer地址。这种用法仅用于在公有云服务提供商的云平台上设置Service的场景。通过外部的负载均衡器来访问,通常在云平台部署LoadBalancer还需要额外的费用。

在service提交后,Kubernetes就会调用CloudProvider在公有云上为你创建一个负载均衡服务,并且把被代理的Pod的IP地址配置给负载均衡服务做后端。

●externalName:将service名称映射到一个DNS域名上,相当于DNS服务的CNAME记录,用于让Pod去访问集群外部的资源,它本身没有绑定任何的资源。

------------------------------------------------------------------------------------------

//查看pod网络状态详细信息和 Service暴露的端口

kubectl -n 命名空间 get pods,svc -o wide//查看关联后端的节点

kubectl -n 命名空间 get endpoints//查看 service 的描述信息

kubectl -n 命名空间 describe svc service名称//在 任意node 节点上操作,查看负载均衡端口

yum install ipvsadm -y

ipvsadm -Ln

//外部访问的IP和端口

//在 任意node 节点上操作,查看负载均衡端口

yum install ipvsadm -y

ipvsadm -Ln

//外部访问的IP和端口

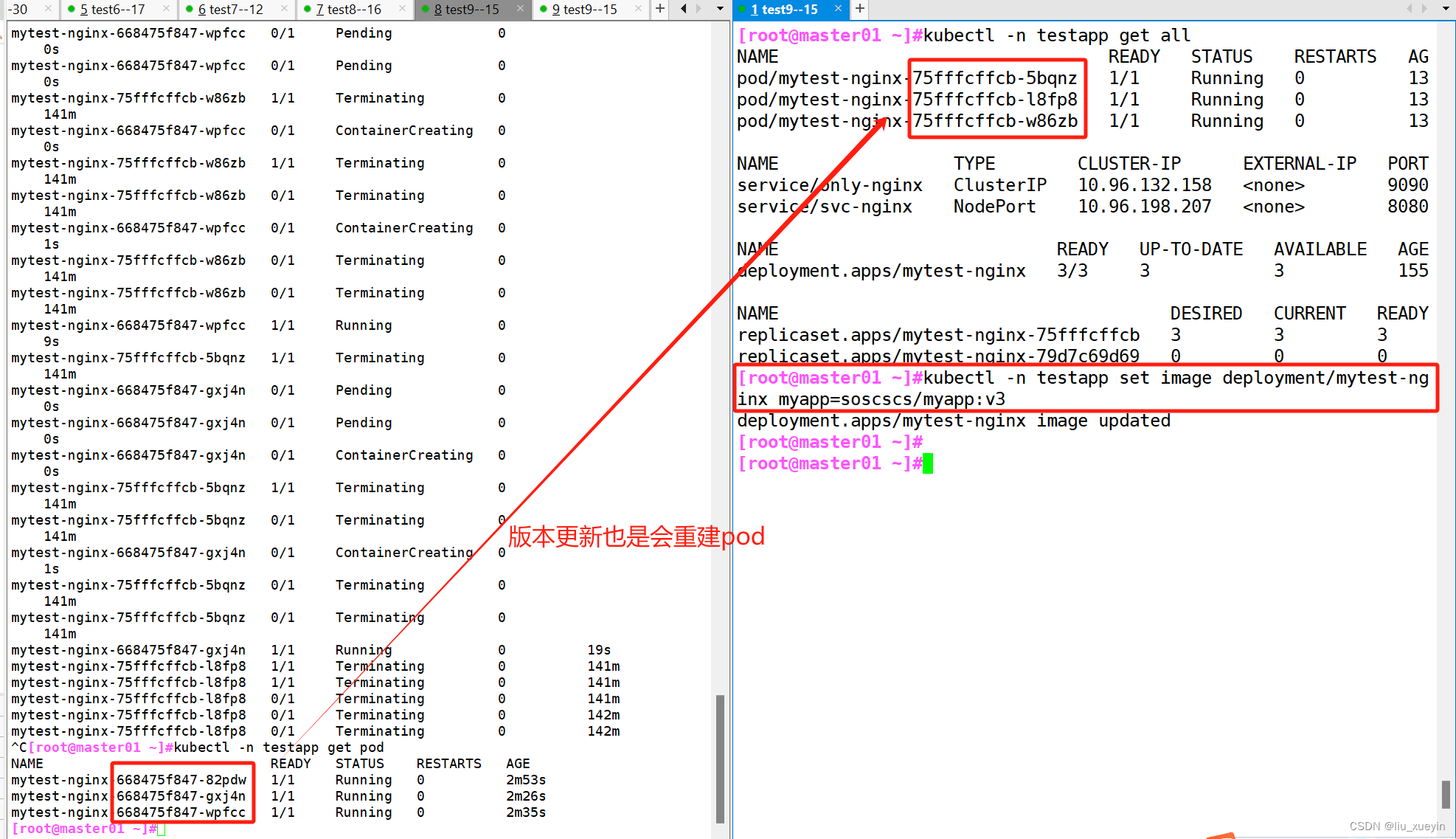

关于更新

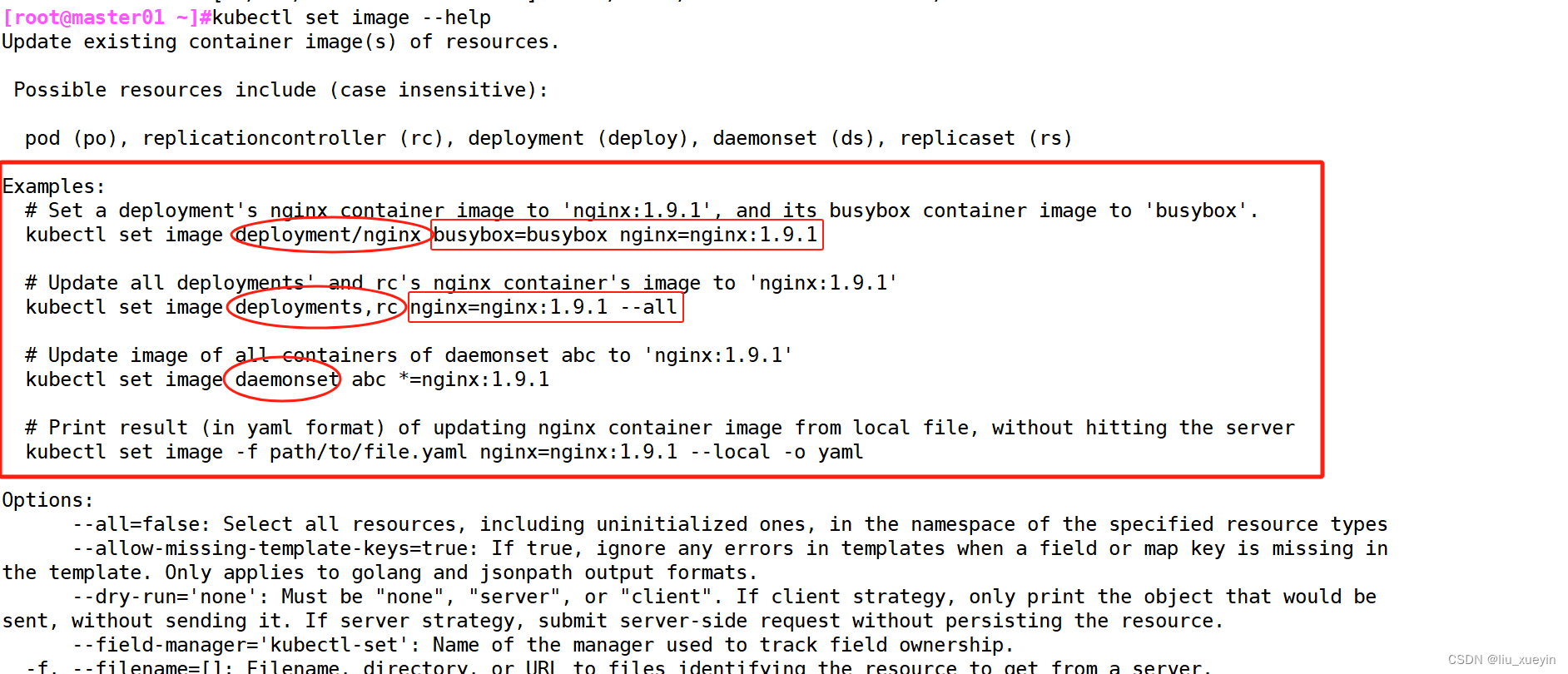

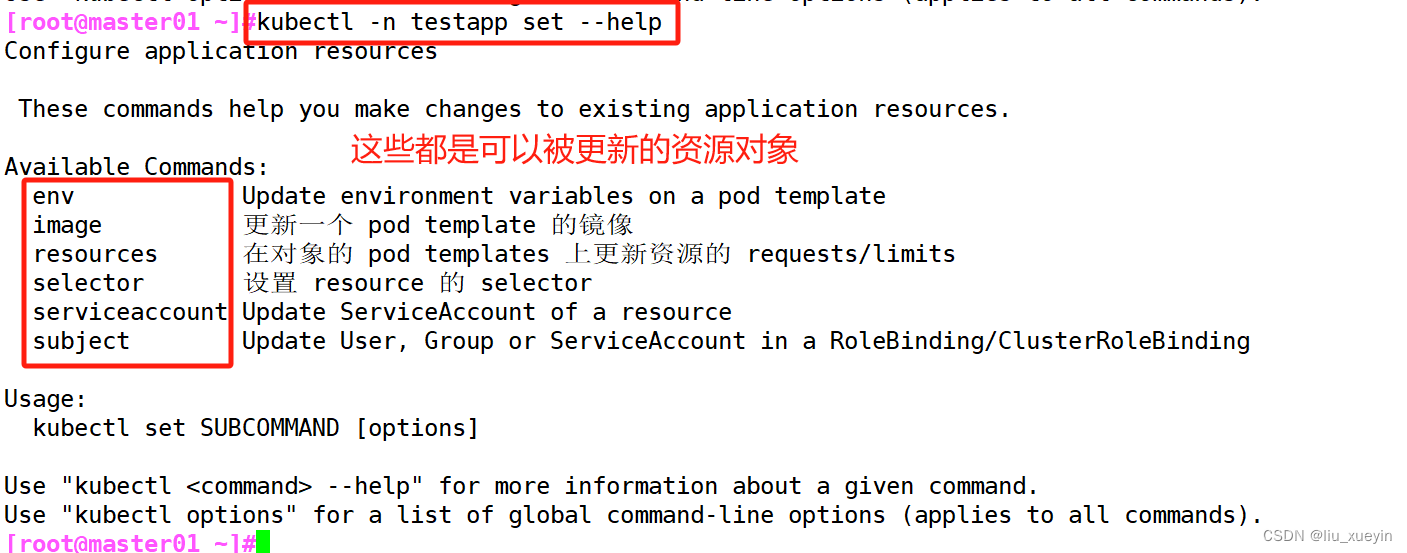

更新 kubectl set

●更改现有应用资源一些信息。

kubectl set --help//获取修改模板

kubectl set image --help

Examples:# Set a deployment's nginx container image to 'nginx:1.9.1', and its busybox container image to 'busybox'.kubectl set image deployment/nginx busybox=busybox nginx=nginx:1.9.1//查看当前 nginx 的版本号

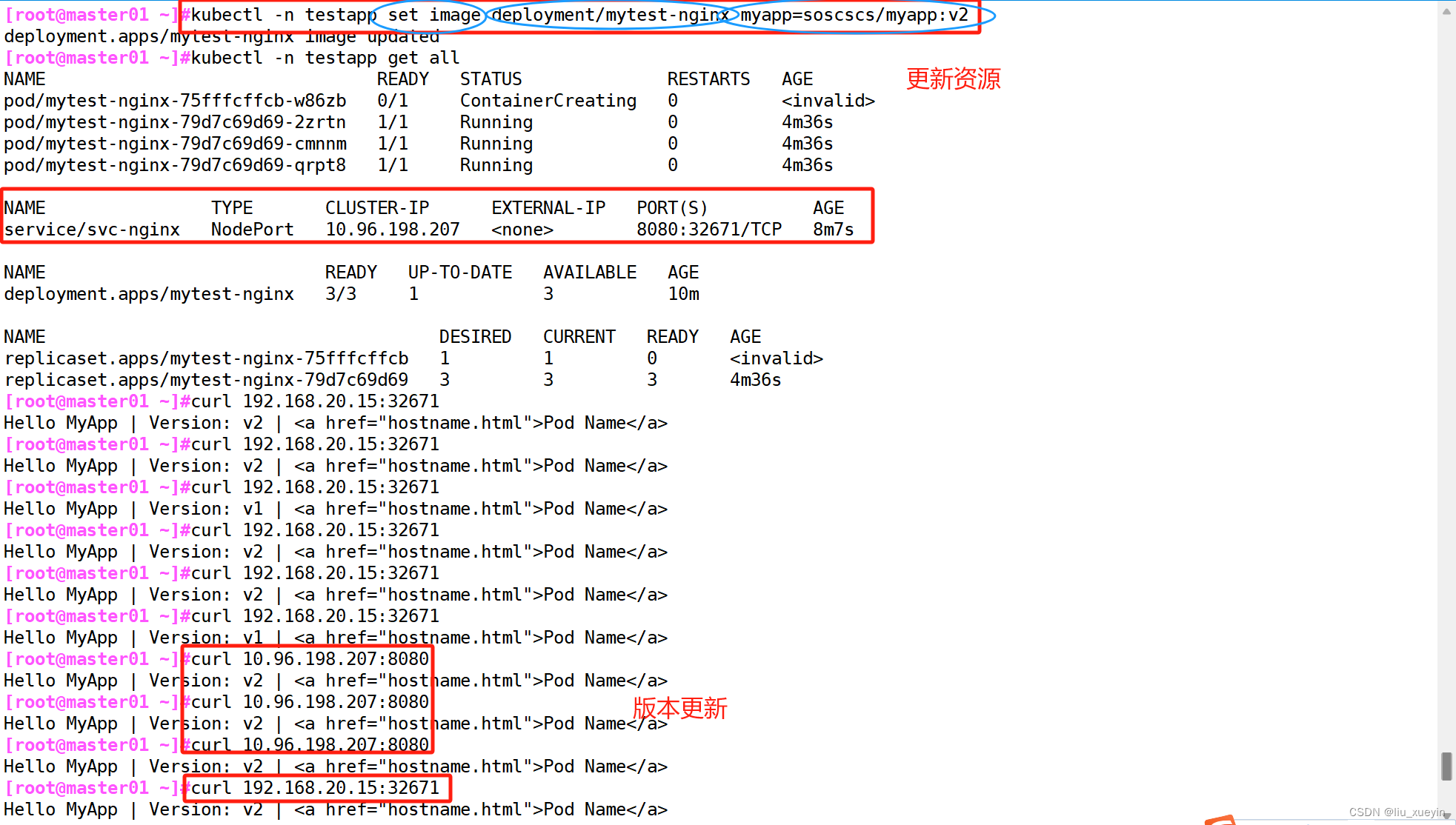

curl -I http://192.168.20.15:32671//将soscscs/myapp:v1 版本更新为 v2 版本

kubectl -n testapp set image deployment/mytest-nginx myapp=soscscs/myapp:v2//处于动态监听 pod 状态,由于使用的是滚动更新方式,所以会先生成一个新的pod,然后删除一个旧的pod,往后依次类推

kubectl -n 命名空间 get pods -w

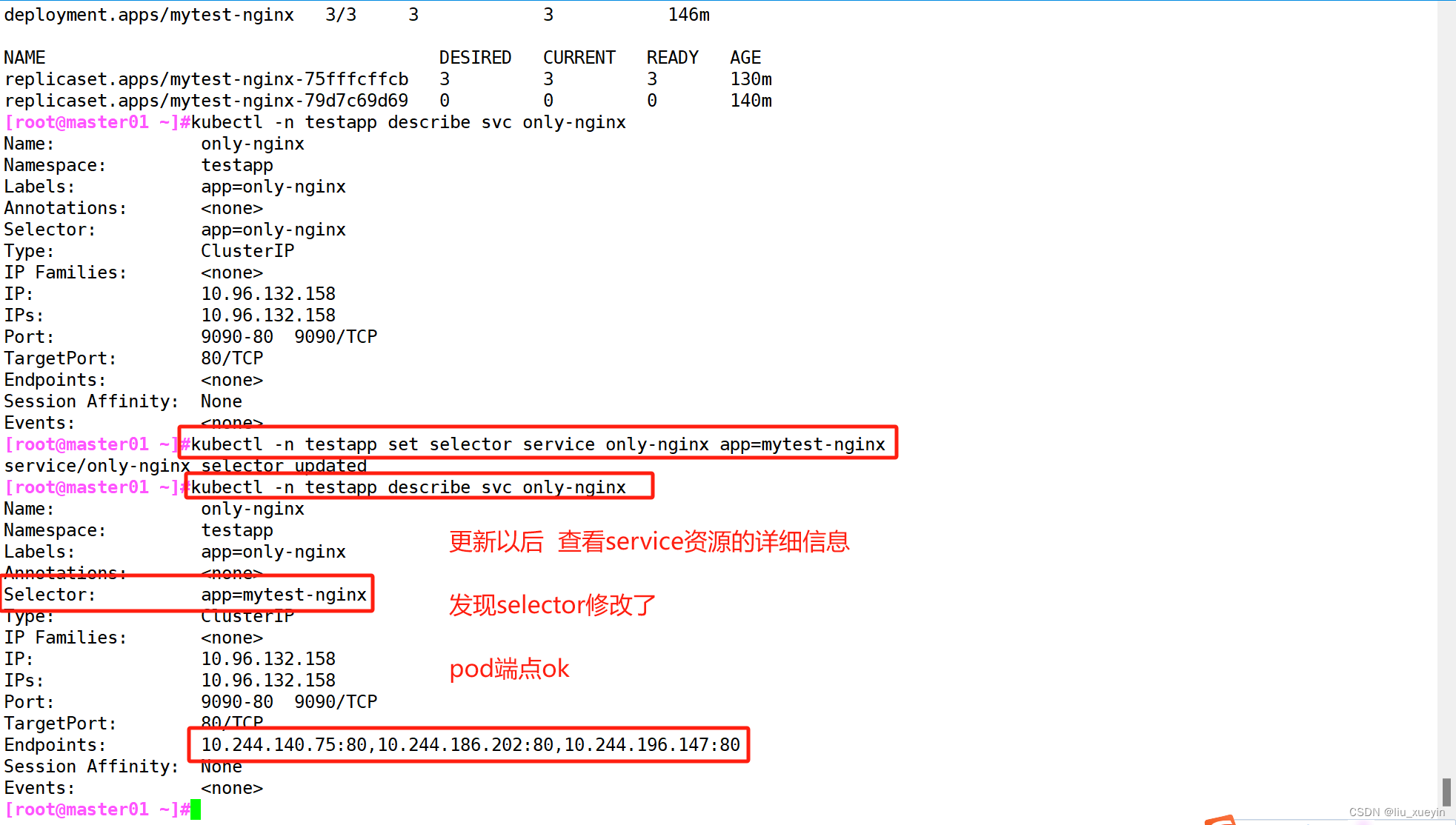

可以更新的资源对象有很多

kubectl -n testapp set selector --help

//查看更新选项

kubectl -n testapp create service clusterip only-nginx --tcp=9090:80

//创建service资源kubectl -n testapp set selector service only-nginx app=mytest-nginx

//更新service的标签选择器

---------------------------------------------------------------------------------------------

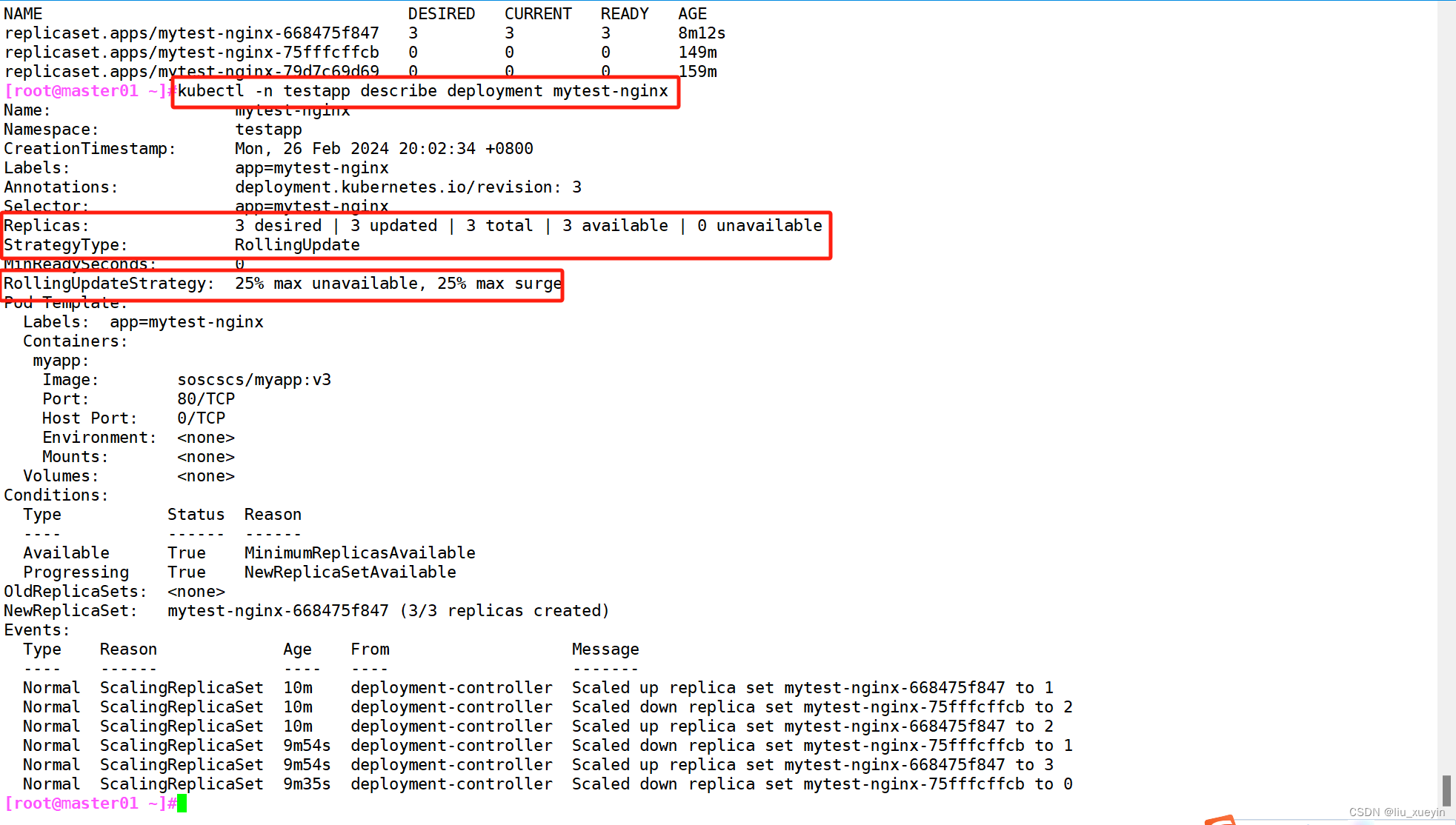

#滚动更新详解:

kubectl get all

DESIRED:表示期望的状态是 10 个 READY 的副本

CURRENT:表示当前副本的总数: 即8 个日副本 + 5 个新副本

UP_TO-DATE:表示当前已经完成更新的副本数: 即 5个新副本

AVAILABLE:表示当前处于 READY 状态的副本数: 即8个日副本。

kubectl describe deployment/nginx

滚动更新通过参数 maxSurge 和 maxUnavailable 来控制副本替换的数量

maxSurge:此参数控制滚动更新过程中副本总数的超过 DESIRED 的上限。maxSurge 可以是具体的整数(比如 3),也可以是百分百,向上取整。maxSurge 默认值为 25%。

例如,DESIRED 为 10,那么副本总数的最大值为 10 + 10 * 25% = 13,即 CURRENT 为 13。

maxUnavailable:此参数控制滚动更新过程中,不可用的副本相占 DESIRED 的最大比例。maxUnavailable 可以是具体的整数(比如 3),也可以是百分百,向下取整。 maxUnavailable 默认值为 25%。

例如,DESIRED 为 10,那么可用的副本数至少要为 10 - 10 * 25% = 8,即 AVAILABLE 为 8。

因此 maxSurge 值越大,初始创建的新副本数量就越多;maxUnavailable 值越大,初始销毁的旧副本数量就越多。

理想情况下,DESIRED 为 10 的滚动更新的过程应该是这样的:

首先创建 3 个新副本使副本总数达到 13 个。

然后销毁 2 个旧副本使可用的副本数降到 8 个。

当这 2 个旧副本成功销毁后,可再创建 2 个新副本,使副本总数保持为 13 个。

当新副本通过 Readiness 探测后,会使可用副本数增加,超过 8。

进而可以继续销毁更多的旧副本,使可用副本数回到 8。

旧副本的销毁使副本总数低于 13,这样就允许创建更多的新副本。

这个过程会持续进行,最终所有的旧副本都会被新副本替换,滚动更新完成。

---------------------------------------------------------------------------------------------

关于回滚

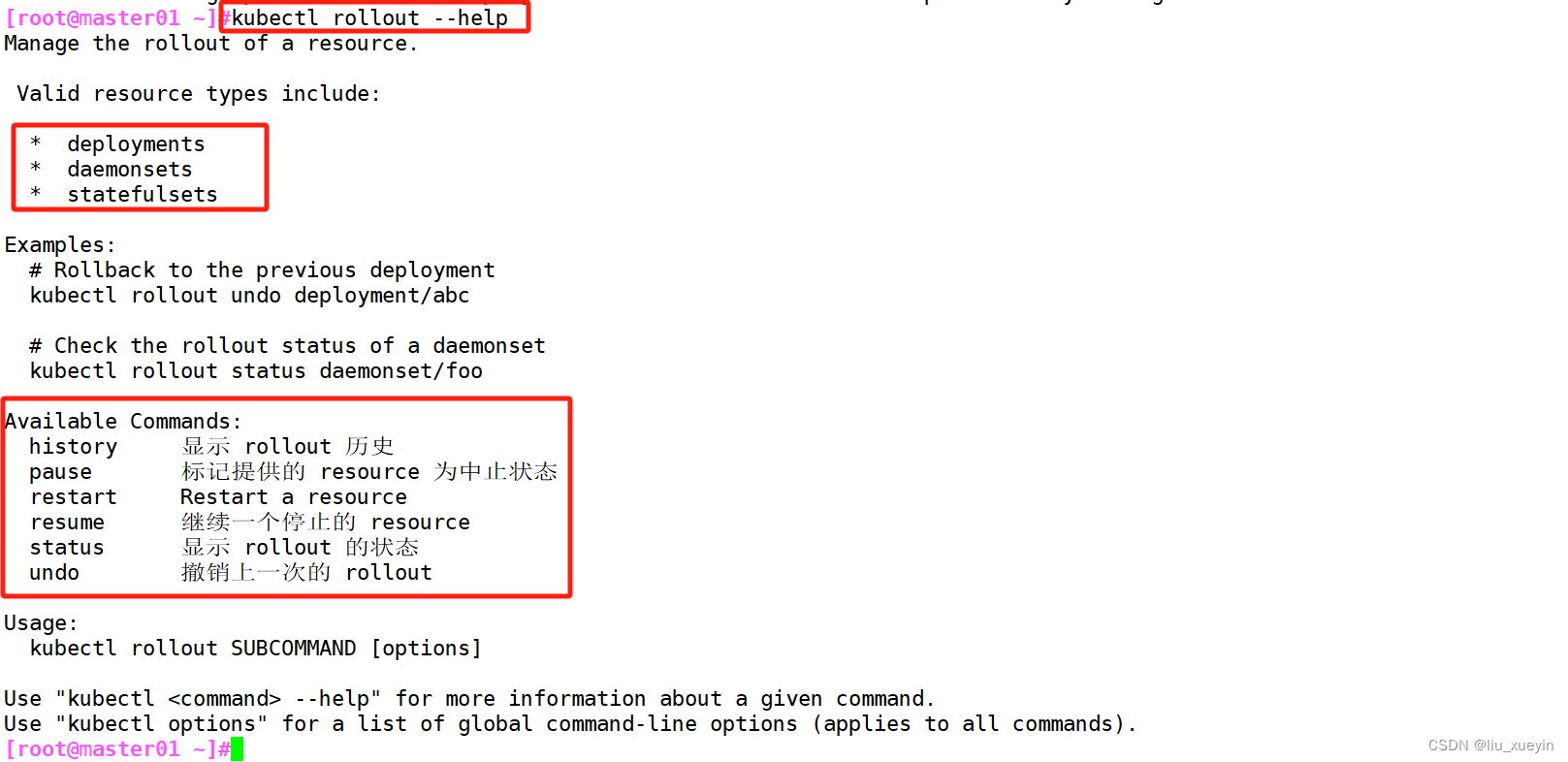

回滚 kubectl rollout

●对资源进行回滚管理

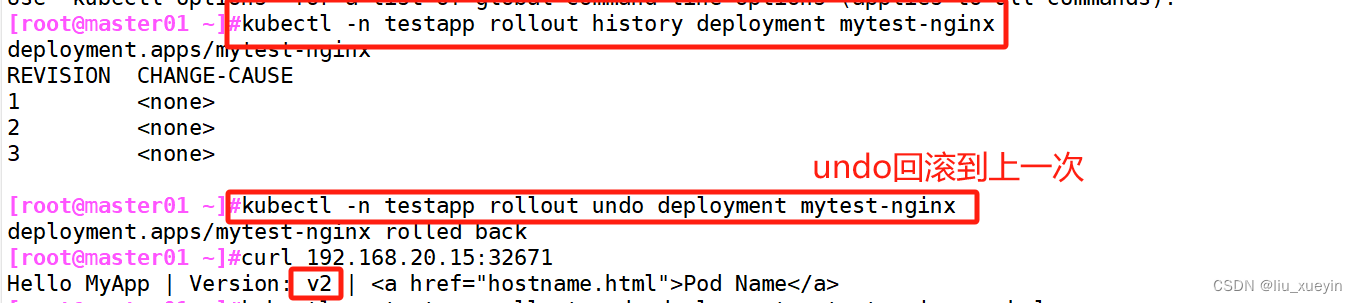

kubectl rollout --help//查看历史版本

kubectl rollout history deployment/mytest-nginx //执行回滚到上一个版本

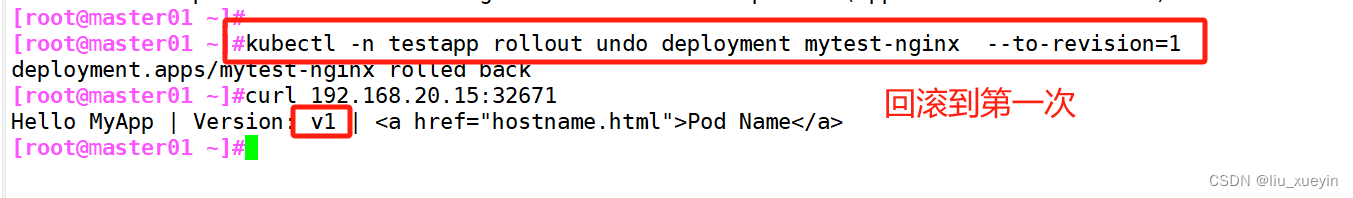

kubectl rollout undo deployment/mytest-nginx//执行回滚到指定版本

kubectl rollout undo deployment/mytest-nginx --to-revision=1//检查回滚状态

kubectl rollout status deployment/mytest-nginx

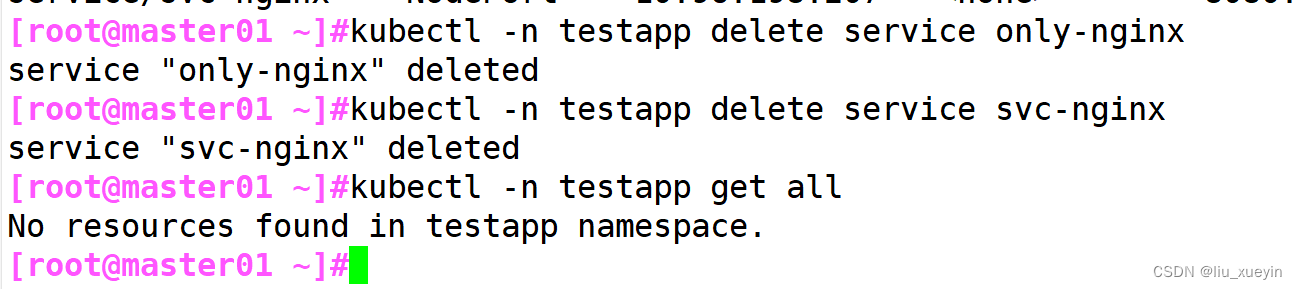

关于删除

删除 kubectl delete

//删除副本控制器

kubectl -n 命名空间 delete deployment/mytest-nginx//删除service

kubectl -n 命名空间 delete svc only-nginx

kubectl -n 命名空间 delete svc svc-nginxkubectl -n 命名空间 get all

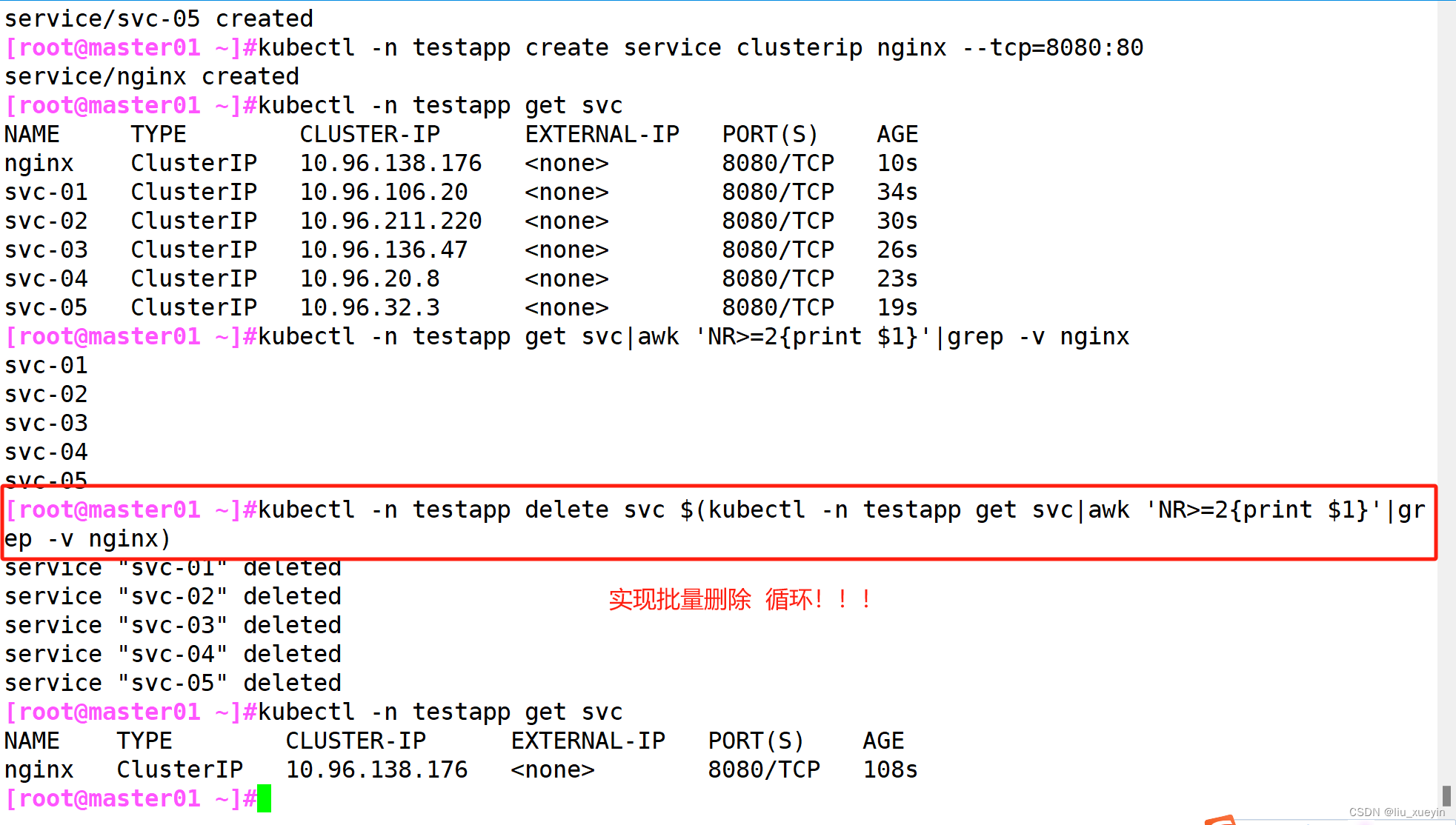

批量删除

kubectl -n testapp delete svc $(kubectl -n testapp get svc|awk 'NR>=2{print $1}'|grep -v nginx)

五、详解service资源

(1)service的端口分类

service端口

- port:service的clusterIP使用的端口,只能在K8S集群内部被访问到。K8S集群内部的客户端可以通过clusterIP:port来访问service

- nodePort:NodePort类型的service使用的端口,会在每个node节点上都开启相同的端口,也就是nodeIP使用的端口(默认范围为30000~32767)。K8S集群外部或内部的客户端都可以通过nodeIp:nodePort来访问service

- targetPort:Pod容器使用的端口。service会将发送给port或nodePort的请求转发给Pod容器,配置要与containerPort一致

Pod容器的端口

- containerPort:创建Pod时所指定的容器端口

(2)service的四大基础类型

- ClusterIP:默认的service资源的类型,可提供clusterIP:port供K8S集群内部访问service及其关联的Pod

- NodePort:会在每个node节点上都开启相同的端口,K8S集群外部或内部的用户都可以通过nodeIp:nodePort来访问service及其关联的Pod

- LoadBalancer:使用云负载设备和service作映射,外部用户通过访问云负载设备即可将请求转发到K8S的node节点,再通过nodeIP:nodePort来访问service及其关联的Pod

- ExternalName:相当于给一个外部地址(域名或IP)作别名,K8S集群内的Pod可以通过这个service访问相关的外部服务

service 是通过 标签选择器 关联Pod的标签 来自动发现Pod的端点(podIP:containerPort)

(3)查看service关联的端点的方式

查看service关联的Pod端口

- kubectl -n 命名空间 describe svc <资源名称>

- kubectl -n 命名空间 get endpoints [svc资源名称]

- kubectl -n 命名空间 describe endpoints <资源名称>

这篇关于【kubernetes】关于k8s集群中kubectl的陈述式资源管理的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!