本文主要是介绍【PaddleHub模型贡献】一行代码实现驾驶员状态识别,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

驾驶员状态识别

- 一、工具简介

- PaddleX

- PaddleHub

- 二、数据集介绍

- 三、模型开发

- 1.安装PaddleX

- 2.定义数据加载器

- 3.模型训练

- 4.导出预测模型

- 5.评估模型性能

- 四、模型转换

- 五、模型预测

- 六、总结与升华

- 个人简介

一般来讲,人在疲劳的时候会有比较典型的面部表情或动作特征,如较长的眨眼持续时间、较慢的眼睑运动、点头、打哈欠等。

基于摄像头的驾驶员监测方案正是利用这一点:首先挖掘出人在疲劳状态下的表情特征,然后将这些定性的表情特征进行量化,提取出面部特征点及特征指标作为判断依据,再结合实验数据总结出基于这些参数的识别方法,最后输入获取到的状态数据进行识别和判断。

前不久,飞桨官方在AI Studio上挑选了45个优质项目,优质项目链接:https://shimo.im/sheets/CqQvXq3JhGqCxdXv/MODOC

开发者 BIT可达鸭 开发的基于PaddleX的驾驶员状态识别和Paddle-Lite部署是上面的优质项目之一,将其转换成PaddleHub模型可供更多开发者快速使用。

参考资料:

- 基于PaddleX的驾驶员状态识别和Paddle-Lite部署

- 手把手带你将Paddlex模型部署为PaddleHub

- 【PaddleHub模型贡献】一行代码实现水表的数字表盘分割

- 【PaddleHub模型贡献】一行代码实现从彩色图提取素描线稿

- 【PaddleHub模型贡献】一行代码实现蛇种识别

一、工具简介

PaddleX

PaddleX是飞桨全流程开发工具,集飞桨核心框架、模型库、工具及组件等深度学习开发所需全部能力于一身,打通深度学习开发全流程,并提供简明易懂的Python API,方便用户根据实际生产需求进行直接调用或二次开发,为开发者提供飞桨全流程开发的最佳实践。目前,该工具代码已开源于GitHub,同时可访问PaddleX在线使用文档,快速查阅读使用教程和API文档说明。

PaddleX代码GitHub链接:https://github.com/PaddlePaddle/PaddleX

PaddleX文档链接:https://paddlex.readthedocs.io/zh_CN/develop/

PaddleX官网链接:https://www.paddlepaddle.org.cn/paddle/paddlex

PaddleHub

PaddleHub官方Github地址(欢迎star~):

https://github.com/PaddlePaddle/PaddleHub

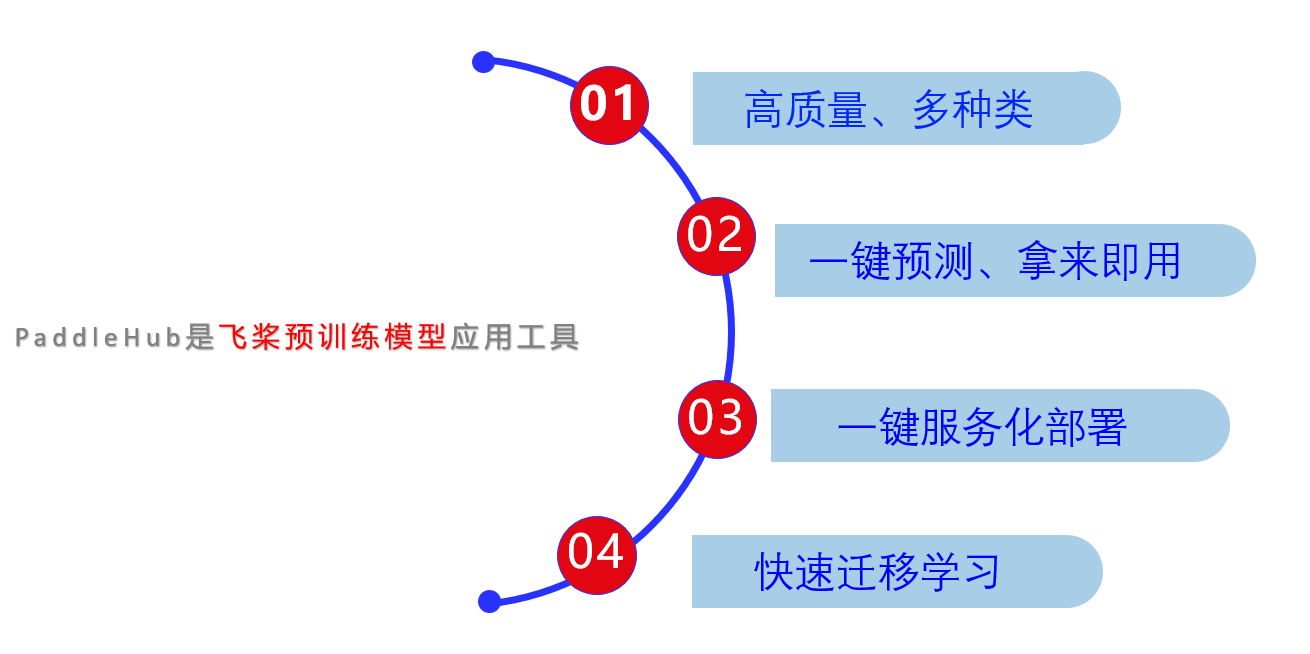

PaddleHub旨在为开发人员提供丰富,高质量,可直接使用的预训练模型。开发者无需深度学习背景,便可以快速使用PaddleHub内置的AI模型。其模型涵盖图像,文本,音频和视频的4个主要类别,并支持一键式预测,轻松的服务部署和迁移学习,另外,所有模型都是开源的,可以在离线情况下免费下载和使用。

二、数据集介绍

数据集地址:https://www.kaggle.com/c/state-farm-distracted-driver-detection

该数据集由kaggle提供,共包括十个类别:

'c0': 'normal driving','c1': 'texting-right','c2': 'talking on the phone-right','c3': 'texting-left','c4': 'talking on the phone-left','c5': 'operating the radio','c6': 'drinking','c7': 'reaching behind','c8': 'hair and makeup','c9': 'talking to passenger'

# 解压数据集(注意要根据环境修改路径——

!unzip /home/aistudio/data/data35503//imgs.zip -d /home/aistudio/work/imgs

!cp /home/aistudio/data/data35503/lbls.csv /home/aistudio/work/

三、模型开发

1.安装PaddleX

!pip install paddlex -i https://mirror.baidu.com/pypi/simple

import os

# 设置使用0号GPU卡(如无GPU,执行此代码后仍然会使用CPU训练模型)

os.environ['CUDA_VISIBLE_DEVICES'] = '0'

# jupyter中使用paddlex需要设置matplotlib

import matplotlib

import os

os.chdir('/home/aistudio/work/')

matplotlib.use('Agg')

import paddlex as pdx

2.定义数据加载器

这里主要是通过 pdx.datasets.ImageNet 类定义用于识别任务的数据加载器;

import paddlehub as hub

import paddle.fluid as fluid

import numpy as npbase = './imgs/'datas = []

for i in range(10):c_base = base+'train/c{}/'.format(i)for im in os.listdir(c_base):pt = os.path.join('train/c{}/'.format(i), im)line = '{} {}'.format(pt, i)# print(line)datas.append(line)np.random.seed(10)

np.random.shuffle(datas)total_num = len(datas)

train_num = int(0.8*total_num)

test_num = int(0.1*total_num)

valid_num = total_num - train_num - test_numprint('train:', train_num)

print('valid:', valid_num)

print('test:', test_num)with open(base+'train_list.txt', 'w') as f:for v in datas[:train_num]:f.write(v+'\n')with open(base+'test_list.txt', 'w') as f:for v in datas[-test_num:]:f.write(v+'\n')with open(base+'val_list.txt', 'w') as f:for v in datas[train_num:-test_num]:f.write(v+'\n')with open(base+'labels.txt', 'w') as f:for i in range(10):f.write('ch{}\n'.format(i))

train: 17939

valid: 2243

test: 2242

from paddlex.cls import transforms

train_transforms = transforms.Compose([transforms.ResizeByShort(short_size=256),transforms.RandomCrop(crop_size=224),transforms.RandomDistort(),transforms.Normalize()

])

eval_transforms = transforms.Compose([transforms.ResizeByShort(short_size=256),transforms.CenterCrop(crop_size=224),transforms.Normalize()

])

train_dataset = pdx.datasets.ImageNet(data_dir='imgs',file_list='imgs/train_list.txt',label_list='imgs/labels.txt',transforms=train_transforms,shuffle=True)

eval_dataset = pdx.datasets.ImageNet(data_dir='imgs',file_list='imgs/val_list.txt',label_list='imgs/labels.txt',transforms=eval_transforms)

2021-03-12 17:20:08 [INFO] Starting to read file list from dataset...

2021-03-12 17:20:08 [INFO] 17939 samples in file imgs/train_list.txt

2021-03-12 17:20:08 [INFO] Starting to read file list from dataset...

2021-03-12 17:20:08 [INFO] 2243 samples in file imgs/val_list.txt

num_classes = len(train_dataset.labels)

print(num_classes)

10

3.模型训练

# 定义并训练模型

model = pdx.cls.MobileNetV3_small_ssld(num_classes=num_classes)

model.train(num_epochs=20,train_dataset=train_dataset,train_batch_size=32,log_interval_steps=20,eval_dataset=eval_dataset,lr_decay_epochs=[1],save_interval_epochs=1,learning_rate=0.01,save_dir='output/mobilenetv3')

2021-03-12 22:53:09 [INFO] [TRAIN] Epoch=20/20, Step=500/560, loss=0.117403, acc1=0.96875, acc5=1.0, lr=0.001, time_each_step=1.7s, eta=0:2:40

2021-03-12 22:53:43 [INFO] [TRAIN] Epoch=20/20, Step=520/560, loss=0.057465, acc1=1.0, acc5=1.0, lr=0.001, time_each_step=1.68s, eta=0:2:5

2021-03-12 22:54:12 [INFO] [TRAIN] Epoch=20/20, Step=540/560, loss=0.521278, acc1=0.84375, acc5=0.96875, lr=0.001, time_each_step=1.44s, eta=0:1:27

2021-03-12 22:54:37 [INFO] [TRAIN] Epoch=20/20, Step=560/560, loss=0.20346, acc1=0.9375, acc5=1.0, lr=0.001, time_each_step=1.29s, eta=0:0:58

2021-03-12 22:54:37 [INFO] [TRAIN] Epoch 20 finished, loss=0.297043, acc1=0.89721, acc5=0.986719, lr=0.001 .

2021-03-12 22:54:37 [INFO] Start to evaluating(total_samples=2243, total_steps=71)...

100%|██████████| 71/71 [00:57<00:00, 1.23it/s]

2021-03-12 22:55:35 [INFO] [EVAL] Finished, Epoch=20, acc1=0.988854, acc5=1.0 .

2021-03-12 22:55:35 [INFO] Model saved in output/mobilenetv3/best_model.

2021-03-12 22:55:36 [INFO] Model saved in output/mobilenetv3/epoch_20.

2021-03-12 22:55:36 [INFO] Current evaluated best model in eval_dataset is epoch_20, acc1=0.9888542131074454

4.导出预测模型

!paddlex --export_inference --model_dir=output/mobilenetv3/best_model --save_dir=inference_model

5.评估模型性能

save_dir = 'output/mobilenetv3/best_model'

model = pdx.load_model(save_dir)

model.evaluate(eval_dataset, batch_size=1, epoch_id=None, return_details=False)

2020-05-18 09:25:35 [INFO] Model[MobileNetV3_small_ssld] loaded.

2020-05-18 09:25:35 [INFO] Start to evaluating(total_samples=2243, total_steps=2243)...

100%|██████████| 2243/2243 [00:58<00:00, 38.38it/s]

OrderedDict([('acc1', 0.9790459206419974), ('acc5', 1.0)])

四、模型转换

这里我们需要将PaddleX训练得到的模型转换成PaddleHub的Module

PaddleX模型可以快速转换成PaddleHub模型,只需要用下面这一句命令即可:

!hub convert --model_dir work/inference_model \--module_name DriverStatusRecognition \--module_version 1.0.0 \--output_dir outputs

转换成功后的模型保存在outputs文件夹下,我们解压一下:

!gzip -dfq outputs/DriverStatusRecognition.tar.gz

!tar -xf outputs/DriverStatusRecognition.tar

五、模型预测

安装我们刚刚转换的模型:

!hub install DriverStatusRecognition

[2021-03-13 12:09:07,593] [ INFO] - Successfully uninstalled DriverStatusRecognition

[2021-03-13 12:09:07,785] [ INFO] - Successfully installed DriverStatusRecognition-1.0.0

实时检测驾驶员状态,从视频流中抽帧:

import cv2

import paddlehub as hubmodule = hub.Module(directory='DriverStatusRecognition') # 一行代码实现模型调用images = [cv2.imread('work/imgs/test/img_1622.jpg'), cv2.imread('work/imgs/test/img_14165.jpg'), cv2.imread('work/imgs/test/img_47183.jpg')]

results = module.predict(images=images)for result in results:

images)for result in results:print(result)

[2021-03-13 12:24:04,960] [ WARNING] - The _initialize method in HubModule will soon be deprecated, you can use the __init__() to handle the initialization of the object[{'category_id': 5, 'category': 'ch5', 'score': 0.47390476}]

[{'category_id': 2, 'category': 'ch2', 'score': 0.99997914}]

[{'category_id': 1, 'category': 'ch1', 'score': 0.99996376}]

六、总结与升华

根据CDC机动车安全部门的说法,五分之一的车祸 是由分心的驾驶员引起的。令人遗憾的是,每年因分心驾驶而导致的425,000人受伤和3,000人死亡。

希望能通过检测驾驶员的行为,从而改善上面这些令人震惊的统计数据,提醒驾驶员专心驾驶,减少交通事故的发生。

个人简介

北京联合大学 机器人学院 自动化专业 2018级 本科生 郑博培

百度飞桨开发者技术专家 PPDE

百度飞桨官方帮帮团、答疑团成员

深圳柴火创客空间 认证会员

百度大脑 智能对话训练师

阿里云人工智能、DevOps助理工程师

我在AI Studio上获得至尊等级,点亮9个徽章,来互关呀!!!

https://aistudio.baidu.com/aistudio/personalcenter/thirdview/147378

这篇关于【PaddleHub模型贡献】一行代码实现驾驶员状态识别的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!