本文主要是介绍有人LORA——WH-L102-L,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

最近使用了有人的lora模块,在此记录一下。

使用该模块最重要的就是进入AT配置模式,在AT模式下可以改变其工作模式,信道,地址等。

在使用过程中,用到了两个串口,一个用来接模块,一个用来显示结果,方便调试。

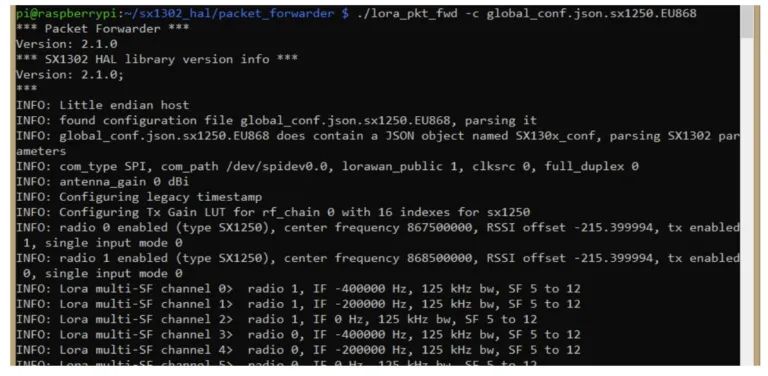

进入配置模式的方法

进入后根据模块说明书中的AT指令即可进行相应配置。

该模块只有透传和定点两种通信的方式。

透传模式:

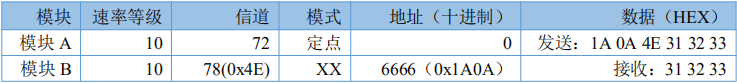

定点模式:

在定点模式下,改变发送内容的信道和地址即可与不同的lora模块实现定点通信。通信双方的速率需保持一致。

这篇关于有人LORA——WH-L102-L的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!