本文主要是介绍论文笔记——EMPATHETIC RESPONSE GENERATION VIA EMOTION CAUSE TRANSITION GRAPH,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文评价

发表在ICASSP,即International Conference on Acoustics, Speech and Signal Processing,是IEEE名下的,很明显这并不是一个做文本的学术会议

总体评价是:这不是一篇好的论文,只能是说思路可以看,但细节完全不忍直视。

论文创新点:

不同于传统的使用情绪分类器先提取出情绪的方法,这篇文章使用了情绪诱因提取的方式来增强共情对话生成(虽然这一方法并不是该文章首创)。

论文思路:

首先要说明的是关于数据集的修改,

作者对数据集进行了补充,原数据集(也就是2019年发表的EmpatheticDialogue,ED)并没有对情绪诱因进行标注,于是作者手工增加了标准便于训练。

原数据集对对话标注了emotion标签,但emotion标签原则上不能直接当成已知的(因为对话本身是不会有emotion标注的),但本文当中,作者并没有解释他的emotion标签是怎么来的,我觉得可能就是直接用了数据集里的(这样做是完全错误的)。

模型思路如下:

用spanBERT对"上下文 [SEP] emotion"进行编码,然后使用指针网络把情绪诱因的开始和结束位置提出来,再用基于规则的方式提取出诱因片段的关键词(但我印象中好像有KeyBERT可以用)。

所有提取出的关键词会被当成图里的节点(vertex,或者文中使用的concept),构建一个图。

结合经过BERT的上下文编码和图,使用Transformer Decoder进行解码.。

但文章认为可能解码器过于关注那些出现频率比较高的关键词(或者说图的顶点),于是使用了Insert Transformer,将decoder中层的输出当作输入,真正的回复当作label,用多任务学习来优化deocder(虽然我并不知道这为什么能解决他提出的问题,作者也没有解释)。

最终使用BERT作为编码器,将预测出的回复节点和上下文连起来放入BERT进行编码,然后再放到Transformer解码器中解码,得到最终的输出。

实验结果

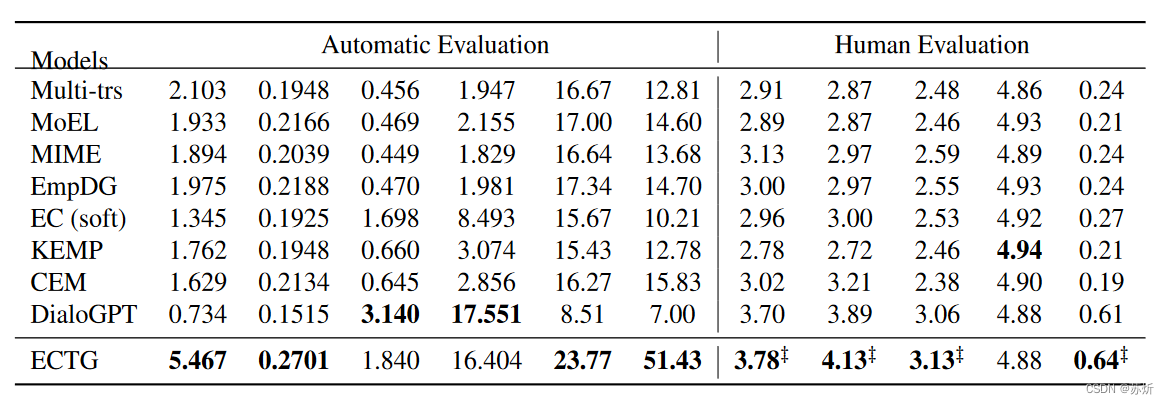

我不知道是arxiv的问题还是论文就是这样,实验结果的大表格是没有标题的。只能通过和另一个表的数据对比大概能看出是什么,对应的应该是这样:

实验结果中写的其他论文的数据在原论文中也不是这么低,至于是谁有问题那我就不知道了

这篇关于论文笔记——EMPATHETIC RESPONSE GENERATION VIA EMOTION CAUSE TRANSITION GRAPH的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!