本文主要是介绍【PaperReading- VLM】1. FERRET,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

| Category | Content |

|---|---|

| 论文题目 | FERRET: REFER AND GROUND ANYTHING ANYWHERE AT ANY GRANULARITY |

| 作者 | Haoxuan You (Columbia University), Haotian Zhang, Zhe Gan, Xianzhi Du, Bowen Zhang, Zirui Wang, Liangliang Cao (Apple AI/ML), Shih-Fu Chang (Columbia University), Yinfei Yang (Apple AI/ML) |

| 发表年份 | 2023 |

| 摘要 | 介绍了Ferret,这是一个多模态大型语言模型(MLLM),能够理解图像中任何形状或粒度的空间引用,并准确地对开放词汇描述进行定位。它采用了一种混合区域表示,结合了离散坐标和连续特征,以及一个空间感知的视觉采样器。 |

| 引言 | 探讨了如何在模型中实现空间理解,重点是引用和定位的能力。它解决了将这些能力与日常对话和推理整合的问题,灵感来源于人类的认知过程。 |

| 主要内容 | Ferret是一种新颖的引用和定位多模态大型语言模型,使用混合区域表示和空间感知视觉采样器,实现更普遍和精确的人机交互。为增强Ferret的能力,创建了一个名为GRIT的Instruct-tuning数据集,包含110万个样本,专注于空间知识,提升模型的鲁棒性。Ferret的贡献包括其用于精细引用和定位的新方法,创建GRIT数据集,以及引入Ferret-Bench,用于评估需要引用/定位知识和推理的任务。Ferret在GRIT数据集上进行训练,并在传统的引用和定位基准任务上进行评估,以及更复杂的多模态聊天任务。 |

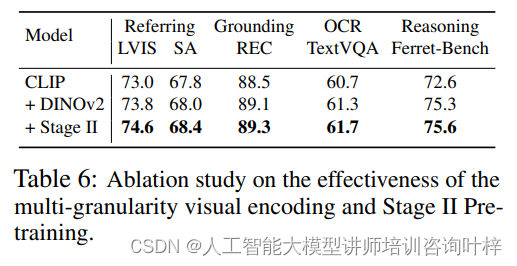

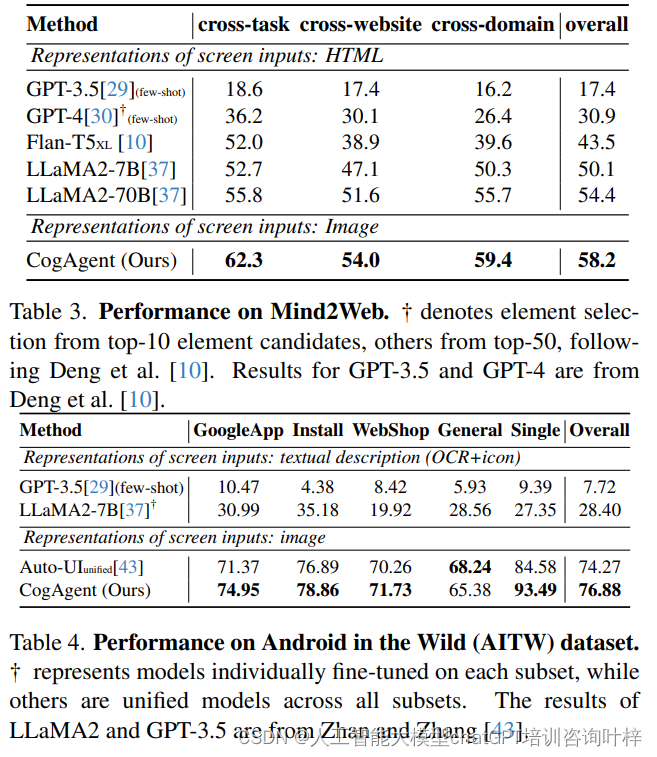

| 实验 | Ferret的输入引用能力通过像引用对象分类这样的任务展示,评估模型对引用区域的理解。在输出定位方面,Ferret在视觉定位任务上进行了评估,如引用表达理解和短语定位,使用了如RefCOCO和Flickr30k实体等数据集。Ferret-Bench引入了新的多模态聊天任务,评估模型在对话中执行引用和定位动作的能力。 |

| 结论 | Ferret在一系列任务中表现出色,显著减少了对象幻觉,具有强大的空间理解和定位能力。 |

| 阅读心得 |  这篇论文主要亮点是开发了一个采样器,能够根据不同的提示,从mask区域的范围内采样出重要的点转化为该对象的feature,这种方式对提示的形状无限制,可以是点或者bbox或者随手画的曲线。另外,就是制作了相应的数据集。GRIT, 110万个样本。 这篇论文主要亮点是开发了一个采样器,能够根据不同的提示,从mask区域的范围内采样出重要的点转化为该对象的feature,这种方式对提示的形状无限制,可以是点或者bbox或者随手画的曲线。另外,就是制作了相应的数据集。GRIT, 110万个样本。 |

这篇关于【PaperReading- VLM】1. FERRET的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!