本文主要是介绍Affective Computing Research,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

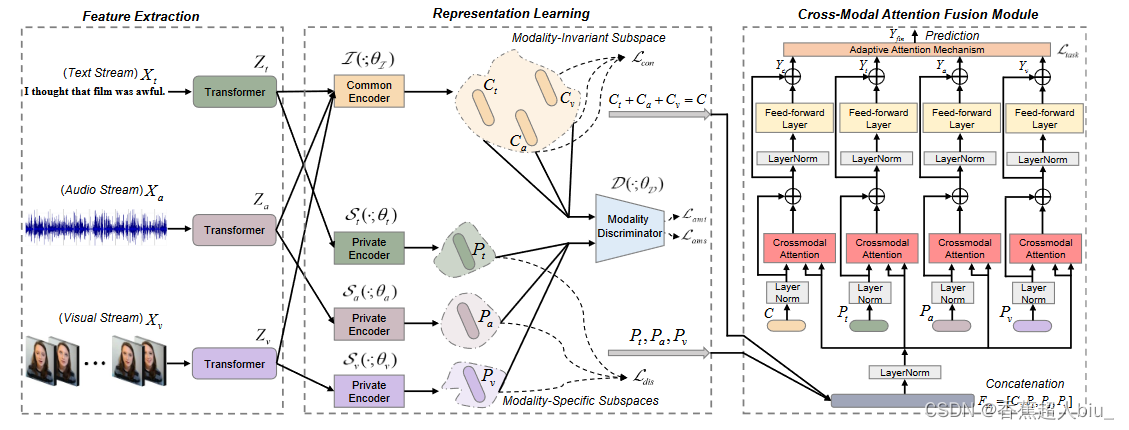

Disentangled Representation Learning for Multimodal Emotion Recognition

提出了一种特征分解的多模态情感识别方法,学习每种模态的共同和私有的特征表征。

Pipline

主要创新点

提出了一种特征解缠方法,同时提出了一种基于注意力机制的跨模态融合方法

- 设计了共同的和私有的编码器,将每个模态分别投射到模态不变的子空间和模态特定的子空间。模态不变的子空间能够探索不同模态之间的共性,并减少分布差距。特定模态子空间能够加强特征多样性,并捕捉每种模态的独特特征。

- 引入了一个模态判别器,以对抗性的方式指导共同和私有编码器的参数学习。通过为上述子空间设计定制的损失来实现模态一致性和差异性约束。

- 提出了一个跨模态注意力融合模块,以学习自适应权重,从而获得有效的多模态表征。

Dataset

- CMU-MOSI.

数据采集方式:YouTube的独白视频。

每个多模态样本的情感得分范围为[-3,3]

情感标签:

Highly Negative、Negative、Weakly Negative、Neutral、Weakly Positive、Positive、Highly Positive - CMU-MOSEI.

CMU-MOSI为规模最大的三模态数据集,且具有情感和情绪两个标签。

数据采集方式:YouTube的独白视频。

情感标签是对每句话的7分类的情感标注,作者还提供了了2/5/7分类的标注,具体细节与CMU-MOSI一致。

情绪标注:高兴,悲伤,生气,恐惧,厌恶,惊讶 - UR_FUNNY.(幽默情感数据集)

数据采集方式:TED演讲(可视为半开放环境)

包含了文本、音频和视频

情感标签:humer & non-humer

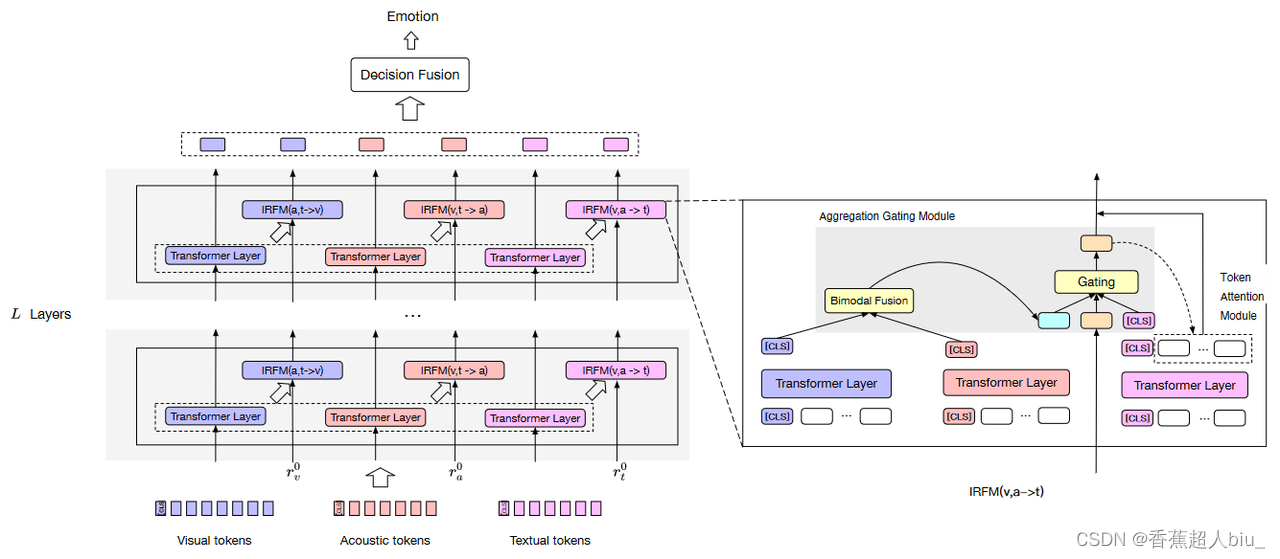

Leveraging Multi-modal Interactions among the Intermediate Representations of Deep Transformers for Emotion Recognition

提出了多模态的递归中间层聚合模型,以探索利用深度预训练转化器的中间表征之间的多模态互动来实现端到端的情感识别的有效性。

Pipline

主要创新点

- 首次探索了利用深度预训练的转换器的中间表征之间的多模态交互进行端到端的多模态情感识别

- 提出了循环中间层聚合模型,它由多模态聚集门控模块和多模态标记注意模块组成。具体来说,在每一层,我们首先使用多模态聚合门控模块来捕捉跨模态和跨层的语料级互动,并在IEMOCAP和MOSEI上取得了最新的性能;

- 给出了逐层融合性能的分析,观察到在IEMOCAP和MOSEI上融合中间层的表示可以获得与融合最后一个表示一样好甚至更好的性能。

Dataset

- IEMPCAP

包含了维度情感标签和离散情感表情标签

数据采集方式:在封闭环境中引导受试者表演剧本

离散情感标签:中性,幸福,悲伤,愤怒,惊讶,恐惧,厌恶,挫败感,兴奋,其他

维度情感标签依赖 PAD

数据集大小:该数据集共包含5531个语音样本。 - CMU-MOSEI

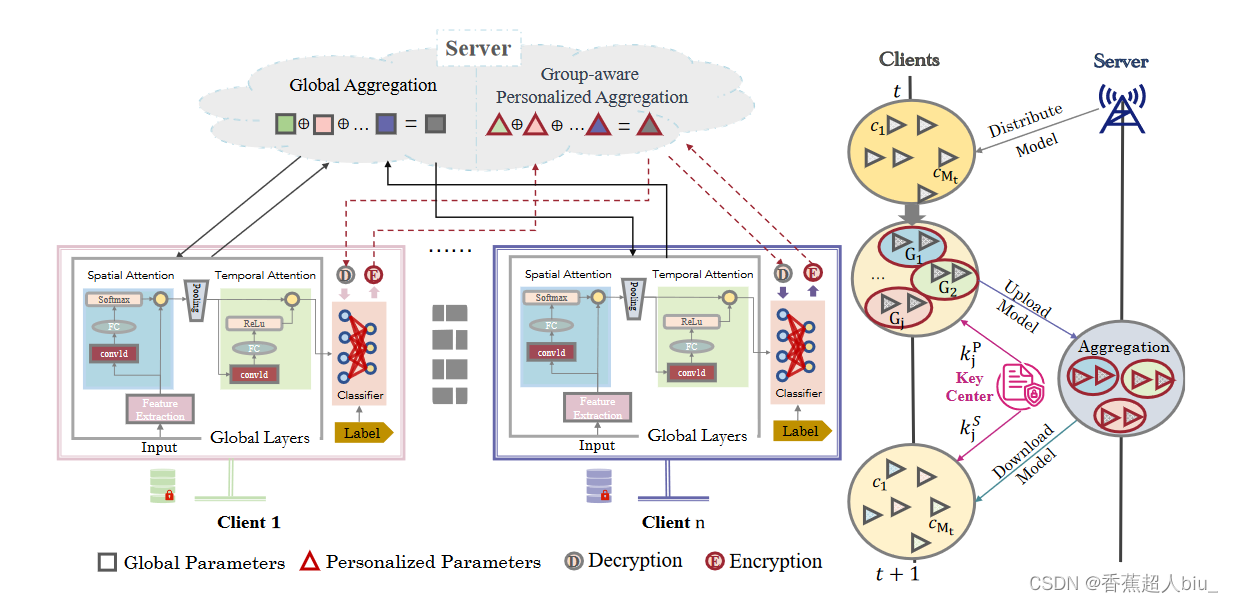

Feeling Without Sharing: A Federated Video Emotion Recognition Framework Via Privacy-Agnostic Hybrid Aggregation

提出通过多组聚类和隐私无关的混合聚合来进行基于视频的情绪识别的联邦学习的实用框架。

Pipline

关键词: 视频识别, 情感计算, 联邦学习。

主要创新点

- 我们提出了第一个面向视频情感计算的隐私保护任务,以及一个高效的联合视频情感识别框架( EmoFed ),从每个客户端提取有用的信息并平衡隐私效用均衡。

- 在相似用户的子群聚类下,提出EmoFed通过全局聚合和群体感知的个性化聚合来缓解不同用户群体的视频数据异构性。其在保护隐私的同时,产生了一个普遍适用和改进的模型,它在群组感知的个性化聚合下训练本地模型。为了进一步鼓励在客户之间交流全面和隐私无关的信息,我们将全局层和个性化层的模型参数上传到服务器。我们对个性化层采用同态加密的方法,由于在加密/解密过程中没有噪音被添加到模型更新中,因此不会产生学习精度的损失。

- 所提出的方法适用于基于视频的情绪识别任务,以预测演员的情绪表达和观众的诱导情绪。在四个基准上进行的大量实验和消融研究证明了我们方法的有效性和实用性。

Dataset

- MEAD

MEAD 是一个包含60名演员在3个不同强度等级下与8种不同情绪的人进行对话的面对面视频语料库。

收集数据的方式为:演员在严格控制的环境下,通过七个不同视角捕捉演员对话时的表情及头部姿态信息

包含了情绪和强度两种标签,同时还包含头部姿态信息

强度标签为:weak、medium、strong

情感标签为:Anger、Disgust、Contempt、Fear、Happy、Sad、Surprise、Neutra - AFEW

AFEW是一个从电影场景中进行剪辑的包含多重标签的语料库

数据采集方式:从电影中剪辑包含表情的视频片段,每一帧画面可能存在多个标注对象

情感标签为:Anger、Disgust、Fear、Sad、Happy、Surprise、Neutral

数据集大小:用于Emotion Recognition In The Wild Challenge (EmotiW) 中音视频竞赛的一个数据集,这个项目从2013至2019每年都在进行,数据集也从最初的1400+个序列增加到后面的1800+个序列 - IMIGUE

IMIGUE 是一个用于微手势理解和情感分析的无身份视频数据集,共有359个视频。

所有样本来自于359个大满贯赛事赛后新闻发布会的视频

情感标签为:Positive、Negative - LIRIS-ACCEDE

LIRIS-ACCEDE 由从160部电影中提取的9800个高质量的视频片段组成,是维度情感数据库

情感标签依据:PAD维度情感模型

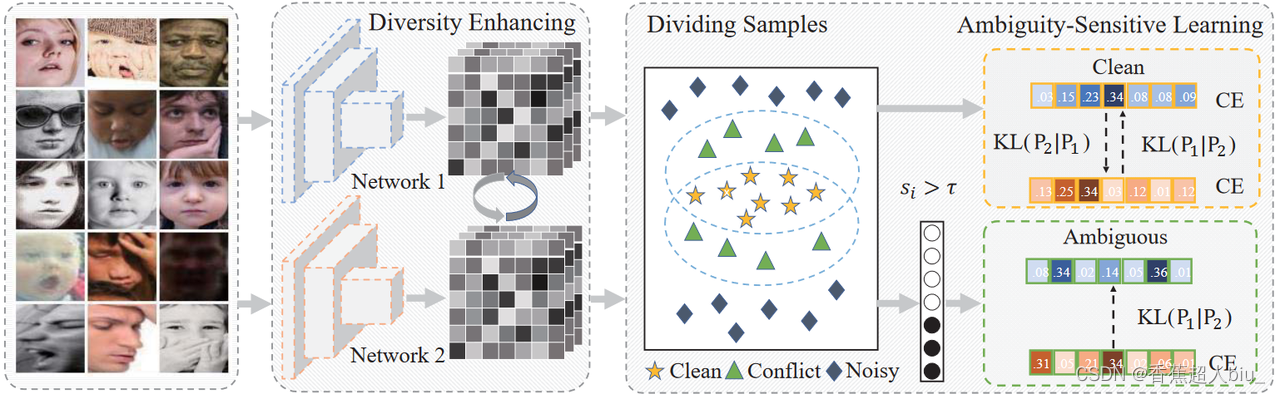

EASE: Robust Facial Expression Recognition via Emotion Ambiguity-SEnsitive Cooperative Networks

为了解决情绪的模糊性问题,提出了情感模糊-敏感合作网络(EASE)。

Pipline

在每个mini batch中使用两个peer networks从噪声图像中学习,两个网络都计算样本的损失值。然后将样本分为三组:。每个网络从其对等网络选择的训练样本中更新参数,并将类别概率与对等网络进行匹配,以校准网络的过拟合。最后,引入了多样性增强模块来提高两个的peer networks合作能力。

主要创新点

- 提出了情感模糊-敏感协作网络(EASE),这是第一个考虑到模糊样本和噪声样本之间差异的工作。网络包含两个部分。首先,对模糊性敏感的学习模块将训练样本分为三组:clean、conflict、noisy。两个网络中损失小的样本被认为是干净的样本,而损失大的样本是有噪声的。Note for the conflict samples that one network disagrees with the other, we distinguish the samples conveying ambiguous emotions from the ones with noises, using the polarity cues of emotions。最后,利用KL散度优化网络,使其能够关注非主导情感。

- 引入了基于负相关的多样性增强模块。随着训练的迭代,写作网络将持续收敛。最终根据特征之间的相关性构建一个惩罚项,这有助于网络从图像中学习不同的表征。

Dataset

- CAER-S

CAER-S是一个探索上下文感知表达的新数据集,包含70000张情感图片

数据采集方式:截取79部电视剧中一些片段

情感标签为:Surprised、Fearful、Disgusted、Happy、Sad、Angry、Neutral

数据集大小:总共13201个视频序列,每个序列长度约为90帧 - FER+

FER+是原始 FER 数据集的扩展,为面部表情识别提供了更好的 ground truth

数据采集方式:来自网络的表情图片

情感标签为:Neutral、Happiness、Surprise、Sadness、Anger、Disgust、Fear、Contempt

数据集大小:由35886张人脸表情图片组成,每张图片是由大小固定为48×48的灰度图像组成 - RAF-DB

RAF-DB数据集是一个大规模面部表情数据库,其主要标签是Expression,包含单标签(7类基本情绪)和双标签(12类符合情绪)。此外还有Gender、Race、Age等标签。

数据采集方式:来自网络的 29672 张多样化的面部图像

情感标签为:Surprised、Fearful、Disgusted、Happy、Sad、Angry、Neutral

数据集大小:包含大约3万张面部图像。 - SFEW

SFEW数据集 是从 AFEW数据集 中抽取的含有表情的静态帧,表情标签、注释同AFEW

情感标签为:Anger、Disgust、Fear、Sad、Happy、Surprise、Neutral

数据集大小:用于Emotion Recognition In The Wild Challenge (EmotiW) 中音视频竞赛的一个数据集,这个项目从2013至2019每年都在进行,数据集也从最初的1400+个序列增加到后面的1800+个序列 - AffectNet

AffectNet是迄今为止最大的FER数据集,包含45万张图像。除了具体的情感标签外,还包含None、Non-face、Uncertain标签

数据采集方式:采集自互联网

情感标签为:Neutral、Happiness、Surprise、Sadness、Anger、Disgust、Fear、Contempt

数据集大小:包含45万张图像 - CK+

CK+数据库是在 Cohn-Kanade Dataset 的基础上扩展来的,包含表情的label和Action Units 的label。CK+数据集中每种表情是一组序列(总共有593个图像序列,其中327个序列是有表情标签的):从自然缓慢变化到给定表情

数据采集方式:123位参与者在实验室条件下摆拍指定表情获得

情感标签为:neutral、anger、contempt、disgust、fear、happy、sadness、surprise

数据集大小:593个视频序列,分辨率640490或者640480,基于图片的人脸表情识别中常常取最后几帧作为样本

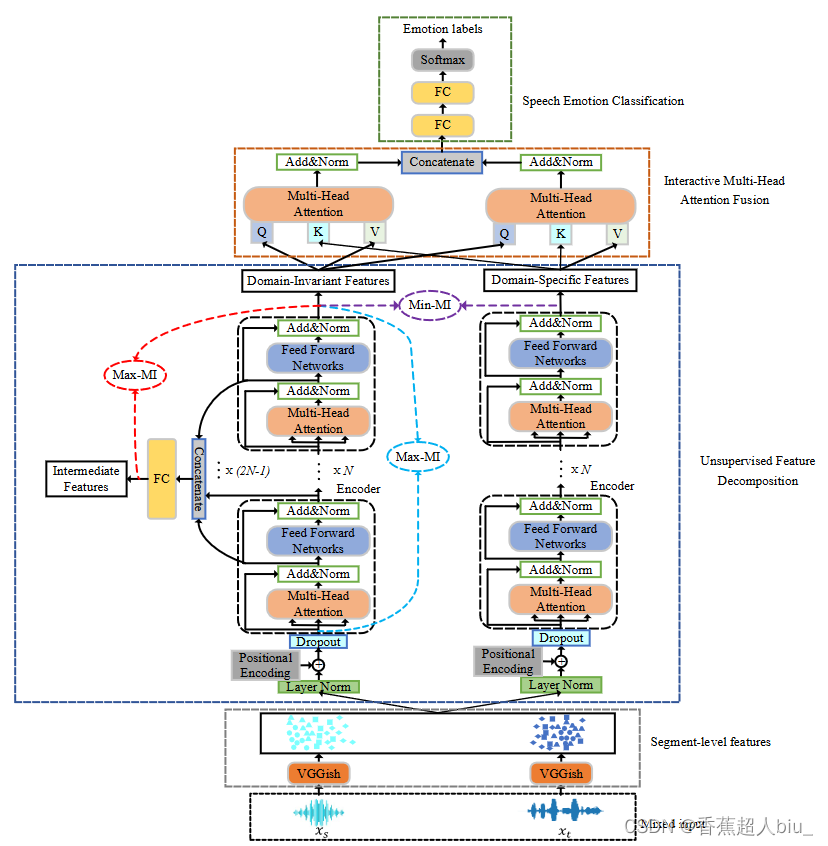

Unsupervised Domain Adaptation Integrating Transformer and Mutual Information for Cross-Corpus Speech Emotion Recognition

本文重点讨论了一个有趣的任务,即无监督的跨语料库语音情感识别,其中标记的训练(源)语料库和未标记的测试(目标)语料库具有不同的特征分布,导致源域和目标域之间存在差异,因此提出了一种无监督的域适应方法,整合了Transformer和互感信息(MI),能够用于跨语料库的SER。

Pipline

主要创新点

- 采用transformer的编码层,从提取的segment-level 的log-MFCC特征中捕捉语音的长期时间动态,从而捕捉两个域中的每个语音产生的相应特征。这是第一个将Transformers和MI结合用于跨语料库SER的无监督DA工作。

- 提出了一种无监督的特征分解方法,采用混合的Max-Min MI策略,从提取的混合utterance级特征中分别学习域不变的特征和域特定的特征,在此过程中,两个域之间的差异被尽可能地消除,同时保留了各自的特征。

- 设计了一个基于交互式多头注意力机制的融合策略,以学习域可变特征和域特定特征之间的互补性,从而使它们可以交互式地融合到SER中。

Dataset

- IEMOCAP

- MSP-Improv

MSP-Improv是一个探索情感行为的视听情感数据库

数据采集方式:在固定的实验室场景下,由12名英语专业学生进行了6次对话(由于对话需要激发的情感是固定的,我认为应该不属于半开放环境)

情感标签为:Happy、Sad、Angry、Neutral

数据集大小:总共8438个语音样本

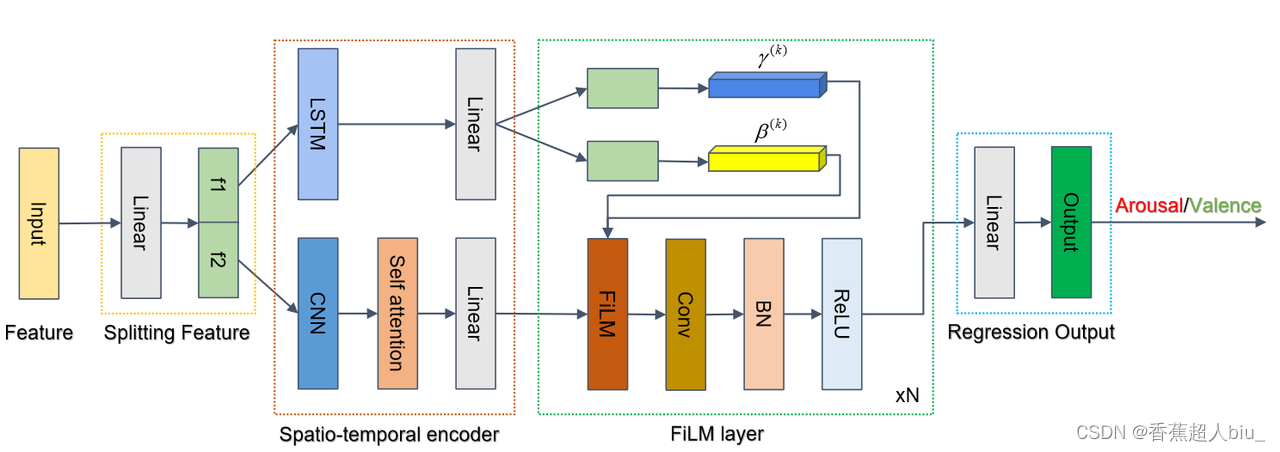

Improving Dimensional Emotion Recognition via Feature-wise Fusion

Pipline

主要创新点

- 提出了一个特征融合机制对空间-时间特征进行编码,融合了空间特征和时间特征以增强学习到的特征表示。

- 第一个考虑应用FiLM模块自适应地调制维度情感识别(DER)的时空特征,能够更好地捕捉情感中的细粒度信息

- 在MuSe - Stress子挑战上的实验结果证明了所提模型的有效性,强调了细粒度情感信息在DER中的重要性。

Dataset

- ULM-TSST

ULM-TSST 是一个多模态的(即声学的、视觉的、文本的和生物的)数据集,

数据采集方式:原始数据记录在一个工作面试情境中,每个参与者,年龄在18到39岁之间,被要求进行5分钟的自由演讲口头陈述。(我认为可以看作是半开放环境)

情感标签:维度情感标签依赖valence-arousal情感模型

数据集大小:一共69个短片,共5 :47 :27

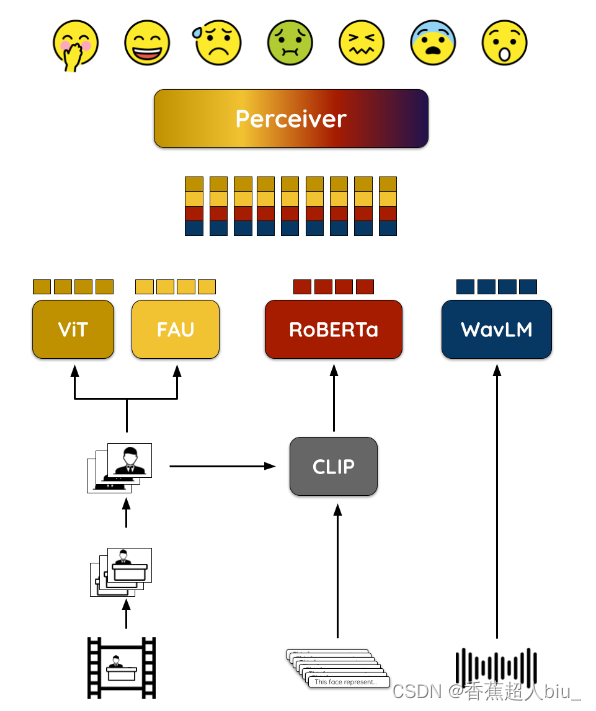

ViPER: Video-based Perceiver for Emotion Recognition

提出了一个多模态架构,利用基于模态的变换器模型来结合视频帧、音频记录和文本注释进行情绪识别。ViPER适合应对MuSe - Reaction挑战,该挑战旨在预测观看视频片段的人的情绪唤醒度。

Pipline

主要创新点

- 采用了模态无关的融合网络,使得所提出的架构能够适应其他输入模态,也是首次尝试从视频中解决模态无关的情感识别问题。

- 利用CLIP预训练模型,通过新的文本标注来丰富视频帧。目的是通过视频帧的文本描述增加输入源,为参与者的情绪唤醒提供相关的描述。

- 基于Perceiver的模态不确定后期融合方法的使用保留了所提方案面向不同场景的通用性和可移植性。提出的解决方案通过使用注意力瓶颈将输入转换为固定长度的潜在表示来确保模型的可扩展性。得到的嵌入具有独立的计算成本,与原始输入大小无关

Dataset

- Ulm-TSST

这篇关于Affective Computing Research的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!