本文主要是介绍txt和lmdb训练caffenet设置对比,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

主要是data层不同。

1.txt

layer {name: "data"type: "ImageData" ###top: "data"top: "label"include {phase: TRAIN}

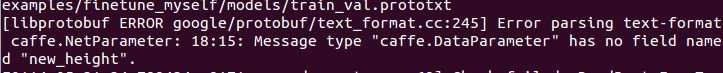

image_data_param { ###source: "examples/finetune_myself/train.txt" ###batch_size: 50new_height: 256 ###new_width: 256 ###}用txt训练时,data层类型改为 ImageData,source路径设置为txt所在位置,batch_size看情况设置。并且要设置new_height和new_width为256,即将图像转换成256*256大小。(TRAIN和TEST阶段均要修改)

2.lmdb

layer {name: "data"type: "Data" ###top: "data"top: "label"include {phase: TRAIN}data_param { ###

source: "examples/imagenet/car_train_lmdb"###

batch_size: 256

backend: LMDB ###

}用lmdb训练时,data层类型改为Data,source路径设置为lmdb所在位置,batch_size看情况设置。这里不用new_height和new_width,因为转换成lmdb时已经将图像转换成256*256了。(TRAIN和TEST阶段均要设置)

注意到txt时是image_data_param,lmdb时是data_param.由于直接用图像训练,所以data_param改为image_data_param,否则出错。

所以总结就是,txt时data层类型为ImageData以及image_data_param,lmdb时data层用Data以及data_param。(打###的地方是需要注意的地方)

所以总结就是,txt时data层类型为ImageData以及image_data_param,lmdb时data层用Data以及data_param。(打###的地方是需要注意的地方)

这篇关于txt和lmdb训练caffenet设置对比的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!